Das IPCC vermutet, dass die anthropogene globale Erwärmung (AGW) stattfindet und dass sie durch die Akkumulation menschlichen CO2-Ausstoßes verursacht wird. Bis heute jedoch wurden kein handfester wissenschaftlicher Beweis, ja nicht einmal starke empirische Hinweise für diesen Effekt präsentiert, weshalb dieser Effekt ein Objekt der Spekulation bleibt. Dennoch haben Reaktionen gebildeter Gesellschaften und von Regierungsagenturen auf die IPCC-Berichte bisher die Meinung weit verbreitet, dass diese globale Erwärmung gefährlich (DAGW) sein könnte und dass Maßnahmen ergriffen werden sollten, den Eintrag menschlichen CO2 in die Atmosphäre zu begrenzen.

Dieses Arbeitspapier analysiert vor allem die politischen Maßnahmen, die Verfahren und die Philosophie der Wissenschaftler und der Regierungsfunktionäre des IPCC im Licht der traditionellen wissenschaftlichen Prinzipien.

Es konzentriert sich auf:

- die generelle Darbietung der IPCC-Berichte mit ihrer Terminologie zur Wahrscheinlichkeit, selbsternanntes Expertenwissen und die Nichtbeachtung alternativer, unabhängiger Standpunkte

- – aktuelle fragwürdige Praktiken der Klimamodellierung

- – vernachlässigte (fast vergessene) Einsichten aus der klassischen Klimatologie

- – die fehlende Aufmerksamkeit wichtiger neuer Ergebnisse der Naturwissenschaften, die in der Klimaforschung anzuwenden erwartet wird, wie z. B. die Komplexitätstheorie

- – die fragwürdige Qualität gegenwärtiger Studien der Literatur.

Es wird gefordert, dass Studien der Zustandsberichte durch individuelle Nationen durchgeführt werden, weitgehend unabhängig vom IPCC, wie Indien es bereits angekündigt hat. Diese Begutachtungen werden am Besten von erfahrenen und etablierten Wissenschaftlern durchgeführt, deren Reputation in traditionellen Disziplinen zur Untermauerung der Klimawissenschaft liegt, besonders Physik, Chemie, Geologie, Astronomie, Sonnenphysik und Meteorologie. Die Verfahren sollten strikt den traditionellen Prinzipien der Wissenschaft folgen und sich auf die wissenschaftliche Methodik und empirische Beweise hinsichtlich der hypothetischen DAGW konzentrieren.

Einführung

Viele hundert Leitautoren, beitragende Autoren und Begutachter haben am jüngsten Zustandsbericht der begutachteten Literatur zur Klimaänderung des IPCC mitgearbeitet. Der Entwurf für den 5. Zustandsbericht der Arbeitsgruppe 1 (WG 1 AR 5)ist eine eindrucksvolle Zusammenfassung und Aufstellung von in wissenschaftlichen Journalen veröffentlichten Studien bis 2011, einschließlich einiger, die auf Beobachtungen in der Realität basieren, zusammen mit einer Diskussion der möglichen Interpretationen dieser Literatur hinsichtlich der DAGW-Hypothese. Auf den ersten Blick kann man den Eindruck gewinnen, dass hier das ‚vollständige Werk’ der wissenschaftlichen Gemeinschaft weltweit sowie eine umfassende Zusammenfassung der gegenwärtigen Forschungsliteratur präsentiert wird. Jedoch:

-

Die vorherrschende Hypothese lautet, dass DAGW stattfindet. Diese Hypothese wird seit vielen Jahren durch zahlreiche unabhängige Wissenschaftler in Frage gestellt. Diese Wissenschaftler wurden nicht eingeladen, an der Vorbereitung des 5. Zustandsberichtes teilzunehmen.

-

Die zitierte wissenschaftliche Literatur im Entwurf des 5. Zustandsberichtes ist selektiv, und zwar zugunsten von Studien die die DAGW-Hypothese stützen, und selbst diese wurden selektiv analysiert, um zum gleichen Ergebnis zu kommen (3)

Diese beiden zugrunde liegenden Verzerrungen geben den Ton an, den die Autoren des AR 5 vermitteln möchten. Deren Botschaft lautet, dass die gegenwärtigen Manifestationen der Klimaänderung Vorboten einer bisher nicht da gewesenen und bedrohlichen globalen Erwärmung seien, hervorgerufen durch die anthropogenen Emissionen von CO2, das sich in der Atmosphäre ansammelt. Allerdings bleibt dies trotz der endlosen Wiederholungen seitens der Befürworter eine unbewiesene Hypothese, mit der viele Wissenschaftler aufgrund ihres Wissens um widersprechende empirische Beweise nicht übereinstimmen. Die DAGW-Hypothese basiert auf der unbestrittenen physikalischen Tatsache, dass CO2 infrarote Strahlung (IR) absorbiert und emittiert. Die meisten Kritiker der DAGW-Hypothese bezweifeln jedoch, ob die gemessenen und projizierten Änderungen der CO2-Konzentration signifikante Auswirkungen auf das komplexe Klimasystem haben, wie es die DAGW-Befürworter propagieren. In diesem Zusammenhang betonen die Kritiker eine Anzahl von Beobachtungen, die der AGW-Hypothese direkt widersprechen. Aber die Erwähnung dieser Phänomene fehlt auffallend in früheren Berichten der Arbeitsgruppe 1 (WG 1) und auch im Entwurf zu AR 5.

Viele Details wissenschaftlicher Beweise, die nicht mit der IPCC-Agenda konform gehen, sowie zahlreiche relevante Diskussionen finden sich in den Berichten des NIPCC ebenso wie auf zahlreichen wissenschaftlichen Blogs. Beispiele angezweifelter IPCC-Wissenschaft sind dessen Überinterpretation instrumentell gemessener Temperaturtrends, das Scheitern an Klimaänderungen in geologischen Zeiträumen, die Missachtung von Eisveränderungen im Verhältnis von Arktis und Antarktis (d. h. global im Gegensatz zur Betrachtung des arktischen Eises allein), das Scheitern des IPCC, auch nur ansatzweise einen Beweis für eine Beschleunigung des Meeresspiegelanstiegs zu erbringen sowie die überaus verengte und spekulative Interpretation der Veränderungen von Lebensräumen bestimmter Spezies durch die globale Erwärmung.

Im Anhang A werden diese Punkte noch etwas detaillierter erläutert, aber mehr noch als diese und andere Zweifel an der DAGW-Hypothese wieder aufzunehmen wird sich diese Studie stattdessen auf die wissenschaftliche Methodik konzentrieren und darauf, was essentiell im Entwurf des AR 5 fehlt sowie auf die bei der Vorbereitung angewandte Philosophie. Die Schlussfolgerung, die von der wissenschaftlichen Gemeinschaft im Ganzen ebenso wie von den politischen Entscheidungsträgern beachtet werden, müsste lauten, dass der Entwurf zum AR 5 des IPCC unzureichende Objektivität aufweist und dass die für die Basis politischer Entscheidungen unabdingbare ‚traditionelle’ wissenschaftliche Ausgewogenheit fehlt. Bedauerlicherweise enthält der Bericht viele Vorgehensweisen einer ‚postmodernen’ Annäherung an die Wissenschaft, wobei die Regeln der Logik nur im Zusammenhang mit den gewählten kulturellen Paradigmen einer vorgegebenen Denkschablone gelten.

Einige charakteristische Besonderheiten des IPCC-Entwurfs

CO2 als wesentlicher Treiber für steigende Temperatur

Alle vierzehn Kapitel des IPC-Berichtes gehen von der Annahme aus, dass das CO2 ein dominanter Treiber der globalen Temperatur ist. In manchen Kapiteln wird sogar behauptet, dass es inzwischen zunehmende Beweise für das CO2 als Ursache steigender Temperatur und anderer Symptome der Klimaänderung gibt. Allerdings finden sich in den relevanten Passagen und auch im gesamten Bericht an keiner Stelle Beschreibungen für solche Beweise.

Der ‚Beweis’, auf den sich das IPCC bezieht, ist nicht empirischer Natur, sondern basiert weitgehend auf schon vorher präsentierten Hypothesen zum Prozess des Strahlungstransportes innerhalb eines atmosphärischen Körpers.

Aber wie funktioniert dieser Prozess in der realen Atmosphäre weltweit? Um diese Frage zu beantworten, verwenden die Modellierer des IPCC deterministische allgemeine Zirkulationsmodelle (General Circulation Models GCMs). Diese Modelle, bei denen der klimatreibende Effekt des CO2 vorgegeben ist, werden auf Supercomputern gerechnet. Die DAGW-Befürworter argumentieren, dass die heutige beobachtete Klimaänderung nicht ohne einen menschlichen treibenden Effekt erklärt werden kann. Da die virtuelle Welt der Modelle sich sehr unterscheidet von der realen Welt, einschließlich einer Serie von ‚was wenn’-Experimenten, weisen Kritiker darauf hin, dass der hypothetische Einfluss des CO2 auf das globale Klimasystem spekulativ bleibt. Eine fundamentale Kritik der gegenwärtigen Generation von GCMs wird im nächsten Abschnitt geübt.

Neben solcher Kritik ist es jedoch augenscheinlich, dass Experimente mit GCM-Modellen einem starken und nützlichen heuristischen Ziel dienen. Ihr Gebrauch als ein heuristisches Werkzeug ist daher vollkommen angemessen. Es ist Aufgabe der GCMs zu zeigen, was das IPCC „Projektionen“ der zukünftigen Temperatur nennt, was jedoch dann unvermeidlich von der Presse, der Öffentlichkeit und von Politikern als „Vorhersage“ angesehen wird. Dies steht im Gegensatz zur bewährten wissenschaftlichen Praxis.

Der Vorhersagewert und andere Defizite der GCMs sowie die nicht perfekte Darstellung eines Modelles ist natürlich kein Beweis dafür, dass es komplett falsch liegt. Und in ähnlicher Weise kann das vermutete Fehlen eines starken CO2-Einflusses auf das Erdklima, wie es DAGW-Kritiker anführen, ebenfalls als spekulativ angesehen werden. Wie auch immer, derzeit erleben wir, dass die empirischen Daten zeigen, wie sehr früher präsentierte Projektionen in die Zukunft in Zusammenhang mit anthropogenem CO2 falsch waren.

Die Abweichung eines Modells von Beobachtungen ist ein wissenschaftliches Signal, das (mit der Haltung zu Nebengedanken, die Wissenschaftler anstreben) weitere gründliche und innovative Studien erfordert.

Wahrscheinlichkeitsterminologie

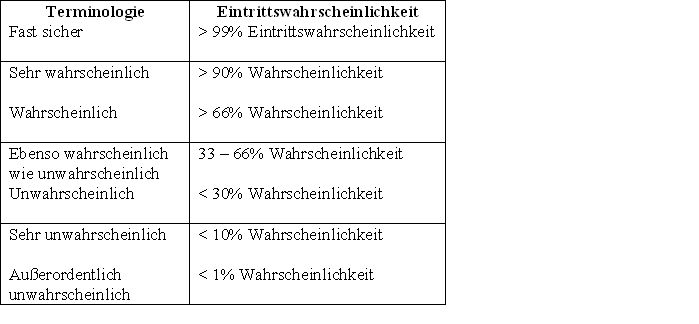

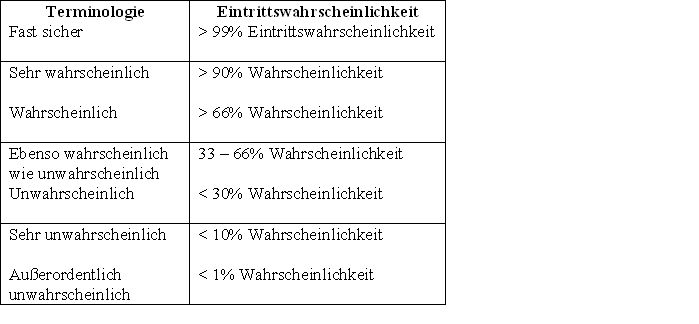

Ein anderer bemerkenswerter Prozess des IPCC ist die Anweisung an die Autoren, dass sie ihre Schlussfolgerungen in der Terminologie einer qualitativen (d. h. meinungsbasierten) Wahrscheinlichkeitsskala ausdrücken. Dieser Umstand wird aus der folgenden Tabelle ersichtlich, zu finden in der Guidance Note for Lead Authors für den 4. Zustandsbericht, ausgegeben 2005 4:

Tabelle 4: Wahrscheinlichkeitsskala

Dieses Prozedere führt zu einem Eintrag subjektiver Beurteilungen durch eine Gruppe Wissenschaftler, die im Endeffekt durch „Handzeichen“ zu ihrem Urteil kommen. Ein solches Prozedere gehört in die Bereiche soziale und politische Wissenschaft und sollte in einer echten Studie der etablierten Wissenschaft keine Rolle spielen (5).

Tatsächlich, die Anwendung dieser postmodernen Technik in den jüngsten IPCC-Berichten reicht aus, um diese als seriöse wissenschaftliche Dokumente zu disqualifizieren.

Selbsternannte Experten

Bedauerlicherweise wird der Gebrauch einer nicht objektiven Beurteilung nach Pseudo-Wahrscheinlichkeiten nicht mehr als eine ungewöhnliche Praxis in der Entwicklung von Wissenschaftspolitik in vielen wissenschaftlichen Institutionen angesehen. Ob eine daraus resultierende Befürwortung sinnvoll ist oder nicht, hängt von der Glaubwürdigkeit ab, mit der Wissenschaftsberater (und in der Folge politische Entscheidungsträger) dem Expertenwissen der an dem ‚Konsens‘ einer bestimmten Sache beteiligten Wissenschaftler Tribut zollen. Werden diese Wissenschaftler als glaubwürdig angesehen, werden die Politiker den ‚Führern‘ folgen, welche im Falle des IPCC die Leitautoren der Berichte sind.

Aber warum solche Leute als von vornherein glaubwürdig angesehen werden, kann und muss hinterfragt werden. Liegt es einfach an ihrem selbst verliehenen Expertenstatus oder weil sie einige außerordentliche Einsichten in sehr komplexe Zusammenhänge der Klimaänderung an den Tag gelegt haben? Hinsichtlich des IPCC ist Ersteres sicherlich zutreffend (weil bis jetzt keiner der vielen Alarmisten des IPCC widerlegt worden ist). Mehr noch, es gibt eine unglückliche Tendenz, auf extreme Wetterereignisse zu deuten, die zwar nicht spezifisch vorhergesagt worden waren, die aber als etwas hingestellt werden, was man von einer globalen Klimaänderung zu erwarten hätte.

Es fehlt die Achtung vor alternativen, unabhängigen Ansichten

Unabhängige Wissenschaftler reagieren besonders empfindlich auf die Arroganz und Intoleranz gegenüber alternativen Ansichten, die den selbsternannten Klimaexperten des IPCC unter die Augen kommen. Personen, die von sich behaupten, überragendes Wissen auf jedem Gebiet öffentlicher Politik zu haben, nicht nur hinsichtlich der globalen Erwärmung, und die aktiv an politischen Aktivitäten teilnehmen, und die verhindern sollen, dass ihre Ansichten unabhängig begutachtet werden (wie es die IPCC-Wissenschaftler immer getan haben), sollte man mit Argwohn betrachten. Das zur-Schau-stellen solcher Verhaltensweisen lässt signifikante Zweifel aufkommen über diejenigen, die dem Stall der IPCC-Berater angehören. Es muss jedoch anerkannt werden, dass solche Gefühle auf Gegenseitigkeit beruhen, und das viele Protagonisten der DAGW der Meinung sind, dass ihre Kritiker einfach ‚Leugner‘ dessen sind, was sie als etablierte Wissenschaft ansehen.

Dieses beiderseitige Fehlen von Respekt hat sich als ernstes Hindernis einer ‚normalen’ wissenschaftlichen Diskussion zwischen den Protagonisten und Antagonisten der DAGW in der Vergangenheit herausgestellt. Und bedauerlicherweise liefert der neue Entwurf des 5. Zustandsberichtes mit seinen unverblümten Statements darüber, was hinsichtlich der angenommenen gefährlichen Erwärmung wahrscheinlich ist oder nicht, keine Hinweise darauf, dass eine solche Diskussion demnächst in Gang kommt.

Der wichtigste Punkt einer Verhinderung dieser Diskussion lautet, dass der Stil des Entwurfs von AR5 diesen eher als ein politisches als ein wissenschaftliches Dokument kennzeichnet, weil er innerhalb des Rahmens eines speziellen kulturellen Paradigmas erstellt worden ist. Dies ist so trotz einer gründlichen und manchmal gut zusammengefassten Selektion der begutachteten Klimaliteratur. Demnach können die AR5-Berichte der Arbeitsgruppen 2 und 3, die den Erwartungen zufolge auf den Entwürfen der hier begutachteten Arbeitsgruppe 1 aufbauen, auch nicht als wohlüberlegte, ausgewogene, akkurate und leidenschaftliche Analysen der Klimawissenschaft und der erforderlichen sinnvollen Politik angesehen werden.

Modellieren der Klimaänderung

Modellieren ist zu einem bedeutenden Werkzeug in allen naturwissenschaftlichen Disziplinen geworden – und mit zunehmendem Erfolg und Wert wegen der großen Fortschritte, die die Programmierung und die Technologie von Computern gemacht haben. Modelle werden inzwischen routinemäßig benutzt, um komplexe Prozesse besser zu verstehen, vor allem solche, die nur durch unlösbare, nichtlineare Differentialgleichungen beschrieben werden können, und die daher einer modellbasierten Simulation bedürfen, um verstanden zu werden.

Der Erfolg von Modellierungen in den Bereichen Meteorologie, vor allem Wettervorhersage, hat sich stetig vergrößert. Aber gerade auch speziell in diesem Bereich hat sich eindeutig herausgestellt, dass die Vorhersagbarkeit wegen der chaotischen Natur des komplexen atmosphärischen Systems begrenzt ist. Vorhersagen lassen sich höchstens etwa eine Woche im Voraus machen. Nach diesem Zeitraum werden chaotische Variationen und wachsende Fehler die Erfolge kürzerfristiger Vorhersagen überkompensieren. Aufgrund theoretischer Überlegungen ist heute allgemein akzeptiert, dass die „eine-Woche-Grenze“ heutiger Vorhersagemodelle nicht mehr wesentlich ausgeweitet werden kann, zumindest nicht in den Klimazonen der gemäßigten Breiten mit ihrer hohen atmosphärischen Variabilität hinsichtlich von Hoch- und Tiefdruckgebieten.

Was also lässt die Klimawissenschaftler glauben, dass sie Klimavorhersagen für Jahrzehnte im Voraus machen können? Mit Hilfe von GCMs, die aus den gegenwärtig benutzten Modellen zur Wettervorhersage abgeleitet worden sind, nahmen die Modellierer an, dass die Mitte des 19. Jahrhunderts ein guter Startpunkt für das Studium künftiger Klimaänderungen ist, und dass ihre Algorithmen bei diesem Startpunkt akkurat das Mittel der globalen Klimaänderung berechnen können im Gegensatz zu der hoch variablen (und über eine Woche hinaus unbekannten) Entwicklung des Wetters. Mehr noch, jedem einzelnen Modell wird vorgegeben, dass ein signifikanter Teil der globalen Erwärmung auf einem Antriebseffekt durch CO2 beruht.

Diese Vorgehensweise ist naiv. Sie ist wahrscheinlich auch fundamental falsch.

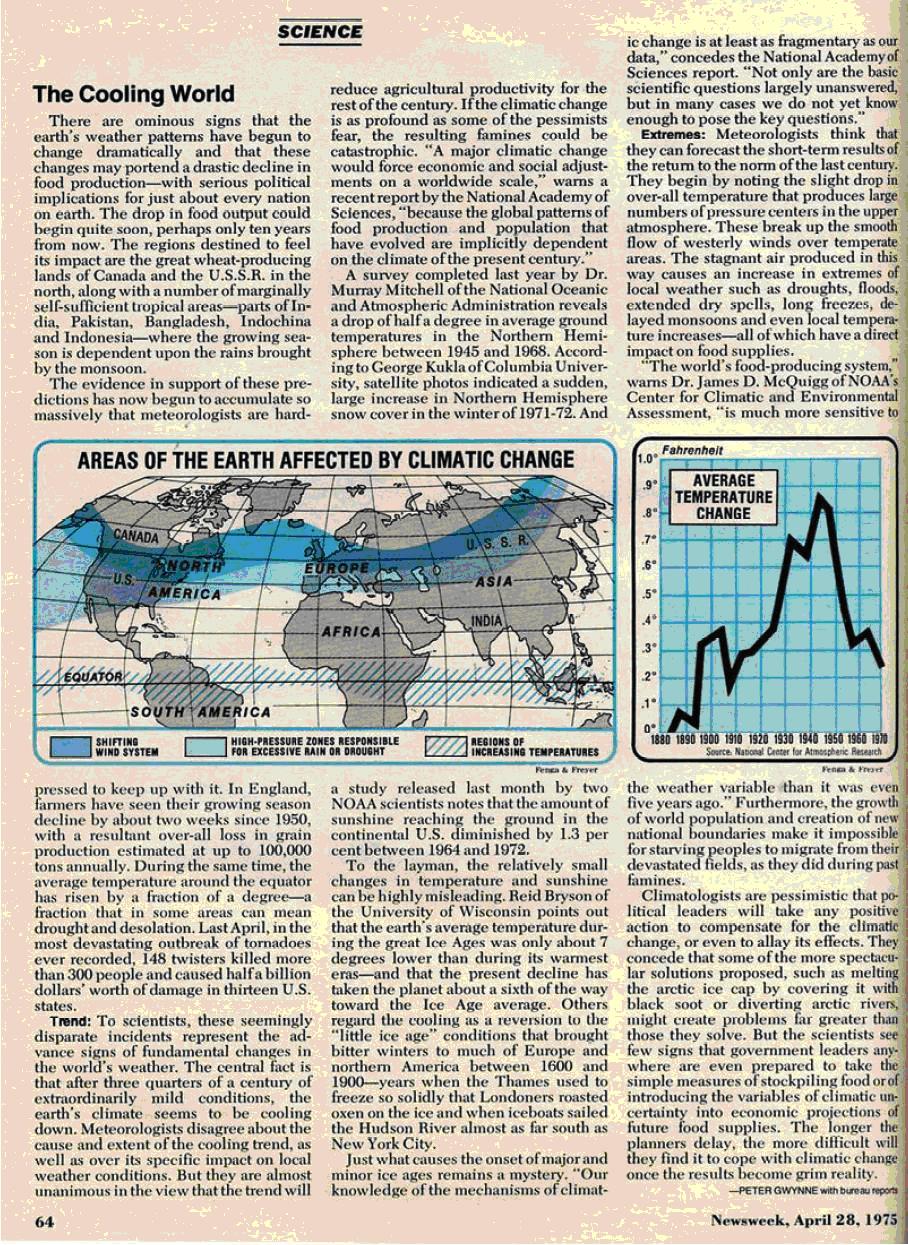

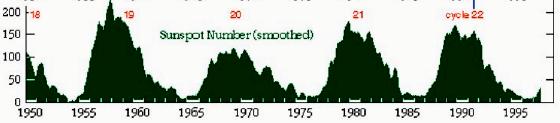

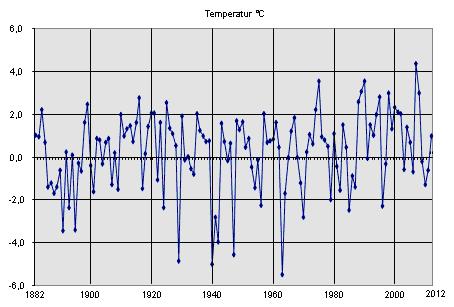

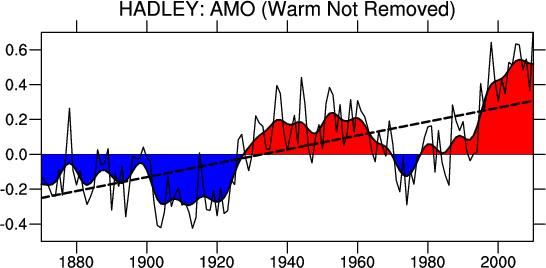

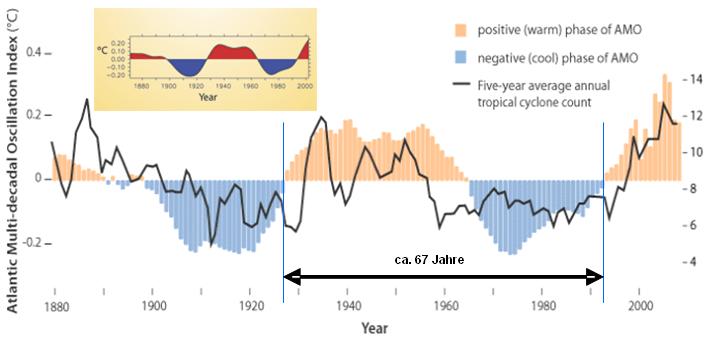

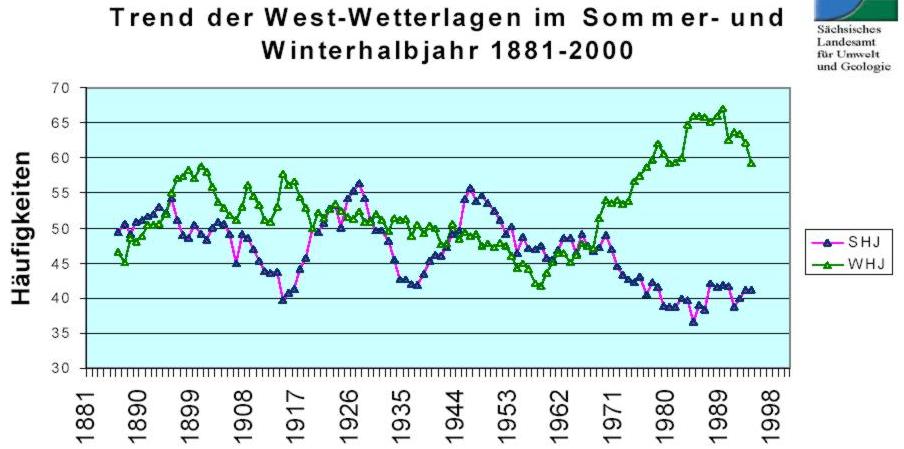

In historischen und geologischen Zeiträumen sind Klimaänderungen als ein natürliches Phänomen etabliert. Klimaänderungen gibt es in allen Zeitbereichen bis zu einer Million Jahre, und es führt in die Irre, zu Analysezwecken eine einzige 150 Jahre lange Periode aus ihrem Zusammenhang zu reißen und zu isolieren (darunter solare Zyklen von 11, 22, 80, 200 und 1500 Jahren ebenso wie gut bekannte multidekadische Variationen vieler unterschiedlicher Oszillationen zwischen Ozean und Atmosphäre). Daher sollte man zuerst versuchen, Klimaänderungen in Relation zu diesen natürlichen Phänomenen zu modellieren. Stattdessen werden fast alle Klimazyklen von der gegenwärtigen Generation der GCMs zugunsten des CO2-Zusammenhangs außen vor gelassen.

Erst nach einer vernünftigen Analyse aller bekannten natürlichen Variationen der Vergangenheit könnte es möglich sein, die mögliche Bedeutung eines verstärkten CO2-Effektes zu erkennen.

Die natürliche Variation wird im nächsten Abschnitt detaillierter beschrieben.

Klassische Klimatologie

Das ‚Modellieren’ von der oben beschriebenen Art wurde auf einer breiteren Grundlage in qualitativer und beschreibender Weise von klassischen Klimatologen vor 1965 durchgeführt. Dabei fanden sie heraus, dass die historische Klimavariabilität zum großen Teil auf Verschiebungen der sechs großen Windsysteme des Planeten beruhen, Verschiebungen, die oft mit multidekadischen Klimaoszillationen zusammen hängen (6).

Wenn sich verändernde Strömungssysteme tatsächlich in historischen Zeiträumen der wesentliche Treiber globaler Klimaänderungen waren, muss jede Auswirkung von Änderungen der Zusammensetzung der Atmosphäre, z. B. durch die Zunahme von CO2, auf das Klima zuvor deren Auswirkung auf die Windzonen modelliert werden. Daran sollte sich die Suche nach den natürlichen Variablen anschließen, die diese Änderungen hervorgerufen haben könnten. Sollte diese Modellierung zufrieden stellende Ergebnisse und Erklärungen für die Veränderungen der Vergangenheit liefern, dann und erst dann ist es die Zusammensetzung der Atmosphäre, die untersucht werden kann.

Andere wichtige Erkenntnisse aus der klassischen Klimatologie, die durch jüngste Beobachtungen bestätigt worden sind, scheinen ebenfalls vom IPCC ignoriert zu werden. Zum Beispiel die Bedeutung der ungleichen Strahlungsverteilung durch die Sonne. Sie würde die Temperatur in der Äquatorzone bis fast 100°C steigen lassen, wenn es keine konvektive Umverteilung der Wärme über den Planeten durch Winde, die Meeresströmungen und – allgemeiner – die Wasserzyklen geben würde (7). Dieses Verständnis legt nahe, dass das mittlere globale Klima, falls ein solches Konzept überhaupt irgendeine Bedeutung hat, großenteils durch meteorologische und physikalische Prozesse um den Äquator und vor allem in den tropischen Ozeanen bestimmt wird.

Konvektion ist für den Wärmetransport genauso wichtig wie Strahlung

Anstatt detailliert den wichtigen Effekt der lokalen Überhitzung in den Tropen und deren Entschärfung durch den konvektiven Wärmetransport zu erwägen, ziehen die AGW-Befürworter des IPCC die Metapher vor, dass der Planet ohne das, was sie als Treibhauseffekt bezeichnen, ein Eisball wäre. Dieser Glaube basiert auf dem Gedanken eines allgemeinen planetarischen Energiebudgets, dessen Analyse darauf hindeutet, dass die gesamte Sonnenenergie, die die untere Atmosphäre (die Troposphäre) und die Erdoberfläche erreicht, nicht ausreicht, ein mittleres globales Temperaturniveau von 15°C zu halten, es sei denn, ein Wärmepuffer in der Troposphäre agiert als eine Art Decke. Die sich daraus ergebende Dämmung wird (der Öffentlichkeit) dann mit der Metapher eines Treibhauses erklärt. Diese Metapher führt erheblich in die Irre, weil sich ein Treibhaus gravierend von der freien Atmosphäre unterscheidet, wird doch in einem Treibhaus die Wärme durch Unterdrückung der Luftzirkulation (d. h. der Konvektion) zurück gehalten.

In Wirklichkeit stellen konvektive Prozesse einen der wichtigsten Einflüsse auf den Wärmehaushalt der Erde dar und spielen eine bestimmende Rolle bei der Regelung der Temperatur an der Erdoberfläche und in der Troposphäre. Nichtsdestotrotz ist auch aus der klassischen Klimatologie offensichtlich, dass die Atmosphäre Wärme aus Strahlung einfängt, sowohl die von der Sonne kommende als auch die (im thermischen Infrarot) ausgehende Strahlung von der Erdoberfläche. Das Ergebnis sind ein Druckgradient und ein Temperaturgefälle – letzteres mit einer Bandbreite von im Mittel 15°C an der Oberfläche bis -50°C in einer Höhe über 10 km. Das theoretisch berechnete Temperaturgefälle wird jedoch fortwährend ‚gestört’ durch lokale Wetterereignisse einschließlich der horizontalen Verlagerung von Hoch- und Tiefdruckgebieten. Die Oberfläche kann sich manchmal beim Fehlen solcher Bewegungen stark erwärmen (40°C), nur durch Dämmung.

Das Dämmungspotential der Troposphäre erklärt sich der AGW-Hypothese des IPCC zufolge fast ausschließlich durch Strahlungstransportprozesse, welche man in einer Luftsäule von Infrarot absorbierenden und emittierenden Molekülen erwartet. Andere (skeptische) Wissenschaftler erachten diese Beschreibung als viel zu eng und weisen darauf hin, dass andere meteorologische und physikalische Prozesse in aktuellen Klimatologie-Fachbüchern gut repräsentiert sind – von denen die meisten den erwarteten verstärkten ‚Treibhauseffekt’ viel reservierter sehen als das IPCC.

Es gibt zahlreiche Bücher und Artikel von ‚Skeptikern der globalen Erwärmung’, die die AGW-Hypothese aufgrund physikalischer und meteorologischer Gegebenheiten in Frage stellen. Zwar werden Nicht-Strahlungsmechanismen wie z. B. unterschiedliche Arten der Konvektion, vom IPCC nicht vollständig in Abrede gestellt, doch sind sie im Vergleich mit dem Verständnis von Klimaänderungen einer größeren wissenschaftlichen Gemeinschaft erheblich unterrepräsentiert. Der Disput konzentriert sich auf eine unterschiedliche Interpretation der gegenseitigen Ursache-Wirkung-Relation zwischen Luft- und Meeresströmungen auf dem Planeten und auf die optischen Eigenschaften der Atmosphäre, welche wiederum einen bestimmten Temperaturgradienten über Breite und Höhe vorgeben.

Es ist zu erwarten, dass positive und negative Rückkopplungen in den oben erwähnten Beziehungen eine Rolle spielen. Die meteorologische Umgebung versucht fortwährend, einen Gleichgewichtszustand zu erreichen, was aber ständig durch verändernde Kräfte unterbrochen wird. In einem dynamischen System ist zu erwarten, dass dies im globalen Maßstab zu komplexen Oszillationsprozessen und nicht zu einem festgelegten Gleichgewicht führt. Letzteres wird bei der DAGW-Hypothese empfohlen, indem man Modelle für unabhängige ‚Klimaantriebe’ nutzt, zum Beispiel die Variabilität der Sonne sowie Änderungen des Aerosols und der optischen Dichte der Atmosphäre.

Die Missachtung einer wichtigen Errungenschaft der Naturwissenschaften

Die endgültige veröffentlichte Version des Zustandsberichtes 5 des IPCC wird zweifellos mit ähnlichen Kritiken bedacht, die oben umrissen worden sind. Im Besonderen wird die Proklamation im Berichtsentwurf, dass es „zunehmende Beweise dafür gibt, dass CO2 der Grund für den globalen Temperaturanstieg und andere Indikationen für die Klimaänderung ist“, massiv unter Feuer geraten, weil diese Feststellung aufgrund der empirischen Daten einfach nicht gerechtfertigt ist.

Ziemlich unabhängig vom Erreichen eines intelligenteren Verständnisses des fortgesetzten Streits unter Wissenschaftlern mit unterschiedlichen Standpunkten zur Klimawissenschaft und DAGW muss dringend ein fundamentales Problem bei der Forschung zur Klimaänderung angesprochen werden.

Diese Notwendigkeit ist von praktischer Bedeutung für die Philosophie hinter einer Komplexitätstheorie, die früher unter der Bezeichnung Katastrophen- oder Chaostheorie bekannt war, welche sich schon im 19. Jahrhundert entwickelt hat. Die Komplexitätstheorie versucht, die Eigenarten dynamischer Prozesse zu interpretieren, die weit unabhängig von jedem thermodynamischen Gleichgewicht auftreten und die daher nur mit Hilfe nichtlinearer (d. h. nicht lösbarer) Differentialgleichungen beschrieben werden können. Computersimulationen, durch Fortschritte in der Informationstechnologie Mitte und Ende des 20. Jahrhunderts stark verbessert, wurden im Besonderen wichtig, um die Natur solcher Prozesse zu simulieren, wobei es wichtig ist darauf hinzuweisen, dass solche Simulationen NICHT tatsächliche Lösungen in der realen Welt zur Verfügung stellen. Stattdessen muss jede solche Simulation mit einem „was, wenn“-Experiment unter bestimmten Bedingungen in einer virtuell realen Welt behandelt werden.

Wegen seiner komplexen Natur ist die Klimaänderung zweifellos ein illustratives Beispiel eines Zweiges der Wissenschaft, in dem man ohne Verwendung solcher Computersimulationen kaum Fortschritte machen kann. Diese Vorgehensweise wurde schon Mitte des 20. Jahrhunderts von den Main Stream-Klimatologen aufgegriffen und erklärt. (8)

Die Kritik an den Schlussfolgerungen dieser früheren Simulationen bezog sich überwiegend auf Fragen, ob die eingehenden Variablen genügend aussagekräftig und ob die angewandten Algorithmen sowohl gültig als auch akkurat waren.

Diese Diskussion wird weitergehen und kann zu einer Verbesserung der Modelle führen. Aber viele wichtige Aspekte der Komplexitätstheorie wurden bisher überhaupt nicht in den Modellierungsprozess eingebracht. Am wichtigsten ist die fehlende Berücksichtigung von Oszillationsprozessen, für die Trajektorien beschrieben werden können, die durch ‚feste Punkte’ genannte Gleichgewichtszustände bestimmt werden können; der entwickelten Theorie zufolge sollten diese niemals auftreten. Dass dieser Aspekt der Komplexitätstheorie bei der gegenwärtigen Modellierung weitgehend ignoriert wird, kann man daran erkennen, dass zuvor keine Identifikation aller festen Punkte durchgeführt worden ist, die hier involviert sein können.

Ein erkannter wesentlicher Fixpunkt ist die globale Strahlungsenergiebilanz zwischen der einfallenden Sonnenstrahlung und der langwelligen Ausstrahlung an der Obergrenze der Atmosphäre. Ob alle Angaben im Modell von Kiehl und Trenberth (KT97) zur globalen Energiebilanz akkurat sind oder nicht, ist von relativ geringer Bedeutung (9). Die viel wichtigere philosophische und wissenschaftliche Frage lautet, ob das Modell KT97 einen Fixpunkt zu beschreiben versucht (hinsichtlich der Komplexitätstheorie ein Attraktor), der in keinem wirklichen Gleichgewichtszustand ist.

Ein zweiter, in KT97 nicht berücksichtigter, aber durch grundlegende Physik und meteorologische Beobachtungen gut belegter Fixpunkt ist die Maximumtemperatur von 29°C, der die tropischen Ozeane charakterisiert, kontrolliert durch die Umleitung der Energie durch starke lokale Dämmung hin zu Verdunstung. Viele weitere Fixpunkte (das heißt Attraktoren, die die Klimatrajektorien beeinflussen) müssen existieren, zum Beispiel an den Grenzen der Windsysteme und an der Obergrenze der Atmosphäre. Diese Attraktoren wurden bis jetzt noch nicht einmal identifiziert, geschweige denn in die GCMs eingebaut.

Man würde erwarten, dass eine Zustandsbeschreibung wie AR5 der WG 1 diesen und anderen Aspekten der Komplexitätstheorie volle Aufmerksamkeit gewidmet hätte, vielleicht sogar deren Behandlung in einem speziellen Kapitel. Obwohl jedoch die deterministisch-chaotische (komplexe) Natur des Klimasystems im Vorübergehen in früheren IPCC-Zustandsberichten erwähnt worden war, gab es niemals eine ausführliche Diskussion darüber, und auch im AR5 ist das nicht der Fall. Die unvermeidliche Schlussfolgerung daraus lautet, dass die IPCC-Experten der Computersimulation und andere Leitautoren mit den Grundprinzipien der Komplexitätstheorie nicht vertraut sind. Folglich fehlen Einsichten im Entwurf von AR 5, die von einer hoch entwickelten und wesentlichen mathematischen und wissenschaftlichen Institution nicht fehlen sollten und dürften.

Kommen wir zurück zu den wesentlichen Konsequenzen, die man hätte berücksichtigen müssen:

-

Die Punkte in jedem Graphen sind nicht „normal“ um den Mittelwert verteilt (die Verteilung ist multimodal), und die Definition von Vertrauensintervallen, die auf der Standardabweichung um den Mittelwert abgeleitet sind, ist ein statistischer Fehler.

-

Wie vorher schon erläutert ist die Mittelung der Kurven aus dem gleichen Grunde bedeutungslos.

-

Es ist mathematisch nicht korrekt, Faktoren zu addieren/zu subtrahieren (eine lineare Operation), wie z. B. die Isolierung einer Trendlinie oder eines jahreszeitlichen Effektes, wenn das System nichtlinear ist, muss ein Querschnittsfaktor existieren.

Der Ursprung der ‚wahrscheinlich’ genannten ‚Unsicherheiten’ hätte durch Verwendung von Argumenten von Auditoren anderer Disziplinen verdeutlicht werden können, die mit dem manchmal unerwarteten Verhalten komplexer Systeme vertraut sind. Dies unterstreicht wieder einmal, dass der Entwurf vom AR 5 keine ‚komplette Arbeit’ einer weltumspannenden wissenschaftlichen Gemeinschaft ist. Es kann sein, dass der AR 5 des IPCC trotz (oder sogar gerade wegen) der Alarmrufe bzgl. der Erwärmung sich eher als ein Hindernis als eine Hilfe auf dem Weg zu den Erkenntnissen über die wahren Gründe der globalen Erwärmung und von Klimaänderungen erweist.

Abwägung der Beweise in Zustandsstudien

Der Entwurf zum AR 5 behauptet, die physikalischen Mechanismen der Klimaänderung zu erklären. Aber er spricht den Kern der Sache gar nicht adäquat an: nämlich die Frage nach den Gründen der natürlichen Klimavariabilität. Bei unserem gegenwärtigen Wissensstand, nämlich dass DAGW existiert, ist eine wissenschaftliche Zustandsstudie erforderlich, die die Beweise für und gegen die Hypothese abwägt. Dieser Zustandsbericht sollte nicht einfach die Leistung einer einzigen spekulativen DAGW-Hypothese proklamieren, wie es der Entwurf zum AR 5 tut.

Die meisten Kapitel im AR 5 behandeln nicht die CO2-Hypothese als solche, sondern lediglich die Signale, die auf die Klimavariabilität hinweisen. Dass diese Variabilität verbreitet auftritt überrascht niemanden, weshalb die geeignete Null-Hypothese lautet, dass die beobachtete Variabilität ein Ausdruck natürlicher Gründe ist, solange und bis kein anthropogener Grund und eine gefährliche Rate einer daraus resultierenden Änderung empirisch gezeigt werden kann.

Obwohl der IPCC-Bericht den Titel ‚The Scientific Basis’ trägt mit der starken Betonung auf und dem Vertrauen der Leitautoren in eine Auswahl DAGW-freundlicher begutachteter Literatur macht den Bericht eher zu einem politischen und nicht einem wissenschaftlichen Zustandsbericht.

Zusammenfassend: Der Entwurf zum AR 5 bietet keine ausgewogene und leidenschaftslose Beschreibung der aktuellen Klimawissenschaft, die als Basis für politische Maßnahmen dienen kann. Obwohl einige erfahrene, unabhängige Wissenschaftler wahrscheinlich von dem Bericht in die Irre geführt werden, von denen einige auch schon ihr Unbehagen mit der IPCC-Arbeitsweise kundgetan haben, könnte das Dokument der WG 1 gefährlich werden, wenn Nichtexperten davon Gebrauch machen – vor allem Bürokraten und Politiker.

Die Notwendigkeit einer ausgewogenen wissenschaftlichen Zustandsbeschreibung

Eine einwandfreie wissenschaftliche Zustandsbeschreibung in Sachen globale Erwärmung sollte auf der kritischen Erwägung einer breiten Palette von Studien in wissenschaftlichen Journalen basieren, und nicht auf naivem und bedingungslosem Vertrauen in den Begutachtungsprozess ausgewählter wissenschaftlicher Journale, seien diese auch noch so angesehen (10). Diese Studien sollten kritisch von einer größeren Anzahl von Schiedsrichtern gelesen werden, mehr als die zwei oder drei bei dem Journal angestellten. Außerdem sollten in der Öffentlichkeit die Befürworter einer Hypothese, die Implikationen für teure politische Maßnahmen enthält, nicht ihre eigenen Begutachter oder ihre eigene Jury sein – wie es die IPCC-Leitautoren tatsächlich waren.

Die Kritiker des IPCC, und davon gibt es viele, haben seit Langem Zweifel daran geäußert, ob das Personal des IPCC ausreichend die Notwendigkeit für ordentliche und angemessen sorgfältige Zustandsberichte wie AR 4 und AR 5 wahrnimmt. Diese Zweifel wurden bestätigt, als die Korrespondenz zwischen einigen Leitautoren des IPCC durch Klimagate 1 im Jahr 2009 offen gelegt wurde. Dieses Leck, und ein zweites Leck Ende 2011 zeigten inter alia viele Beispiele wissenschaftlichen Fehlverhaltens, einschließlich im Besonderen einer herablassenden Haltung und emotionaler Reaktionen auf professionelle Kritik von außen.

Detaillierte Analysen der IPCC-Prozeduren und damit Zusammenhängendes von John McLean, Andrew Montford und jüngst durch Donna Laframboise (11) sowie die Analysen von Steve McIntyre auf seinem Blog ClimateAudit verdienen viel mehr Aufmerksamkeit seitens der Politiker als diese bisher dafür übrig hatten. Stattdessen fahren die Politiker fort, ein unterwürfiges Klammern an die politisch gefärbten Ratschläge des IPCC an den Tag zu legen, entweder weil sie es nicht besser wissen oder bevorzugen, die eindeutigen Unzulänglichkeiten und die fehlende Ausgewogenheit der wissenschaftlichen Zusammenfassungen des IPCC nicht zur Kenntnis zu nehmen.

Anfang 2007 hat das IPCC unter Druck von Kritikern die kritischen Kommentare der Begutachter veröffentlicht, die es zum AR 4 WG 1 gegeben hatte, zusammen mit den Antworten auf diese Kritiken von den Leitautoren. Ungefähr zur gleichen Zeit haben die Autoren der Zusammenfassung für Politiker von AR 4 (SPM) ihren Text fertig gestellt, der offenkundig die substantielle Kritik von außen am IPCC nicht enthielt. Und in einer anderen erstaunlichen Missachtung des Prozesses basierte die politisch motivierte SPM des AR 4 auf einem Entwurf der WG 1; weitere sechs Monate gingen ins Land, bevor die Schlussfolgerungen und Behauptungen der SPM in den endgültigen Bericht integriert wurden, auf den die SPM doch aufbauen sollte. Inzwischen haben Sprecher des IPCC bereits die alarmierende Botschaft der fortwährenden gefährlichen globalen Erwärmung in die Welt posaunt, basierend auf der zuvor veröffentlichten SPM.

Diese verschiedenen Umstände und Fakten machen klar, dass eine unabhängige wissenschaftliche Begutachtung des WG1 AR 5 des IPCC unabdingbar ist, sowie der Bericht veröffentlicht wird. Unabhängige Experten haben in der Tat bereits eine solche Begutachtung seit der Veröffentlichung von AR 3 2001 angemahnt, aber ihr Drängen wurde ignoriert.

Wichtig: Die wissenschaftlichen Auditoren müssen (i) ausschließlich von außerhalb des IPCC-Interessenkreises stammen; (ii) sie müssen kompetent genug sein, um ein unabhängiges Urteil über die relevanten Beobachtungen und deren Interpretation fällen zu können, und (iii) sie dürfen sich nicht einfach auf die pro-DAGW-Schlussfolgerungen verlassen, die von den Autoren der meisten Studien gezogen werden.

Frühere Begutachtungen der IPCC-Ratschläge

Viele nationale Wissenschaftsakademien haben zusammenfassende Broschüren zum DAGW-Problem veröffentlicht, veranlasst durch die Kritiken in der Folge der Veröffentlichung von AR 4 2007 (z. B. von der Royal Society of London, der Australian Academy of Science und der US National Academy of Sciences). Diese individuellen Berichte führten etwas später zu einer Untersuchung ihrer übergeordneten Institution, das international Inter-Academy Council (IAC). Die Hauptschlussfolgerung dieser zahlreichen Dokumente – trotz Kritik seitens des IAC über die Unzulänglichkeiten einiger IPCC-Verfahrensweisen, enthüllt durch Klimagate – lautete, dass die wesentlichen Schlussfolgerungen des 4. Zustandsberichtes immer noch als gültig angesehen werden sollten.

Diese Behauptung durch das IAC und andere führte sofort dazu, dass sich die folgende Frage in unabhängigen wissenschaftlich kritischen Kreisen erhob: Welche Schlussfolgerungen?

Dass einige Signale einer moderaten Klimaänderung in der jüngeren Vergangenheit aufgetaucht sind? Aber diese Schlussfolgerung ist wissenschaftlich trivial und steht nicht im Mittelpunkt der DAGW-Frage, die da lautet zu beurteilen, bis zu welchem Grad menschliche CO2-Emissionen eine messbare oder gefährliche Erwärmung verursachen. Wie viel Zeit und Wissen hat das Komitee des IAC damit zugebracht, diese Frage zu beurteilen? Weder die vielen nationalen noch die IAC-Komitees scheinen diese zentrale Frage überhaupt angesprochen zu haben, was viele Wissenschaftler dazu gebracht hat, die Prognosen als politisch willfährige Operationen zur Weißwäsche anzusehen.

Unabhängige Wissenschaftlerkreise stellten sofort in Frage, was eigentlich das IAC so befürwortete. Dessen Schwerpunkt lag auf den Prozeduren und der administrativen Arbeit des IPCC, nicht auf der Integrität von dessen Schlussfolgerungen.

Begutachtungen im parlamentarischen Zusammenhang

Zusätzlich zu den akademischen Begutachtungen haben zahlreiche nationalen Parlamente seit 2007 Anhörungen zur DAGW-Frage organisiert. Im parlamentarischen Kontext hatten diese Anhörungen den sehr starken Vorzug, dass unabhängige angesehene Wissenschaftler involviert waren, zusammen mit den IPCC-Akolyten. Solche Anhörungen haben zumindest in den USA, in Schweden, Australien den Niederlanden und jüngst Kanada stattgefunden.

Trotz der sehr klaren wissenschaftlichen Informationen und Ratschläge dieser Anhörungen (für ein Beispiel siehe Anhang B), die speziell dem IPCC-Alarmismus widersprechen, war ihr nachfolgender Einfluss auf die Öffentlichkeit begrenzt; und zwar aus folgenden Gründen: (i) alle offiziellen Kanäle, über die die Öffentlichkeit über die globale Erwärmung informiert wird, werden durch Material vom IPCC dominiert und (ii) die Medien haben eine starke Aversion, Stories über die Klimaänderung zu verbreiten, die das vorherrschende, politisch korrekte und alarmistische Paradigma herausfordern.

Die Begutachtungen holländischer und französischer Akademien

Der 2007 veröffentlichte Bericht AR 4 wurde formalen Überprüfungen durch die nationalen Akademien Frankreichs und der Niederlande unterzogen. Die beiden Prozesse und die folgenden Berichte weisen bestimmte Ähnlichkeiten auf.

Jeder der beiden Untersuchungen waren informelle Treffen unter den Mitgliedern der Akademien vorausgegangen, woran auch einige geladene externe Wissenschaftler teilgenommen hatten (Niederlande, April 2010; Frankreich, September 2010). Diese anerkennenswerten Initiativen führten zu Audit-Berichten, die unabhängig von der IPCC-internen Begutachtungsprozedur waren.

Trotz der ursprünglich gut gemeinten Absichten, die unvermeidlich von einer begrenzten Anzahl von Autoren zusammengestellt worden sind, wurden in der Folge dafür kritisiert, nicht ausreichend die Nuancen der unterschiedlichen Meinungen der DAGW-Protagonisten und –Antagonisten gespiegelt zu haben, die in den voran gegangenen Besprechungsrunden zum Ausdruck kamen.

Diese Kritik gilt sehr stark vor allem dem Audit-Bericht der Royal Dutch Academy of Sciences (KNAW), veröffentlicht im Oktober 2012 (12). Der Bericht war erheblich in Richtung der IPCC-Doktrin verzerrt und erwähnte nicht die Kommentare der DAGW-Antagonisten während der Treffen. Außerdem hat sich die KNAW sehr beeilt, die Aufmerksamkeit des Ständigen Parlamentsausschusses für Infrastruktur und Umwelt auf ihren Bericht zu lenken, ohne vorher noch einmal die Teilnehmer des Treffens zu konsultieren. Dieses Vorgehen führte zu einem formalen Protest und der Forderung, den Bericht zurückzuziehen. Unterschrieben war er von 23 Professionellen mit wissenschaftlichem Hintergrund – nicht zuletzt, weil der Bericht ein Dutzend aussagestarker Feststellungen bzgl. DAGW enthielt, die wissenschaftlich als nicht gerechtfertigt angesehen waren. Die Forderung wurde ignoriert, und der verfälschte Bericht blieb in der ursprünglichen Fassung bestehen (Februar 2012).

Eine Untersuchung der Prozeduren durch die Autoren des holländischen Berichtes brachte ans Licht, dass eine kleine Zahl anonymer pro-DAGW-Begutachter den Ton im endgültigen Text vorgegeben hatte, was erneut das Ausmaß zeigt, mit dem IPCC-Insider mit politischen Mitteln den „wissenschaftlichen“ Rat an Politiker beeinflussen können. Trotz dieses ungehörigen und unangebrachten Einflusses präsentierte die Akademie den Bericht als eine autorisierte Feststellung einer ‚gebildeten’ Vereinigung. Offensichtlich hatte die Akademie so viel Vertrauen in einige ausgewählte akademische Autoren, dass sie sich nicht die Mühe gemacht hat, unabhängige auswärtige Wissenschaftler zu konsultieren, die ziemlich genau, tatsächlich wesentlich in die Begutachtung involviert waren.

Solche Aktionen gehen ganz klar nicht konform mit dem Motto der ältesten wissenschaftlichen Akademie der Welt, der Royal Society of London, das da lautet: ‚Nullius addictus iurare in verba magistri‘ (ich bin nicht verpflichtet, irgendeinem Herrn Gefolgschaft zu schwören).

Betrachtet man die Schlussfolgerungen der Debatte bei der französischen Akademie der Wissenschaften, berichteten die französischen medien, dass sie voll auf der Linie des WG 1 AR 4 lagen.

Diese Schlussfolgerung unterscheidet sich jedoch um Einiges vom verständnis einiger Mitglieder der Akademie, die an der Diskussion teilgenommen hatten. In seiner Analyse weist der Akademiker Vincent Courtillot darauf hin, dass die Akademie nicht in vollem Umfang das für und wider gegeneinander abgewogen hat, sondern einfach die verschiedenen – sich teilweise widersprechenden – Ansichten nebeneinander gestellt hat (13).

Trotz all der abweichenden Meinungen und gegenteiliger Aussagen in den französischen und holländischen Akademien scheinen die wesentlichen Schlussfolgerungen in ihren Berichten die Autorität des IPCC zu stützen. Zum Beispiel heißt es im Bericht der französischen Akademie:

Eine Anzahl unabhängiger Indikatoren weist auf eine Zunahme der globalen Erwärmungsrate von 1975 bis 2003 hin; diese Zunahme erfolgt hauptsächlich durch die zunehmende CO2-Konzentration in der Atmosphäre.

Und im holländischen Bericht heißt es:

Die gegenwärtigen Klimamodelle erklären zum größten Teil die Klimaänderungen im 20. Jahrhundert. Diesen Modellen zufolge kann der globale Temperaturanstieg im späten 20. Jahrhundert nicht erklärt werden, ohne die anthropogene Erzeugung von Treibhausgasen zu betrachten.

Eine Zusammenfassung der entgegen gesetzten Ansichten der DAGW-Antagonisten ist im Audit-Bericht von unabhängigen Wissenschaftlern an die australische Regierung enthalten. Siehe Anhang B mit einem Auszug und Referenz.

Was führt zu der Dominanz des IPCC-DAGW-Paradigmas?

Zweifellos ist das vom IPCC bevorzugte Paradigma der gefährlichen globalen Erwärmung durch menschliche CO2-Emissionen fest in den Köpfen der Öffentlichkeit, der Medien und der Politiker verankert. Die Schlüsselfrage lautet jedoch: „bis zu welchem Grad resultiert diese Dominanz aus der Aussagekraft der wissenschaftlichen Beweise, und bis zu welchem Grad aus der höchst aktiven öffentlichen und politischen Kommunikation durch das IPCC vor dem Hintergrund einer willfährigen, tatsächlich DAGW oft missionarisch vorantreibender Medien?“

Zweifellos ist die DAGW-Hypothese des IPCC oberflächlich plausibel. Die Hypothese macht auch wissenschaftlich detaillierter Sinn, solange man nur das zugrunde liegende Konzept des „Treibhauseffektes“ akzeptiert, dass man die Klimaänderung einteilen kann nach den verschiedenen separat einwirkenden Treibern, dass all diese Treiber bekannt sind und dass das Klima als deterministisches System erfolgreich analysiert werden kann.

Allerdings stellen viele kompetente Wissenschaftler einen, zwei, drei oder alle vier dieser Positionen in Frage, und zwar mit durch und durch vernünftigen und verantwortungsvollen Argumenten. Daher ist der Gebrauch all dieser überheblichen Vermutungen als Basis für die Propagierung der globalen Erwärmung, wie es das IPCC macht, so, als ob man Logik innerhalb eines subjektiven kulturellen Paradigmas anbringen wollte. Dies, nämlich die Verwendung einer Modellannahme innerhalb eines gegebenen und nicht hinterfragbaren Denksystems ist natürlich das Kennzeichen der postmodernen wissenschaftlichen Vorgehensweise.

Aber wenn man diese Positionen verwirft – nicht zuletzt, weil diese prognostizierten Ergebnisse den Beobachtungen widersprechen – erscheint ein sehr unterschiedliches Bild der Klimavariabilität. Akzeptiert man eine alternative konzeptionelle Annäherung, könnte sich der Zusammenhang mit einem „Treibhauseffekt“ und einer Quantifizierung der angenommenen Klimatreiber als falsch herausstellen und eher ein Hindernis als eine Hilfe bei Fortschritten des Wissens sein.

Schlussbemerkungen

Es ist offensichtlich, dass Audits, die mehr auf Autorität als auf wirklicher wissenschaftlicher Expertise beruhen, hinsichtlich der grundlegenden Prinzipien wissenschaftlicher Untersuchungen fragwürdig bleiben.

Die Beschreibung der vermeintlichen DAGW-Bedrohung erfordert daher eine vollständig neue wissenschaftliche Begutachtung, die mit den IPCC-Argumenten und solider alternativer technischer Informationen gleichwertig ist, wie z. B. die Berichte des NIPCC. Eine solche ausgewogene Begutachtung wurde definitiv durch irgendeine wissenschaftliche Akademie bisher nicht durchgeführt, weil alle das betrügerische IPCC-Treibhausmodell vorbehaltlos akzeptiert haben (einschließlich der Gültigkeit des Konzeptes unabhängiger und schwierig zu definierender Antriebe, welche komplexe Prozesse sind), und weil alle die Notwendigkeit, sich der Klimaänderung durch die Komplexitätstheorie anzunähern, ignoriert haben.

Einige jüngere Wissenschaftler, die unter dem Einfluss postmoderner Wissenschaft studiert haben, könnten dies als altmodisch ansehen. Aber mein Appell lautet, dass wir weiterhin die Traditionen der Grundlagen- und angewandten Wissenschaft respektieren sollten, wie sie während der historischen Periode, die wir Aufklärung nennen, etabliert worden sind. Es war nämlich von größtem Vorteil für moderne Gesellschaften, dass wir seit vier Jahrhunderten die wissenschaftliche, experimentelle, empirische und theoretische Praxis übernommen haben, und zwar unter den wachsamen Augen von Universitäten und gebildeten Gesellschaften.

Nach dem, was wir das IPCC-„Abenteuer“ nennen können, ist es mein Appell an zeitgemäße politische und wissenschaftliche Administratoren, dass sie sich jetzt einmal kritisch überlegen, ob die nationalen Wissenschaftsakademien und –agenturen dem wissenschaftliche Prinzip, „Qualität ist der Eckpfeiler der Wissenschaften“, noch folgen. (14)

Danksagung

Die erste Version dieses Arbeitspapiers und die neun Entwürfe zuvor wurden von 15 Wissenschaftlern kommentiert. Was ich dankbar willkommen heiße. Und die mich zu ein paar Änderungen veranlasst haben. Anstatt ihre Namen zu nennen, lade ich diese Schiedsrichter ein, selbst zu benennen, bis zu welchem Grad sie meine Analyse unterstützen und meiner Forderung folgen wollen, dass Zustandsbeschreibungen durch individuelle Nationen vorgenommen werden sollten, weitgehend unabhängig vom IPCC. Diese Begutachtungen sollten am Besten durch erfahrene und etablierte Wissenschaftler durchgeführt werden, deren Reputation in traditionellen Disziplinen wurzelt, die die Klimawissenschaft bilden, speziell Physik, Chemie, Geologie, Astronomie, Sonnenphysik und Meteorologie. Die Audits sollten sich an den traditionellen Prinzipien der Wissenschaft orientieren und sich auf die wissenschaftliche Methodik und empirische Beweise stützen, die die hypothetische DAGW in Frage stellen.

Anhang A: Ausgewählte Punkte in verschiedenen, vom IPCC unabhängigen Begutachtungen und in den Berichten des NIPCC

1.

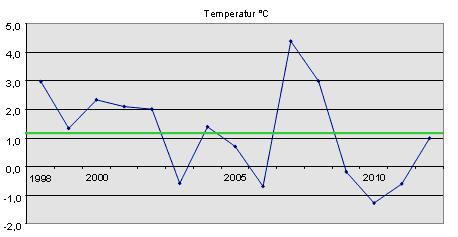

Wie aus den vom IPCC bevorzugten Temperaturaufzeichnungen von HadCRUT hervorgeht, hat es seit 1995 keine statistisch signifikante Erwärmung mehr gegeben, trotz einer Zunahme des atmosphärischen CO2-Gehaltes um 20% seit jenem Jahr (welches selbst 34% aller Emissionen in Verbindung mit Menschen seit dem Beginn der industriellen Revolution repräsentiert).

Dies ist an sich nicht so überraschend, wie es scheint. Noch einmal, es ist wissenschaftlich unumstritten, dass die Beziehung zwischen dem zunehmenden atmosphärischen Kohlendioxid und der atmosphärischen Erwärmung eine negativ logarithmische ist. Mit anderen Worten, jeder zusätzliche Eintrag verursacht eine geringere Folgeerwärmung.

2.

Gelogische Klimaaufzeichnungen zeigen, dass im richtigen Zusammenhang nichts Ungewöhnliches an der moderaten Erwärmung um ein paar Zehntelgrad ist, die es zum Ende des 20. Jahrhunderts gegeben hat. Gleiche oder höhere Temperaturen gab es viele Male in vielen Gebieten während des Holozäns (die letzten 10 000 Jahre) und während des Pleistozäns (vor 6 bis 3 Millionen Jahren), und man schätzt, dass es auf der Erde im Mittel in diesen Zeiten 2 bis 3 Grad Celsius wärmer war als heute; und keine Krise der Biodiversität ist erfolgt. Diese Art der Temperaturoszillationen ist charakteristisch während der gesamten Geologie und wurde verursacht durch solare und andere Gründe – die bei weitem noch nicht völlig verstanden sind.

3.

Betrachtet man das globale Eisvolumen, erkennt man, dass das jüngste Abschmelzen des arktischen Meereises (noch einmal, was es in früheren geologischen Zeiten schon oft gegeben hatte) durch ein Anwachsen des Meereises um die Antarktis kompensiert worden ist, d. h. die Gesamteisbedeckung hat sich kaum verändert. Außerdem ist das Schmelzen in der Arktis NICHT durch steigende atmosphärische Temperaturen verursacht worden, sondern durch viel komplexere Gründe, unter anderem Änderungen der Windsysteme (wobei Eis südwärts in wärmere Gewässer verfrachtet wird) und warme Meeresströmungen (welche beim Eintritt in den Arktischen Ozean das Eis direkt schmelzen).

4.

Die Analyse antarktischer Eisbohrkerne zeigt, dass das Niveau des Kohlendioxids und die Temperatur tatsächlich parallel variierten während der letzten vielen hunderttausend Jahre. Allerdings sind die beiden Verläufe nicht genau phasengleich, wobei Änderungen des CO2-Gehaltes den Temperaturänderungen um 800 bis 2000 Jahre hinterher hinken. Diese fundamentale Tatsache stellt die CO2-Temperatur-Annahme der DAGW-Hypothese schwer in Frage und ist konsistent mit den CO2 freisetzenden, sich erwärmenden Ozeanen.

5.

Die zahlreichen ökologischen und umweltlichen Änderungen, die der DAGW durch das IPCC zugeschrieben werden, sind genauso konsistent mit der Null-Hypothese wie die beobachteten Änderungen in der modernen natürlichen Welt, die in Übereinstimmung mit natürlichen und umweltlichen Änderungen stehen. Vögel, die früher oder später nisten, weniger oder mehr Eisbären, mehr oder weniger Regen, mehr oder stärkere Hurrikane – sollte irgendein Ereignis dieser Art stattfinden – sind durch die Bank zu erwartende Ereignisse im Zusammenhang mit der natürlichen Klimavariabilität der Erde.

Trotz gewaltiger Ausgaben für die damit verbundene Forschung ist es bisher noch keiner Studie gelungen, solche biotischen oder klimatischen Änderungen mit dem sich ansammelnden CO2 in der Atmosphäre in Zusammenhang zu bringen.

Anhang B: Das australische unabhängige Audit

Dieses Audit (Carter et al 2009) (15) der IPCC-Äußerungen, das dem australischen Parlament durch das Department of Climate Change übermittelt worden ist, wurde auf Anforderung von dem unabhängigen australischen Senator Stephen Fielding durchgeführt. Und zwar durch eine qualifizierte Gruppe erfahrener Wissenschaftler aus verschiedenen Disziplinen mit klimatologisch-meteorologischem Hintergrund, einem Hydrologen, einem Computermodellierer und einem Geologen.

Das Audit fand massive Defizite beim IPCC – bis zu einem Grad, dass Senator Fielding veranlasst hat, gegen die Gesetzgebung zum Emissionshandel zu stimmen – was zu dessen Ablehnung führte.

Die wesentlichen Schlussfolgerungen dieses australischen Audits waren Folgende:

(i) Die jüngste Zunahme der Treibhausgase spielt eine geringere radiative Rolle beim globalen Klima, es existiert kein stichhaltiger Beweis, dass menschliche CO2-Emissionen eine gefährliche globale Erwärmung verursachen oder in Zukunft verursachen werden, (ii) es ist eine unkluge Umweltpolitik der Regierung, auf einer monopolistischen Aussage zu basieren, vor allem, wenn dieses Monopol durch eine internationale politische (nicht wissenschaftliche) Agentur repräsentiert wird (d. h. das IPCC); (iii) Die Folgen der Gesetzgebung zum Emissionshandel werden so teuer, so besorglich regressiv, sozial spaltend und umweltlich ineffektiv sein, dass das Parlament die Überlegung zum CPRS (Emissionshandel) aussetzen sollte und eine vollständig unabhängige Kommission einsetzen sollte, um die Beweise für und gegen einen gefährlichen menschlichen Einfluss auf das Klima zu untersuchen. Hinsichtlich (iii) fügen wir hinzu, dass die wissenschaftliche Gemeinschaft inzwischen so polarisiert hinsichtlich dieses kontroversen Themas ist, dass die angemessene Sorgfalt hierbei nur erreicht werden kann, wenn kompetente wissenschaftliche Zeugen ins Kreuzverhör genommen werden, unter Eid und unter strikten Vorgaben von Beweisen.

Trotz dieser Forderungen und trotz des Scheiterns des Emissionshandels im Parlament wurde keine Kommission ins Leben gerufen, und die australische und internationale Presse hat nichts über dieses wissenschaftliche Audit berichtet.

Arthur Rörsch

Über den Autor:

1 Dr. Arthur Rörsch hat einen Grad als Chemieingenieur der University of Delft (1957) und einen PhD der University von Leyden (1963). Er ist Ritter des Ordens Dutch Lion (1994). Seine wesentliche Tätigkeit war die Mitgliedschaft, zeitweise auch als Vizepräsident, des Managementboard der Netherlands Organisation for Applied Research, TNO, 1979 bis 1994) mit spezieller Verantwortung für die Forschungsgebiete öffentliche Gesundheit, Nahrung & Landwirtschaft sowie Umwelt. Als Student war er Sekretär des Departments ‚Delft’ der Netherlands Association for Meteorology and Astronomy.

Auf europäischer Ebene war er in Komitees involviert, die die Qualität von EU-Projekten und wissenschaftliche Institutionen bewerten sollte. Als Generalsekretär der European Molecular Biological Conference (einer politischen Institution mit seinerzeit 10 Mitgliedern) war er aktiv im Wechselspiel zwischen Wissenschaft und Regierungspolitik. Als Vorsitzender des National (Dutch) Council for Agricultural Research arbeitete er vier Jahre lang (1995 bis 1999) an der Entwicklung von Szenarien und Vorhersagen aus theoretischer und angewandter Sicht.

Als Mitglied des Beratungsgremiums des populären holländischen Wissenschaftsjournals ‚Natuur, Wetenschap and Techniek‘ (1970-2009) hatte er auch großes Interesse an der Qualität der Informationen, die der Öffentlichkeit von der wissenschaftlichen Gemeinschaft durch modernen Wissenschaftsjournalismus gegeben worden sind.

2 Traditionelle objektive Wissenschaft basiert auf der Interpretation von Beobachtungen und dem Formulieren einer Hypothese, gefolgt von der Interpretation und den logischen Implikationen dieser Hypothese sowie der ständigen Überprüfung. Nachmodernisten hinterfragen nicht die Rationalität, sondern ob sie eine reale Einsicht in die Welt darstellt. Regeln der Logik finden nur innerhalb eines gegebenen kulturellen Paradigmas oder Modells Anwendung, die auf einem gegebenen Denksystem beruhen.

http://en.wikipedia.org/wiki/Science_wars

http://www.spaceandmotion.com/Philosophy-Postmodernism.htm

3 Hunderte von Studien, die Daten oder Besprechungen enthalten, die nicht DAGW uunterstützen, wurden in den früheren Berichten des NIPCC unabhängig zusammengefasst und analysiert. Die Ausgaben der NIPCC-Berichte sind daher ein Muss, wenn es um Gegenliteratur zu den IPCC-Berichten geht, und zwar für diejenigen, die eine umfassende, ausgewogene Sicht des komplexen Themas DAGW und Klimaänderung erhalten wollen. http://www.nipccreport.org/reports/2011/pdf/FrontMatter.pdf

4 http://www.ipcc.ch/pdf/assessment-report/ar4/wg1/ar4-uncertaintyguidancenote.pdf

5 „Es gab eine Zeit, in der Päpste und Könige Astrologen um sich hatten, die ihnen helfen sollten, die Zukunft zu planen. Heutzutage haben Regierungsabteilungen Statistiker für den gleichen Zweck. (…) Aber für viel der statistischen Arbeit durch Regierungsabteilungen kann ich keine Entschuldigung finden“. M. J. Moroney in ‘Facts from Figures’(Pelican 1957) in Kapitel 17 ‘Time series and Fortune Telling’

6 und 7 Für den aktuellen Stand der Technik siehe: Encyclopaedia Britannica 1964, volume V page 914-927:

„Die grobe Verteilung der Klimaänderung seit dem Ende der Eiszeit ist konsistent mit der Hypothese einer alternierenden Verstärkung und Abschwächung der planetarischen atmosphärischen Zirkulation, verbunden mit einer alternierenden Verlagerung der Windzonen in Richtung Äquator oder Pole.“

8 D.A.Randall (ed) “General Circulation Model Development. Past, Present and Future. (Academic Press

2000).

9 aktualisierte Version: EARTH’S GLOBAL ENERGY BUDGET by Kevin E. Trenberth, John T.

Fasullo, and Jeffrey Kiehl. AMERICAN METEOROLOGICAL SOCIETY März 2009

10 . J.P.A. Ioannidis. “Why most Published Research findings are false”. PloS Medicine, August ,2005.

Vol 2. Issue 8, 696-701

11 J. McLean “Peer review, what peer reviews? Failures of scrutiny of the UN’s fourth assessment report

(2007) http://scienceandpublicpolicy.org/images/stories/papers/originals/mclean/mclean_IPCC_review_final_9-

5-07.pdf

A. Montford. http://www.amazon.co.uk/Illusion-Climategate-Corruption-Science-

Independent/dp/1906768358

D. Laframboiboise. http://wattsupwiththat.com/2011/10/14/donna-laframboises-new-expose-book-onthe-

ipcc/

12 Theo Wolters. “Sceptical seminar climate report of Dutch Science academy www.climategate.nl. Dec. 29. 2011

13 Siehe: http://www.thegwpf.org/science-news/1804-vincent-courtillot-the-climate-report-by-the-frenchacademy-

of-sciences.html.

14 meinung von Hendrick Casimir, ein sehr respektierter Physiker und Wissenschaftsberater, früher Direktor des Philips Physics lab in Eindhoven, Niederlande.

15 http://joannenova.com.au/global-warming/the-wong-fielding-meeting-on-global-warming-documents/;

Punkt 7 auf der Liste)

Übersetzt von Chris Frey für EIKE