UPDATE 2 (5. Januar 2012): BITTE LESEN! Drei Dinge: Erstens, ich habe den Unterschied zwischen einem „linearen Zeittrend“ (Foster und Rahmstorf, hiernach F&R) und einem „linearen Trend“ nicht verstanden. Meine Konfusion führte auch bei vielen Bloggern zu Konfusion, die meinen Beitrag gelesen und bei WattsUpWithThat kommentiert haben (hier). Dafür möchte ich mich entschuldigen. Für alle Interessierten: der „lineare Zeittrend“ wird unter der Überschrift „Data as trend plus noise” bei Wikipedia beschrieben (hier).

Zweitens habe ich zusätzlich zu MEI, AOD und TSI als unabhängige Variable fälschlich die Werte des linearen Trends verwendet, die EXCEL mit seiner LINEST-Funktion aus den monatlichen GISS-Daten als vierte unabhängige Variable berechnet hat. Und dies addiert sich zu der Konfusion jener, die die Gleichungen interpretiert haben. In der Rückschau denke ich, dass ich diese Gleichungen nicht hätte bringen sollen. Stattdessen hätte ich eine Tabelle bringen sollen, in der die Koeffizienten aufgelistet sind.

Drittens, in der Eile, mit der ich diesen Beitrag veröffentlicht habe, ist es mir nicht gelungen, die Schritte zur Bearbeitung der Daten zu erklären, was Vielen beim Betrachten der Gleichungen und Graphen konfus erscheinen mochte. Ich habe die Regressionsanalysen mit den „rohen“ monatlichen Daten durchgeführt; danach habe ich unter Verwendung der sich ergebenden Koeffizienten die monatlichen Daten angepasst. (Ich hatte einen Graphen unter Verwendung monatlicher Daten vorbereitet, ähnlich der Abbildung 4 bei F&R mit den Jahren 1979 bis 2010 als Basis. Aber ich hatte den Eindruck, dass meine Version ein unintelligenter Spaghetti-Graph mit wenig Aussagekraft war, also habe ich ihn nicht gebracht). Dann habe ich die angepassten Daten in jährliche Daten umgerechnet und schließlich 1979 bis 2010 als Basisjahre herangezogen.

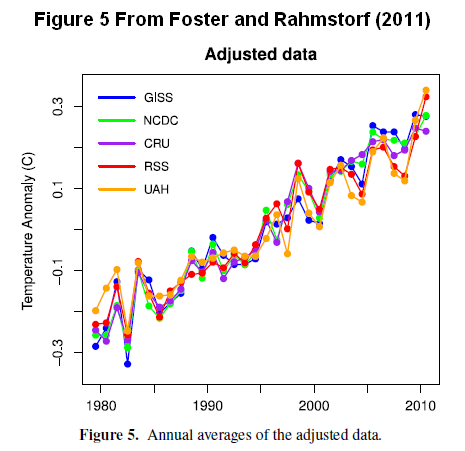

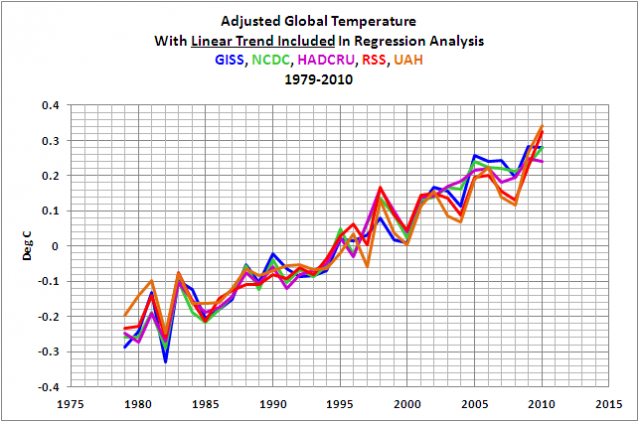

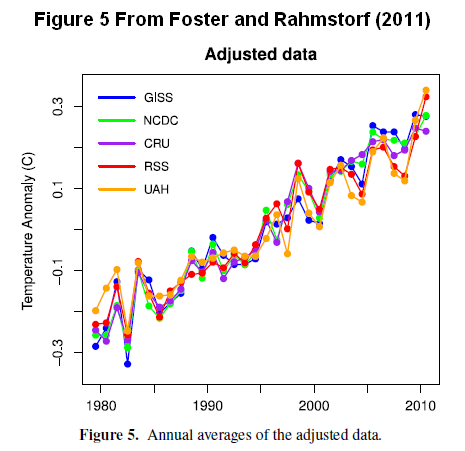

Unter dem Strich: Obwohl ich einen linearen Trend mit einem linearen Zeittrend verwechselt habe, und obwohl ich nicht alle zusätzlichen Feinheiten in den von F&R (2011) verwendeten Daten eingeschlossen habe, ist es schwer, irgendeinen Unterschied zwischen der Abbildung 7 von mir und der Abbildung 5 von F&R zu erkennen. Es gab Kommentare von anderen Bloggern zu dem Beitrag auf WUWT, die mit unterschiedlichen Methoden zu ähnlichen Ergebnissen gekommen waren. Heißt das, dass die Ergebnisse von F&R (2011) so stichhaltig sind wie in einigen Kommentaren bei WUWT behauptet? Nein. ENSO ist ein Prozess, kein Index, und es kann nicht für lineare Regressionsanalysen herhalten. Dies wurde klar gezeigt und detailliert diskutiert unter der Überschrift ENSO IS NOT AN EXOGENOUS FACTOR.

Update 1: (3. Januar 2012): Unter dieser Überschrift habe ich den Wortlaut eines Satzes verändert und das Wort „create“ mit dem Wort „recharge“ ersetzt.

Übersicht

Dieser Beitrag befasst sich mit einem merkwürdigen Aspekt der multiplen linearen Regressionsanalyse von Foster and Rahmstorf der in ihrem 2011 Papier “Global Temperature Evolution 1979–2010” zu finden ist. Ich finde es sehr seltsam, dass der Faktor, auf denen das Papier zu beruhen scheint, nicht im Detail hier vorgestellt wird. Zur Klarstellung für diesen Teil des Beitrages, ich will nicht implizieren, dass etwas falsch ist mit diesem spezifischen Aspekt des Papiers, aber ich bin auch nicht einverstanden mit ihm. Ich habe es jetzt zur Diskussion hier vorgelegt.

Der zweite Teil dieses Beitrags ist eine Diskussion über eine der exogenen Faktoren, den Foster und Rahmstorf (2011) versucht haben, zu entfernen. Das Problem dabei: Es ist kein exogener Faktor. Und gibt es eine dritte Diskussion über einen Datensatz in einem Tabellenblatt vom Hauptautor Grant Foster (aka Tamino), der aber seltsamerweise nicht im Paper selbst erwähnt wird.

Es ist nicht überraschend, das das Foster und Rahmstorf (2011) Papier auf den Blogs der Befürworter der anthropogenen globalen Erwärmung die Runde gemacht hat. Joe Romm lobte es mit dem Post "Sorry, ihr Leugner, Die Studie des "True Global Warming Signals" zeigt eine "bemerkenswert stabile" Rate der menschgemachten Erwärmung seit 1979. Und SkepticalScience erläutert das Papier in seinem Beitrag zu Foster und Rahmstorf "Sie messen das Global Warming Signal". Und auch auf RealClimate gab es eine lobende Erwähnung durch die Aufnahme als eines der Themen in ihren Neuigkeiten zur globalen Temperatur.

Einführung

F&R (2011) haben versucht, aus 5 globalen Temperaturdatensätzen die linearen Effekte von drei Faktoren zu entfernen, von denen bekannt ist, dass sie Variationen der globalen Temperatur hervorrufen.

Sie überdeckten die Periode von 1979 bis 2010. Die offensichtliche Absicht der Studie ist es zu zeigen, dass die anthropogene globale Erwärmung unvermindert in allen Datensätzen andauert. Die unabhängigen Variablen, die im Abstract von F&R (2011) aufgelistet werden, sind El Niño-Southern Oscillation, vulkanische Aerosole und solare Variationen. F&R (2011) scheint eine viel klarere Version des Beitrags von Tamino (Grant Foster) vom 20. Januar 2011 zu sein: How Fast is Earth Warming? Nach der Veröffentlichung dieser Studie hat sie Tamino in seinem Beitrag The Real Global Warming Signal diskutiert und freundlicherweise die Quelldaten und den Code in seinem Beitrag Data and Code for Foster & Rahmstorf 2011 zur Verfügung gestellt. Die Daten von Tamino finden sich hier. Es ist eine .zip-Datei, die Tamino in eine .xls-Datei umbenannt hat, um, wie er erklärt, „die Weltpresse glauben zu machen, dass es sich um eine Excel-Datei handelt. Man muss einen „Rechtsklick und dann Speichern unter…“ durchführen und dabei die Rückbenennung in eine .zip-Datei vornehmen, um sie öffnen zu können.

Wie oben erwähnt haben F&R (2011) die exogenen Faktoren aufgelistet, die als unabhängige Variable in der multiplen Regressionsanalyse als “El Niño/southern oscillation, volcanic aerosols and solar variability“ bezeichnet werden. Komischerweise haben F&R drei Absätze später bei der nochmaligen Auflistung der Faktoren bei der multiplen Regressionsanalyse eine vierte Variable eingeführt: linearer Trend. Der letzte Satz des dritten Absatzes unter der Überschrift „Introduction“ lautet:

„Der Einfluss exogener Faktoren wird durch eine multiple Regression der Temperatur in Abhängigkeit von ENSO, vulkanischer Einflüsse, der gesamtsolaren Einstrahlung und einem linearen Zeittrend durchgeführt, um die globale Erwärmung anzugleichen, die seit 32 Jahren Gegen¬stand der Analyse ist.“

Aber eine der Grundlagen dieser Studie ist es zu illustrieren, wie ähnlich sich die Trends sind, nachdem die Anpassungen für ENSO, Solarstrahlung und vulkanischer Aerosole vorgenommen worden waren, einschließlich der linearen Trends der Datensätze, die in der Regressionsanalyse als eigenartig auffielen. In der Folge machte ich mich daran, nach einem anderen Grund zu suchen, warum F&R diesen linearen Trend in ihre Regressionsanalyse einfließen lassen mussten. Wie ich im Folgenden anmerke, benutze ich kommerzielle Zusatzsoftware für EXCEL, um diese multiple Regressionsanalyse durchzuführen. Da ich keine anderen Mittel habe, die Resultate zu verifizieren, anders als die Ergebnisse eines ihrer Graphen zu reproduzieren, bitte ich Sie, die folgenden Ergebnisse zu bestätigen, wenn Sie diese Möglichkeit haben.

Warum haben sich F&R genötigt gesehen, einen linearen Trend in die multiple Regressionsanalyse einzuführen?

Den einzigen Grund, den ich dafür erkennen kann, ist Folgender: Der Anpassungsfaktor für die solaren Daten ist das falsche Vorzeichen, wenn in der multiplen Regressionsanalyse nur ENSO, solar und vulkanisches Aerosol als unabhängige Variable eingehen. Lassen Sie mich das detaillierter erklären. Aber noch einmal bitte ich zu verstehen, dass ich in diesem Abschnitt des Beitrags nicht impliziere, dass mit diesem spezifischen Aspekt der Studie etwas nicht stimmt; und noch einmal: ich stimme damit nicht überein. Ich fand es nur interessant.

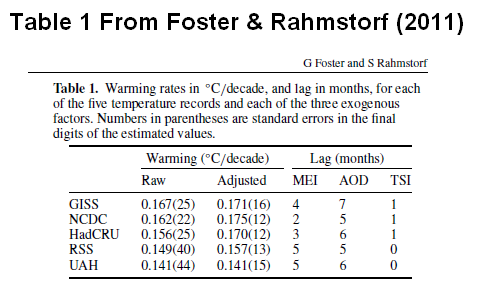

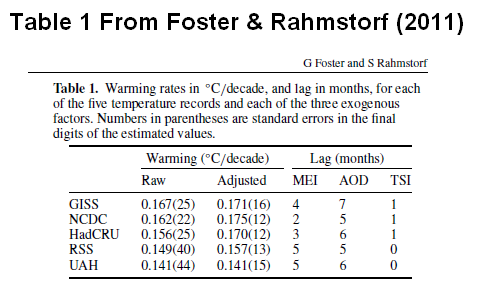

Mit den von Tamino zur Verfügung stellten Daten, habe ich Analyse-It for EXCEL– Software benutzt, um eine multiple Regressionsanalyse durchzuführen. Meine ursprüngliche Analyse schließt ein Taminos Lieblingsdatensatz der Globalen Temperatur nach GISS als abhängige Variable und den mehrdimensionalen ENSO-Index (MEI), die totale Solarstrahlung (PMOD) und die Daten zur Dichte vulkanischen Aerosols (AOD) als unabhängige Variable. Ich habe meine MEI-Daten vier Monate verzögert dargestellt, die PMOD-Daten einen Monat und die AOD-Daten sieben Monate in Übereinstimmung mit Tabelle 1 von F&R (2011), die auch in diesem Beitrag Tabelle 1 ist. Und in dieser Analyse habe ich den GISTEMP linearen Trend als unabhängige Variable nicht berücksichtigt.

Tabelle 1:

Die multiple Regressionsanalyse allein mit den ENSO (MEI), Solar (PMOD) und vulkanische Aerosole (AOD) ergibt sich aus Gleichung 1:

EQUATION 1:

GISS = 123.6 + 0.06769MEI(4m lag) – 0.09025TSI.PMOD(1m lag)– 3.837AOD (7m lag)

[4m lag etc. = 4 Monate Verzögerung usw. Gilt auch für alle anderen Gleichungen. A. d. Übers.]

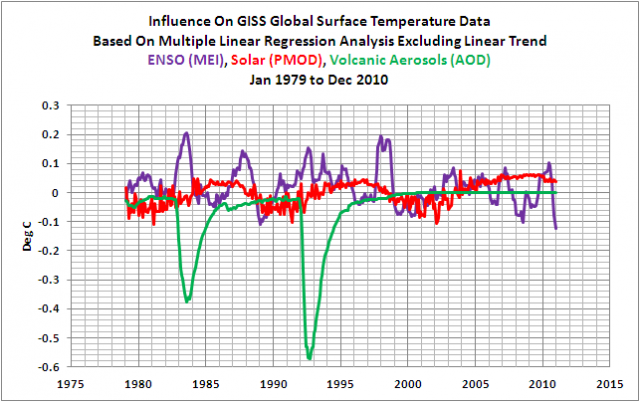

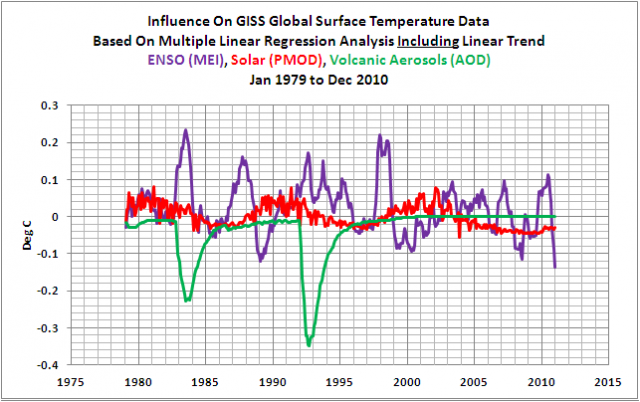

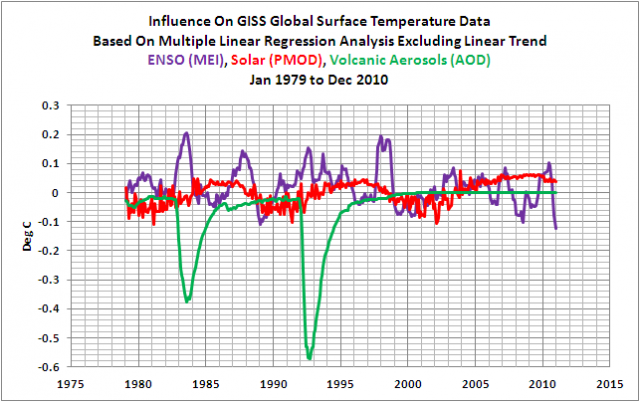

Ich habe den Term für die solare Variable [in der Gleichung] in Fettdruck dargestellt, um die Tatsache hervorzuheben, dass das Vorzeichen negativ ist. Er müsste positiv sein, um die Ergebnisse von F&R (2011) zu reproduzieren. Die Vorzeichen von ENSO und für das vulkanische Aerosol entsprechen dem, was man erwartet, siehe Abbildung 1. Gegensätzlich zu F&R ist lediglich das Vorzeichen des Solarkoeffizienten, wie Abbildung 2 zeigt (welche ihre Abbildung 7 ist).

Abbildung 1

HHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHH

Abbildung 2

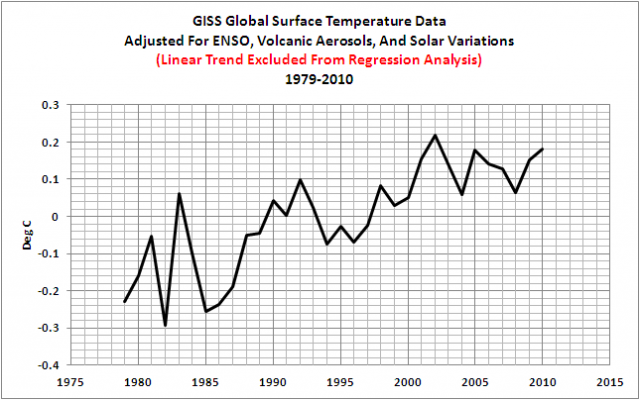

Und das ergibt einen monumentalen Unterschied zum Ergebnis von F&R (2011). Wenn wir die GISS-Daten der Temperatur mit den Faktoren aus Gleichung 1 anpassen, ist der Anstieg nicht kontinuierlich. Siehe dazu Abbildung 3. Das Jahr mit der globalen Temperaturspitze der adjustierten GISS-Daten ist das Jahr 2002.

Abbildung 3

Um die Ergebnisse von F&R (2011) zu stützen, habe ich einen linearen Trend von 0,167°C pro Dekade zu den Anomaliedaten von GISS als unabhängige Variable hinzugefügt. Die Verzögerungen von ENSO (MEI), Solar (PMOD) und vulkanisches Aerosol (AOD) bleiben die gleichen wie zuvor.

Die multiple Regressionsanalyse mit ENSO (MEI), Solar (PMOD) und vulkanisches Aerosol (AOD) und dem linearen Trend ergibt sich aus Gleichung 2:

EQUATION 2:

GISS = -91.43 + 1.024Trend + 0.0761MEI(4m lag) + 0.06694TSI.PMOD(1m lag)– 2.334AOD (7m lag)

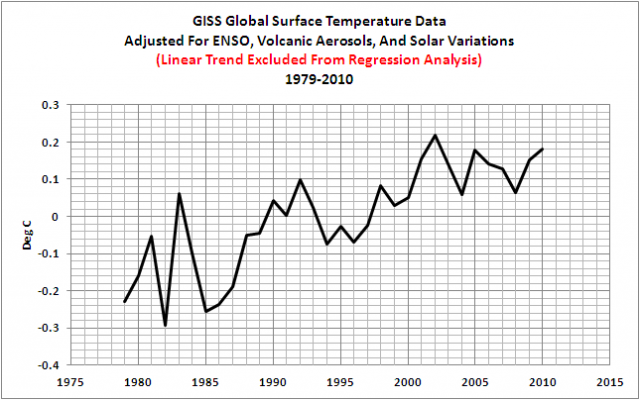

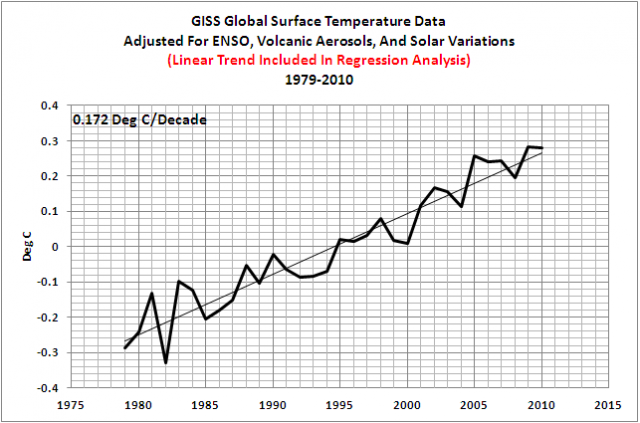

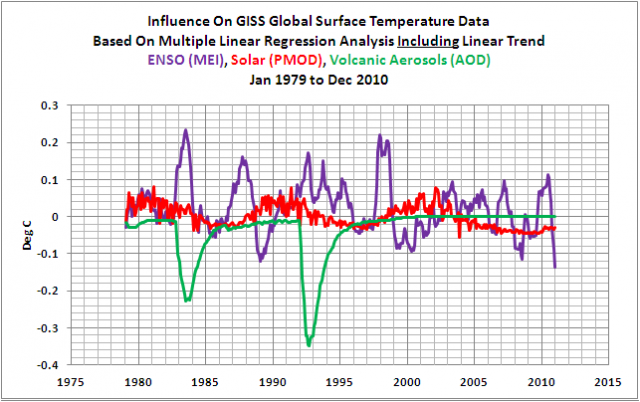

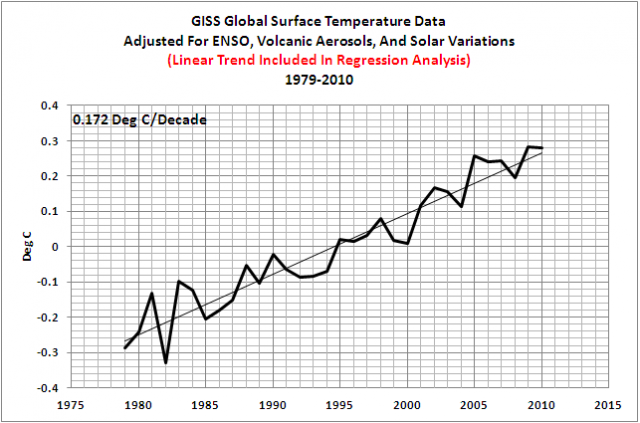

Das Vorzeichen des Koeffizienten der Sonneneinstrahlung stimmt jetzt mit F&R überein, wie Abbildung 4 zeigt. Man beachte, dass die Einführung des linearen Trends als unabhängige Variable auch die Skalierung der anderen drei Variablen verändert. Es hat den Skalierungsfaktor der ENSO-Daten etwas zunehmen lassen und den Skalierungsfaktor des vulkanischen Aerosols signifikant abnehmen lassen. Natürlich ergibt die Einführung des Trends als unabhängige Variable mit der Änderung des Vorzeichens der Solarstrahlung auch mit den GISS-Daten das von F&R gewünschte Ergebnis, Abbildung 5, mit einem relativ stetigen Temperaturanstieg während des 32-jährigen Zeitraumes. Und man beachte, dass der Trend von 0,172°C pro Dekade mit den Ergebnissen von F&R (2011) vergleichbar ist, die in Tabelle 1 gelistet sind.

Abbildung 4

HHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHH

Abbildung 5

Natürlich habe ich die Trendanpassung aus Gleichung 2 nicht eingeführt (und F&R (2011) konnten sie nicht einführen), als ich die korrigierten Daten in Abbildung 5 gezeigt habe. Nachdem die Trendanpassung mit eingeschlossen war, würden die korrigierten Daten keinen Trend aufweisen. Das bedeutet: wie es scheint, mussten F&R (2011) den Trend in den GISSTEMP-Daten in die Regressionsanalyse einführen, nur um das Vorzeichen des solaren Einflusses zu bekommen, das sie haben wollten.

F&R (2011) hätten ähnliche Faktoren der Skalierung für die ENSO (MEI)-, PMOD- und AOD-Daten erhalten, wenn sie die GISS-Temperaturdaten nur trendbereinigt hätten.

EQUATION 3:

Detrended GISS = -86.31 + 0.0759MEI(4m lag) + 0.0632TSI.PMOD(1m lag) – 2.37AOD (7m lag)

Das umgekehrte Vorzeichen des solaren Einflusses haben alle globalen Datensätze der Temperatur gemeinsam.

Nun könnte man geneigt sein zu fragen, ob der GISS-Datensatz der globalen Temperatur der einzige Datensatz mit diesen Ergebnissen ist. Die Antwort lautet nein. Wenn der lineare Trend nicht in die linearen multiplen Regressionsanalysen eingeführt wird, steht das Vorzeichen des Solarkoeffizienten immer im Gegensatz zu dem, was F&R (2011) hätten benutzen müssen für die NCDC und HADCRUT Land- plus Wassertemperaturdaten sowie für die Temperaturdaten der unteren Troposphäre von RSS und UAH. Die Gleichungen 4 bis 7 liegen den Regressionsanalysen dieser Datensätze zugrunde. Die Verzögerungen sind die gleichen wie in Tabelle 1 oben gelistet:

EQUATION 4 (NCDC Land Plus Meeresoberflächentemperatur):

NCDC = 109.1 + 0.05495MEI(2m lag) – 0.0796TSI.PMOD(1m lag)– 3.113AOD (5m lag)

EQUATION 5 (Hadley Centre HADCRUT Global Surface Temperature Anomalies):

HadCRUT3v = 92.21 + 0.06421MEI(3m lag) – 0.0673TSI.PMOD(1m lag)– 3.293AOD (6m lag)

EQUATION 6 (RSS MSU Lower Troposphere Temperature Anomalies):

RSS33 = 61.44 + 0.1285MEI(5m lag) – 0.04489TSI.PMOD(0m lag)– 4.863AOD (5m lag)

EQUATION 7 (UAH MSU Lower Troposphere Temperature Anomalies):

UAH = 72.94 + 0.1332MEI(5m lag) – 0.05338TSI.PMOD(0m lag)– 5.139AOD (6m lag)

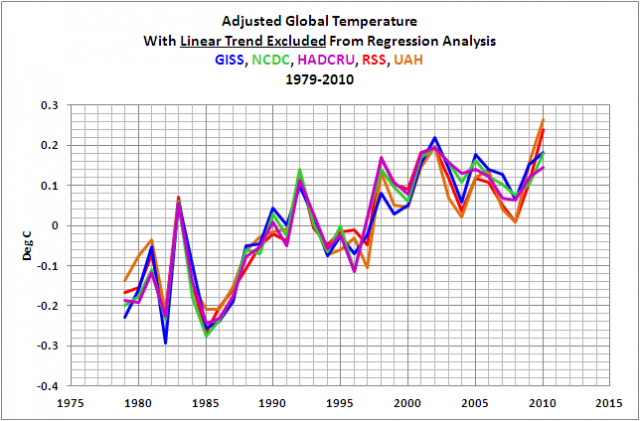

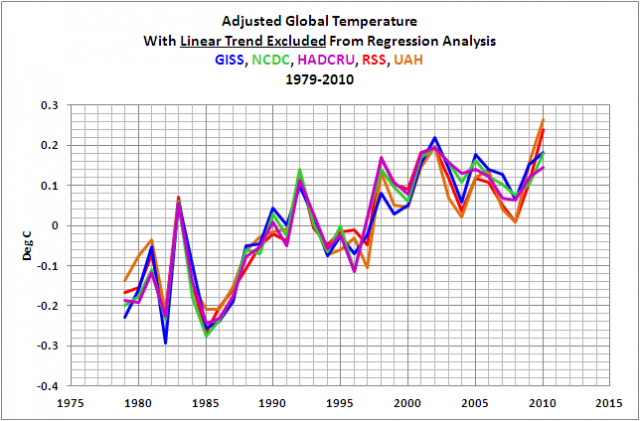

Wenn wir diese Koeffizienten verwenden, ergibt sich aus den fünf Datensätzen keineswegs der nette kontinuierliche Anstieg der globalen Temperatur, den F&R so gerne präsentiert hätten, wie Abbildung 6 zeigt. Für die drei Datensätze (GISS, HADCRUT, NCDC) war das Jahr 2002 das wärmste. Lediglich die beiden Datensätze der Temperaturanomalien in der unteren Troposphäre zeigen 2010 als das wärmste Jahr.

Abbildung 6

Und wie zu erwarten war, wenn die linearen Trends der anderen globalen Temperaturdatensätze als unabhängige Variable mit einbezogen werden, wird das Vorzeichen des Solarkoeffizienten positiv. Siehe die Gleichungen 8 bis 11.

EQUATION 8 (NCDC Land Plus Ocean Surface Temperature, with trend):

NCDC = -106.7 + 1.085Trend + 0.06832MEI(2m lag) + 0.07813TSI.PMOD(1m lag)– 1.68AOD (5m lag)

EQUATION 9 (Hadley Centre HADCRUT Global Surface Temperature Anomalies, with trend):

HadCRUT3v = -119.2 + 1.093Trend + 0.07519MEI(3m lag) + 0.08723TSI.PMOD(1m lag)– 1.858AOD (6m lag)

EQUATION 10 (RSS MSU Lower Troposphere Temperature Anomalies, with trend):

RSS33 = -135.5 + 1.05Trend + 0.1342MEI(5m lag) + 0.09923TSI.PMOD(0m lag)– 3.479AOD (5m lag)

EQUATION 11 (UAH MSU Lower Troposphere Temperature Anomalies, with trend):

UAH = -105.7 + 0.9953Trend + 0.1381MEI(5m lag) + 0.07742TSI.PMOD(0m lag)– 3.871AOD (6m lag)

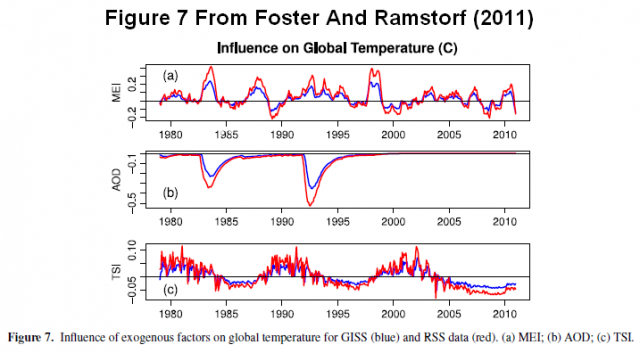

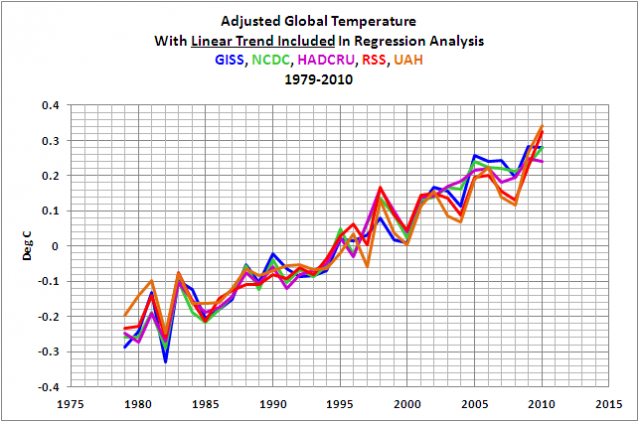

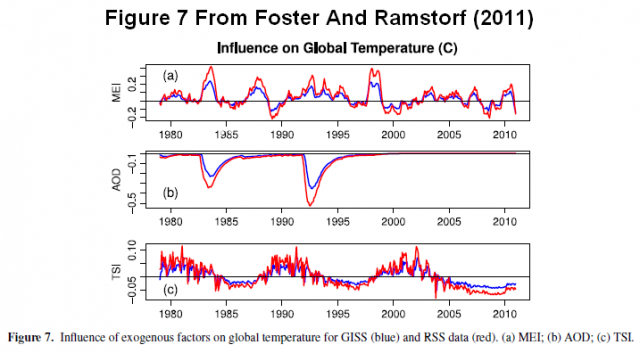

Schließt man die linearen Trends in die multiplen Regressionsanalysen mit ein, ergeben die Koeffizienten aus den obigen Gleichungen die Anpassungen, die F&R (2011) präsentiert haben, Abbildung 7. Ich habe ihre Abbildung 5 als Abbildung 8 als Referenz hier mitgezeigt.

Abbildung 7

HHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHHH

Abbildung 8

Die Annahme über den linearen Trend

Ich bin sicher, dass irgendeiner versuchen wird zu argumentieren, dass die Mitberücksichtigung des Trends in den Regressionsanalysen notwendig ist, da die auf Computermodellen basierenden Studien gezeigt haben, dass der Anstieg der globalen Temperatur in der Periode 1979 bis 2010 durch anthropogene Antriebe verursacht worden ist. Aber natürlich setzt diese Argumentation voraus, dass man die Klimamodelle verwenden kann, den Grund für einen Anstieg der globalen Temperatur während jeder beliebigen Periode zu bestimmen. Wir haben vor Kurzem gezeigt und diskutiert, dass die vom IPCC in ihrem 4. Zustandsbericht verwendeten Klimamodelle die globalen Temperaturen in keiner Periode des 20. Jahrhunderts darstellen konnten. Siehe hierzu den zusammenfassenden Beitrag hier. Das zweite Problem mit ihrer Annahme besteht darin, dass die globalen Ozeane, die etwa 70% der Erdoberfläche überdecken, während der Satellitenära keine Anzeichen einer anthropogenen globalen Erwärmung zeigen. Und das bringt uns zu…

ENSO ist kein exogener Faktor

F&R (2011) haben versucht, ENSO als einen exogenen Faktor von den Instrumentenaufzeichnungen abzuziehen. Aber ENSO ist kein exogener Faktor. ENSO ist ein gekoppelter Ozean-Atmosphäre-Prozess, der periodisch während eines El Niño Wärme in die Atmosphäre bringt. Der El Niño verursacht Änderungen in der atmosphärischen Zirkulation, was zu variierenden Temperaturen außerhalb des östlichen tropischen Pazifiks führt, teils Erwärmung, teils Abkühlung, aber insgesamt überkompensieren die warmen Gebiete die kühlen, und die globale Temperatur steigt als Reaktion auf einen El Niño. Die Verteilung von Erwärmung und Abkühlung während eines La Niña sind denen eines El Niño ähnlich, aber die Vorzeichen sind umgekehrt. Und das ist wirklich alles, worauf Studien wie die von F&R (2011) die Hoffnung begründen können, dass sich die Berücksichtigung von ENSO in den Regressionsanalysen auszahlt. Aber ENSO bedeutet noch viel mehr.

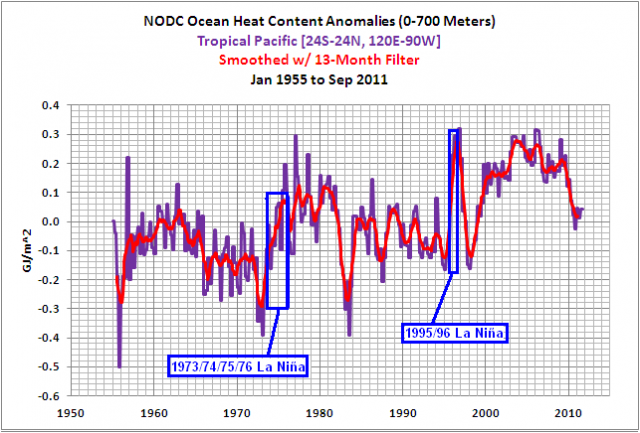

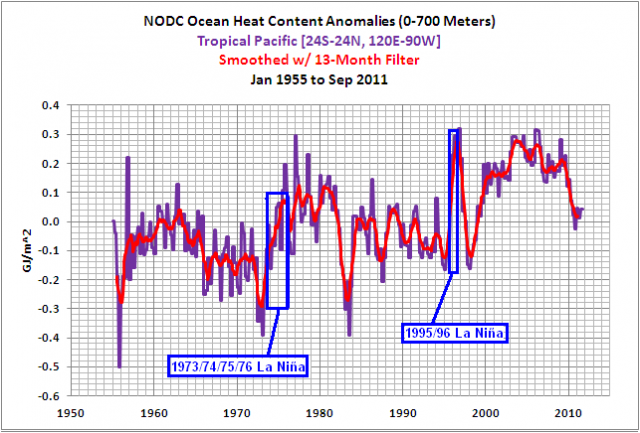

ENSO ist auch ein Prozess, der das vom El Niño selbst übrig gelassene Warmwasser umverteilt und die Verteilung des El-Niño-Warmwassers außerhalb des östlichen tropischen Pazifik verstärkt. Bei dieser Umverteilung wird warmes Wasser polwärts transportiert sowie in die angrenzenden Ozeanbecken während eines einem El Niño folgenden La Niña. La Niña-Ereignisse erwärmen auch einen Teil des Warmwassers verursacht durch El Niño. Manchmal „überladen“ La Niña-Ereignisse den tropischen Pazifik insofern, als sie mehr tropische Ozeanwärme des Pazifiks erzeugen als vorher durch El Niño entstanden war. Das war so während der La Niña-Ereignisse 1973/74/75/76 und 1995/96. Siehe Abbildung 9. Das La Niña-Ereignis von 1973/74/75/76 stellte den Initial-“Treibstoff” für den Super El Niño von 1982/83 und den mehrjährigen El Niño von 1986/87/88. Und der „El Niño des Jahrhunderts” 1997/98 wurde durch La Niña von 1995/96 angeregt. Der Prozess ENSO kann durch lineare Regression nicht in einem Index berücksichtigt werden. Dies wurde in der Einführung zu dem Beitrag ENSO Indices Do Not Represent The Process Of ENSO Or Its Impact On Global Temperature illustriert und diskutiert.

Abbildung 9

F&R (2011) bezogen sich auf Trenberth et al. (2002) Evolution of El Nino–Southern Oscillation and global atmospheric surface temperatures” als eine ihrer Referenzen zu ENSO. Aber Trenberth et al. (2002) erwähnen das folgende Dementi im zweiten Absatz ihrer Schlussfolgerungen (ihr Absatz 52, Fettdruck von mir):

Das in dieser Studie benutzte wesentliche Tool ist die Korrelation und Regressionsanalyse, die durch kleinste Quadrate-Anpassungen [?] dazu tendiert, größere Ereignisse zu betonen. Dies erscheint angebracht, weil in diesen Ereignissen das Signal ganz klar größer ist als das Rauschen. Mehr noch, diese Methode wichtet jedes Ereignis angemessen (anders als in vielen Komposit-Analysen). Obwohl es möglich ist, die Regression dazu zu verwenden, den linearen Anteil des globalen Temperatursignals in Zusammenhang mit ENSO zu eliminieren, weichen die regional zum globalen Mittel beitragenden Prozesse erheblich voneinander ab, und die lineare Annäherung verlässt wahrscheinlich ein ENSO Überbleibsel.

Die ENSO-„Reste” liefern einen signifikanten Beitrag zum Anstieg der globalen Wassertemperaturwährend der Satellitenära, wie wir noch sehen werden. Haben F&R (2011) diese Reste in ihren Analysen berücksichtigt? Nein. Sie haben angenommen, dass der Anstieg durch anthropogene Antriebe erfolgt ist, und sie vermuteten, dass ein linearer Trend dies repräsentiert.

Eine jüngere Studie ist von F&R (2011) übersehen worden. Compo und Sardesmukhs (2010) Beitrag “Removing ENSO-Related Variations from the Climate Record” scheint ein Schritt in die richtige Richtung zu sein. Sie schreiben (Fettdruck von mir):

Eine wichtige Frage bei der Abschätzung des Klimas im 20. Jahrhundert lautet, in welchem Ausmaß durch ENSO verursachte Variationen zum beobachteten Trend beigetragen haben. Diese Beiträge zu isolieren ist aus vielerlei Gründen eine Herausforderung, einschließlich Mehrdeutigkeiten, wie ENSO definiert wird. Im Besonderen kann die Definition von ENSO mit einem einzigen Index und die mit diesem ENSO in Zusammenhang stehenden Variationen als Regression über diesen Index, wie es in vielen früheren Studien getan worden ist, zu falschen Schlussfolgerungen führen. Diese Studie sagt, dass man ENSO am besten untersuchen kann, wenn man es nicht als Zahl, sondern als einen sich entwickelnden dynamischen Prozess für dieses Ziel betrachtet.

Und wie Compo und Sardeshmukh vermutet haben, kamen F&R (2011) zu den falschen Schlussfolgerungen.

Beachte: Compo und Sardeshmukh lagen bei einem sehr wichtigen Aspekt von ENSO daneben. Sie haben die Signifikanz der riesigen Menge warmen Wassers übersehen, die von den El Niño-Ereignissen übrig gelassen worden sind, und sie haben nicht den Beitrag dieses Vorgangs zum Anstieg der globalen Wassertemperatur-Anomalie seit etwa 1976 gesehen.

Wir wollen auch nicht die vielgepriesene Studie von Thompson et al. (2008) vergessen. Diese Studie von Thompson et al. (2008) für den neuen und verbesserten HADSST3-Datensatz der globalen Wassertemperatur-Anomalie vom Hadley Centre. Bei Thompson et al. (2008) wurde wie bei F&R (2011) gemogelt, weil sie versuchen, das ENSO-Signal aus den Aufzeichnungen globalen Temperaturaufzeichnung zu entfernen und dann behaupten, dass der restliche Temperaturanstieg durch anthropogene Antriebe verursacht wird. In ihrer Einführung schreiben Thompson et al. (2008) (Fettdruck von mir):

In dieser Studie werten wir eine Reihe neuer Methoden aus, um aus den ungeglätteten Datenreihen der globalen Land- und Wassertemperaturen die Varianz in Verbindung mit ENSO zu identifizieren und herauszufiltern, ebenso die dynamisch induzierte atmosphärische Variabilität und Vulkanausbrüche. Die Auswirkungen von ENSO und von Vulkanausbrüchen auf die globale mittlere Temperatur werden mit Hilfe eines einfachen thermodynamischen Modells der Reaktion der Durchmischungsschicht Atmosphäre – Ozean auf eine anomale Erwärmung geschätzt. Im Falle eines ENSO wird vermutet, dass die Erwärmung proportional zu den Anomalien der Wassertemperatur im östlichen Pazifik ist…“

Das ist eine monumentale Hypothese, und es ist die gleiche bewusst irreführende Hypothese von F&R (2011).

Aber es war diese spezielle Sprache bei Thompson et al. (2008), die mich dazu veranlasst hat, die Anomalien der Wassertemperatur in die zwei Unter-Datensätze aufzuteilen. Einer zeigt die Anomalie im Ostpazifik von Pol zu Pol (90S – 90N, 180 – 80W) und der andere den Rest der Welt (Atlantik – Indischer Ozean – Westpazifik) von Pol zu Pol (90S – 90N, 80 W-180). Und rein zufällig habe ich den Datensatz der Wassertemperatur benutzt (Reynolds OI.v2), der auch für den Land-Ozean-Index von GISS benutzt wird, welcher Taminos bevorzugter Datensatz der Temperaturanomalien ist. Ich habe die Wassertemperaturen der beiden Datensätze zum ersten Mal am 3. März 2011 präsentiert, und zwar hier. (Für Interessierte gibt es ungefähr ein Dutzend zusätzliche Beiträge, in denen ENSO und die vieljährigen Folgewirkungen spezifischer ENSO-Ereignisse behandelt werden. Sie sind am Ende dieses Beitrags verlinkt.)

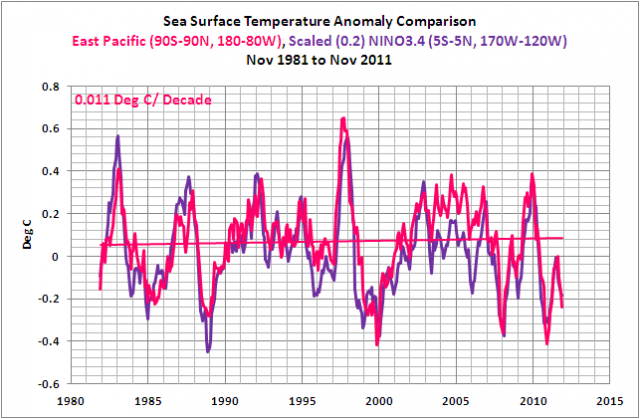

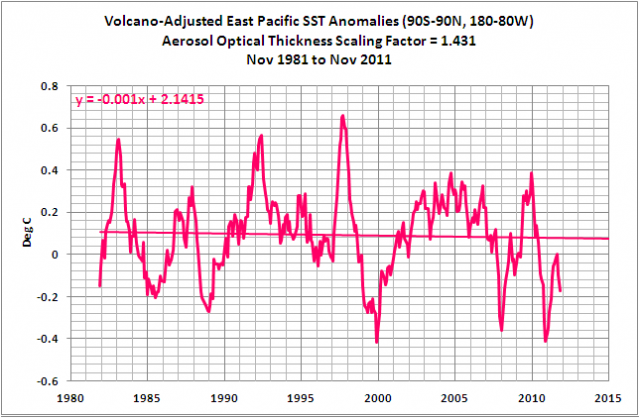

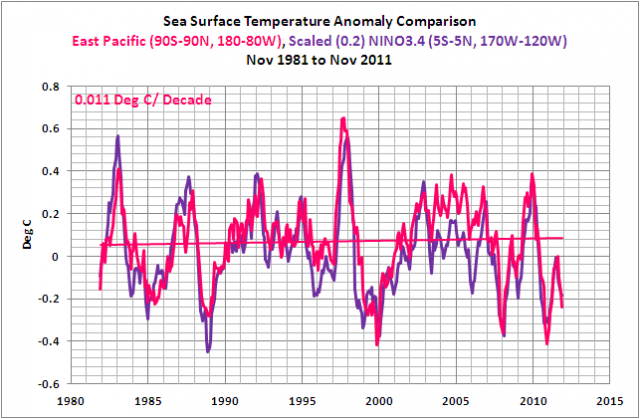

Die Anomalien der Wassertemperatur im Ostpazifik von Pol zu Pol, Abbildung 10, werden beherrscht von den Variationen im tropischen Pazifik, hervorgerufen durch ENSO, und als Folge imitieren die Variationen der Wassertemperatur im Ostpazifik ENSO, repräsentiert durch die skalierten NINO3.4-Anomalien der Wassertemperatur. Der Trend der Wassertemperatur im Ostpazifik ist relativ flach und beträgt 0,011°C pro Dekade.

Abbildung 10

Der Grund für diesen flachen Trend: Warmes Wasser an und unter der Oberfläche im Wärmepool des westlichen Pazifiks wird während eines El Niño ostwärts transportiert und breitet sich an der Oberfläche des östlichen tropischen Pazifiks aus, was dort zu einem Anstieg der Wassertemperatur führt. Und während der den El Niño folgenden La Niñas wird das übrig gebliebene Warmwasser in den westlichen tropischen Pazifik zurück transportiert. Wegen der gesteigerten Stärke des Passatwinde während eines La Niña kommt es zu einem verstärkten Aufquellen kälteren Tiefenwassers im östlichen äquatorialen Pazifik, so dass die Wassertemperatur dort sinkt. Mit anderen Worten, der Ostpazifik ist nichts weiter als ein Sammelpunkt für das warme Wasser eines El Niño-Ereignisses. Warmes Wasser schwappt in diesem Datensatz aus dem westlichen tropischen Pazifik und setzt Wärme frei, bevor das warme Wasser wieder zurück schwappt.

Aber das warme Wasser unter der Oberfläche des Wärmepools im Westpazifik während eines El Niño beeinflussen nicht nur die Wassertemperatur in allen globalen Ozeanen, und man kann sie nicht mit einem ENSO-Index darstellen. Das übrige Warmwasser wird während eines auf einen El Niño folgenden La Niña in den Westpazifik zurück geführt, wobei viel davon an der Oberfläche verbleibt. Die Wassertemperatur im westlichen Pazifik steigt daher. Auf einer Breite von etwa 10N transportiert auch eine sich langsam verlagernde Rossby-Welle übriggebliebenes Warmwasser vom östlichen tropischen Pazifik zurück zum westlichen Pazifik während eines La Niña. Meeresströmungen transportieren das warme Wasser polwärts in das erweiterte Strömungssystem Kuroshio – Oyashiro (KOE) östlich von Japan und zur südpazifischen Konvergenzzone (SPCZ) östlich von Australien, und der Indonesische Durchfluss [Indonesian Throughflow] (eine Meeresströmung) transportiert warmes Wasser in den tropischen Indischen Ozean. Und wie oben erwähnt quillt verstärkt kaltes Tiefenwasser während eines La Niña aufgrund der stärkeren Passatwinde im östlichen tropischen Pazifik auf, so dass die Wassertemperatur dort zurückgeht. Aber dieses Wasser, kälter als normal, wird während La Niña rasch erwärmt, da es durch die verstärkten Passatwinde westwärts strömt. Und der Grund, warum sich das Wasser bei dieser Westverlagerung so rasch erwärmt, ist Folgender: die verstärkten Passatwinde reduzieren die Wolkenbildung, so dass die kurzwellige Sonnenstrahlung (das sichtbare Sonnenlicht) das Wasser bis zu einer gewissen Tiefe erwärmt. Dieses zusätzliche Warmwasser hilft, die Wassertemperaturen im Westpazifik und dem Ostindischen Ozean während La Niña auf einem höheren Niveau zu halten, und es füttert auch den westpazifischen Wärmepool bis zum nächsten El Niño. Siehe nochmals Abbildung 9, aber man beachte dabei, dass diese Abbildung den ozeanischen Wärmegehalt für den gesamten tropischen Pazifik darstellt und nicht nur für den pazifischen Wärmepool.

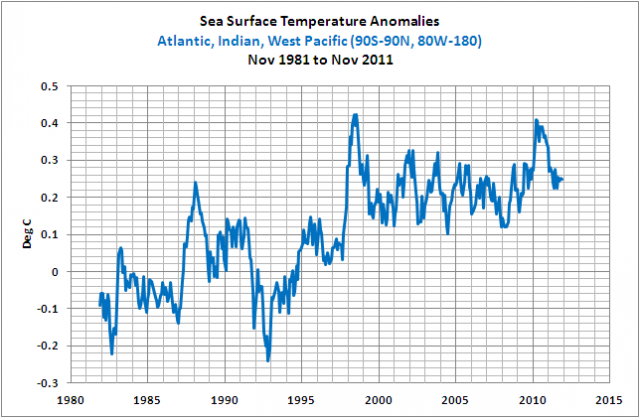

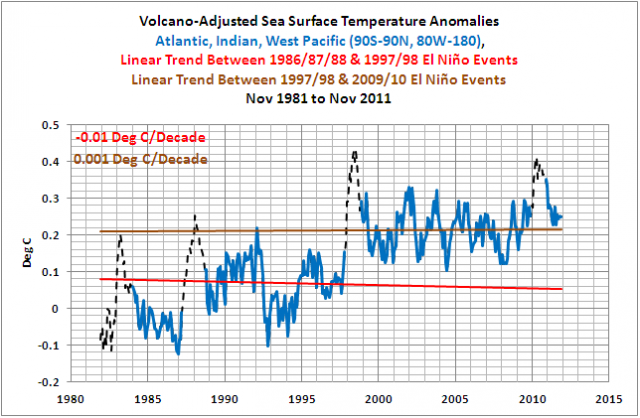

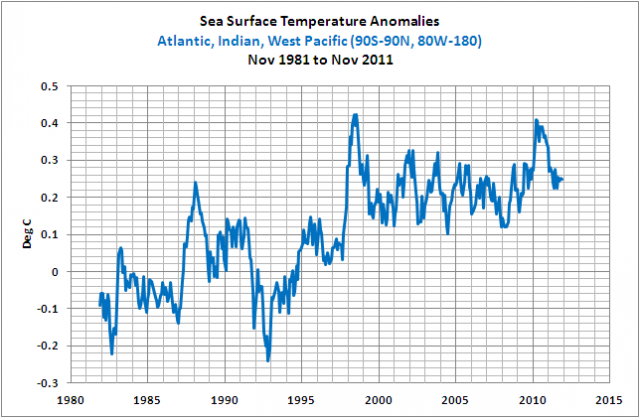

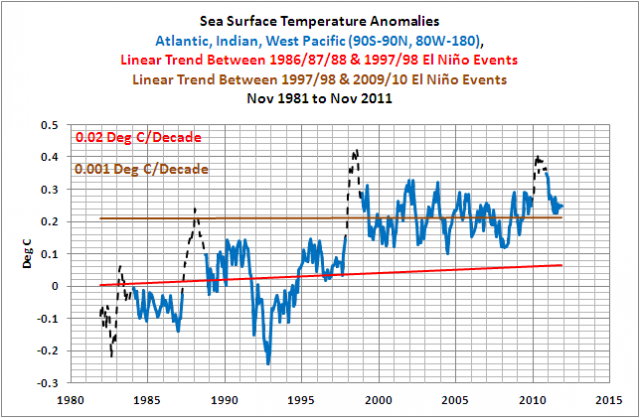

Und was passiert, wenn ein starkes El Niño-Ereignis von einem La Niña gefolgt wird? Die Anomalien der Wassertemperatur für den Atlantik, den Indischen und den Westpazifischen Ozean (alle Ozeane außerhalb des Ostpazifik) nehmen als erstes zu, und zwar als Reaktion auf den El Niño; die El Niño-Ereignisse von 1986/87/88 und 1997/98. Danach werden die Wassertemperaturen dieser Ozeane durch La Niña auf einem erhöhten Niveau gehalten; die La Niña-Ereignisse 1988/89 und 1998/99/00/01. Die Folgen sind die offensichtlich steigenden Anomalien der Wassertemperatur in diesen Ozeanen von Pol zu Pol (90S-90N, 80W-180), wie in Abbildung 11 gezeigt.

Abbildung 11

Der Abfall und die Erholung mit Beginn im Jahre 1991 wurden verursacht durch die vulkanischen Aerosole der Explosion des Mount Pinatubo. Und der Grund dafür, warum die Wassertemperatur-Anomalien in den anderen Ozeanen so gering auf den Super-El Niño von 1982/83 reagieren, liegt darin, dass der Ausbruch des El Chichon im Jahre 1982 der Erwärmung entgegen wirkte.

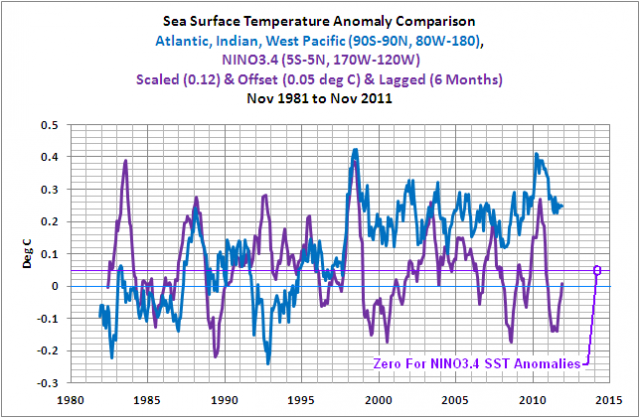

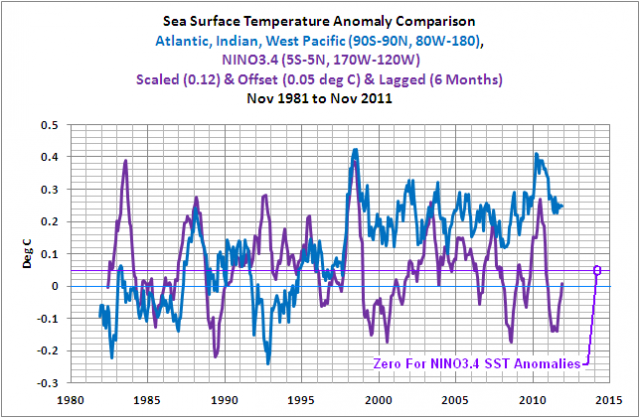

Um den Lesern zu versichern, dass der Anstieg der Wassertemperaturen in den Ozeanen außerhalb des Pazifik mit den El Niño-Ereignissen von 1986/87/88 und 1997/98 zusammenfällt, habe ich einen ENSO-Index, NINO3.4 Wassertemperatur-Anomalien in Abbildung 12 eingezeichnet. Die NINO3.4 Wassertemperatur-Anomalien wurden (multipliziert mit dem Faktor 0,12) skaliert, um einen besseren augenscheinlichen Vergleich zu ermöglichen. Außerdem habe ich ihn um 6 Monate verschoben, um der Zeitverzögerung zwischen den Variationen in NINO3.4 und der Reaktion der Daten der übrigen Ozeane Rechnung zu tragen.

Abbildung 12

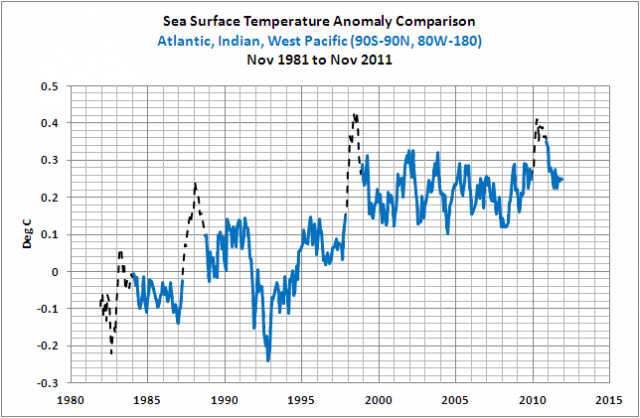

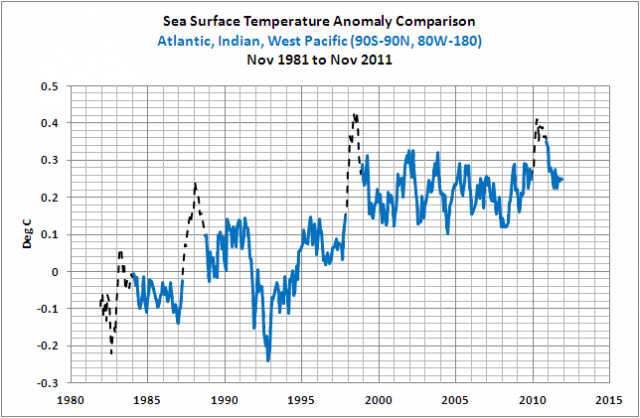

Aber der ENSO-Index rauscht sichtlich und lenkt von der Zunahme ab. Darum habe ich in Abbildung 13 die Daten zwischen den signifikanten El Niño-Ereignissen isoliert. Für diesen Zweck habe ich den Oceanic Nino Index (ONI) der NOAA verwendet, um die offiziellen Monate dieser El Niño-Ereignisse zu bestimmen. Es gibt eine 6-monatige Zeitverschiebung zwischen den NINO3.4-Anomalien und der Reaktion der Wassertemperatur-Anomalien in den restlichen Ozeanen während der Entwicklungsphase des El Niño von 1997/98. Also wurden die ONI-Daten um sechs Monate verschoben, und die Daten der Wassertemperatur der übrigen Ozeane, die auf die El Niño-Ereignisse von 1982/83, 1986/87/88 und 2009/10 reagiert haben, wurden ausgeschlossen – übrig gelassen als schwarze gestrichelte Linien. Alle anderen Monate mit Daten verbleiben.

Abbildung 13

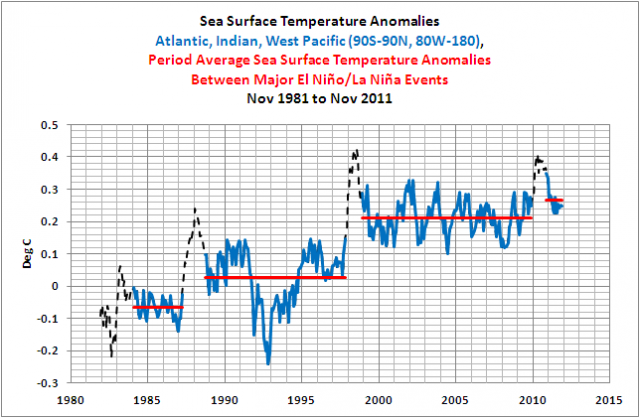

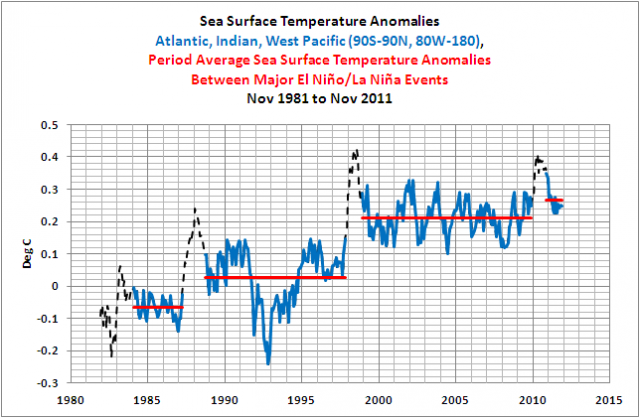

Und um den Anstieg weiter zu beleuchten, wurden in Abbildung 14 die mittleren Anomalien der Wassertemperatur zwischen großen El Niño-Ereignissen hinzugefügt.

Abbildung 14

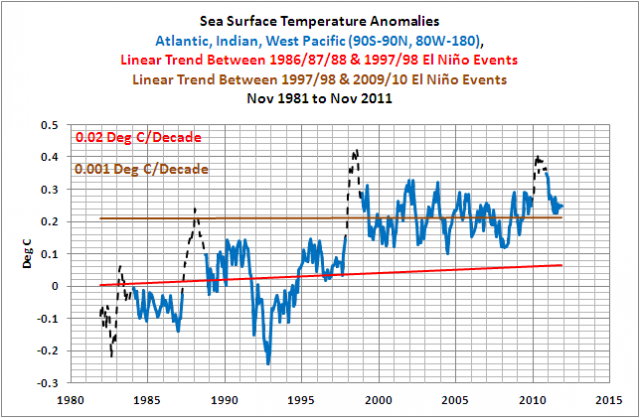

Basierend auf früheren Beiträgen, in denen ich den gleichen Datensatz präsentiert habe, schlugen einige Kommentatoren vor, dass die Zeitspannen der Mitteltemperaturen irreführend sind, und verlangen, dass ich die linearen Trends illustriere. Abbildung 15 zeigt, wie flach die Trends zwischen den El Niño-Ereignissen von 1986/87/88 und 1997/98 sowie zwischen denen von 1997/98 und 2009/10 waren.

Abbildung 15

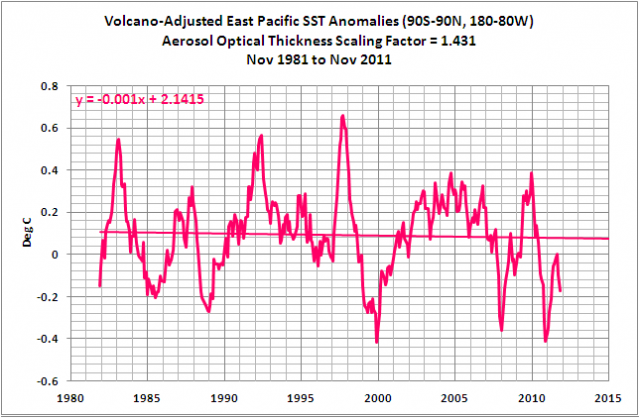

Zurück zu den Daten aus dem Ostpazifik: Falls man die Anomalien der Wassertemperatur im Ostpazifik anpasst, um den Effekte vulkanischer Aerosole Rechnung zu tragen, ist der lineare Trend leicht negativ (Abbildung 16). Mit anderen Worten, für etwa 33% der Fläche der globalen Ozeane sind die Anomalien der Wassertemperatur seit 30 Jahren nicht gestiegen.

Abbildung 16

Bemerkung: Die Methode zur Anpassung bzgl. von Vulkanausbrüchen wird hier beschrieben, und zwar im Absatz unter der Überschrift ACCOUNTING FOR THE IMPACTS OF VOLCANIC ERUPTIONS.

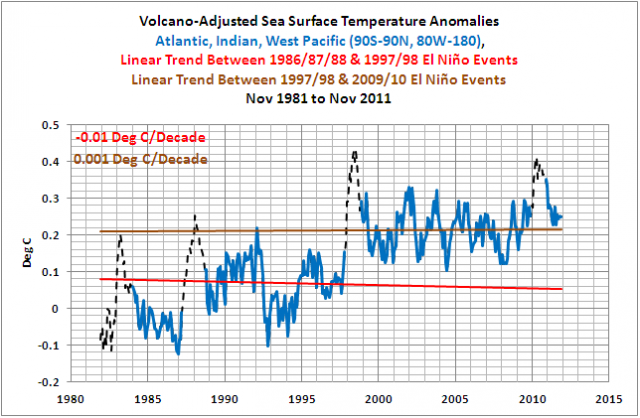

Und wenn wir die Anomalien der Wassertemperatur in den übrigen Ozeanen bzgl. vulkanischer Eruptionen anpassen (Abbildung 17), reduzieren wir die Effekte des Abfalls und der Erholung durch die Eruption des Mount Pinatubo 1991. Und der Trend in diesen Ozeanen zwischen den El Niño-Ereignissen von 1986/87/88 und 1997/98 ist leicht fallend verglichen mit den nicht angepassten Daten (Abbildung 15), was den Trend noch flacher und leicht negativ macht.

Abbildung 17

Zusammenfassend: ENSO ist ein gekoppelter Ozean-Atmosphäre-Prozess, und seine Auswirkungen auf die globalen Temperaturen können nicht mit einem ENSO-Index dargestellt werden, wie es F&R (2011) versucht haben – und andere vor ihnen. Wir können einfach die Studie von F&R (2011) zu der Liste zahlreicher Studien hinzufügen, die den gleichen Fehler machen. Beispiele:

Lean and Rind (2009) How Will Earth’s Surface Temperature Change in Future Decades?

Und:

Lean and Rind (2008) How Natural and Anthropogenic Influences Alter Global and Regional Surface Temperatures: 1889 to 2006

Und:

Santer et al (2001), Accounting for the effects of volcanoes and ENSO in comparisons of modeled and observed temperature trends

Und:

Thompson et al (2008), Identifying signatures of natural climate variability in time series of global-mean surface temperature: Methodology and Insights

Und:

Trenberth et al (2002) Evolution of El Nino–Southern Oscillation and global atmospheric surface temperatures

Und:

Wigley, T. M. L. (2000), ENSO, volcanoes, and record-breaking temperatures

Außerdem haben F&R (2011) vermutet, dass das Signal der globalen Erwärmung linear ist und dass es durch anthropogene Antriebe verursacht wird, aber diese Vermutungen werden durch die Messungen der Wassertemperatur in der Satellitenära nicht gestützt, wie oben gezeigt wurde. Das Signal der globalen Erwärmung ist nicht linear, und es wurde gezeigt, dass die El Niño-Ereignisse von 1986/87/88 und 1997/98 der Grund für den Anstieg der Wassertemperatur war und nicht anthropogene Treibhausgase.

Die atlantische multidekadische Oszillation

Wenn man Taminos Datei allfit2.xls heruntergeladen hat (hier – und es danach zu einem .zip.file gemacht hat), wird man bemerken, dass die erste Spalte AA als „AMO“ bezeichnet ist. Und ja, das sind die Daten der multidekadischen Oszillation von der AMO website des NOAA Earth System Research Laboratory (ESRL).

Man beachte: Die jüngsten AMO-Daten und die in Taminos Datei aufgelisteten Daten sind etwas unterschiedlich. Der Grund: Die ESRL AMO-Daten entwickeln sich ständig. Jeden Monat nachdem die neuen Daten der Wassertemperatur im Nordatlantik (0 – 70N, 80W – 0) hinzugefügt worden sind, werden die Daten mit den neuen Daten trendbereinigt.

Man kann nur darüber spekulieren, warum Tamino die AMO-Daten mit aufgeführt hat – und warum die Daten auf dem Arbeitsblatt bis zum Jahr 1950 zurückreichen, wenn es in der Studie lediglich um den Zeitraum 1979 bis 2010 geht. Und man kann sich auch fragen, warum Tamino die ESRL AMO-Daten mitführt, welche auf den Kaplan-Anomaliedaten der Wassertemperatur im Nordatlantik basieren, wenn diese Kaplan-Daten in keinem anderen Datensatz genutzt werden (GISS, HADCRUT oder NCDC). Die Datensätze sind nicht die gleichen. Ich habe Tamino und seine Jünger schon auf diesen Fehler hingewiesen, und zwar in dem Beitrag Comments On Tamino’s AMO Post.

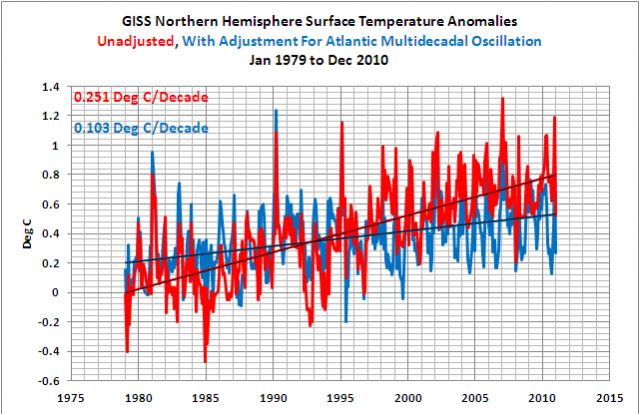

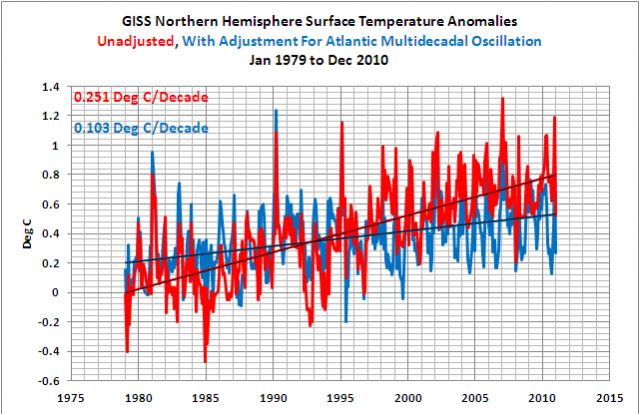

Aber die Neugier beispielsweise kann befriedigt werden. Nehmen wir an, man fragt sich, wie die Ergebnisse aussehen würden, wenn man auf den Einfluss der AMO auf die Temperaturen der Nordhemisphäre zählt, unter Verwendung einer linearen Regressionsanalyse mit den ESRL AMO-Daten als unabhängige Variable und den GISS-Daten der nordhemisphärischen Temperatur als die abhängige Variable. Wir begrenzen das Beispiel auf die von F&R (2011) betrachtete Zeitspanne von 1979 bis 2010. Siehe Abbildung 18. Die AMO-angepasste nordhemisphärische Temperatur besitzt einen linearen Trend, der lediglich 41% der nicht angepassten Daten der Nordhemisphäre ausmacht.

Hmm. Das würde bedeuten, dass die AMO für 59% des Temperaturanstiegs in der Nordhemisphäre verantwortlich war, wenn man die Regressionsanalyse zugrunde legt.

Abbildung 18

Und das liegt auf einer Linie mit der Generalisierung durch Taminos Erfüllungsgehilfen auf RealClimate und dort auf ihrer Atlantic Multidecadal Oscillation (“AMO”) – Website. Dort schreiben sie zur AMO:

Eine multidekadische Verteilung (50 bis 80 Jahre) der nordatlantischen Ozean-Atmosphäre-Variabilität, dessen Existenz durch Verweis auf die statistischen Analysen von beobachteten und Proxy-Daten begründet wird, und den Simulationen des gekoppelten Atmosphere-Ocean General Circulation Model (“AOGCM”). Von dieser Verteilung glaubt man, dass man mit ihr die beobachtete Erwärmung im frühen 20. Jahrhundert (zwanziger und dreißiger Jahre) erklären kann und auch einen Anteil, aber nicht der gesamten, der Erwärmung in hohen Breiten im ausgehenden 20. Jahrhundert. Der Term wurde in einer Zusammenfassung von Kerr (2000) eingeführt, und zwar aufgrund einer Studie von Delworth und Mann (2000).

Tamino fährt fort, sich darüber zu beklagen, dass man keine Anpassungen wegen der AMO vornehmen kann, weil sie eine Komponente der globalen Erwärmung enthält. Zum Beispiel schreibt Tamino in einer Antwort auf einen Kommentar von Colin Aldridge am 22. Dezember 2011 (hier):

Wenn es um die AMO geht, IST es Temperatur, anders als ENSO (oder PDO in dieser Sache). Klar und einfach, nicht mehr und nicht weniger. Eine Temperaturänderung einer Temperaturänderung zuzuordnen scheint irgendwie dumm zu sein.

Hmm. Ich glaube, dass Tamino nicht den Punkt getroffen hat, dass nämlich die AMO eine zusätzliche Variabilität einbringt und dass sie über den gesamten Datenterm trendbereinigt wird.

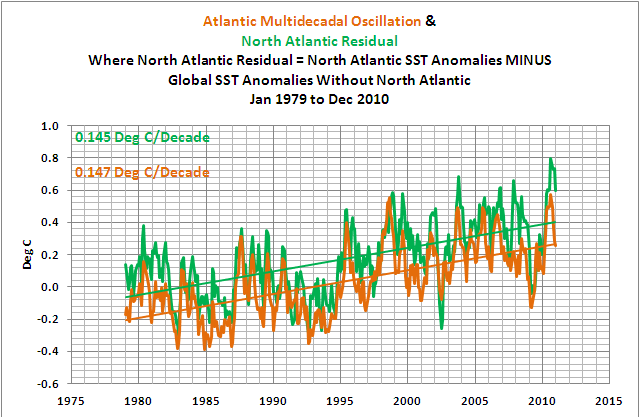

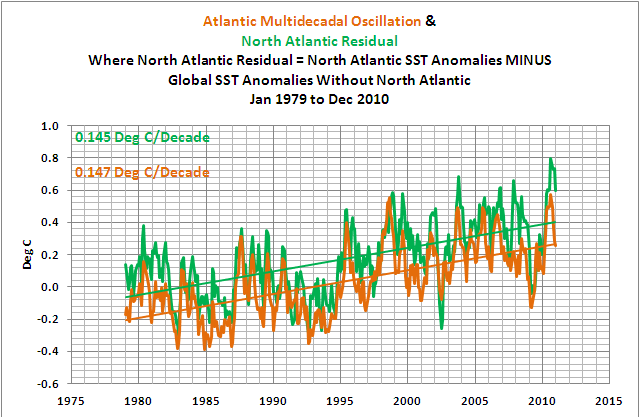

Um hier weiterzukommen, habe ich Tamino erklärt und illustriert, dass wir das „Erwärmungssignal“ in der globalen Wassertemperatur mit Ausnahme des Nordatlantik von den Anomalien der Wassertemperatur im Nordatlantik abziehen können. Dann bleibt nur die zusätzliche Variabilität der Wassertemperaturen im Nordatlantik verursacht durch die AMO übrig. Und nur so sollte die AMO dargestellt werden. Den Unterschied nennen wir die Nordatlantische Restgröße. Diese Restgröße hat in etwa den gleichen Trend wie die AMO im F&R (2011)-Zeitraum von 1979 bis 2010, wie Abbildung 19 zeigt:

Abbildung 19

Zur Beachtung: Die Daten der nordatlantischen Restgröße in Abbildung 16 basieren auf einer Kombination der HADISST-Daten von 1979 bis November 1981 und den ReynoldsOI.v2-Daten von Dezember 1981 bis zur Gegenwart, und zwar in Übereinstimmung mit GISS, dargestellt auf der Website der GISS Surface Temperature Analysis. Um die Wassertemperatur des Nordatlantik aus den globalen Daten der Wassertemperatur zu entfernen wurde festgelegt, dass die Fläche des Nordatlantik zwischen 0 – 70N und 80W – 0 11% der Fläche der globalen Ozeane ausmacht.

Und als einen zusätzlichen Check des Vorzeichens der solaren Korrektur habe ich multiple lineare Regressionsanalysen der nordhemisphärischen Temperaturen von GISS als der abhängigen Variable und die AMO-Daten als eine unabhängige Variable in einem Augenblick in die nordatlantische Restgröße in einer Sekunde durchgeführt. Die Analysen umfassten auch ENSO (MEI), Solar (PMOD) und vulkanische Aerosole (AOD.NH) als unabhängige Variable mit der gleichen Zeitverzögerung wie in den globalen Daten. In beiden Fällen stand das Vorzeichen der solaren Korrektur im Gegensatz zu dem, was F&R (2011) gesucht haben, wie die Gleichungen 12 und 13 zeigen:

EQUATION 12:

GISS.NH = 62.25 + 0.001696MEI (4m lag) – 0.04528TSI.PMOD(1m lag)– 1.683AOD.NH (7m lag) + 0.866AMO (0m lag)

EQUATION 13:

GISS.NH = 72.12 + 0.04751MEI (4m lag) – 0.05258TSI.PMOD(1m lag)– 2.413AOD.NH (7m lag) + 0.72N. Atl. Residual (0m lag)

Abschließende Bemerkung zur AMO: Für eine erweiterte Diskussion darüber, wie der Nordatlantik die Wassertemperaturen in der Zeitspanne zwischen den Aufwärtssprüngen der El Niño-Ereignisse von 1986/87/88 und 1997/98 schaue man hier: Supplement To “ENSO Indices Do Not Represent The Process Of ENSO Or Its Impact On Global Temperature”

Schlussbemerkungen

Ich fand das Hinzuziehen eines linearen Trends in den von F&R (2011) durchgeführten Regressionsanalysen sehr interessant. Es scheint, als seien diese linearen Trends einfach deshalb hinzugefügt worden, um das Vorzeichen der solaren Korrektur zu dem zu machen, was die Autoren für ihre Anpassungen gerne sehen wollten. Man könnte denken, wenn die grundlegenden Ergebnisse der Studie davon abhängig wären, ob ein linearer Trend in die multiplen Regressionsanalysen eingeführt wird, wäre es in der Studie behandelt worden. Und noch einmal, wenn Sie die Fähigkeit haben und mit den Ähnlichkeiten zwischen meinen Ergebnissen und denen von F&R (2011) nicht zufrieden sein sollten (Abbildungen 7 und 8), bestätigen Sie bitte die Ergebnisse der oben präsentierten Ergebnisse der multiplen Regressionsanalysen mit und ohne den linearen Trend.

Dieser Beitrag hat auch den Fehler in ihren Hypothesen deutlich gemacht und diskutiert, dass nämlich die Regressionsanalyse verwendet werden kann, um die Auswirkungen von ENSO auf die globale Temperatur zu entfernen. ENSO ist ein Prozess, der nicht vollständig durch ENSO-Indizes beschrieben werden kann. Mit anderen Worten, die ENSO-Indizes repräsentieren nur einen kleinen Teil der Auswirkungen von ENSO auf die globale Temperatur. Der Versuch, den ENSO-Index so zu verwenden, wie es F&R (2011) getan haben, gleicht dem Versuch, ein Baseballspiel allein von der Ausgangsposition des Spielfeldes aus zu spielen.

Es wurde gezeigt, dass die Hypothese von F&R (2011), dass ein linearer Trend ein ungefähres Signal „globaler Erwärmung“ bereitstellt, hinsichtlich der Wassertemperatur irrig ist. Spaltet man die Daten in zwei logische Unterdatensätze auf, nämlich Ostpazifik einerseits und die übrigen Ozeane andererseits, zeigen die satellitengestützten Werte der Wassertemperatur keinen Beweis für ein Signal einer anthropogenen globalen Erwärmung. Sie zeigen lediglich Sprünge nach oben im Zuge starker ENSO-Ereignisse. Dies scheint jeden Versuch zu komplizieren, die Hinzunahme eines linearen Trends zur Umkehrung des Vorzeichens der solaren Anpassung zu rechtfertigen.

Und Dank an Tamino, dass der die Daten der multidekadischen atlantischen Oszillation auf seinem Arbeitsblatt vermerkt hat. Dies erlaubte es mir, die signifikante Auswirkung zu zeigen, die die AMO auf die Temperaturen der Nordhemisphäre haben kann.

ABOUT: Bob Tisdale – Climate Observations

QUELLEN (aus Zeitgründen nicht mitübersetzt)

The spreadsheet that served as the source of the data for the regression analyses was linked to Tamino’s (Grant Foster’s) post Data and Code for Foster & Rahmstorf 2011.

To save you some time, here’s a copy of the file that contains the spreadsheet from Tamino’s blog that I’ve uploaded to mine, allfit2 as of 12-21-11. Again, you’ll have to download the file and change it to a .zip file in order to open it.

The Reynolds OI.v2 Sea Surface Temperature data used in the ENSO discussion is available through the NOAA NOMADS website here.

The Aerosol Optical Thickness data used in the volcano adjustments of the Sea Surface Temperature data in Figures 13 and 14 is available from GISS the Stratospheric Aerosol Optical Thickness webpage here.

Link: http://wattsupwiththat.com/2012/01/02/tisdale-takes-on-taminos-foster-rahmstorf-2011/

Übersetzt von Chris Frey für EIKE

Nachtrag 21.1.12:

Wie u.a. ein Leser auf Science Sceptical richtig schrieb, hat Autor Bob Tisdale am 2. Januar einen fachliche Kritik zum Foster/Rahmstorf-Artikel veröffentlicht. Oben lesen Sie die übersetzte Version davon. Das Original ist hier: Tisdale takes on Tamino’s Foster & Rahmstorf 2011. Sie enthält jedoch einige Fehler.

Bob Tisdale hatte dann am 14.Januar den Folgeartikel Tisdale takes on Foster & Rahmstorf – take 2 veröffentlicht, in dessen Vorspann er die Mängel seines 1.Artikels ausführlich erläutert hatte. In diesem zweiten Artikel selbst konzentrierte er sich ganz auf ENSO und zog die Konsequenzen aus den Ungenauigkeiten seines ersten Artikels. Da unsere Übersetzungskapazitäten derzeit bis zum Anschlag ausgefüllt sind verweisen wir für die Details auf das englische Original.

Die Redaktion