Mr. Spock übernehmen Sie: Über die Bearbeitung der Daten der ARGO-Bojen

Die Behauptungen und Schlussfolgerungen der H2011-Studie beziehen sich hauptsächlich auf den Wärmegehalt der Ozeane (OHC), großenteils von den ARGO-Bojen gemessen, also dachte ich, dass ich mir diese Daten mal ansehen sollte. Die Messungen der Wassertemperatur und des Salzgehaltes mit einer großen Datenmenge geben uns viele wertvolle Informationen über den Ozean. Das H2011-Papier wendet die jüngsten Ergebnisse der Studie von K. von Schuckmann und P.-Y. Le Traon an (SLT2011).

Abbildung 1 rechts:

Schema einer Argo-Boje. Sie ist insgesamt etwa 2 m hoch. Quelle: Wikipedia

Die Argo-Bojen sind Treibbojen, die selbständig arbeiten. Jede Boje misst alle zehn Tage ein komplettes vertikales Temperaturprofil. Das Profil reicht bis in eine Tiefe von 1000 oder 2000 m. Sie sendet alle Messergebnisse via Satellit vor der nächsten Messung.

Unglücklicherweise sind die in H2011 verwendeten Argo-Daten mit einigen Problemen behaftet. Die Zeitspanne des Datensatzes ist sehr kurz. Die Änderungen sind ziemlich klein. Die Genauigkeit wird überschätzt. Schließlich und am Wichtigsten, die Untersucher benutzen die falsche Methode bei der Analyse der Daten.

Erstens ist da die Länge des Datensatzes. Die von Hansen benutzten Daten überdecken nur eine Zeitspanne von 72 Monaten. Dies begrenzt die Schlussfolgerungen, die wir aus diesen Daten ziehen können. H2011 drückt sich davor, wenn er nicht nur für diese Daten, sondern für alle Daten lediglich ein gleitendes Mittel über sechs Jahre zeigt. Ich kann es wirklich nicht leiden, wenn Rohdaten nicht gezeigt werden, sondern nur die mit der Hansen-Methode bearbeiteten Daten.

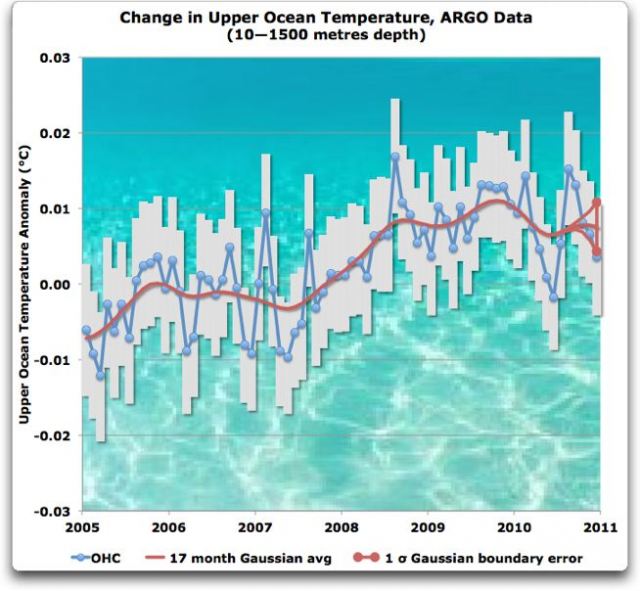

Zweitens, die Unterschiede sind ziemlich klein. Abbildung 2 zeigt eine Aufzeichnung, wie sie in SLT2011 zu finden ist. Sie zeigt die Daten als jährliche Änderungen des Wärmegehalts im oberen Ozean (OHC) in der Einheit Joule. Ich habe diese OHC-Änderungen (Joules/m²) für das Wasser, das sie vermessen, in Änderungen mit Celsius-Graden übertragen. Das gilt für eine ein Quadratmeter große Wassersäule mit einer Tiefe von 1490 Metern. Wie man erkennt, behandelt die SLT2011-Studie sehr kleine Temperaturvariationen. Dies gilt auch für die H2011-Studie.

Abbildung 2 : Temperatur des oberen Ozeans nach Schuckmann & Le Traon, 2011 (SLT2011). Graue Balken zeigen einen Sigma Fehler in den Daten. Die rote Linie steht für eine 17-Punkte-Gaussverteilung. Die vertikale rote Linie zeigt den Fehler des Gauss’schen Mittels an den Rändern des Datensatzes (95% CI). Digitalisierte Daten aus SLT2011, Abb. 5b, erhältlich als durch Kommata getrennte Textdatei hier.

Einige Dinge in diesem Datensatz sind bemerkenswert. Zunächst haben wir es hier mit winzigen Temperaturänderungen zu tun. Die Länge der grauen Balken zeigt, dass SLT2011 behauptet, dass man die Temperatur der oberen 1½ Kilometer des Ozeans mit einem Fehler von nur ±acht tausendstel eines Grades…

Nun hasse ich es, aus Unglauben zu argumentieren, und ich werde ausführlich statistische Gründe weiter unten anführen, aber, meiner Treu… ein Fehler von acht Tausendstel Grad bei den Messungen der monatlichen Mitteltemperatur in der obersten Meile Wasser von fast dem gesamten Ozean? Wirklich? Sie glauben, dass sie die Temperatur des Ozeans bis zu diesem Grad an Präzision messen können, geschweige denn Genauigkeit?

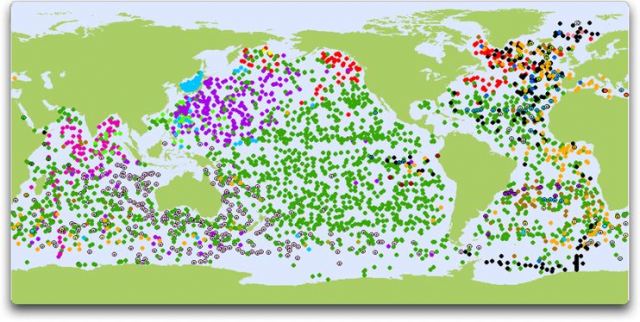

Das zu glauben fällt mir sehr schwer. Ich verstehe die Gesetze der Zahlen und das zentrale Begrenzungstheorem und wie es uns zusätzliche Hebelwirkung gibt, aber der Gedanke, dass wir die Temperatur von 400 Millionen Kubikkilometer von Ozeanwasser mit einer Genauigkeit von acht Tausendstel Grad messen können, ist… nun, nennen wir es unbegründet. Andere, die mit Temperaturmessungen in Flüssigkeiten mit weniger als ein Hundertstel an Genauigkeit Erfahrung haben, mögen sich hierzu äußern, aber für mich sieht es wie eine viel zu weit entfernte Brücke aus. Ja, es gibt etwa 2500 ARGO-Bojen dort draußen, und auf einer Karte des Ozeans sieht die Verteilung ziemlich dicht aus. Abbildung 3 zeigt die Position der Bojen im Jahr 2011.

Abbildung 3: Position der ARGO-Bojen. Quelle

Aber das ist nur eine Karte. Die Welt ist unvorstellbar groß. Im echten Ozean, bis zu einer Tiefe von eineinhalb Kilometern, das heißt ein ARGO-Thermometer für jedes der 165.000 Kubikkilometer Wasser… Ich weiß nicht, wie man sich klar machen kann, wie viel das wirklich ist. Versuchen wir es mal so: Der Obere See ist der größte Binnensee Amerikas, der selbst in der obigen Karte noch erscheint. Wie akkurat kann man die mittlere monatliche Temperatur der gesamten Wassermenge im Oberen See mit einer einzigen ARGO-Boje messen? Sicher kann man sie auf und ab tauchen oder sie rund um den See treiben lassen, sie wird drei vertikale Profile pro Monat messen. Aber selbst dann deckt jede Messung nur einen kleinen Teil des gesamten Sees ab.

Aber für ARGO sieht es noch schlimmer aus. Jede einzelne Boje, jeder Punkt in Abbildung 3 repräsentiert ein Volumen, das 13 mal so groß ist wie der Obere See … mit nur einem ARGO-Thermometer…

Oder wir betrachten es auf andere Weise. In der von SLT2011 abgedeckten Zeitspanne waren 2500 ARGO-Bojen in Betrieb. Das Gebiet des Ozeans umfasst etwa 360 Millionen Quadratkilometer. Also repräsentiert jede ARGO-Boje eine Fläche von etwa 140.000 Quadratkilometer, d. h. mit einem Quadrat von etwa 380 km auf jeder Seite. Eine ARGO-Boje für das alles! Zehn Tage für jeden Tauchzyklus, wobei die Boje tausend Meter absinkt und dort neun Tage lang verharrt. Dann steigt sie wieder auf, entweder von diesem Punkt, oder sie sinkt erst in eine Tiefe von 2000 Meter, um danach mit einer Geschwindigkeit von etwa 10 cm pro Sekunde an die Oberfläche zu steigen, wobei sie ununterbrochen Temperatur und Salzgehalt misst. Auf diese Weise erhalten wir drei vertikale Temperaturprofile von 0 bis 1000 oder 0 bis 1500 oder 0 bis 2000 Metern jeden Monat, abhängig von der Drift im Einzelnen, um ein Gebiet von 140.000 Quadratkilometern abzudecken… Tut mir leid, aber drei vertikale Temperaturprofile pro Monat, um ein Gebiet von 60.000 Quadratkilometern und einer Tiefe von 1 Kilometer abzudecken, das klingt in meinen Ohren ganz und gar nicht nach „einer Genauigkeit von acht Tausendstel Grad“.

Hier habe ich noch einen dritten Weg, um sich die Herausforderung dieser Messungen klarzumachen. Wenn man je mal in einem kleinen Boot gesessen und kein Land mehr gesehen hat – weiß man dann, wie groß der Ozean von Deck aussieht? Nehmen wir an, das Deck befinde sich 3 Meter über dem Wasser und man steht an Deck und schaut sich um. Nichts als der blanke Ozean erstreckt sich ringsum bis zum Horizont, eine riesige Menge Wasser auf allen Seiten. Wie viele Thermometermessungen würde man brauchen, um die monatliche Mitteltemperatur nur des in diesem Falle sichtbaren Ozeans bis zu einer Tiefe von eineinhalb Kilometern brauchen? Ich würde sagen… mehr als eine.

Nun führe man sich vor Augen, dass jede ARGO-Boje ein Gebiet zu überdecken hat, das 2000 mal so groß ist wie die Fläche, die man auf dem Deck des Schiffes stehend überblicken kann… und die Boje nimmt drei Tauchdurchgänge pro Monat vor… wie gut passen die Messungen, wie gut repräsentieren sie die Wirklichkeit?

Es gibt noch eine weitere Schwierigkeit. Abbildung 2 zeigt, dass sich der größte Teil der Änderung während der Zeitspanne innerhalb eines Jahres ereignete, etwa von Mitte 2007 bis Mitte 2008. Die Änderung des notwendigen Antriebs, die Temperatur von Wasser bis zu einer Tiefe von eineinhalb Kilometern zu ändern, liegt etwa bei 2 W/m² für diese Periode eines Jahres. Das „Ungleichgewicht“, um Hansens Term zu benutzen, ist sogar noch schlechter, wenn wir die Menge Energie betrachten, die nötig ist, um den oberen Ozean von Mai 2007 bis August 2008 zu erwärmen. Dies erfordert ein globales „Ungleichgewicht“ von etwa 2,7 W/m² während dieser Zeit.

Weiter! Wäre dies mein Datensatz, wäre das Erste, was ich mir ansehe, was sich Mitte 2007 verändert hat. Warum sprang das globale „Ungleichgewicht“ auf einmal auf 2,7 W/m²? Noch mehr auf den Punkt gebracht, warum hat sich der obere Ozean erwärmt, nicht jedoch die Lufttemperatur?

Ich habe keine Antworten auf diese Fragen, mein erster Gedanke waren „Wolken“… aber bevor ich mit diesem Datensatz arbeitete, wollte ich hingehen und nachschauen, warum es 2007 diesen großen Sprung gab. Was hat sich verändert und warum? Wenn das globale „Ungleichgewicht“ in unserem Interesse liegt, gibt es hier ein Ungleichgewicht zu studieren.

(Lassen Sie mich im Vorübergehen anmerken, dass es eine nicht korrekte vereinfachende Annahme ist, den Wärmegehalt der Ozeane zu eliminieren, um zur kanonischen Klimagleichung zu kommen. Diese kanonische Gleichung lautet:

Temperaturänderung = Sensitivität x Änderung des Antriebs.

Der Fehler liegt darin anzunehmen, dass die Änderung des ozeanischen Wärmegehalts (OHC) eine lineare Funktion der Temperaturänderung ∆T ist. Das ist sie nicht, wie die ARGO-Daten bestätigen… diesen Fehler habe ich in einem früheren Beitrag hier (auf Deutsch bei EIKE hier) beschrieben. Aber ich schweife ab…

Die ARGO-Aufzeichnungen bei SLT2011 haben auch eine Eigenart, wie sie auch bei einigen anderen Temperaturaufzeichnungen vorkommt. Die Schwingung während des gesamten Zeitraumes beträgt etwa ein Hundertstel Grad. Der größte Sprung innerhalb eines Jahres in den Daten liegt auch etwa bei einem Hundertstel Grad. Wenn sich in lang- und kurzfristigen Zeiträumen die gleiche Schwingung zeigt, kann man kaum noch viel über die Daten sagen. Das macht es sehr schwierig, die Daten zu interpretieren. Zum Beispiel beträgt das notwendige Ungleichgewicht zur größten Änderung innerhalb eines Monats etwa 24 W/m². Bevor wir fortfahren – Änderungen des OHC die zu betrachten sich lohnen würde, um zu sehen, a) ob sie real sind und b) falls ja, was hat sich verändert…

In jedem Falle, das war mein zweites Anliegen, die Kleinheit der gemessenen Temperaturunterschiede.

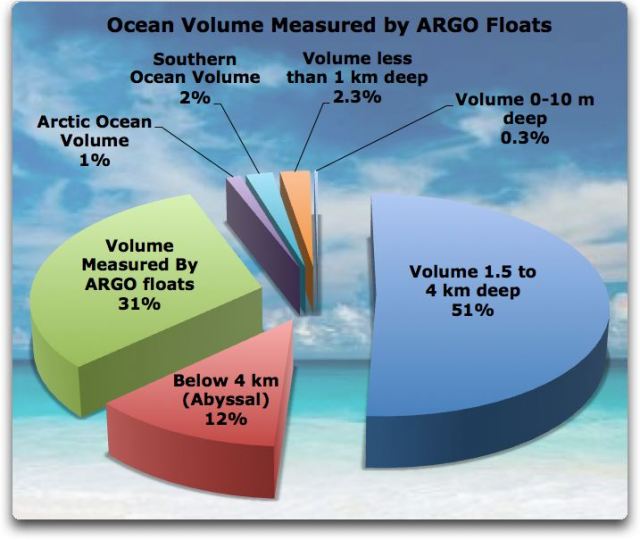

Als nächstes zur Abdeckung. Die ARGO-Analyse bei SLT2011 verwendet lediglich Daten bis zu einer Tiefe von 1500 Metern. Sie sagen, dass der Datenumfang von ARGO in noch größeren Tiefen zu dünn ist, um von Bedeutung zu sein, aber die Lage verbessert sich. Außerdem überdeckt die ARGO-Analyse nur den Bereich zwischen 60° Nord und 60° Süd. Der arktische bzw. antarktische Ozean bleibt also außen vor, ebenfalls wegen der unzureichenden Datenlage. Als nächstes fängt sie erst in einer Tiefe von 10 Metern an, lässt also die entscheidende Oberflächenschicht außen vor, obwohl die, wiewohl klein im Volumen, große Temperaturveränderungen erfährt. Schließlich fehlen in ihrer Analyse die Kontinentalschelfe, weil nur Gebiete betrachtet werden, in denen der Ozean über 1000 m tief ist. Abbildung 4 zeigt den Anteil der von den ARGO-Bojen tatsächlich vermessenen Gebiete in SLT2011, nämlich etwa 30%.

Abbildung 4: Anteil der Weltozeane, in denen die ARGO-Bojen messen, wie in SLT2011 verwendet.

Zusätzlich zu den Messungen der ARGO-Bojen zeigt Abbildung 4, dass es noch eine Anzahl anderer Messungen gibt. H2011 enthält Daten für einige davon, einschließlich der Südlichen Ozeane (= der antarktischen Gewässer) des Arktischen Ozeans sowie Tiefengewässer. Hansen verweist auf seine Quelle (Purkey und Johnson, hier PJ2010 genannt) und sagt, dass es in einer Tiefe von 2 bis 4 km keine Temperaturänderung gegeben hat. Dies gilt für das meiste des Wasseranteils auf der rechten Seite der Abbildung 4. Es ist unklar, wie sich das Wasser am Grund erwärmt, ohne dass die mittleren Wasserschichten das auch tun. Ich kann mir nicht vorstellen, wie das möglich sein soll, aber PJ2010 zufolge ist es so, dass das blaue Gebiet rechts das die Hälfte des Ozeanvolumens repräsentiert, keinerlei Temperaturänderung aufweist.

Weder H2011 noch SLT2011 bieten eine Analyse des Effekts an, den das Auslassen der Kontinentalschelfe oder der dünnen Oberflächenschicht hat. In dieser Hinsicht ist es bemerkenswert, dass sich in einer zehn Meter dicken Schicht wie in Abbildung 4 gezeigt die Temperatur problemlos um ein ganzes Grad ändern kann… und wenn sie das tut, wäre das etwa die Größenordnung der gleichen Änderung des ozeanischen Wärmegehaltes wie die 0,01°C der Erwärmung des gesamten Volumens, wie es von den ARGO-Bojen gemessen worden ist. Also ist diese Oberflächenschicht ein viel zu großer Faktor, um einfach bei der Analyse nicht berücksichtigt zu werden.

Es gibt noch ein anderes Problem mit den Abbildungen, die in H2010 als Beleg für die Änderung des Wärmegehalts des Tiefenwassers (unter 4 km) herangezogen werden. In der zitierten Studie, PJ2010, heißt es:

Schließt man den arktischen Ozean und die Nördlichen Ozeane aus, ist die Änderung des Wärmegehalts in Tiefengewässern (unter 4000 m) global in den neunziger Jahren und der ersten Dekade dieses Jahrhunderts äquivalent mit einem Wärmefluss von 0,027 (± 0,009) W/m², angewendet auf die gesamte Erdoberfläche. QUELLE: PJ2010.

Das läuft auf eine behauptete Erwärmungsrate der Tiefengewässer von 0,0007°C pro Jahr hinaus, mit einem behaupteten 95%-Intervall einer Standardabweichung von ±0,0002°C pro Jahr… Es tut mir leid, aber das nehme ich ihnen nicht ab. Ich akzeptiere nicht, dass wir den jährlichen Temperaturanstieg der Tiefengewässer auf zwei tausendstel eines Grades pro Jahr kennen, egal was PJ2010 behaupten. Die Tiefengewässer werden einmalig oder zweimal pro Dekade mit einem Profil vermessen. Ich glaube nicht, dass unsere Messungen ausreichend sind.

Wie es in der Klimawissenschaft häufig der Fall ist, ist unser Problem hier, dass als Einziges die strikte mathematische Unsicherheit hinsichtlich der Zahlen selbst berücksichtigt wird, losgelöst von der realen Welt. Es gibt eine damit verbundene Unsicherheit, die manchmal unberücksichtigt bleibt. Diese besteht darin, wie sehr unsere aktuelle Messung das gesamte Gebiet repräsentiert.

Das zugrunde liegende Problem ist, dass die Temperatur von „intensiver“ Qualität ist, während so etwas wie Masse von „extensiver“ Qualität ist. Diese beiden Arten, intensive und extensive Parameter, zu messen ist sehr, sehr unterschiedlich. Eine extensive Qualität ändert sich mit der Menge („extent“) dessen, was gemessen wird, was auch immer das ist. Die Masse von zwei Gläsern Wasser mit einer Temperatur von 40° ist zweimal die Masse eines Glases Wasser mit einer Temperatur von 40°. Zur Bestimmung der Gesamtmasse addieren wir einfach die beiden Massen.

Aber addieren wir zweimal 40°C, um eine Gesamttemperatur von 80° zu erhalten? Nein, so funktioniert das nicht, weil die Temperatur von intensiver Qualität ist. Sie ändert sich nicht auf Basis der Menge, die wir messen.

Extensive Qualitäten sind generell einfach zu messen. Wenn wir eine große Badewanne voll Wasser haben, können wir dessen Masse leicht bestimmen. Man bringe eine Skala an und mache eine einzige Messung – fertig! Eine Messung ist alles, was man braucht.

Aber die mittlere Temperatur des Wassers ist viel schwerer zu ermitteln. Es erfordert simultane Messungen der Wassertemperatur an genauso vielen Stellen wie verlangt. Die Anzahl der erforderlichen Thermometer hängt von der Genauigkeit ab, die man braucht, und von der Größenordnung der Änderung der Wassertemperatur. Wenn es warme und kalte Stellen des Wassers in der Wanne gibt, braucht man sehr viele Thermometer, um einen Mittelwert zu erhalten, der, sagen wir, auf ein zehntel genau ist.

Nun rufen Sie sich ins Gedächtnis zurück, dass wir hier anstelle einer Badewanne mit vielen Thermometern für die ARGO-Daten ein Ozeangebiet haben mit einer Seitenlänge von 380 km mit einer einzigen ARGO-Boje darin, die die Temperatur misst. Wir messen bis zu einer Tiefe von eineinhalb Kilometern, und wir erhalten drei vertikale Temperaturprofile pro Monat… wie gut charakterisieren diese drei Profile die tatsächliche Temperatur von 140.000 km² Ozean?

Man beachte ferner, dass es in den Tiefengewässern viel, viel weniger Messungen gibt… und doch wird behauptet, dass man eine noch größere Genauigkeit erreichen kann als mit den ARGO-Daten.

Bitte seien Sie sich darüber im Klaren, dass meine Argumentation nicht auf den Möglichkeiten einer großen Anzahl von Messungen basiert, um die mathematische Präzision des Ergebnisses zu verbessern. Es gibt etwa 7500 vertikale ARGO-Profile pro Monat. Die Einteilung der Ozeanoberfläche in 864 Gitterpunkte ist ausreichend, um uns mathematische Präzision in der von ihnen behaupteten Größenordnung zu geben, falls die Standardabweichung (SD) des tiefenintegrierten Gitterpunktes etwa 0,24°C beträgt. Die Frage ist, ob die SD der Gitterpunkte so klein ist, und falls ja, warum sie so klein geworden ist.

Sie diskutieren, wie sie ihre Fehleranalyse durchgeführt haben. Ich habe den Verdacht, dass ihr Problem in zwei Gebieten liegt. Eines ist, dass ich keine Fehlerabschätzung für das Entfernen der „Klimatologie“ aus den Daten, der historischen monatlichen Mittelwerte sehe. Das andere Problem enthält die verwendete geheimnisvolle Methode der Datenanalyse durch die Gittereinteilung der Daten horizontal und vertikal. Ich möchte mich zuerst mit der Klimatologiefrage befassen. Sie beschreiben ihre Methode wie folgt:

2.2 Methode der Datenbearbeitung

Eine ARGO-Klimatologie (hiernach ACLIM, 2004 – 2009 von Schuckmann et al., 2009) wird zunächst an jeder Stelle des Profils interpoliert, um lückenhafte Profile für die Tiefe jeder Temperatur und jeden Salzgehaltes zu vervollständigen. Diese Prozedur ist erforderlich, um die tiefenintegrierten Quantitäten zu berechnen. OHC (ozeanischer Wärmegehalt), OFC (ozeanischer Frischwassergehalt) und SSL (räumlicher {temperaturabhängiger} Meeresspiegel) werden dann für die Position jedes ARGO-Profils berechnet, wie es von Schuckmann et al. (2009) beschrieben worden ist. Schließlich wurden noch Anomalien der physikalischen Gegebenheiten an jedem Ort eines Profils berechnet, relativ zu ACLIM.

Terminologie: Ein „Temperaturprofil“ ist ein Strang von Messungen mit zunehmender Tiefe durch eine ARGO-Boje. Die „Position des Profils“ liegt auf einem vorher festgelegten Druckniveau, bei dem die ARGO-Bojen ausgesetzt werden, um eine Messung durchzuführen.

Dies bedeutet, wenn Daten in einem gegebenen Profil fehlen, wird die Lücke mit Hilfe der „Klimatologie“ gefüllt, d. h. den langzeitlichen Mittelwerten für den Monat und den Ort. Nur führt dies dazu, dass ein Fehler eingebracht wird, kein sehr großer, aber einer, der sich bemerkbar macht.

In Bezug auf den letzten Satz des vorigen Absatzes kann ich jedoch in ihrer Fehlerberechnung keinerlei Fehlerabschätzung finden. Jener Satz beschreibt die Subtraktion der ACLIM-Klimatologie von den Daten. ACLIM ist eine ARGO-Klimatologie, und zwar ein Mittel Monat für Monat aus jedem Tiefenniveau.

SLT2011 weist bzgl. dieser Frage auf eine frühere Arbeit der gleichen Autoren hin, SLT2009, worin die Bildung der ACLIM-Klimatologie beschrieben wird. Ich sehe dort über 150 Niveaus der ACLIM-Klimatologie, wie sie von den Autoren beschrieben werden:

Die Konfiguration wird definiert durch das Gitternetz und den Satz von mutmaßlichen Informationen wie der Klimatologie und deren mutmaßliche Abweichungen und Kovarianzen, die erforderlich sind, um die Kovarianzmatrix zu berechnen. Das analysierte Feld wird definiert auf einem horizontalen isotropischen Gitter im Abstand von ½° einer Mercator-Projektion und ist begrenzt auf den Bereich zwischen 77°S bis 77°N. Es wurden 152 vertikale Schichten zwischen 0 und 2000 m Tiefe definiert… und zwar mit einem Abstand von jeweils 5 m von der Oberfläche bis zu einer Tiefe von 100 m, 10 m von 100 bis 800 m und 20 m von 800 m bis 2000 m.

Sie haben also die oberen Ozeanschichten in Gitterwürfel eingeteilt und jeden Gitterwürfel in Schichten, um Gitterzellen zu erhalten. Wie viele Gitterzellen? Nun, 360 Längengrade x 2 x 180° Grad Breite x 2 x 70% der Erde sind Ozeane x 152 Schichten = 27.578.880 ozeanische Gitterzellen. Dann haben sie das Temperaturmittel Monat für Monat für jede einzelne dieser 25 Millionen Gitterzellen ozeanischen Volumens berechnet… ein netter Trick. Klarer Fall, sie interpolieren wie die Verrückten.

Es gibt etwa 450.000 einzelne Werte der Ozeantemperatur pro Monat, ermittelt durch die ARGO-Bojen. Dies bedeutet, dass jede ihrer 25 Millionen Gitterzellen im Mittel nur alle 5 Jahre einmal mit [gemessenen] Temperaturwerten gestützt werden.

Dies ist die “Klimatologie”, die sie an jeder „Profilstelle“ bei jedem ARGO-Tauchgang abziehen. Angesichts der kurzen Geschichte des ARGO-Datensatzes, die Abdeckung von 140.000 Quadratkilometern Ozeanfläche und die Kleinheit der Gitterzellen sind große Unsicherheiten in der Klimatologie offensichtlich.

Wenn sie also eine Klimatologie von einer aktuellen Messung subtrahieren, enthält das Ergebnis nicht nur einen Fehler in der Messung. Es enthält auch den Fehler in der Klimatologie. Wenn wir etwas subtrahieren, addieren sich die Fehler „quadratisch“. Dies bedeutet, dass der resultierende Fehler die Quadratwurzel der Summe der Fehlerquadrate ist. Es bedeutet auch, dass die großen Fehler bestimmend sind, vor allem, wenn ein Fehler viel größer ist als der andere. Die Temperaturmessung an der Stelle des Profils enthält lediglich den Instrumentenfehler. Für die ARGO-Werte beträgt dieser ± 0,005°C. Der klimatologische Fehler? Wer weiß das schon, wenn die Volumina nur alle 5 Jahre einmal mit Messungen belegt werden? Aber es steckt viel mehr dahinter als der Instrumentenfehler…

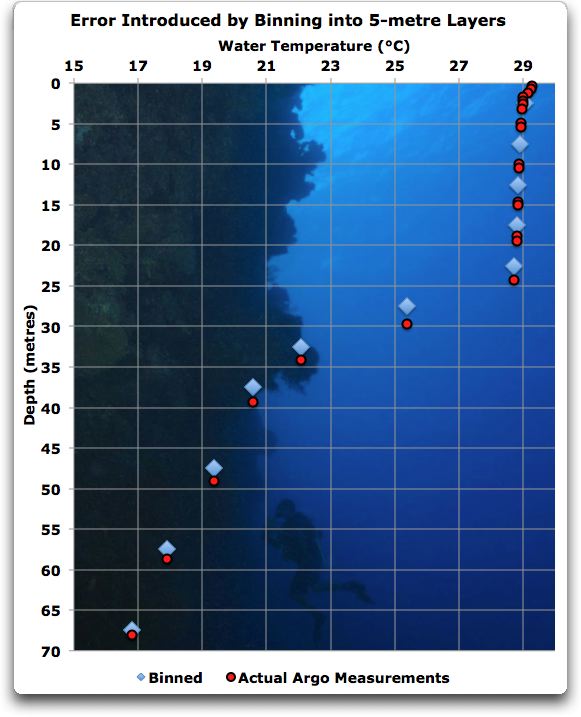

Das also ist das wesentliche Problem, das ich ihren Analysen entnehme. Sie machen es auf eine schwer nachvollziehbare, geheimnisvolle und plumpe Art und Weise. Argo-Daten und Temperaturdaten allgemein kommen in einer irgendwie genetzten Welt nicht vor. Wenn man die Dinge macht, die sie mit den Gitterquadraten und den Schichten machen, schleichen sich Fehler ein. An einem Beispiel will ich das verdeutlichen. Abbildung 5 zeigt die Tiefenschichten von 5 m, verwendet in der oberen kleineren Sektion der Klimatologie zusammen mit den Aufzeichnungen eines Temperaturprofils einer ARGO-Boje.

Abbildung 5 ACLIM-Klimatologieschichten (5 Meter). Rote Kreise zeigen die aktuellen Messungen eines einzelnen ARGO-Temperaturprofils. Die blauen Karos zeigen die gleiche Information nach der Mittelung in Schichten. Quelle

Vieles kann man hier erkennen. Erstens gibt es keine Daten für drei der klimatologischen Schichten. Ein größeres Problem ist Folgendes: wenn wir eine Einteilung in Schichten vornehmen, verweisen wir den Mittelwert in den Mittelpunkt der Schicht. Das Problem damit ergibt sich, weil die ARGO-Bojen im Flachwasser in Intervallen messen, die etwas weniger als 10 m dick sind. Also sind die oberen Messungen gerade über der unteren Grenze der Schicht. Im Endergebnis ist dies gleichbedeutend, dass man das Temperaturprofil bei der Einteilung in Schichten ein paar Meter nach oben verschiebt. Dies führt zu einer großen Verzerrung bei den Ergebnissen. Zusätzlich ist diese Verzerrung abhängig von der Tiefe, weil die oberen Schichten aufwärts, die tieferen Schichten aber abwärts bewegt werden. Der Fehler ist unter 100 Metern am kleinsten, wird aber danach wegen der Änderung der Schichtdicke zu 10 Metern rasch größer.

SCHLUSSFOLGERUNGEN

Zuletzt kommen wir zur Frage nach der Analysemethode und der Bedeutung der Überschrift zu diesem Beitrag*. Im SLT2011 lesen wir weiterhin:

Um die globalen ozeanischen Indizes (GOI) mit Hilfe der unregelmäßig verteilten Profile abschätzen zu können, wird der globale Ozean in Rechtecke mit 5° Breite, 10° Länge und 3 Monate Zeit eingeteilt. Dies gewährleistet eine ausreichende Anzahl von Beobachtungen pro Rechteck. Um falsche Daten zu entfernen wurden Messungen, die um mehr als das Dreifache von der Standardabweichung entfernt liegen, ausgeschlossen. Die Information bzgl. der Varianz für dieses Kriterium wird aus ACLIM abgeleitet. Dieser Prozess schließt etwa 1% der Daten unserer Analyse aus. Nur Datenpunkte über einer gemessenen Tiefe über 1000 m wurden dann behalten. Rechtecke mit weniger als 10 Messungen wurden als eine Messlücke betrachtet.

Tut mir leid, aber das ist eine dumme Methode, diese Art von Daten zu analysieren. Sie haben die aktuellen Daten verwendet. Dann haben sie Lücken mit „klimatologischen“ Daten gestopft, so dass alles nett und ordentlich aussah. Dann haben sie die „Klimatologie“ von dem Ganzen subtrahiert, mit einem Fehler in unbekannter Größe. Dann wurden die Daten in ein Gitternetz gemittelt mit einem Abstand der Gitterpunkte von 5 mal 10 Grad sowie 150 Schichten unter der Oberfläche mit variierender Schichtdicke, dann haben sie das gemittelt über einen Zeitraum von drei Monaten… das ist alles unnötige Komplexität. Dieses Problem zeigt erneut, wie isoliert die Gemeinschaft der Klimawissenschaftler in der Welt etablierter Methoden ist.

Dieses Problem, über vertikale ARGO-Temperaturprofile zu verfügen und diese zur Abschätzung der Temperatur in den nicht gemessenen Gebieten zu nutzen, ist keineswegs neu. Tatsächlich ist es genau die Situation, der sich jede Bergbaugesellschaft gegenüber sieht hinsichtlich der Ergebnisse ihrer Testbohrungen. Genau wie bei den ARGO-Daten haben die Bergbauer vertikale Profile der Zusammensetzung der unterirdischen Wirklichkeit an verschiedenen Stellen. Auch wie bei ARGO müssen die Gesellschaften aus diesen Informationen die Verhältnisse in den Gebieten abschätzen, die sie nicht sehen können.

Aber dabei handelt es sich dann nicht um AGW stützende Wissenschaftler, für die fehlerhafte Behauptungen nichts bedeuten. Für diese Leute geht es um das große Geld abhängig von den Ergebnissen ihrer Analysen. Ich kann Ihnen versichern, dass sie kein Brimborium veranstalten und das Gebiet in rechteckige Kästen einzuteilen und den Untergrund in 150 Schichten unterschiedlicher Dicke zu zerlegen. Sie würden jeden auslachen, der versucht, mit einer solchen schwerfälligen Methode eine Goldader zu finden.

Stattdessen benutzen sie eine mathematische Methode, “kriging“ genannt. Warum machen sie das? Weil es funktioniert.

Man erinnere sich, die Bergbaugesellschaften können sich keine Fehler leisten. Das Kriging (und daraus abgeleitete Methoden) haben sich jedes Mal dabei bewährt, die besten Abschätzungen des Untergrundes zu ergeben, die man nicht messen kann.

Zweitens ergeben sich aus dem Kriging aktuelle Fehlerabschätzungen und nicht der „acht tausendstel von einem Grad“-Unsinn der ARGO-Analysten. Die Bergbaugesellschaften können sich nicht selbst mehr Sicherheit vortäuschen als die Messungen hergeben. Sie müssen genau über die Risiken Bescheid wissen und nicht irgendwelche optimistischen Berechnungen vornehmen.

Am Ende dieses Tages möchte ich sagen, werfen Sie die Analyse der ARGO-Daten zum Fenster hinaus, zusammen mit all den aufgeblasenen Behauptungen über die Genauigkeit. Hören Sie auf, mit Gitternetzen und Schichten um sich zu werfen, das ist Zeug für die Hochschule. Nehmen Sie sich einen Kriging-Experten und analysieren Sie die Daten ordnungsgemäß. Meine Vermutung ist, dass eine echte Analyse zeigen wird, dass viele Abschätzungen unbrauchbar sind.

In jedem Falle ist dies meine Analyse der Hansen-Studie zum Energieungleichgewicht. Sie behaupten darin eine Genauigkeit, von der ich nicht glaube, dass sie ihrer gewaltig komplexen Methode gerecht wird.

Dies ist ein langer Beitrag, vielleicht haben sich Ungenauigkeiten und Druckfehler eingeschlichen, seien Sie gnädig…

Willis Eschenbach

Link: http://www.columbia.edu/~jeh1/mailings

Übersetzt von Chris Frey für EIKE