Im Netz gibt es eine weitere Seite, die die Bürger mit Fakten, im speziellen Fall, „Klimafakten“, informativ an die Wahrheit, das Wahre, die Realität also, heranführen möchte. „Klimafakten“, endlich eine Seite, die Fakten liefert, was denn nun los ist mit unserem Wetter und Klima oder ist damit etwa gar nichts los? Fakten sollen bekanntlich Realitäten, Wahrheiten aufzeigen, bzw. liefern. Die Enttäuschung über die Zeitvergeudung bei näherer Betrachtung war indes nicht unerheblich oder mit dem geflügelten Satz zu umschreiben „Außer Spesen, nichts gewesen“, was nun wieder einen direkten Zusammenhang zu dem jüngsten Klimarummel in Durban liefert, den die Politik, unterstützt von diversen Instituten, wie dem PIK veranstaltet, um unser Bestes zu wollen. Nicht unser Geld, wie jetzt vielleicht mancher zu denken glaubt, nein, unser Klima und damit unsere Lebensgrundlagen, zu retten (sofern sich das Klima von uns Menschen überhaupt retten lässt). In Anbetracht solch geistiger Verwandtschaft lag es nahe, einen Blick auf die Personenliste zu werfen, die die „Wahrheitsseite“ betreibt. Und in der Tat, bekannte Personen, die die Politik mit „Wahrheiten“ beliefert und mit ihr zu sonnigen, urlaubsbekannter Orte, Entschuldigung, heißt natürlich von Klimagipfel zu Klimagipfel jetten, sind dort aufgeführt. Für wahr, eine glaubwürdige, will heißen, unabhängige „Elite“, die sich dort zusammen findet, um uns Bürgern im Land, die Wahrheit, also Fakten zu liefern. Unser EIKE- Artikel möchte exemplarisch ein paar der dort zu findenden „Wahrheiten“ unter die Lupe nehmen.

Ganz vorne steht die Aussage: “97 Prozent der Klimaforscher sind überzeugt, dass der Mensch den Klimawandel verursacht“ und weiter “Es ist wissenschaftlich gesichert und gut belegt, dass der Mensch Hauptverursacher der bereits laufenden globalen Erwärmung ist.“ Warum braucht man dann noch eine „Wahrheitsseite“ im Netz, betrieben von so bekannten Personen wie Rahmstorf – war dass nicht der Rahmstorf, der sich Wissenschaftler nennt und zuweilen Wissenschaft mit einem Wettbüro verwechselt (http://www.scilogs.de/wblogs/blog/klimalounge/klimadaten/2008-05-08/die-klimawette).

Doch zurück zum obigen Zitat. In der Kommunikationswissenschaft wird solches mit einem „Totschlagargument“ gekennzeichnet. Unter Wikipedia steht dazu folgendes:

„Totschlagargumente sind inhaltlich nahezu leere Argumente, also Scheinargumente, bloße Behauptungen oder Vorurteile.“ Wikipedia liefert hierzu Beispiele wie „Jeder vernünftige Mensch weiß, dass …“, oder „Das ist doch allgemein bekannt.“

In der Wissenschaft werden üblicherweise Fragen gesucht, deren Beantwortung diskutiert und Für und Wider gegeneinander „abgewogen“. Von einer weiteren Person, die der Netzseite ein wissenschaftliches Renommee gibt, Prof. Marotzke, MPI, stammt folgende Aussage:

“Unsere Arbeiten zeigen zum ersten Mal mit einem umfassenden gekoppelten Klimamodell, dass die Erde bei heutiger Sonneneinstrahlung und heutiger Konzentration von Kohlendioxid in der Atmosphäre sowohl den heutigen Klimazustand als auch den Eisballzustand annehmen kann.“

Bravo! Herr Prof. Marotzke, wann dürfen Ihre Leser Ihre Einschätzung zu der Güte der Klimamodelle auf „Klimafakten“ lesen. Zum weiteren Inhalt von „Klimafakten“.

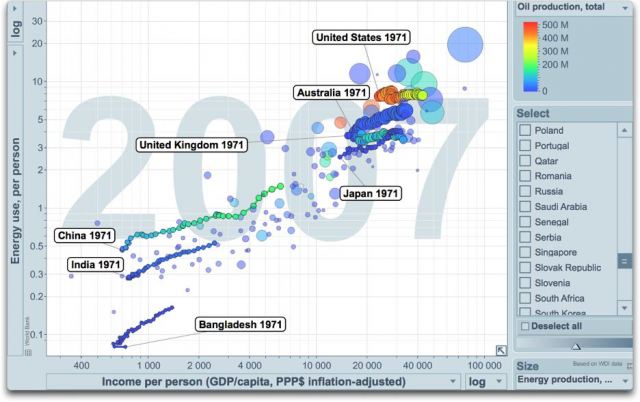

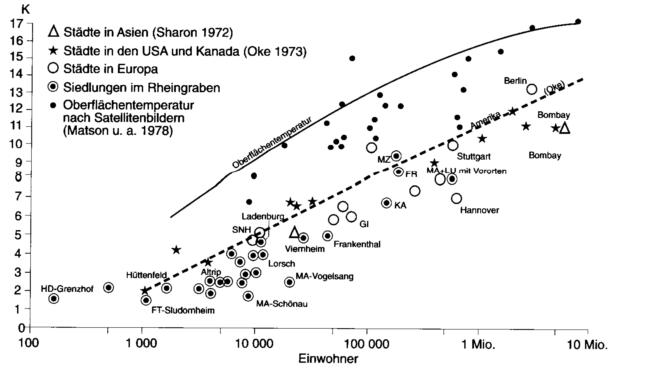

Einer der dortigen Berichte befasst sich mit Temperaturreihen und diverser Institute, die diese Reihen zusammenstellen. Nun, seit Climategate weiß die Welt, wie dort Klimawissenschaft durch Taschenspielertricks ersetzt wurde. EIKE berichtete ausführlich darüber. Wissenswertes darüber ist auch unter der Internetseite vor Prof. Watts oder in der Studie “Surface Temperature Records: Policy Driven Deception?“ (http://scienceandpublicpolicy.org/images/stories/papers/originals/surface_temp.pdf), oder hier zu finden (http://surfacestations.org/).

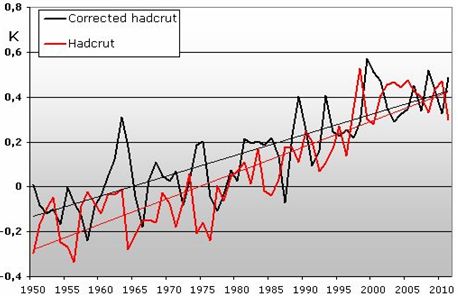

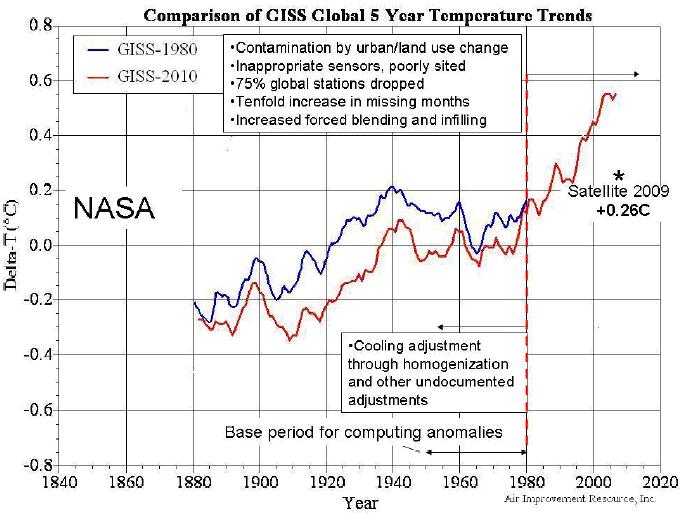

Da die Betreiber der Netzseite „Klimafakten“ explizit auf die Güte der GISS-Reihen verweisen, eine kleine Kostprobe, was es mit dieser Güte auf sich hat:

Abbildung 1 (Quelle: http://icecap.us/images/uploads/GHG_Model_failure_AO.pdf) zeigt die GISS-1980-Datenreihe (blau) und zum Vergleich, für exakt denselben Zeitraum, die GISS-Datenreihe 2010 (rot), in der auf wundersame Weise, der Temperaturverlauf gänzlich anders ist. Zum Vergleich ist darüber hinaus die Abweichung der Satellitenmessungen (+0,26°C) für 2009 eingetragen.

Weiter weiß der EIKE-Leser bereits, dass sich über 50% aller weltweiten Temperaturmessstationen des GHCN (erstellt die globalen Temperaturreihen) auf Flughäfen befinden und mittelbar und unmittelbar von den bis zu 600°C-heißen Jetabgasen beaufschlagt werden. Für globale Temperaturaussagen, die sich im Zehntel-°C-Bereich befinden, für wahr eine mehr als fragwürdige Darbietung. Und man braucht nicht weit zu gehen, um solch eine „Gütestation“ zu finden.

Abbildung 2 zeigt die Wetterstation auf dem Frankfurter Flughafen. Sie liegt nicht nur sehr nah am Rollfeld (ca. 70m), sondern in direkter Richtung zu den Abgasstrahlen der Jets, wie in der rechten Abbildung zu sehen. Das Bild erinnert frappierend an die Zustände auf dem Flughafen Rom, wie von Antony Watts gezeigt.

Abbildung 3 zeigt die Lage der DWD-Wetterstation auf dem Flughafengelände Frankfurt (roter Pfeil).

Der mittlere Temperaturhub, der sich durch den Flugbetrieb ergibt und durch die direkte, wie die indirekte Beaufschlagung über Wirbelschleppen erfolgt, liegt bei ca. +2,5°C, wie EIKE berichtete.

Optimisten könnten nun anführen, dass immerhin noch fast die Hälfte der Stationen brauchbar ist, doch leider weit gefehlt, wie der angegebene Link http://surfacestations.org/ und Abbildung 4 und 5 zeigen.

Die Messstation befindet sich direkt gegenüber einem Parkplatz in nur 2-3 m Entfernung zur Motorabwärme der Fahrzeuge. Unmittelbar gegenüber der Messhütte ist im Abstand von 3m gerade ein Messfahrzeug des Deutschen Wetterdienstes geparkt. Der Autor möchte nun nicht so weit gehen und fragen, ob immer dann dort Fahrzeuge abgestellt werden, wenn gerade einmal wieder Rekordtemperaturen benötigt werden. Auf jeden Fall verwundert es wohl niemanden mehr, dass gerade die Station in Karlsruhe immer unter den Temperaturrekordhaltern in Deutschland platziert ist.

Geradezu abenteuerlich die Aussage von „Klimafakten“ zum Wärmeinseleffekt (WI), der angeblich heraus gerechnet würde und überhaupt sehr gering sei. Erstens wird der WI weder von dem GISS, noch vom DWD heraus gerechnet, mehr noch, die Stationsleiter des DWD kennen auf Anfrage nicht einmal den WI ihrer Station! Und zweitens ist er alles andere als gering, wie die Bundesanstalt für Geowissenschaften und Rohstoffe bestätigt.

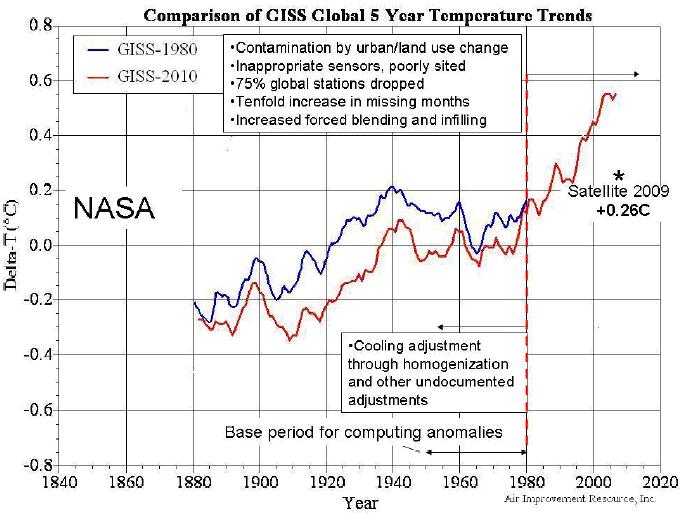

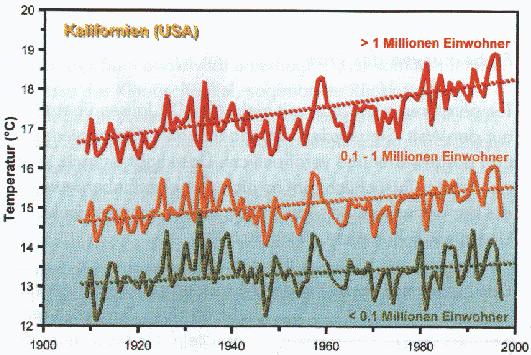

Abbildung 6 verdeutlicht am Beispiel der USA für den Zeitraum von 1910 bis 2000 den WI der Temperaturmessungen. Regionen mit geringer Einwohnerzahl weisen niedrige Temperaturen und fast keinen Temperaturanstieg auf, wogegen in Ballungsräumen eine signifikant höhere Durchschnittstemperatur und ein deutlicher Temperaturanstieg zu verzeichnen ist, Quelle: Klimafakten, S. 212, der Bundesanstalt für Geowissenschaften und Rohstoffe. Die Bundesanstalt für Geowissenschaften und Rohstoffe nennt ihre Ausarbeitung übrigens ebenfalls „Klimafakten“.

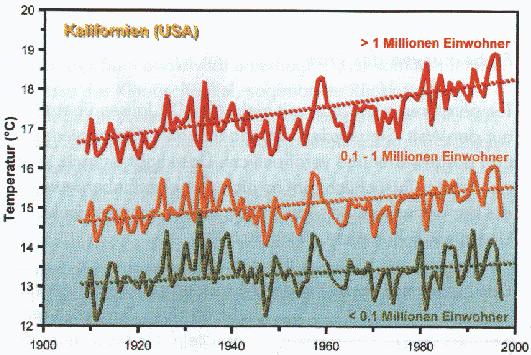

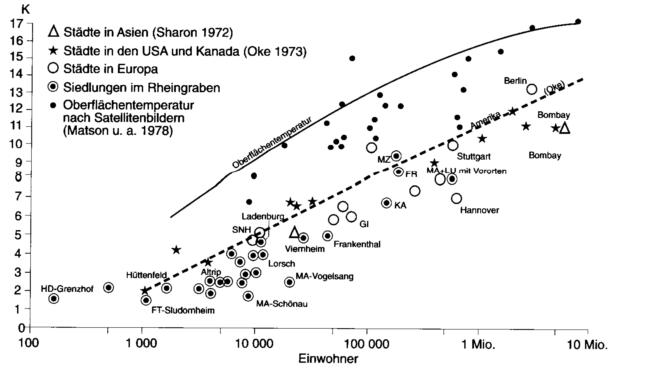

In der folgenden Abbildung sind die wissenschaftlichen Untersuchungen zum Wärmeinseleffekt für Asien, Nordamerika, Europa und Deutschland aufgelistet. Leicht erkennbar, dass die Stadttemperatur deutlich von der Umgebungstemperatur Land abweicht, also verfälschte Werte liefert. Abbildung 7 zeigt die Temperaturunterschiede von Städten gegenüber dem Umfeld.

Abbildung 7, Quelle: Christian-Dietrich Schönwiese, Klimatologie, Stuttgart, 2003

Das gleiche Bild bei der Untersuchung des international hoch angesehenen Klimawissenschaftlers Dr. Spencer.

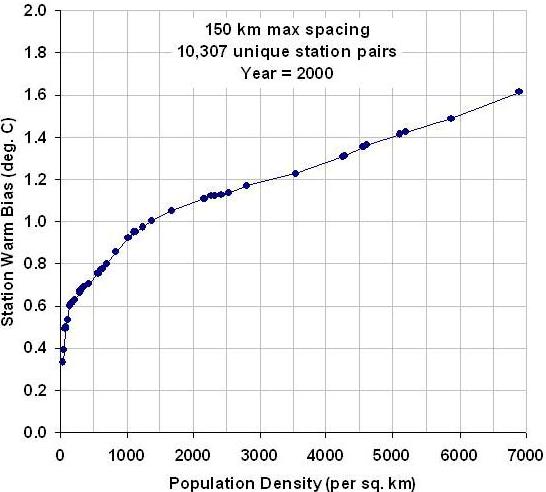

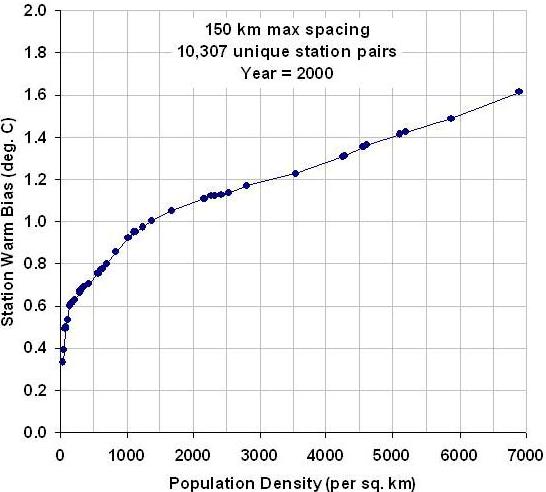

Abbildung 8: In seiner Veröffentlichung vom 03. März 2010 berichtet der bekannte Physiker und Klimawissenschaftler Roy Spencer, dass die Auswirkungen des Wärmeinseleffekts von der Besiedlungsdichte abhängen. Bei Änderungen von geringen Bevölkerungsdichten ist dieser proportional am stärksten, d.h. hier tritt die größte Erwärmung auf. Da im 20. Jahrhundert weit mehr kleinere Ansiedlungen in ihrer Bevölkerungsdichte zunahmen, als große Städte, die darüber hinaus noch einen geringeren Erwärmungstrend beim Zuwachs der Besiedlung ausweisen, liegt hier ein weiterer Fakt, warum die Temperaturen ab der zweiten Hälfte des 20. Jahrhunderts, als die Bevölkerungszahlen deutlich zunahmen, vergleichweise stark anstiegen.

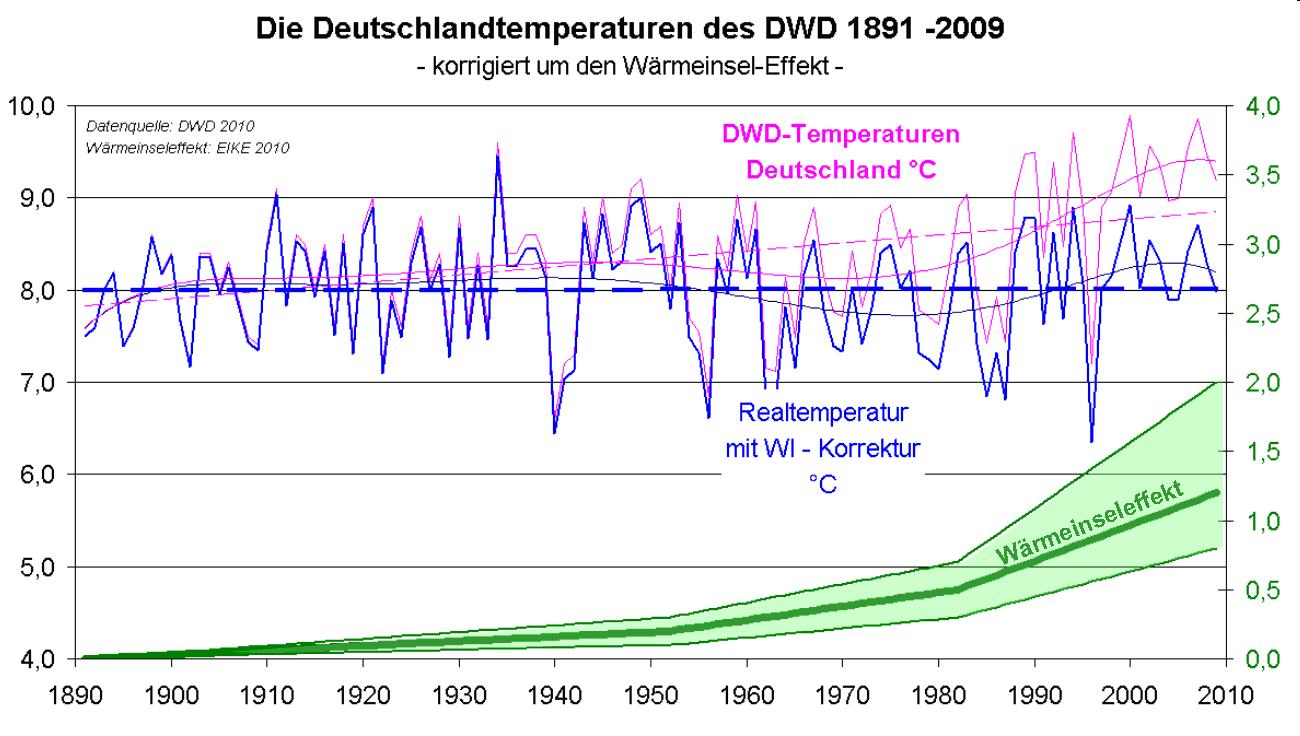

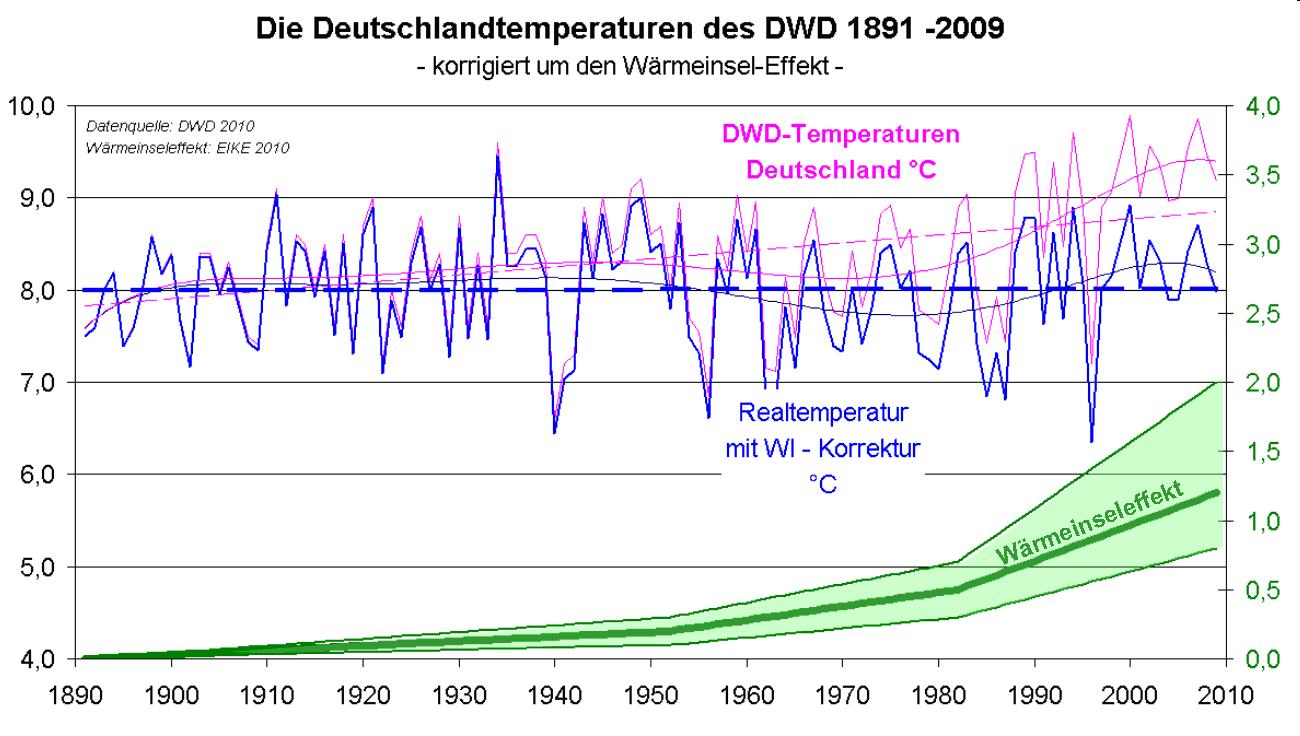

Zum gleichen Ergebnis kommen wir bei EIKE. EIKE hat erstmals die für Deutschland richtige Vergleichstemperaturkurve veröffentlicht, in der der WI flächendeckend heraus gerechnet wurde.

Abbildung 9 zeigt den unmittelbaren Vergleich der Deutschlandtemperaturen DWD und der WI-bereinigten von 1891 – 2009. Die blau gestrichelte Linie zeigt den Temperaturmittelwert im Betrachtungszeitraum. Die Temperaturen in Deutschland durchbrechen die Mittellinie nach unten, was bedeutet, dass es derzeit kälter als im 120-Jahresvergleich ist. Zum berechneten WI wurde, wie dies beim IPCC üblich ist, der Fehlertoleranzbereich angegeben (grüner Bereich).

Nicht besser ist die Aussage über den sog. Konsens. Dieser so oft bemühte Konsens besteht und bestand zu keiner Zeit und basierte zu allen Zeiten seines Aufkommens auf einer glatten Lüge. EIKE berichtete darüber (http://www.eike-klima-energie.eu/climategate-anzeige/phoenix-runde-teil-ii-kein-prima-klima-ist-die-welt-noch-zu-retten-ein-faktencheck/). Auch hier bringen die Klimaalarmisten Realität und Fiktion durcheinander:

Der Präsident der amerikanischen Akademie der Wissenschaften, Prof. Seitz schrieb im Wallstreet Journal vom 13. August 1996 die folgenden Passagen (deutsche Übersetzung: EIKE):

“In der vergangenen Woche veröffentlichte das Intergovernmental Panel on Climate Change nach fünf Jahren seinen ersten Bericht mit dem Titel „Die Wissenschaft vom Klimawandel 1995“ [The Science of Climate Change 1995]. Das IPCC wird von Vielen als beste Quelle für wissenschaftliche Information über den menschlichen Einfluss auf das Erdklima angesehen. Der Bericht wird ganz gewiss als jüngste und höchstautoritative Aussage über die Erderwärmung begrüßt. Entscheidungsträger und die Weltpresse werden den Bericht wahrscheinlich als Basis für wichtige Entscheidungen über die Energiepolitik ansehen. Er wird einen großen Einfluss auf die amerikanischen Öl- und Gaspreise und auf die internationale Wirtschaft ausüben.“

“Dieser IPCC-Bericht genießt wie alle anderen sein hohes Ansehen vor allem deshalb, weil er von Fachleuten begutachtet [peer reviewed] ist. Das heißt, er wurde von einem internationalen Expertengremium gelesen, diskutiert, geändert und gebilligt. Diese Experten haben ihren Ruf in die Waagschale gelegt. Doch der Bericht ist nicht, wonach er aussieht: Es ist nicht die Version, die von den beitragenden Wissenschaftlern genehmigt wurde, die auf der Titelseite aufgeführt sind. In meinen über 60 Jahren als Mitglied der amerikanischen Wissenschaftler-Gemeinde einschließlich meiner Tätigkeit als Präsident der „Academy of Sciences“ und der „American Physical Society“ habe ich keine bestürzendere Korruption des Verfahrens der Expertenbegutachtung [peer review] erlebt, wie bei der Entstehung dieses IPCC-Berichts.“

“Der Vergleich des von den beitragenden Wissenschaftlern genehmigten Berichts mit der veröffentlichten Version zeigt, dass zentrale Änderungen durchgeführt wurden, nachdem die Wissenschaftler zusammengesessen und die für den Schlussstand gehaltene Version begutachtet und gebilligt hatten. Die Wissenschaftler hatten angenommen, dass das IPCC seine eigenen Regeln einhalten würde – einen Regelsatz zur Steuerung seiner eigenen Tätigkeit. Keine der IPCC-Regeln erlaubt es, einen wissenschaftlichen Bericht zu verändern, nachdem ihn das Gremium der wissenschaftlichen Mitarbeiter und das gesamte IPCC selbst akzeptiert hat.“

“Die wissenschaftlichen Mitarbeiter hatten im November [1995] in Madrid den Bericht „The Science of Climate Change“ angenommen; das gesamte IPCC hatte im Folgemonat in Rom zugestimmt. Aber mehr als 15 Abschnitte im Kapitel 8 waren nach der wissenschaftlichen Überprüfung und Billigung des vermeintlichen Schlusstextes verändert oder gelöscht worden. Kapitel 8 ist das Schlüsselkapitel für das Darstellung der wissenschaftlichen Beweise für und gegen einen menschengemachten Einfluß auf das Klima.“

“Nur einige der Änderungen waren kosmetischer Natur, nahezu alle Hinweise auf die Skepsis vieler Wissenschaftler wegen der Behauptung, dass der Mensch einen Haupteinfluss auf das Klima generell und im Besonderen auf die Erderwärmung hätte, wurden entfernt.“

“Die folgenden Passagen enthalten Beispiele aus dem gebilligten Bericht, die aber aus der vermeintlichen expertengeprüften Version gelöscht wurden.“

„Keine der oben zitierten Studien hat einen klaren Beweis erbracht, dass wir den beobachteten [Klima-] Wandel auf die Zunahme von Treibhausgasen zurückführen können.“ „Bislang hat keine Studie den gesamten oder einen Anteil [des Klimawandels] auf anthropogene [menschengemachte] Ursachen zurückführen können.“ „Jegliche Behauptungen von positiver Entdeckungen über signifikante Klimaveränderung werden wahrscheinlich kontrovers bleiben, bis die Ungewissheit über die gesamte natürliche Veränderlichkeit des Klimasystems vermindert ist.“

“Die gutachtenden Wissenschaftler benutzten genau diese Sprache, um ihre eigene Aufrichtigkeit und die des IPCC zu wahren. Ich bin nicht in der Lage, zu sagen, wer die Hauptänderungen am Kapitel 8 gemacht hat. Doch der Hauptautor des Berichts, Benjamin D. Santer, muss vermutlich dafür verantwortlich gemacht werden.“

“IPCC-Berichte werden häufig als „Konsens“ bezeichnet. Wenn sie aber zur Kohlenstoff-Besteuerung und zu Beschränkungen des Wirtschaftswachstums führen, werden sie ganz sicher eine schwere zerstörerische Wirkung auf die Weltwirtschaft entfalten. Was auch immer die Absicht der Leute war, die diese bedeutenden Änderungen machten, sie täuschten Politiker und die Öffentlichkeit darüber, dass es wissenschaftliche Beweise für die menschliche Verursachung des Klimawandels gäbe.“

“Wenn das IPCC noch nicht einmal seine eigenen Regeln einhält, dann sollte das gesamte IPCC-Vorgehen aufgegeben werden, oder zumindest der Anteil, bei dem es um die wissenschaftlichen Beweise für den Klimawandel geht. Und die Regierungen sollten sich verlässlichere Quellen zur Beratung in dieser wichtigen Frage suchen.“

Die Fälschung der Kyoto-Vorlage durch Santer, warf ein ernstes Problem auf, wenn auch nicht für die Politiker und Staatsoberhäupter, die letztendlich ein solches Konstrukt unterschrieben und sich im wahrsten Sinne des Wortes, verschaukeln ließen. Das Problem bestand darin, dass sich von den ca. 2.000 Unterzeichnern, etwa 1.500 Wissenschaftler weigerten, den von Santer eigenmächtig geänderten Entwurf zu unterzeichnen. Wo sollte nun das IPCC die Unterschriften herbekommen. Hartmut Bachmann hat hierzu Unglaubliches recherchiert und veröffentlicht.

Hartmut Bachmann war u. a. Präsident eines Wirtschaftsinstitutes in den USA und leitete zur Zeit der Erfindung der Klimakatastrophe, also vor ca. 25 Jahren, als CEO und Managing Director eine US-Firma, die sich exklusiv mit Klimafragen beschäftigte. Er war als Kommissar des US Energy Savings Programms präsent bei zahlreichen Meetings und Verhandlungen in den USA, welche die Geburt des IPCC, des späteren Weltklimarates, zur Folge hatten.

Auszug aus dem Bericht von Hartmut Bachmann, “Wer waren die Unterzeichner des gefälschten Weltklimaberichtes?“ vom 02.08.2011:

“Um der hypothetischen Klimakatastrophe entgegenzusteuern sollen alle Nationen der Erde das angebliche Klimagift CO2 durch entsprechende nationale Gesetze bekämpfen. Dieser Auftrag an die Völker der Erde wurde vor Jahren durch die UNO beschlossen. Sie ordnete via ihres Ablegers UNEP für Dezember 1997 eine Weltklimakonferenz in Kyoto in Japan an. Den geladenen Delegationen sollte der neueste Weltklimabericht des IPCC vorgelegt werden.“

“Dieser zweite IPCC-Bericht von Ende 1995 beinhaltete die Schlüsselinformationen für die Verhandlungen, die dann 1997 zur Annahme des Protokolls von Kyoto durch den UNFCCC führen sollten. Dieser Bericht war vor Publikation peer-rewied. Nachdem alle an diesem Bericht beteiligten so genannten Wissenschaftler ihn durch ihre Unterschrift abgesegnet und in Umlauf gebracht hatten, kam Dr. Ben Santer, ein relativ kleines Licht innerhalb der UNO – UNEP – IPCC – Organisationen daher, und löschte alle Textteile, die darauf hinwiesen, dass es wahrscheinlich „KEINE“ Mensch-gemachte Klimaerwärmunf gäbe.“

„Ohne Löschen dieser Aussagen war das lange eingefädelte Billionengeschäft mit der Klimakatastrophe in Gefahr, was anlässlich der nächsten Weltklimakonferenz in Kyoto von der Weltgemeinde abgesegnet werden sollte. Also strich Santer die entsprechenden hinderlichen Passagen.“

“Kyoto rückte in Eile näher. Ein von Santer präparierter (gefälschter) schockierender Weltklimabericht lag nunmehr vor. Er sollte die Delegationen animieren, ohne viel Rückfragen und Aufhebens nach Kenntnisnahme des Inhaltes des Klimaberichtes ruck-zuck das so genannte Kyoto-Protokoll, das Endprotokoll der Tagung, zu unterzeichnen. Damit war der Weg frei, mittels nationaler Gesetze den weltweiten kostenträchtigen Kampf gegen das angebliche Umweltgift CO2 zu beginnen. Das gigantische Geschäft der Menschheit erhielt das internationale Limit zum Start. Und nun konzentrieren Sie sich bitte: Der den Delegationen vorzulegende jetzige Klimabericht war nunmehr nicht von gewünschter Anzahl von Wissenschftlern unterzeichnet, da so genannte originäre peer-Reviewer sich weigerten, den von Santer geänderten IPCC-Bericht in der jetzigen „gefälschten“ Form zu unterzeichnen, bzw. die Mitarbeit beim IPCC gekündigt hatten.“

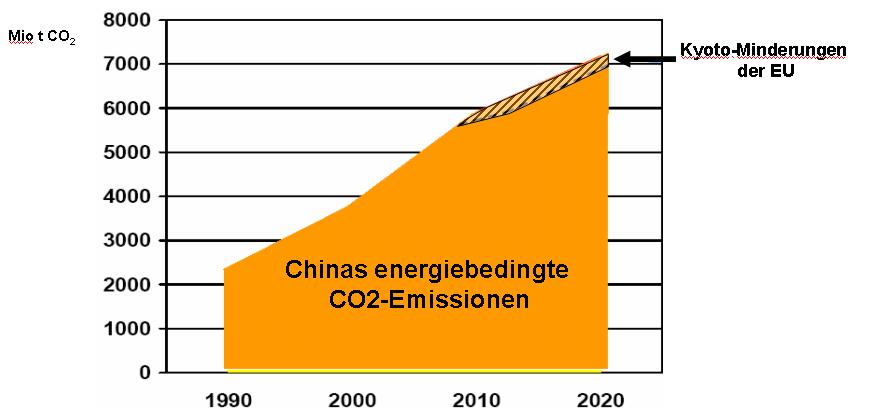

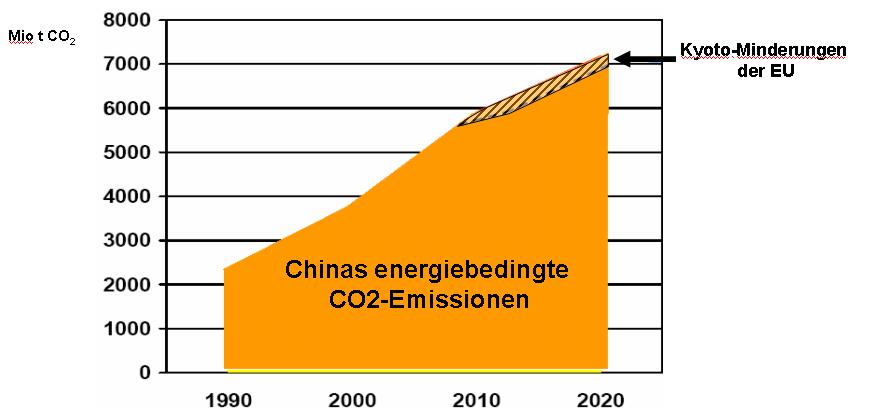

Abbildung 10, zeigt nach Daten der EnBW, wie sich die CO2-Emissionen Chinas von 1990 – 2010 entwickelten und wie sie sich bis zum Jahr 2020 entwickeln werden. Dazu im Vergleich, die europäischen CO2-Emissionseinsparungen nach dem Kyoto-Verträgen. Deutlich ist erkennbar, dass alle EU-Maßnahmen wirkungslos bleiben und die ganzen Gelder zur Reduzierung verschwendet sind.

“In Kassel gab es damals ein Klimainstitut (Center for Enviromental Systems Research University of Kassel) dessen Chef Prof. Joseph Alcamo von UNO, UNEP und IPCC ausgesucht wurde, die Interessen dieser Organisationen bezüglich Klima in Deutschland (Vorbereitung gigantischer Geschäfte) wahrzunehmen. Seinen in Kyoto wartenden Assistenten gab Prof. Alcamo am 9. Okt. 1997 zur Beschaffung der entsprechenden Unterschriften unter den gefälschten IPCC-Bericht folgenden Auftrag, den ich Ihnen hier komplett zur Kenntnis bringe:“

”Sounds like you guys have been busy doing good things for the cause. I would like to weigh in on two important questions–Distribution for Endorsements. I am very strongly in favor of as wide and rapid a distribution as possible for endorsements. I think the only thing that counts is numbers. The media is to say: „1000 scientists signed“ or „1500 signed“. No one is going to check if it is 600 with PhDs versus 2000 without. They will mention the prominent ones, but that is a different story. Conclusion – Forget the screening, forget asking them about their last publication (most will ignore you.) Get those names! Timing — I feel strongly that the week of 24 November is too late.”

”1. We wanted to announce the Statement in the period when there was a sag in related news, but in the week before Kyoto we should expect that we will have to crowd out many other articles about climate.”

”2. If the Statement comes out just a few days before Kyoto I am afraid that the delegates who we want to influence will not have any time to pay attention to it. We should give them a few weeks to hear about it.”

”3. If Greenpeace is having an event the week before, we should have it a week before them so that they and other NGOs can further spread the word about the Statement. On the other hand, it wouldn’t be so bad to release the Statement in the same week, but on a different day. The media might enjoy hearing the message from two very different directions.”

”Conclusion — I suggest the week of 10 November, or the week of 17. November at the latest.

Mike — I have no organized email list that could begin to compete with the list you can get from the Dutch. But I am still willing to send you what I have, if you wish.

Best wishes, Joe Alcamo“

“Wie wurde nun die Beschaffung der Unterschriften dort in Kyoto Ende Nov.-Dez. 1997 bewerkstelligt, damit die nichts ahnenden Teilnehmer der Delegationen den Bericht akzeptierten? Zur Tagung in Kyoto strömten zehntausend geladene Gäste und ebenso viele Klimamitläufer herbei. Alle wollten am Geschäft beteiligt werden.“

„So war es kein Kunststück fast 2000 Unterschriften von Greenpeace Gesandten, Lobbyisten, Angestellten umliegender Hotels, Tagesgästen, Schuhputzern und Tellerwäschern und rumstrolchenden Mitessern einzusammeln und sie als wichtige Wissenschaftler die letzten Seiten des Weltklimaberichts unterschreiben zu lassen, der dann in Kopie an alle anwesenden Delegationen verteilt wurde, um Schockwirkungen und Bereitschaft zur Unterschrift unter das endgültige Kyoto-Protokoll zu produzieren.“

“So lernte das Klima in Kyoto das Laufen und bewegte sich mittels der entsprechenden internationalen Klimagesetzte dahin, wofür es 11 Jahre lang – seit 1986 – zur Entwicklung gigantischer weltweiter, lang anhaltender Geschäfte mittels entsprechender Aktivitäten der Medien und der Wissenschaftler vorpräpariert worden war.“

Der anthropogene Klimawandel ist der größte Wissenschaftsschwindel und Wissenschaftsskandal der Neuzeit. Es muss an dieser Stelle die Feststellung getroffen werden, dass im IPCC tlw. eine dominante Gruppe von Betrügern am Werk ist, die gezielt Politik, Medien und Gesellschaft hinters Licht führen. Der ehemalige französische Wissenschaftsminister Claude Allegre bezeichnete die IPCC als “Ganz gewöhnliche Mafia.“

Der „Wissenschaftlicher Beirat“ von „Klimafakten“, wie man sich dort bezeichnet und deren Terminus auf Kompetenz hoffen lässt, schreiben zum Klima:

“Alle bekannten natürlichen Faktoren, die das Klima beeinflussen, wirken entweder über viel längere Zeiträume (z.B. die Verschiebung der Kontinente über Millionen von Jahren oder Unregelmäßigkeiten in der Umlaufbahn der Erde in Zig-Tausend-Jahres-Zyklen), oder sie haben sich innerhalb der vergangenen Jahrzehnte nicht signifikant verändert.“

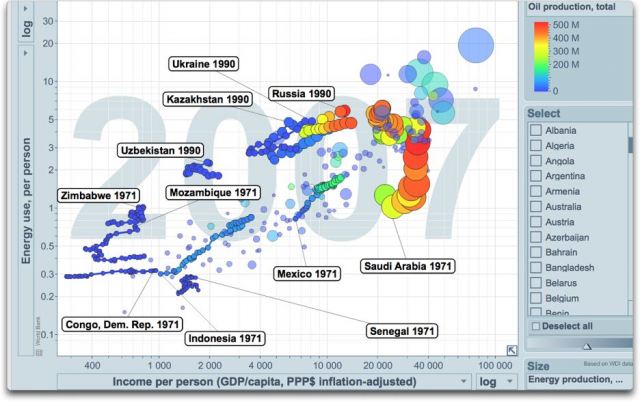

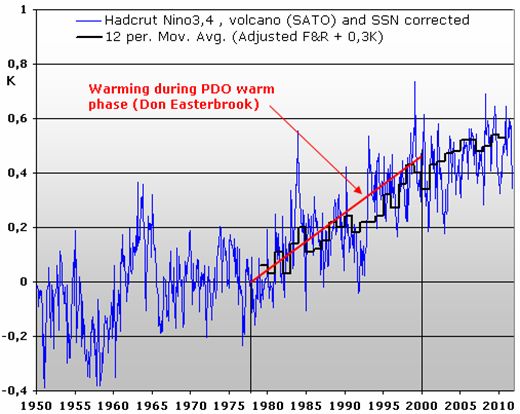

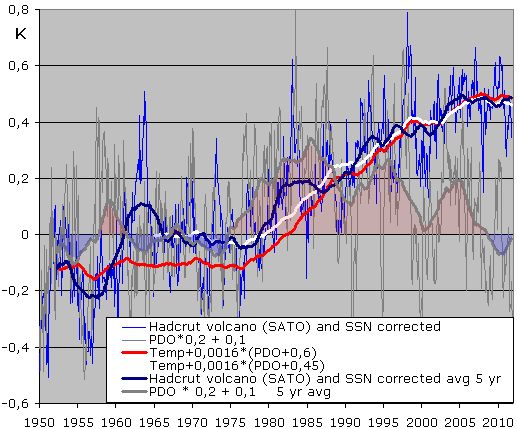

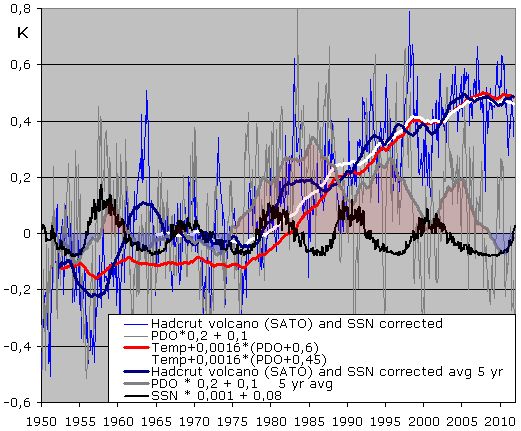

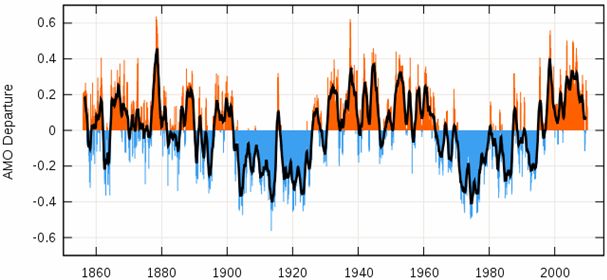

Es hat den Anschein, dass der „wissenschaftliche Beirat“ von „Klimafakten“ noch nicht etwas von der variablen Sonne gehört hat, bzw. nicht deren vielfältige Facetten kennt. Auf EIKE ist hierzu ein 8-teiliger Artikel erschienen, mit dem der „Wissenschaftliche Beirat“ seine Kenntnisse erweitern kann: (http://www.eike-klima-energie.eu/klima-anzeige/teil-1-dynamisches-sonnensystem-die-tatsaechlichen-hintergruende-des-klimawandels/). Dort ist die folgende Abbildung zu sehen, die zeigt, wie sehr die variable Sonne allein und auf kurzen Zeitskalen das Klima auf der Erde für die letzten 30 Jahre bestimmte. Zur Erinnerung, der Hauptsonnenzyklus hatte in 2003 sein 200-jähriges Maximum und seinen Anstieg parallel zum leichten Temperaturanstieg auf der Erde.

Auszug:

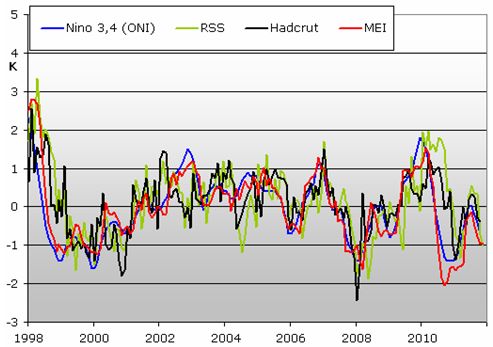

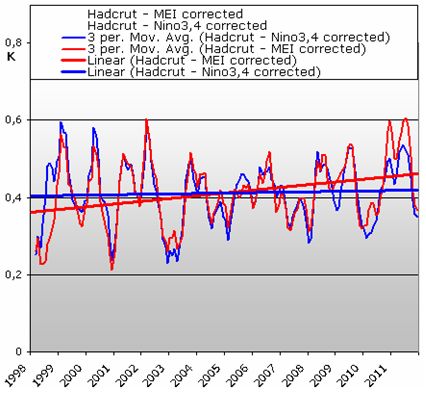

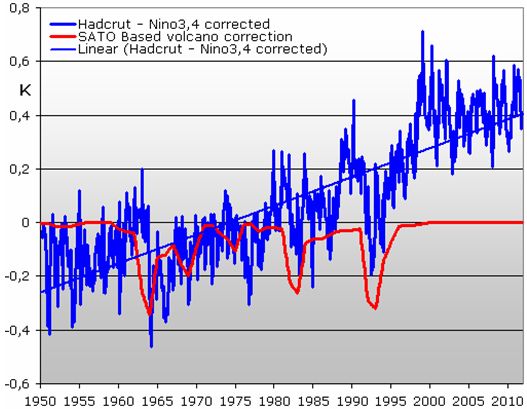

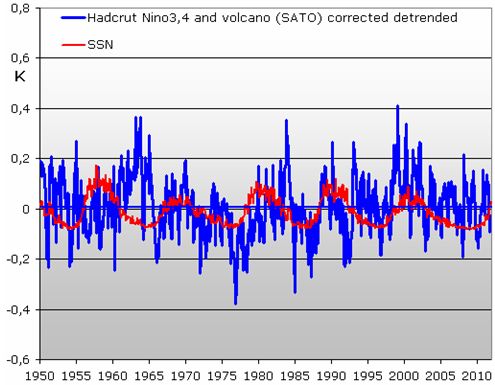

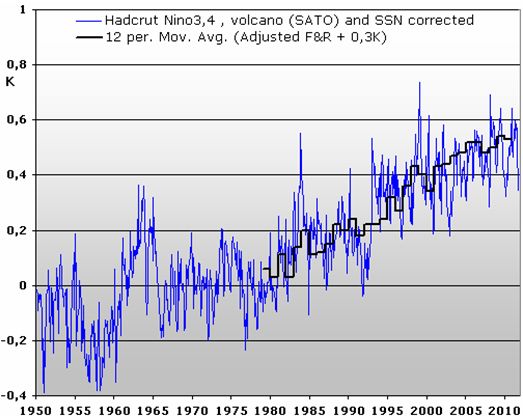

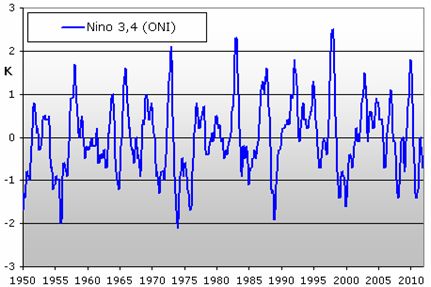

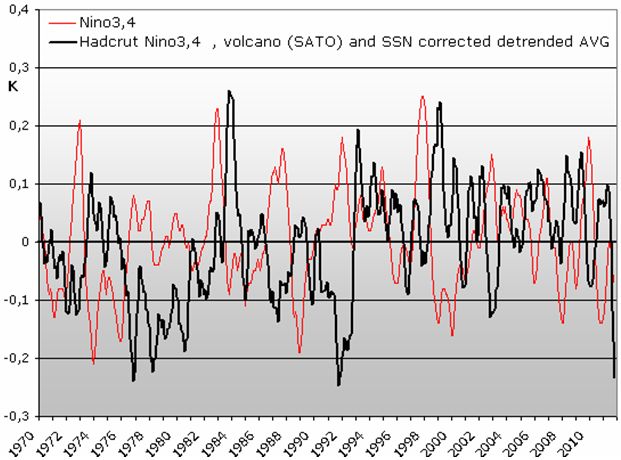

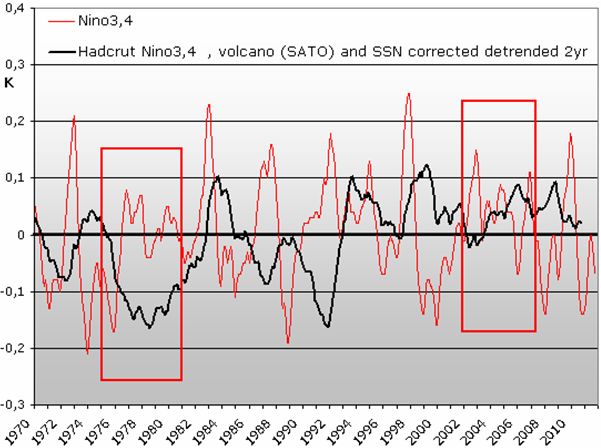

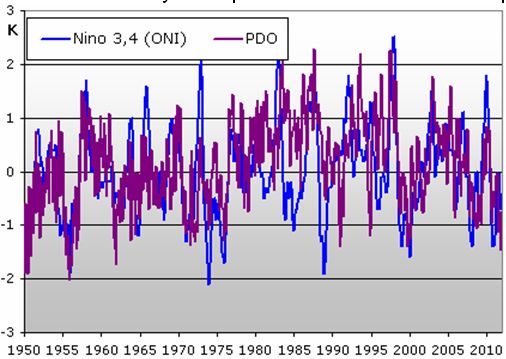

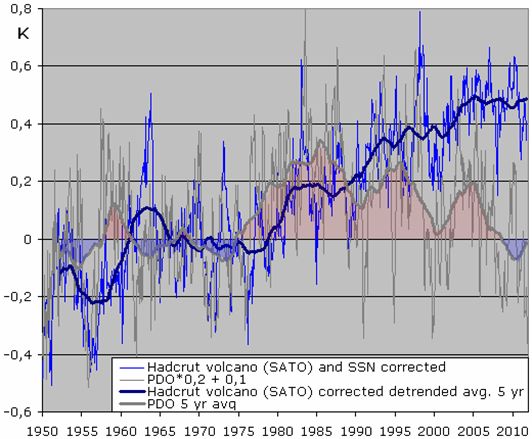

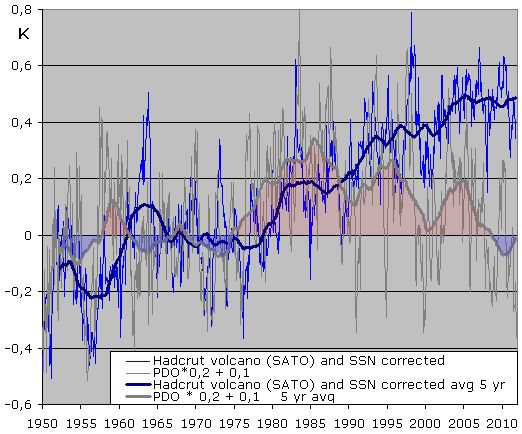

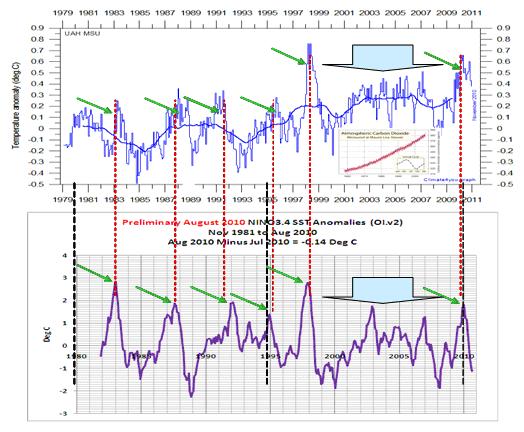

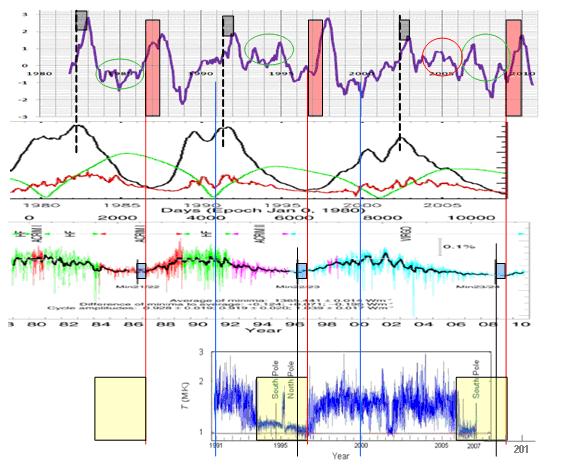

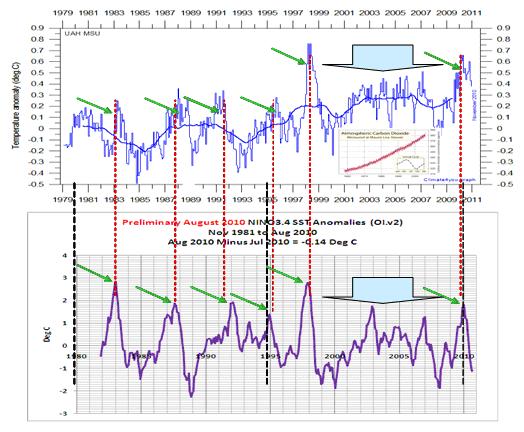

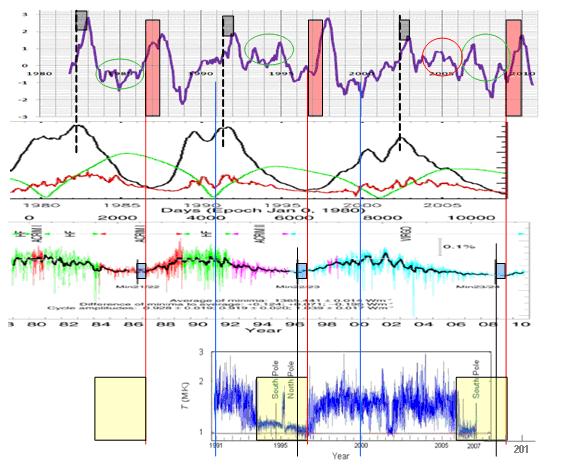

Abbildung 11 oben zeigt die Temperaturdatenreihe UAH (Satellitendaten). Die kleine Abbildung zeigt die atmosphärische CO2-Entwicklung nach Mauna Loa, die übrigens keinerlei Übereinstimmung mit dem Temperaturgang aufweist. Die Abbildung darunter zeigt die El Niño-Anomalien (El Niño 3.4) der Wasseroberflächentemperaturen. Jede globale Temperaturspitze in den letzten 30 Jahren fällt mit einem El-Niño-Ereignis exakt zusammen und das bei 8 Ereignissen im Betrachtungszeitraum (grüne Pfeile und Blockpfeil). Die schwarzen Linien dienen zur zeitlichen Justierung der Datenreihen.

Abbildung 12 zeigt den El Niño 3.4, der z.B. von der NOAA zur Betrachtung von El Niño-/La Niña-Ereignissen herangezogen wird (ganz oben). Die mittlere Datenreihe, die solare Aktivität nach Angaben der PMOD (Physikalisch-Meteorologisches Observatorium Davos) und die untere Datenreihe die Koronatemperatur der Sonne (http://rst.gsfc.nasa.gov/Sect20/A5a.html). Die blauen Linien dienen zur Zeitausrichtung der Kurven, die rote Linie zeigt den „Sprung“ der Koronatemperatur von 1 Million auf annähernd 2 Millionen Kelvin. Das blaue Rechteck die verstrichene Zeit vom Sonnenminimum, welches von der PMOD durch einen senkrechten Strich gekennzeichnet ist und das rote Rechteck die Zeitspanne vom Einschalten der „Koronaturboheizung“ bis zum El Niño-Maximum. Zu sehen ist, dass nach jedem Einschalten der Koronazusatzheizung (untere Datenreihe) ein El Niño ausgelöst wird (rote Rechtecke) und zwar innerhalb eines festen Zeitraumes und weiter, nach ca. 11 Monaten der El Niño sein Maximum erreicht. Darüber hinaus zeigt Abbildung 12 die magnetische solare Aktivität (zweite Datenreihe von oben, Quelle: Max Planck Gesellschaft (http://www.mps.mpg.de/projects/solar-mhd/research_new.html). Wie unschwer festzustellen, wird nach jedem Maximum im Schwabe-Zyklus ebenfalls ein El Niño-Ereignis ausgelöst. Auch hier wird das Maximum im El Niño-Ereignis nach einer exakt festen Zeitspanne erreicht (graue Rechtecke).

Die beiden Abbildungen legen den Schluss nahe, dass die Erdtemperaturen im Betrachtungszeitraum El-Niño-gesteuert sind (Abbildung 11, zum dominanten Einfluss auf die Erdtemperaturen, siehe auch die Arbeiten von Prof. Brönnimann, ETH, “Pazifik ließ Europa frieren“, Spektrum der Wissenschaft 03/05) und jeder El Niño wiederum, durch die Sonnenparameter gesteuert wird. Die Sonne bestimmt demnach ganz allein den Temperaturgang auf der Erde, oder wie Herr Dr. Gunter Tiersch am 09.11.2011 in seiner Wettervorhersage so trefflich bemerkte: „Ohne die Sonne geht gar nichts“. Irgendwelche Treibhausgase spielen erkennbar keine Rolle, so dass anhand der solaren Aktivität auch eine Aussage getroffen werden kann, wohin sich die Erdtemperaturen bewegen werden (http://www.eike-klima-energie.eu/climategate-anzeige/teil-8-dynamisches-sonnensystem-die-tatsaechlichen-hintergruende-des-klimawandels/).

Wie plausibel sind nun die auf „Klimafakten“ vorgebrachten „Fakten“, also „Wahrheiten“, die einen anthropogenen THE belegen sollen, denn, ein Grundgesetz der Quantentheorie lautet, dass es Energiequanten immer nur für gebundene Bewegungen gibt. Im Bohr´schen Atommodell sind dies die Elektronenbahnen. In einem Molekül (z.B. CO2) sind jedoch noch andere Bewegungen und mit ihnen, andere Energiezustände möglich: Drehung (um den Schwerpunkt), sowie Schwingung der Atome gegeneinander. Daraus ergeben sich eine Vielzahl von Energieniveaus und damit Energiespektren, die aus Rotationsenergie und Schwingungsenergie, sowie der Elektronenenergie bestehen. Lediglich letztere führt zur Emission von IR-Strahlung. Wie sich aus Berechnungen ergeben, liegen die Abstände der Stufen für die Elektronenenergien, für die Oszillationsenergien, als auch für die Rotationsenergien bei Molekülen (CO2) um Größenordnungen auseinander, wobei die kleinsten Energiequanten die Rotationsquanten sind, deren Linien am dichtesten zueinander sind. Man spricht hier von Rotationsquantenzahlen. Deshalb können diese absorbiert werden, ohne das Schwingungs- oder Elektronenzustand sich ändern.

Rotationsquantenzahl

Die Rotationsquantenzahl bestimmt dabei die Rotations-Schwingungsübergänge bei einem Absorptionsexperiment und beschreibt die Drehungen um die Molekülachse. Absorbiert ein Molekül dabei Strahlung, geht es von einem, durch die Rotationsquantenzahl J beschriebenen Zustand in den nächst höheren, durch J + 1 beschriebenen über. J = 0 gibt den nicht rotierenden Molekülzustand und J = 1 den langsamst möglichen rotierenden Zustand wieder. Nach der Quantenmechanik sind nicht alle denkbaren Übergänge zwischen den Energieniveaus erlaubt, sondern nur die mit einer sog. „Auswahlregel“. Die Auswahlregel für Rotationsübergänge bei 2-atomigen Molekülen lautet denn: Δ J = ± 1. Dies bedeutet nichts anderes, als dass nach der Bohr’schen Frequenzbedingung nur bestimmte Frequenzen absorbiert werden können.

Aus der Kenntnis der Rotationsspektren lässt sich übrigens auch nachweisen, warum N2 und O2-Moleküle nicht strahlen können. Damit elektromagnetische Wellen abgestrahlt werden können, muss eine periodisch bewegte elektrische Ladung vorhanden sein. Damit durch Änderung des Rotationszustandes eines Moleküls Ausstrahlung hervorgerufen wird, muss demnach während der Umdrehung auch elektrische Ladung bewegt werden. Nun fallen aber bei (symmetrischen) O2/N2-Molekülen die Schwerpunkte von positiver und negativer Ladung zusammen und liegen wegen der Massensymmetrie immer in der Rotationsachse. Daher haben solche dipollosen Moleküle kein Rotationsspektrum. Voraussetzung für das Auftreten von Rotationsspektren ist also, dass ein Dipolmoment während der Rotation seine Lage im Raum ändert.

Während niederenergetische Anregungen keine höher energetischen Anregungen hervorrufen können, ist dies im umgekehrten Fall stets gegeben. Die häufig im sichtbaren (zwischen 0,8 μm bis 0,4 μm) liegenden Elektronenspektren enthalten immer auch Änderungen des Oszillations- und des Rotationszustandes eines Moleküls. Demnach lässt sich das Spektrum eines Moleküls in drei Hauptbereiche unterteilen:

a) nur Änderung der Rotationsenergie, λ > 20 μm (langwelliges Infrarot)

b) zusätzliche Änderung der Schwingungsenergie, λ = 20 μm bis 1 μm (Infrarot)

c) zusätzliche Änderung der Elektronenenergie, λ < 1 μm (sichtbar bis ultraviolett)

Mit den Werten aus der Plank´schen Strahlungskurve und dem Wien´schen Verschiebungsgesetz: 6000 K etwa 0,5 μm, 300 K etwa 10 μm ergibt sich zwangsläufig, welche Prozesse in der Atmosphäre vorliegen können und welche nicht! Eine Gegenstrahlung gibt es daher nicht!

Im Bereich um 15 μm liegt demnach Oszillations- und Rotationsanregung vor und somit entsteht auch kein Strahlungs- oder Gegenstrahlungsfeld.

Dadurch wird deutlich, warum die durch den Erdboden erwärmte Atmosphäre stets kälter als dieser ist (Invasionswetterlagen ausgeschlossen, aber die werden nicht einmal von der IPCC als Beleg für den THE herangezogen) und den Erdboden nicht erwärmen kann, da Massen (Überwindung Trägheitsmoment) bewegt werden und somit die möglich abzugebende Energie immer kleiner als die aufgenommene ist. Zu Punkt c) müssen Energieniveaus überwunden werden, womit sich der Energiezustand eines Atoms ändert (z.B. durch Absorption). Bei der Rückkehr in den Grundzustand wird die vorher absorbierte Energie wieder in exakter Größe abgegeben, wonach das emittierte Photon natürlich zu groß sein müsste, als das vorher absorbierte. Nun „fallen“ Atome nicht direkt in ihren Grundzustand zurück, sondern dies geschieht über eine „Leiter“ zurück und nur ein Teil der „Energiewegstrecke“ ist durch Photonenemission(en) begleitet. Wie oben beschrieben, führen hochenergetische Anregungen, bei denen Photonen emittiert werden, immer auch zu niederenergetischen Anregungen, d.h. stets auch zu Molekülschwingungen und Rotationen, so dass das Energieniveau des emittierten Photons immer kleiner als das absorbierte ist. Abgesehen davon, dass bei 15 μm „lediglich“ Oszillations- und Rotationsanregung vorliegt.

Weiter hat Einstein einen Strahlungsansatz für Moleküle erarbeitet (1917), dessen Struktur mit dem Strahlungsgesetz vom Planck vereinbar ist. Einstein verwendete nicht nur Absorption von Molekülen, sondern auch die spontane Emission von Strahlung durch Moleküle und darüber hinaus auch noch die vom Strahlungsfeld induzierte Emission. Nur dadurch gelangte Einstein zur Struktur der Planckschen Strahlungsfunktion, wie sie Voraussetzung der Schwarzkörperstrahlerbetrachtung ist. Milne (1928) erweiterte die Arbeit Einsteins, damit eine seiner wesentlichen Annahmen überprüfbar ist. Dies ist die Gültigkeit des lokalen thermodynamischen Gleichgewichts. Wer nun behauptet, dass CO2 IR-Strahlung absorbiert und die absorbierte Energie wieder 1:1 an die Luft abgibt (Absorption also gleich Erwärmung ist), hat anscheinend Planck, Einstein und Milne nicht verstanden. Ob in diesen Gegebenheiten der Grund zu finden ist, warum der THE sich beharrlich seiner Überprüfung und Bestätigung im Versuch entzieht? Ohne experimentelle Überprüfung bleibt der THE eine wissenschaftliche These, jedoch kein wissenschaftlicher, bzw. physikalischer Effekt, der beispielsweise im Versuchsaufbau nachgestellt oder gar bestätigt werden könnte.

Dass der „Wissenschaftlichen Beirat“ sich weniger der Wissenschaft, als der, von dem IPCC vorgegebenen Linie widmet, zeigt weiter die folgende Passage:

“Die beobachteten Temperaturveränderungen in der Atmosphäre ähneln jenen, die bei einem verstärkten Treibhauseffekt zu erwarten wären: So erwärmt sich zur Zeit die unterste Atmosphärenschicht (bis ca. zehn Kilometern Höhe) bei gleichzeitiger Abkühlung der oberen Atmosphärenschichten (über zehn Kilometern Höhe).“

Was der „Wissenschaftliche Beirat“ mit einem Treibhauseffekt verwechselt, ist nichts anderes, als das gewöhnliche Gegenläufigkeitsprinzip zwischen Troposphäre (<10 km) und Stratosphäre (>10 km). Auf der Internetseite Atmosphärenphysik der Uni Wuppertal ist folgendes festgehalten:

“Tägliche Temperaturänderungen in der Stratosphäre sind nahezu regelmäßig denen in der Troposphäre entgegengesetzt mit etwa gleichen Beträgen. D.h. eine Erwärmung in der Troposphäre hat eine Abkühlung in der Stratosphäre zur Folge und umgekehrt. Dieses Verhalten ist als Gegenläufigkeitsprinzip bzw. stratosphärische Kompensation bekann. Die Temperaturkonstanz bzw. -zunahme hat ihre Ursache in der Strahlungskühlung durch den Wasserdampf in der oberen Troposphäre und Tropopausenregion und in der Erwärmung durch Absorption solarer Strahlung in der oberen Stratosphäre.“

Ein weiterer „Kalauer“, den der „Wissenschaftliche Beirat“ von „Klimafakten“ vorlegt:

“Direkte Strahlungsmessungen zeigen eine Zunahme der von der Erde ausgehenden langwelligen Wärmestrahlung (Harries 2001) und einen Anstieg der langwelligen Strahlung, die bei klarem Himmel aus der Atmosphäre auf die Erde einfällt und nur von Treibhausgasen stammen kann, da die Sonnenstrahlung kurzwellig ist. (Philipona 2005) – beides kann nur mit dem Treibhauseffekt erklärt werden.“

Diese Aussage sagt nichts anderes, als dass die Erde und damit THG*) eine Energiequelle ohne die Sonne sind und die Erde sich von sich selbst aus erwärmen würde, was gegen Grundprinzipien der Thermodynamik verstößt. Wie jeder weiß, wird darüber hinaus die kurzwellige Sonnenstrahlung durch die Atmosphäre selbst und die Bodenwärmeflüsse gewandelt. Vom PIK ist der Autor nichts Besseres gewohnt.

*) Sog. Treibhausgase, wie auch der postulierte Treibhauseffekt (THE), basieren auf vielleicht plausiblen (siehe Fazit) aber letztlich willkürlichen Annahmen und Festlegungen. Eine dieser willkürlichen Annahmen ist die Basis des THE, die sog. globale Temperatur der Erde ohne Atmosphäre von -18°C, anhand derer der sog natürliche THE berechnet wird. Anhand einer gemessenen und dann gemittelten globalen Oberflächentemperatur von +15°C läge der sog. natürliche THE bei 33°C (15°C – -18°C). An dem sog. natürlichen THE setzt der sog. anthropogene THE an. Stimmt der erstere nicht, so ist folglich auch der letztere falsch.

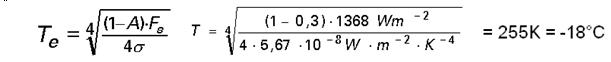

Berechnet wird die fiktive Temperatur der Erde ohne Atmosphäre anhand der Annahme eines Strahlungsgleichgewichts (eingehende Strahlung = ausgehende Strahlung) und nach S&B nach der Formel:

Während die „Solarkonstante“ recht gut ermittelt werden kann, wurde als planetarische Albedo einfach der gleiche Wert (0,3), wie für eine Erde mit Atmosphäre angesetzt, was nicht nur willkürlich (lässt sich nicht messen), sondern auch beliebig falsch ist. Nach Weichert (Fig. 25, S. 102) teilt sich die Albedo auf 0,21 (Wolkenanteil), 0,07 (Atmosphäre) und 0,02 (Boden). P. Kupfer/W. Kuttler (1998) definieren die Albedo als Rückstrahlung der Gesamtstrahlung (betrachten also das gesamte Strahlungsspektrum) und kommen ebenfalls auf einen Wert von 0,3 – 0,31 (in ihrer Arbeit auf S. 68). Sie teilen die Albedo auf, in 15,6% im sichtbaren Bereich, 10,8% Infrarotbereich und 4,2% im UV-Bereich. Bereits 1977 ging Michail Budyko in seinem Buch “Climatic Change“ von einer Albedo ohne Atmosphäre von 0,07 aus. Selbst die Vertreter der Deutsche Meteorologische Gesellschaft schreiben in einer Stellungnahme aus dem Jahre 1995 zu den “Grundlagen des Treibhauseffekts“ über die (fiktiven) -18°C: “Dabei ist eine planetare Albedo von 30 %, wie sie für das System Erde/Atmosphäre gilt, angenommen worden, d. h. die dem System zugeführte Sonnenenergie ist genauso groß wie in Wirklichkeit. Nimmt man eine realistische Albedo der Erdoberfläche von 15 % an, so ergibt sich für die mittlere Erdoberflächentemperatur ein Wert von -5,5° C.“

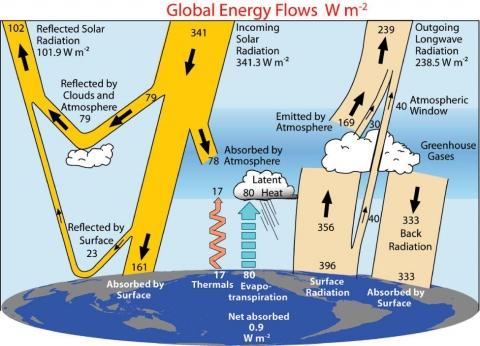

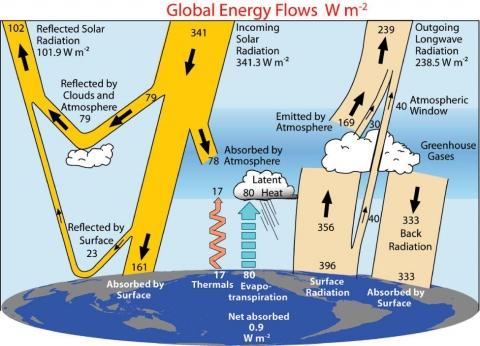

Selbst das IPCC gibt zu, dass die angesetzte Albedo von 0,3 für eine Erde ohne Atmosphäre falsch ist. Anhand der Energieflüsse von Trenberth (Abbildung 13), die als Grundlage für das Strahlungs(un)gleichgewicht der Erde dienen, ist die Albedo aufgeteilt in Boden und Atmosphäre, wobei der reflektierte Anteil der Atmosphäre mit 79 W/m2 deutlich über dem reflektierten Anteil den Bodens mit 23 W/m2 liegt. Wird dieser Wert in Relation gesetzt, so ergibt sich für eine Erde ohne Atmosphäre eine planetarische Albedo von 9,5%, was übrigens dem Wert der tatsächlichen Mondalbedo mit 0,11 (11%) sehr nahe kommt. Wird dieser realistische Wert in die obige Gleichung eingesetzt, so ergibt sich eine Temperatur für die Erde ohne Atmosphäre von 272 K, gleich -1°C. Der sog. natürliche THE von 33°C ist somit nach Trenberth auf nur noch 16°C zusammen geschrumpft. Mit diesem Wert, zugleich auch all die anderen vermuteten Werte, die die unterschiedlichen Treibhausgase am sog. postulierten THE haben sollen. Er basiert zudem auf Annahmen, die in der Realität auch nicht annähernd erfüllt sind**).

Abbildung 13 zeigt die Energieflüsse nach Trenberth, 2009.

**)

· Die planetare Albedo von 0,3 gilt nur für eine Erde mit Atmosphäre

· Das planetare Emissionsvermögen ist mit ca. 0,67 deutlich geringer als 1

· Eine gleichförmig verteilte Oberflächentemperatur gibt es nicht

· Die Rotation wird nicht berücksichtigt (dazu müsste eine Energiefluss-Bilanzgleichung für die Oberfläche eines jeden Gitterelements aufgestellt und gelöst werden)

· Speicherung von Energie im Erdboden bleibt unberücksichtigt

Soviel zu den „Fakten“ („Wahrheiten“), den die Betreiber von „Klimafakten“ propagieren.

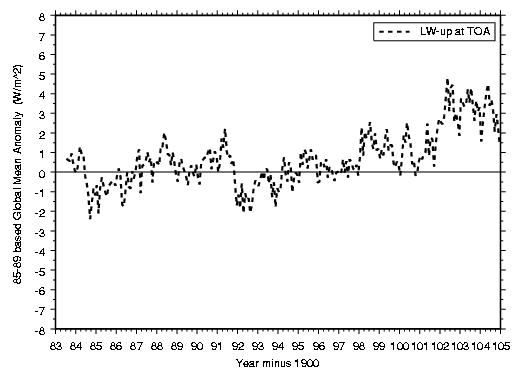

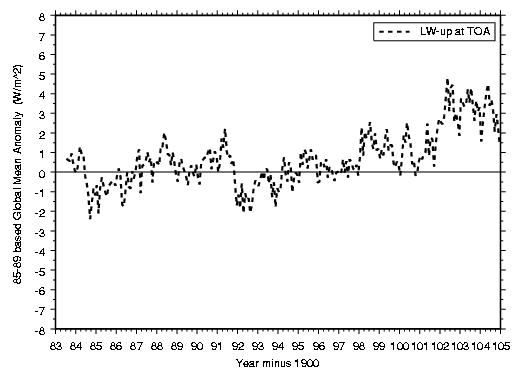

Die NASA als Weltraumbehörde, nicht das Goddard Institute for Space Studies, das sich vorrangig mit Klima-Computerspielen beschäftigt (siehe obige Aussage von Prof. Marotzke zu den Klimamodellen), der Teil der NASA, der das Erbe von Werner von Braun angetreten hat, widerlegt m.E.n ganz eindeutig die These vom Treibhauseffekt und die obige Aussage („Direkte Strahlungsmessungen zeigen…“) der erhöhten langwelligen Wärmeabstrahlung, die auf THG basieren soll, wie Abbildung 14 zeigt.

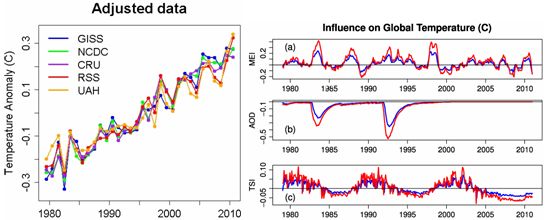

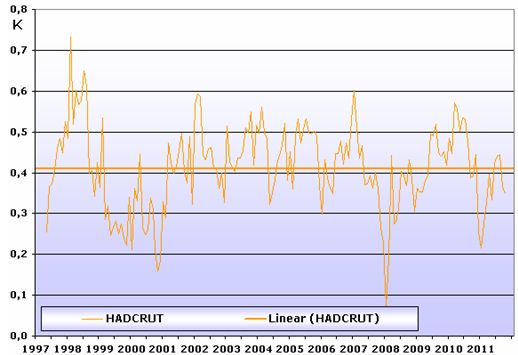

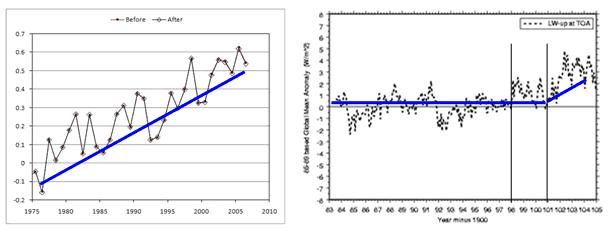

Abbildung 14, Quelle: (http://isccp.giss.nasa.gov/projects/browse_fc.html) zeigt die sich ändernde Strahlungsabgabe der langwelligen IR-Strahlung (Variabilität, TOP = Top Of Atmosphere) der Erde im Zeitraum von 1984 – 2005. Der Hub zwischen Min. – Max. beträgt 7 W/m2. Die Abbildung ist übrigens ein eindeutiger Beweis, dass die globalen Temperaturreihen manipuliert (z.B.: über Auswahl – EIKE berichtete darüber) sind, weil diese zur langwelligen Abstrahlung (Wärmeabstrahlung) der Erde nicht passen (Abbildung 15).

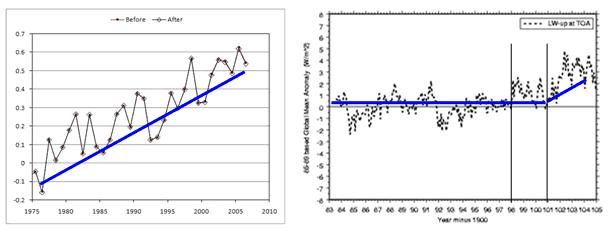

Abbildung 15 zeigt den Vergleich der langwelligen Erdabstrahlung, die bekanntlich das Produkt (Resultat) der globalen Erdtemperaturen ist und der globalen Temperaturentwicklung selbst, linke Abbildung, Quelle: www.Klimafakten.de. Während die globalen Temperaturen seit 1975 stetig steigen (zumindest gibt die Zeitreihe dies vor), ist die longway IR-Abstrahlung bis ca. 1998 konstant und steigt erst ab 2001 erkennbar an. In jenen Jahren (bis 2003) hatte der Hauptsonnenzyklus, der im Mittel 208-jährige de Vries/Suess-Zyklus sein Maximum.

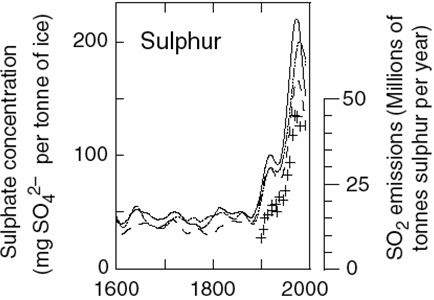

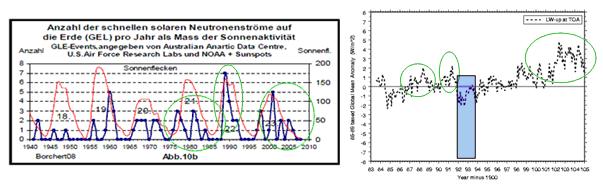

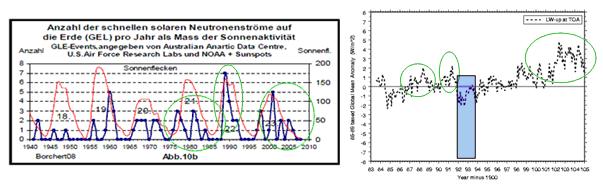

Abbildung 16 links zeigt die Häufigkeit der solaren Neutronenströme pro Jahr als Maß solarer Aktivität, Quelle: Dr. Borchert (Uni Mainz), “Klima, Sonnenflecken und kosmische Strahlung“ im Vergleich der langwelligen IR-Abstrahlung, also Erderwärmung. Es ist überdeutlich das gleiche Muster (Fingerabdruck, grüne Kreise) zu erkennen, was zeigt, dass zum einen, die eingangs zitierte Aussage aus „Klimafakten“ unhaltbar ist und zum anderen, einzig die Sonne („Ohne die Sonne geht gar nichts.“ Dr. Tiersch) die Erdtemperaturen steuert. Weiter ist sehr transparent zu sehen, wie der Ausbruch des Pinatubo in 1991 (blauer Balken), der die Erdtemperaturen für 2 Jahre um ca. 0,8°C senkte, die langwellige Erdabstrahlung (abhängig von der Temperatur) ebenfalls ins Minus lenkt, obwohl die Neutronenströme und damit die solare Aktivität hoch ist.

Fazit:

Anspruch und Wirklichkeit passen nicht zusammen. Die Herausgeber der Netzseite „Klimafakten“ schreiben vollmundig:

“Für den Klimaschutz gibt es keine Patentrezepte. Umso mehr kommt es in der Debatte über die besten Wege zum Klimaschutz auf eines an: dass die grundlegenden Fakten stimmen. Deshalb haben die Mitglieder des Wissenschaftlichen Beirats alle Texte auf dieser Website vor der Veröffentlichung überprüft. Darüber hinaus aktualisieren wir die Texte regelmäßig.“

Unser Artikel zeigt, dass „überprüfen“ (lesen), allein nicht ausreicht. Sachverstand und Wissen als Grundlage der Wissenschaft, und das kritische Hinterfragen, sind nun einmal durch nichts zu ersetzen.

Abschließen möchte der Autor mit einer Aussage von Prof. Dr. John S. Mattick aus S.d.W. 03/05, S. 62, die, wie der Autor meint, die derzeitige Auseinandersetzung zum sog. THE recht treffend beschreibt, auch wenn die Aussage ursprünglich aus dem Wissenschaftszweig der Molekularbiologie stammt: “Unbewiesene Annahmen entwickeln manchmal ein Eigenleben, was besonders in der Naturwissenschaft unangenehme Folgen haben kann. Am Anfang geht es gewöhnlich nur um eine plausible oder einfache Erklärung der Befunde. Wenn sie keine offensichtlichen Mängel aufweist und ihr Wahrheitsgehalt nicht unmittelbar überprüfbar ist, mutiert sie aber oft zum Glaubenssatz. Neue Beobachtungen werden dann passend interpretiert. Irgendwann aber muss das Dogma unter der Last eklatanter Widersprüche zusammenbrechen.“

Raimund Leistenschneider – EIKE