„Klimaforscher“ Latif sagt voraus: 50 °C in hundert Jahren, Italien erlebt Regengüsse wie seit langem nicht!

Siehe auch ergänzenden Nachtrag am Ende des Beitrages

…Sowohl beim kalten Winter 2009/10 als auch beim vorjährigen heißen Sommer in Mitteleuropa oder jetzt den sintflutartigen Regenfällen in Nord-Italien und Nordspanien handelt es sich um Ergebnisse normaler(!) meteorologischer Prozesse und Wetterlagen. Mit irgendeiner "Klima-Katastrophe" hat weder der vergangene kalte Winter noch der letzte heiße Sommer oder auch das jetzige Wettergeschehen auch nur das Geringste zu tun, und mit CO2 schon ganz+gar nicht !

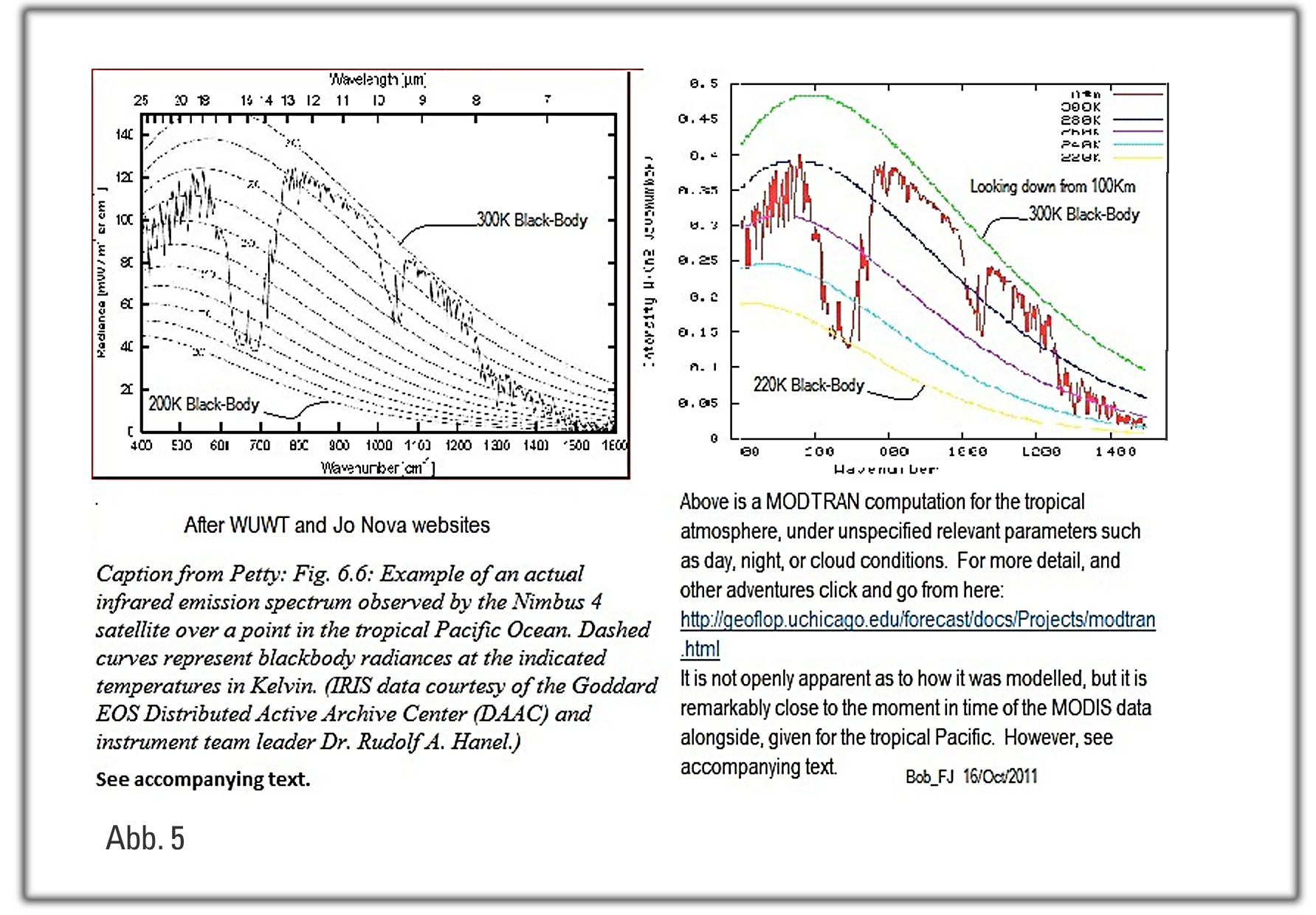

Die Atmosphären-Strömung "arbeitet" in Wellen und Wirbeln. D i e s e leisten in der Atmosphäre die Energie-Umsätze und Energie-Transporte. In unseren gemäßigten Breiten haben wir es zu etwa 80% des Jahres mit einer mehr oder weniger mäandernden West-Wind-Strömung in den höheren Luftschichten zu tun, wobei als dynamisches Bezugs-Niveau häufig die 500- Hektopascal-Fläche (keine “Ebene“) in ca. 5000 m Höhe benutzt wird.

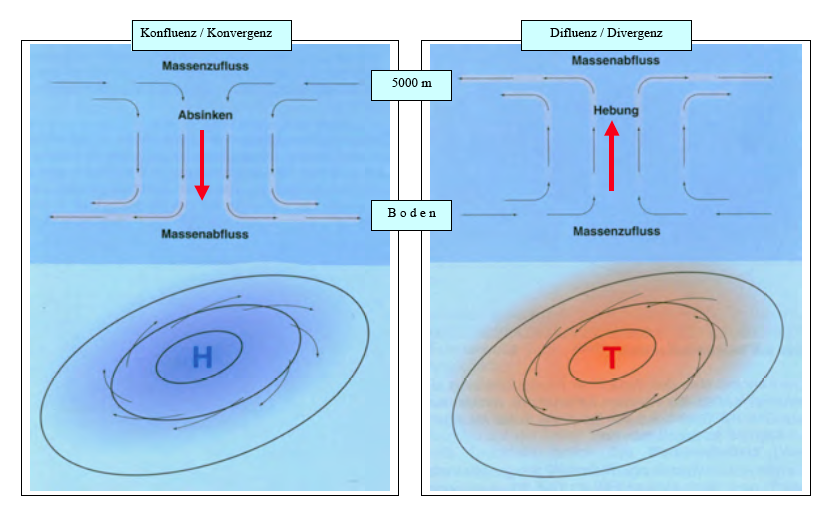

Das Wetter am Erdboden (also “in Augenhöhe") mit seinen Tiefs, Fronten, Hochs …. ist "ein Abfall-Produkt" dieser Höhenströmung. Die Druckgebilde und Wetter- Fronten entstehen als Folge von Konfluenzen (Konvergenzen) und Difluenzen (Divergenzen) in dieser Höhenströmung – auch Jetstream genannt (Abbildung 1).

Höhenströmung und "Boden-Wetter" werden von den sogenannten Zirkulations- Modellen der welt-weiten Wetterdienste mit guter Genauigkeit für ca. eine Woche prognostiziert. Dabei wird der sogenannte deterministische Anteil dieser physikalischen Prozesse für die Wetter-Prognosen heraus gearbeitet, während mit zunehmender zeitlicher Rechen-Distanz zum Ausgangszustand der unbestimmbare (stochastische) Anteil mehr und mehr überwiegt !

D a h e r geht man derzeit davon aus, daß aus physikalischen Gründen (Chaos- Theorie der Atmosphäre) auch in den nächsten Jahrzehnten (Jahrhunderten?) eine Vorhersagbarkeits-Grenze von ca. 10 Tagen kaum überschritten werden kann.

Schon aus diesen Gründen ist es eine ungeheuere Anmaßung der Klima- Institute, Klima (und damit letztlich Wetter) für 100 Jahre im voraus berechnen zu wollen !! (….selbst auch dann, wenn dieser Vergleich physikalisch etwas "hinkt").

Zu eigentlichen Kernfrage, warum mal sehr kalt und mal sehr heiß :

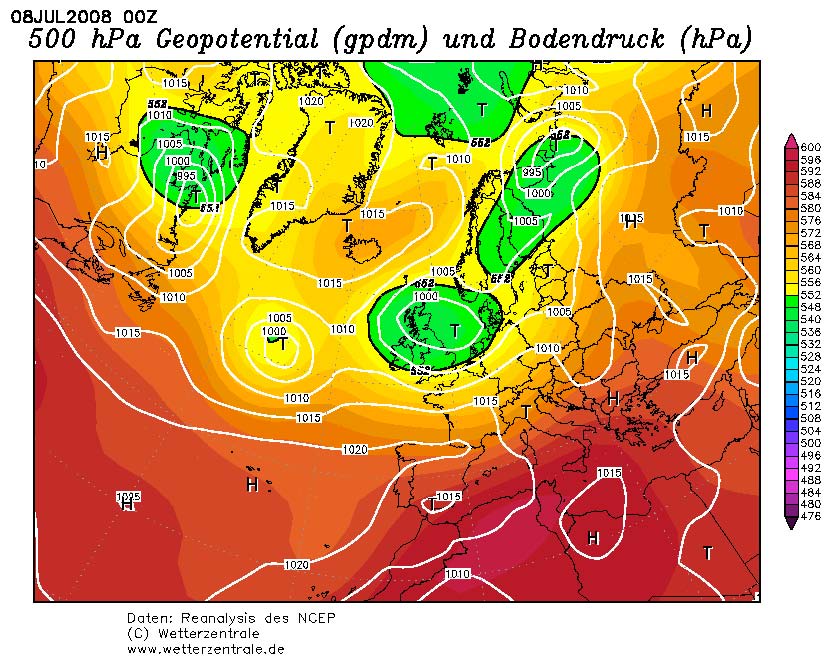

Wenn die Höhenwind-Strömung weitgehend West-Ost ausgerichtet ist, dann wird mit den Tiefs und ihren Fronten atlantisch temperierte Luft nach Europa gesteuert (Abbildung 2).

Das hat zur Folge, daß die Winter in Mitteleuropa mild und die Sommer kühl und regnerisch sind. Die mehr oder weniger ausgeprägten Mäander der ("wetter-steuernden"!) Höhenströmung nennt man wegen ihres globalen/planetaren Auftretens in der meteorologischen Fachsprache "Planetarische Wellen" (nach ihrem Entdecker auch: ROSSBY-Wellen). Dort, wo ein "Wellenbauch" ist, entsteht ein Hochdruck- Keil ; dort, wo ein "Wellental" ist, den die Meteorologen TROG nennen, haben wir tiefen Luftdruck – b e i d e s in "allen" Höhenschichten bis zum Boden, mehr oder weniger.

Auf den Westseiten der Tröge, auch Rückseiten genannt (…und damit am Ostabhang der Keile) wird Kaltluft von höheren (nördlichen) Gefilden in niedere Breiten transportiert (am Boden: "Kaltfronten") ; auf den Ostseiten der Tröge und folglich an den West-Flanken der Hochkeile wird Warmluft von niederen (südlicheren) Breiten nach Norden transportiert – Warmluft-Advektion!

In dieser Zirkulation überwiegen hemisphärisch/global "Wellen-Zahlen" von 5…6…7, seltener 3 oder 4. Bei geringeren Wellen-Zahlen (also 3…4…5) neigt die atmosphärische Strömung aus physikalischen Gründen ("stehende Wellen") zu einer Verlangsamung des West-Ost-Weiterwanderns, bis hin zum "Stillstand" – in der Meteorologie BLOCKIERUNG genannt.

D a n n verstärken sich Hochkeile und Tröge noch, w o m i t sich die Zufuhr von kalter bzw. warmer Luft intensiviert, je nachdem, in welcher Region wir uns unter der Höhenströmung und der sich daraus ergebenden Bodenströmung befinden.

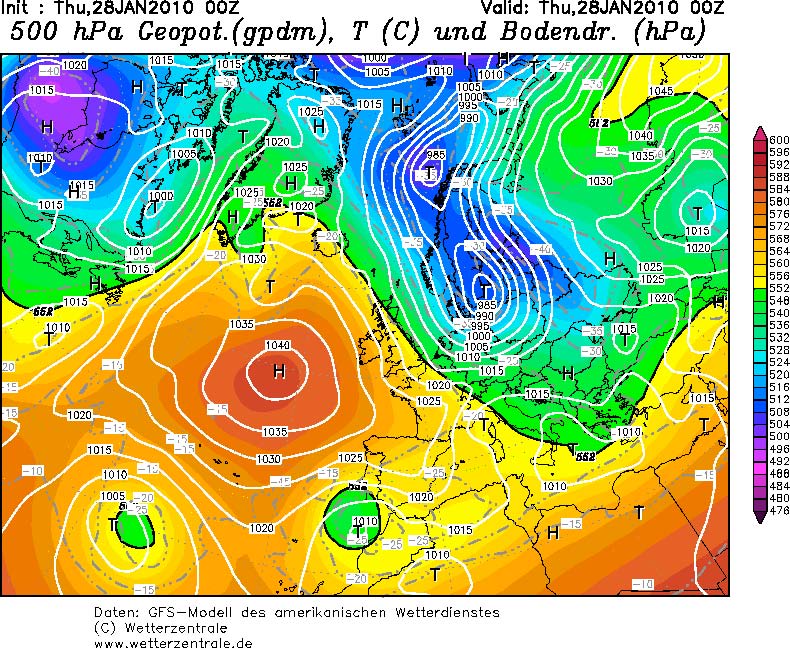

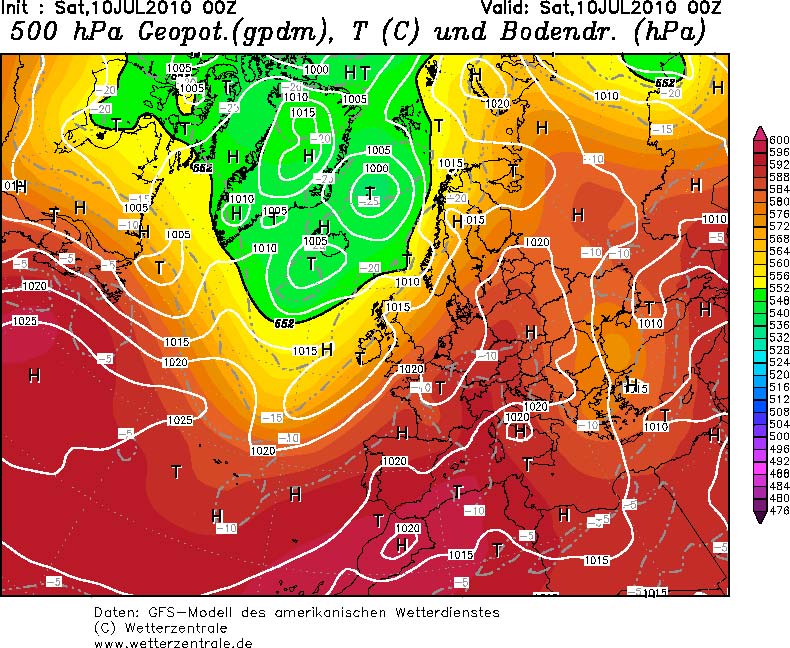

F o l g l i c h : Es gibt im globalen Maßstab gleichzeitig (!!) immer Regionen, in denen es (im Vergleich zum meteorologischen Langzeit-Mittel) entweder "zu kalt" oder eben"zuwarm"ist!! Genau dieses Strömungs-Muster einer BLOCKIERUNGS-Wetterlage ("Blockierung" gegen die "normale" Westdrift) hatte sowohl unseren Winter 2009/2010 bestimmt (Abbildung 3; 28.01.10), als auch unseren Sommer 2010 in den ersten drei Juli-Wochen (Abbildung 4; 10.07.10) .

Der einzige Unterschied – betreffend den vergangenen Winter und den Juli- Sommer 2010 – ist d e r , daß der blockierende Hochkeil im letzten Winter mehr oder weniger über dem Ostatlantik lag, mit einer ständigen "vorderseitigen" Kaltluft-Polarluft-Advektion nach Mittel- und Osteuropa (TROG), w o g e g e n

der Hochkeil im Juli über dem mittleren bis östlichen Europa lag.

D a s hatte zur Folge, daß an der Westflanke dieses Hochkeils und gleichermaßen auf der Ostflanke ("Vorderseite") des "stationären" ostatlantischen Tiefdruck-Troges subtropische Warmluft nach West- und Mittel- Europa geführt wurde ! W a r u m die Atmosphäre sich in machen Jahreszeiten für eine solche “Blockierung“ entscheidet, oder eben – wie z.B. in “normalen“ Sommern – für eine Atlantische Westdrift mit Regen und kühler Luft (wie mehr oder weniger in den Sommern 2007-2009), das ist nicht bekannt.

Interessant ist jedoch, daß diese Zirkulations-Muster der Blockierungen bzw. der sommerlichen West-Wind-Regen-Drift tief in der Erfahrung unseren Vorfahren verankert ist, und in der Bauern-Regel vom “Siebenschläfer“ ihren Niederschlag gefunden hat (vgl. Anlage PDF).

Fazit:

Dieses alles sind meteorologische Prozesse und Wetterlagen, mit irgendeiner "Klima-Katastrophe" hat weder der vergangene kalte Winter noch der jetzige heiße Sommer auch nur das Geringste zu tun, und mit CO2 schon ganz+gar nicht !!!!!

Dipl.-Meteorologe Klaus-Eckart Puls

(Quelle d. Wetterlagen-Abbildungen: Nat.Rdsch. H.2 (1984), Singularitäten der Witterung, S. 61-66)

Nachtrag der Redaktion 12.11.11:

Dem Beitrag von Herrn Puls kann man entnehmen, wie das hemisphärische Wellenmuster die Wetterlagen bei uns beeinflusst. Völlig zu Recht hat er auf die Erhaltensneigung bei stark meridionaler Zirkulation hingewiesen. Als Ergänzung wollen wir noch ein wenig tiefer in die Rossby-Wellentheorie einsteigen.

Die Rossby-Formel zur Verlagerung planetarischer Wellen besagt, dass diese sich umso schneller ostwärts verlagern, je höher der sog. zonale Grundstrom ist. Außerdem wandern kürzere Wellen (z. B. 8 Tröge/Hochkeile) schneller als längere Wellen (4 bzw.5 Tröge/Keile). Die ultralangen Wellen 1 (=Asymmetrie des Jet-Streams zum geographischen Nordpol), 2 und 3 bewegen sich retrograd, d. h. westwärts, sofern sie überhaupt vorhanden sind.

Eine dieser Wellenzahlen wird also stabil gehalten. Im Sommer ist dies häufig bei der Wellenzahl 5, im Winter bei der Wellenzahl 4, bei sehr starkem zonalen Grundstrom auch die Wellenzahl 3. Da man, grob vereinfacht, die Stärke des zonalen Grundstroms mit der Stärke des Westwindimpulses vergleichen kann, ist bei einer kürzeren Wellenzahl, die stabil gehalten wird, der Westwindimpuls deutlich schwächer. Im Unterschied Sommer/Winter leuchtet das ein und braucht hier nicht weiter erläutert zu werden.

Zwei Dinge sind im aktuellen Fall interessant: 1. Im Moment, das zeigt eine einfache harmonische Zerlegung des Jet-streams in einzelne Wellenanteile, wird die Welle 5 stabil gehalten, was für diese Jahreszeit schon sehr ungewöhnlich ist (siehe unten). Sollte das Anfang Dezember auch noch so sein, zeichnet sich im kommenden Winter eine stark verringerte Neigung zu Westwindwetterlagen ab.

2. Weiteres Indiz für den derzeit schwach ausgeprägten Westwindimpuls ist die lange zeitliche Dauer des gegenwärtigen Wellenmusters, worauf ja auch Herr Puls in seinem Beitrag schon hingewiesen hatte.

Was eine stark verminderte Neigung zu Westwindwetterlagen für unser Wetter (nicht Klima!) im Winter bedeutet, ist wohl ziemlich leicht auszurechnen.

Ein Grund (von mehreren, teils wohl noch nicht einmal bekannten) für die verringerte Westwindbereitschaft ist sicherlich die Tasache, dass im äquatorialen Pazifik nach wie vor eine riesige Kaltwasseranomalie zu finden ist, in abgeschwächter Form auch im subtropischen Atlantik. Dies bedeutet, dass der absolute Temperaturgegensatz der Wassertemperatur zwischen niedrigen und hohen Breiten vermindert ist, was mit der Atmosphäre natürlich in Wechselwirkung steht.

Weiteres hierzu kann man mit den Stichworten "Rossby, hemisphärische Wellen" etc. googeln.

A n l a g e zur meteorologischen Erläuterung:

“Die Bauernregel vom Siebenschläfer“

So ist auch ein kausaler Zusammenhang nicht gesichert, wenn ein warmer Sommer

auf einen kalten Winter folgt, oder umgekehrt. In der überwiegenden Zahl der Fälle

passiert das nämlich nicht.

Gleichermaßen gibt es für entsprechende Jahreszeiten-Prognosen weiterhin kein

wissenschaftlich abgesichertes Verfahren.