Ganz offensichtlich wird die Wirkung des anthropogenen Treibhauseffekts weit überschätzt, denn insbesondere der CO2-Treibhauseffekt war im wesentlichem schon zu Zeiten Goethes ausgereizt. Dies zeigen eigene quantitative Untersuchungen der IR-Absorption von Kohlendioxid mittels eines FT-IR-Spektrometers. Außerdem gibt es Äußerungen hierzu in der anerkannten Literatur, die offiziell allerdings heruntergespielt werden (23). Wegen des weitgehenden Sättigungseffekts ist der anthropogene Anteil der Treibhausgase für die gegenwärtige Klimaänderung von untergeordneter Bedeutung. Vielmehr geht die Varianz der Erdoberflächentemperatur mit der Wolkenbedeckung einher, die wiederum von der Fluktuation des solaren Magnetfelds abhängt. Mit anderen Worten: ähnlich wie ein offenes Kaminfeuers durch einen Paravent mehr oder weniger abgeschirmt wird, so steuert die Wolkendichte die Erdoberflächentemperatur weit stärker als der Treibhauseffekt. Der Einfluss der Wolkenbedeckung lässt sich aber mit den Klimamodellen des IPCC nur äußerst unzulänglich abbilden. Auch sind Klimamodelle möglicherweise auch deshalb ein spektroskopisches Artefakt, weil sie mit gewillkürten Flusskorrekturen arbeiten müssen, deren Beträge den des anthropogenen Treibhauseffekts um ein Vielfaches übersteigen.

Einleitung

Oftmals wird fälschlicherweise angenommen, der Treibhauseffekt sei mit der Absorption von Infrarotstrahlung (IR-Strahlung) durch atmosphärische Spurengase (CO2, CH4, Wasserdampf u. a.) identisch. Dadurch würde sich die Luft erwärmen, die dann ihre Wärmeenergie auf die Erdoberfläche übertrage. Es verhält sich genau umgekehrt: Die Erdoberfläche wird fast ausschließlich durch Bestrahlung erwärmt und die Atmosphäre nimmt ihre Wärmeenergie durch direkten Kontakt mit dem Erdboden auf.

Die Bestrahlung der Erdoberfläche setzt sich aber aus zwei Teilen zusammen:

1. Die direkte Solareinstrahlung (abhängig von der Wolkenbedeckung)

2. Der atmosphärische Treibhauseffekt (im wesentlichem ausgereizt)

Die Existenz einer atmosphärischen Gegenstrahlung, die den Treibhauseffekt charakterisiert, lässt sich zwar leicht nachweisen, aber bereits die Größenordnung des natürlichen Treibhauseffekts kann nur berechnet werden und die ihm zugeschriebene Auswirkung auf das Klima entzieht sich vollkommen der Falsifikation (18). Zum Verständnis des CO2-Treibhauseffekts ist es dennoch nützlich, sich zunächst einmal die „ganz normale“ Infrarot-Absorption atmosphärischer Spurengases zu betrachten (1).

Nimmt man einmal an, die auf der IR-Absorption beruhende Extinktion (E) würde innerhalb der Troposphäre (bis ca. 10 km Höhe) bei heutiger CO2-Konzentration in der Größenordnung von E = 2 im Maximum des Absorptionspeaks liegen, d.h. die Transmission T = I/I0 = 10-E wäre auf 0,01 reduziert, dann wäre es für jeden, der mit den Grundlagen der quantitativen IR-Spektroskopie vertraut ist, offensichtlich, dass eine Verdopplung des CO2 zu einer merklichenTemperaturerhöhung führen müsste. Tatsächlich liegt aber die Extinktion um viele Zehnerpotenzen höher. Deshalb ist nach einer einfachen Abschätzung von Jack Barrett (2) der maximal mögliche Treibhauseffekt schon nach einem Weg von 100 m über dem Erdboden erreicht. Tatsächlich liegt eine weitestgehende Sättigung aber keine Komplettsättigung vor. Die gibt es nicht aus quantenmechanischen Gründen.

In der Literatur werden vielfach Emissionsspektren (3) oder gelegentlich auch Absorptionsspektren (4) des CO2 gezeigt. Was einen Chemiker aber besonders interessiert, ist eine Abschätzung der Sättigung des Effekts mit Hilfe molarer Extinktionskoeffizienten der einzelnen Absorptionsbanden. CO2 ist zwar das mit am intensivsten untersuchte Molekül, weshalb man auch genügend quantitative Angaben aus der Literatur beziehen kann und natürlich gibt es die HITRAN-Spektren (5). Dennoch existieren offensichtlich unterschiedliche Vorstellungen. Auch unterliegt die prophezeite Klimaerwärmung großen Schwankungen, wobei in der Vergangenheit Angaben von 1,2 °C bis 11,5 °C bei CO2-Verdopplung genannt wurden. Dies war Anlass zu eigenen überschlagsmäßigen Messungen (6).

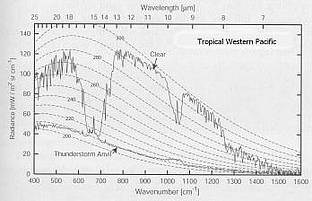

Zunächst muss aber geklärt werden, welche der Absorptions-/Emissionsbande des CO2 von Bedeutung ist. Hierüber geben Satellitenspektren Auskunft (3).

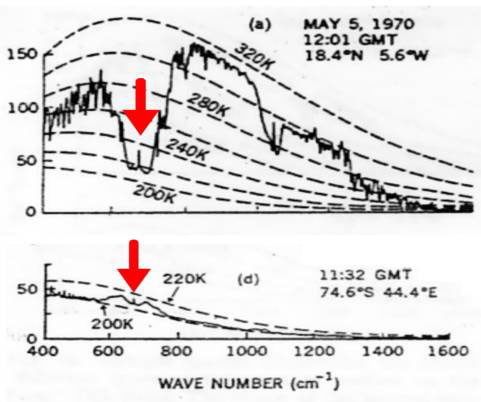

Bild 1: Satellitenspektren, oben über der Sahara, unten über der Antarktis

Die gestrichelten Linien im Bild 1 ist die ideale Planck-Strahlungskurve der Erdoberfläche berechnet bei unterschiedlichen Temperaturen in K. Die „gezackte Linien“ repräsentieren neben der ungehinderten Emission der Erdoberfläche (ca. 800 – 1000 cm-1 und ca. 1050 – 1300 cm-1) die Emissionsgraphen der atmosphärischen Treibhausgase. Die roten Pfeile im Bild 1 kennzeichnen die n2-Bande um 15 mm (667 cm-1). Deshalb ist nur diese relativ schwache von Bedeutung und nicht die wesentlich stärkere n3-Bande um 4,2 mm (2349 cm-1). Außerdem erkennt man, die Atmosphäre emittiert tatsächlich IR-Strahlung („Treibhauseffekt“) Dies sieht man ganz deutlich im Satellitenspektrum über der Arktis (unterer Teil im Bild 1). Die Bodentemperatur beträgt dort nämlich ca. 200 K (-73 °C), während die Atmosphäre in etwa 10 km Höhe eine höhere Temperatur von ca. 210 K (-63 °C) aufweist. Dies ist aber ein erster Hinweis darauf, dass der den IPCC-Computermodellen zugrunde liegende Strahlungstransport eine Fiktion ist. Es handelt sich vielmehr um einenEnergietransport. Dabei gelangt wärmere Luft zur Arktis und gibt ihre Energie oberhalb einer Höhe von 10 km als „ungestörte Emission“ ins Weltall ab.

1. Die Meßmethode

Zunächst soll die eigene Messung der Absorption des Kohlendioxids beschrieben werden. Eine 10 cm-Küvette mit IR-durchlässigem Fenster wurde mit synthetischer CO2-freier und wasserfreier Luft gefüllt. Danach wurde soviel CO2 mit einer Mikroliterspritze zugegeben, dass 357 ppm CO2 zugegen waren (Konzentration von 1993). Weiter wurden 2,6 % Wasserdampf zugegeben. Als IR-Strahlungsquelle diente ein Globar, ein elektrisch auf 1000-1200 ºC geheizter Siliziumkarbid-Stab mit nachgeschaltetem variablen Interferenzfilter. Nach der Aufnahme dieses Spektrums wurde mit CO2 aufgestockt, so dass 714 ppm enthalten waren. Die Messung erfolgte mit einem FT-IR-Spektrometer „Bruker IFS 48“. Als Auswertungssoftware diente das Programm OPUS. Ein Nullwert wurde ebenfalls aufgenommen und entsprechend subtrahiert.

1.1 Messung und Auswertung

Bild 2 zeigt das unbearbeitete Spektrum der 15 µm-Bande für 357 ppm CO2 und 2.6% H2O.

Bild 2: Unbearbeitetes Spektrum der 15 µm-Bande (n2-Bande)

Deutlich sind der R- (DJ = + 1) und der P- (DJ = – 1) sowie der Q-Zweig (DJ = +/- 0) der n2-Bande zu erkennen. Der Extinktionskoeffizient im Maximum ergab sich zu:

e = 20,2 m2 mol-1 (n2 bei 667 cm-1)

Um die Absorption zu berechnen, wurde der durchschnittliche CO2-Gehalt der Atmosphäre mit c = 1,03.10-3 mol/m3angenommen (aus der Gesamtstoffmenge und dem Volumen der Homosphäre). Setzt man die oben gemessenen molaren Extinktionen nebst der Konzentration und der Schichtdicke der Troposphäre (h = 10 km = 104 m) in das Lambert-Beer’sche-Gesetz ein, so erhält man

E(n2) = 20,2 m2 mol-1 × 1,03.10-3 mol/m3 × 104 m = 208

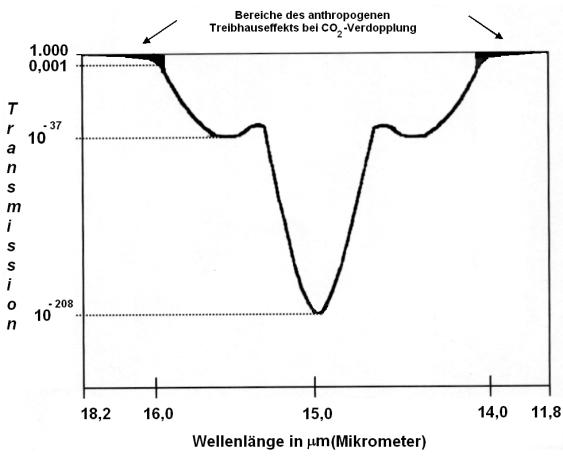

Dies bedeutet, dass die Transmissionen in der Mitte der Absorptionsbande bei den um 1997 gegebenen 357 ppm CO2 beiT(n2) = 10-208 liegt (Bild 3).

Bild 3: Spektrales Auswertungsschema

Dies ist ein extrem geringer Transmissionswert, der eine Steigerung des Treibhauseffektes bei Verdopplung des klimawirksamen Spurengases in diesem Bereich vollkommen ausschließt. Ähnliche Ergebnisse hat Jack Barrett anhand spektroskopischer und kinetischer Überlegungen (2) gefunden und damit prompt in ein Wespennest gestochen, weshalb 1995 von ihm eine äußerst heftige Diskussion angefacht wurde (7 – 10).

Setzt man den molaren Extinktionskoeffizient e für die n2-Bande sowie die Volumenkonzentration in mol/m3 (357 ppm CO2) in das Lambert-Beersche-Gesetz ein und nimmt eine Schichtdicke von 10 m an, resultiert eine Extinktion von

E = 20,2 m2 mol-1 × 0,0159 mol/m3× 10 m = 3,21

Dies entspricht einer Transmission von T = 10-3.21 = 0,6 Promille. Mit anderen Worten: Bereits nach 10 m sind 1 – T = 99,94% der IR-Strahlung absorbiert.

Bei der Absorption an den Peakflanken ist die Extinktion naturgemäß kleiner. Deshalb schreibt das IPCC1990 „The effect of added carbon dioxide molecules is, however, significant at the edges of the 15 µm band, and in particular around 13,7 and 16 µm (13)“. Natürlich existieren diese Ränder, denn die Rotationsquantenzahl J geht von J = + 1 bis J = + ¥ und vonJ = – 1 bis J = – ¥. Bedauerlicherweise werden aber die ungesättigten Bereiche an den Rändern immer schwächer. Die Besetzung der Rotationsniveaus gehorcht nämlich einer Boltzmann-Verteilung, weshalb immer weniger der vorliegenden CO2-Moleküle zu einem gegebenen Zeitpunkt in diesem Bereich absorbieren.

Um die Absorption an den Peakflanken abzuschätzen, wurde als Arbeitshypothese angenommen, die Extinktion soll sich bei Verdopplung des CO2-Gehalts um die Größenordnung E = 3 (T = 10-3) erhöhen. Hierzu wurde das Gesamtintegral der Banden bis zu den auslaufenden Enden des R- und P-Zweiges bei E = 0 ermittelt (s. Bild. 3). Anschließend wurden die digital abgespeicherten Spektren ab einer Extinktion, die dem Wert E = 3 (auf den Gesamtweg innerhalb der Troposphäre bezogen) entsprachen bis zu den auslaufenden Enden (E = 0) des R- und P-Zweiges integriert. Damit waren die „edges„ annähernd erfasst. Diese „edges„ begannen beim P-Zweig bei 14,00 µm und beim R-Zweig bei 15,80 µm und liefen jeweils bis zur Grundlinie E = 0. IPCC lässt die Banden an den Rändern bei 13,7 und 16 µm beginnen (13). Für die n2-Bande ergab sich folgendes:

| 15 µm-Bande |

357 ppm |

714 ppm |

| Gesamtintegral 624,04 cm -1 von 703,84 cm -1 |

0,5171/cm |

1,4678/cm |

| Summe der Flanken-Integrale |

1,11.10-4/cm |

9,79.10-4/cm |

Tabelle: 15 µm-Bande (Gesamtintegral und Flankenintegrale E = 0 bis E = 3)

Der relative Zuwachs des Treibhauseffekts bezogen auf das Gesamtintegral ist entscheidend. Er entspricht der Differenz der Flankenintegrale bei 714 ppm und 357 ppm im Verhältnis zum Gesamtintegral bei 357 ppm.

(9,79.10-4/cm – 1.11.10-4/cm) / 0,5171/cm = 0,17 %

Weil man mit der Planck-Strahlungsgleichung arbeiten muss, sind Extinktionen weniger geeignet, den Treibhauseffekt zu quantifizieren, dennoch zeigen sie sehr gut die Relationen, um die es beim anthropogenen Treibhauseffekt geht (Bild 3). Auch sind die oben angegebenen Messwerte relativ ungenau; sie werden aber durch die Aussage des Nobelpreisträges Paul Crutzen gestützt. Dieser schrieb1993 in einem Lehrbuch (20): „Es gibt bereits so viel CO2 in der Atmosphäre, dass in vielen Spektralbereichen die Aufnahme durch CO2 fast vollständig ist, und zusätzliches CO2 spielt keine große Rolle mehr.“ Man kann es auch so ausdrücken: Ein Treibhaus heizt sich bestenfalls geringfügig (Spureneffekt!) stärker auf, wenn man das normale Fensterglas gegen ein zehn Zentimeter dickes Panzerglas austauscht!

2. Vergleich mit den offiziellen Daten des IPCC

Das zur Messung verwendete und in der Chemie übliche FT-IR-Spektrometer besitzt nur einen Spiegelweg von 5 cm. Dies ergibt eine Auflösung der IR-Banden von 0,2 cm-1. Da die „ungesättigten“ Spektralbereiche ungewöhnlich schwache IR-Banden betrifft, benötigt man Spektrometer, die eine Auflösung von 0,0004 cm-1 erbringen (5). Hierzu muss man ein FT-IR-Spektrometer bauen, das theoretisch über einen Spiegelweg von 25.000 cm (25 m!) verfügt. Nur dann lassen sich dieäußerst schwachen IR-Banden messen, auf die sich die Klimamodellierer des IPCC stützen. Es sind Banden, mit einer „Absorptionsstärke“ von nur 0,05 % der 15 mm CO2-Hauptbande! Da Spiegelwege von 25 m technisch schwierig realisierbar sind, misst man reines CO2 unter höheren Druck und mit käuflichen Geräten, die über Spiegelwege bis zu 10 m verfügen. Die derart gewonnenen Extinktionskoeffizienten sind in der HITRAN-Datenbank abgelegt, welche zur Berechnung des Strahlungsantriebs („radiative forcing“) bei weiterer Steigerung der Treibhausgase (CO2, CH4 usw.) dient. Nimmt man die offiziellen Zahlen (IPCC), dann beträgt der „natürliche“ Treibhauseffekt“ 324 W/m2 (21). Bei Verdopplung des CO2 (100 % Steigerung!) wird nach Übereinkunft („best guess“ aus Computermodellrechnungen) angenommen, dass sich der Strahlungsantrieb um 3,7 W/m2 erhöht (22, 23). Im Bild 4 sind die Verhältnisse dargestellt.

Bild 4: Prozentuale Erhöhung des Treibhauseffekts bei Verdopplung des atmosphärischen CO2-Gehalts gemäß der offiziellen Angaben des IPCC

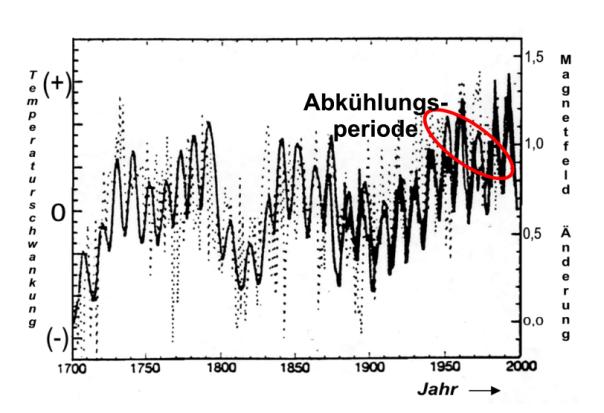

Auch das Bild 4 belegt eindeutig die oben beschriebene weitestgehende Sättigung denn die Steigerung des Treibhauseffekts bei CO2-Verdopplung beträgt nur geringfügige 1,2 %. Dies ist in der Klimaforschung bekannt. Deshalb wird versucht, den „Sättigungscharakter mit dem Argument zu entkräften, das Klima sei ein so empfindliches System, dass es bereits von kleinsten Änderungen des Strahlungsantriebs aus dem Gleichgewicht gebracht werden kann. So wird behauptet, die Abkühlung zwischen 1930 und 1970 sei durch die Staubbelastung der Industriegesellschaft verursacht. Dies ist falsch. Die Abkühlung war durch das geänderte Magnetfeld der Sonne verursacht, wie aus dem Bild 11 (rot eingekreist) hervorgeht.

3. Erdoberflächentemperatur, Treibhauseffekt und CO2-Konzentration

Zur Berechnung der irdischen Oberflächentemperatur ohne Treibhausgasatmosphäre benutzt man eine einfache Gleichung, die auf dem Stefan-Boltzmann- Gesetz beruht.

|

(Gleichung 1)

A ist dabei die Albedo – das durchschnittliche „Rückstrahlvermögen“ der Erde. Sie wird mit A= 0,3 angenommen. Tatsächlich existierten in der Vergangenheit auch andere Angaben. Die Solarkonstante, die in Wirklichkeit gar nicht so konstant ist, hat den Wert Fs = 1368 W/m2. Weiterhin enthält die Gleichung die Stefan-Boltzmann-Konstante s = 5,67 .10-8 W.m-2.K-4.

Rechnet man mit diesen Angaben, so resultiert für die Oberflächentemperatur der Erde:

|

Dieses Ergebnis ist fragwürdig, weil die Erde kein wasserloser Gesteinshaufen im Weltall ist. Sehr wahrscheinlich liegt die irdische Mitteltemperatur ohne Treibhausgase um einiges höher! Aber bleibt man zunächst einmal dabei, dann beträgt die spezifische Ausstrahlung der Erdoberfläche bei dieser Temperatur (Formelzeichen M nach DIN 5031, Teil 1):

M1 = (1-0,7) . 0,25 . 1368 W/m2 = 239 W/m2

Für die Klimanormalperiode bezeichnet, hat man sich vor Jahren unter Konsensbildung auf eine Mitteltemperatur von + 15 °C (T = 288 K) geeinigt. Benutzt man jetzt das „unveränderte“ Stefan-Boltzmann-Gesetz

M2 = s . T4 (Gleichung 2)

und berechnet damit die spezifische Ausstrahlung der Eroberfläche erneut, resultiert:

M2 = s . T4 = 5,67 . 10-8 W.m-2.K-4 . (288 K)4 = 390,0 W.m-2

Folglich erhöht der „natürliche“ Treibhauseffekt, mit einer hypothetische Erwärmung von DT = 288 K – 225 K = 33 K(33 °C), die spezifische Ausstrahlung der Erdoberfläche um

DM = M2 – M1 = 390,0 W/m2 – 239,0 W/m2 = 151 W/m2

Wie bereits oben erläutert, wird bei Verdopplung des CO2 (100 %ige Steigerung) ein zusätzlicher Strahlungsantrieb von 3,7 W.m-2 angenommen (die Größenordnung entzieht sich der Falsifikation und beruht auf Konsens – „best guess“!). Dadurch steigt die spezifische Ausstrahlung der Eroberfläche von 390,0 W.m-2 auf 393,7 W.m-2. Setzt man diesen Wert in die Stefan-Boltzmann-Gleichung (Gleichung 2) ein, resultiert als Erdoberflächentemperatur:

|

Demnach erhöht sich die Temperatur bei CO2-Verdopplung (100 % mehr CO2!) von 288,0 K auf 288,7 K. Das entspricht gerade einmal DT = 288,7 K – 288,0 K = 0,7 K (0,7 °C) und nicht mehr. Die Klimamodellierung hätte keinerlei politische Beachtung gefunden, wenn man nicht die Hypothese der Wasserdampfverstärkung in die Diskussion eingebracht hätte. Dies lässt sich jedoch glücklicherweise falsifizieren, wie im nächsten Absatz dargelegt wird.

4. Die Wasserdampfverstärkung

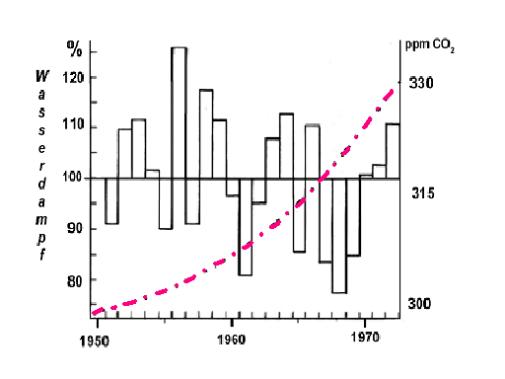

Da eine Erwärmung von lediglich 0,7 °C bei 100 % mehr CO2 zu wenig erscheint, hat man sich vor Jahren darauf geeinigt, dass diese geringfügige Temperaturerhöhung gemäß der altbekannten Clausius-Clapeyronschen-Gleichungdeutlich mehr Wasser aus den Ozeanen verdunsten lasse. Da Wasserdampf selbst ein Treibhausgas sei, fällt dadurch die von CO2 verursachte Temperaturerhöhung wesentlich höher aus. Originalton IPCC (24): „Der Wasserdampf-Feedback’ ist nach wie vor der durchweg wichtigste Rückkopplungseffekt, der die von den allgemeinen Zirkulationsmodellen als Reaktion auf eine CO2-Verdopplung vorhergesagte globale Erwärmung verursacht.“ Wenn dies richtig ist, muss besonders in einer kälteren Periode, während der die direkte Solarstrahlung nicht so viel Wasser verdunsten lässt, der Wasserdampfgehalt über den Ozeanen mit dem atmosphärischen CO2-Gehalt ansteigen. Dies ist eindeutig nicht der Fall, wie das Bild 5 belegt (31). Deshalb können sich die Klimamodellierer auf keinen Fall auf den durchaus einleuchtenden, hypothetischen Wasserdampfverstärkungsmechanismus berufen, der eine viel zu große Temperatursteigerung prophezeit.

Bild 5: Prozentuale Abweichung des Wasserdampfgehalts über dem Atlantik (33)

Um Missverständnissen vorzubeugen: Mit der Prozentangabe im Bild 5 ist natürlich nicht die relative Luftfeuchte gemeint, die niemals höher als 100 % sein kann, sondern vielmehr die Abweichung des Wasserdampfgehalts nach oben und nach unten um den Messwert von 1950. So liegt der absolute Wasserdampfgehalt 1956 um 25 % höher als 1950. 1968 liegt der Wasserdampfgehalt um ca. 45 % niedriger, obwohl der CO2-Gehalt weiter angestiegen ist!

5. Die Strahlungstransportgleichung

Bei der Berechnung des Treibhauseffekts wird ein „Schicht- oder Kaskadenmodell“ zugrunde gelegt nach dem innerhalb der Atmosphäre eine ständige Absorption (I) und Emission (L) stattfindet. Diesem fiktiven Strahlungstransport liegt dieSchwarzschildgleichung zugrunde (11). Bei einem infinitesimalen Weg dz, dem Absorptionskoeffizienten sa und der Teilchenzahl n gilt hierfür im lokalen thermodynamischen Strahlungsgleichgewicht (LTE):

(Gleichung 3)

Die Größe L ist hierbei die Strahldichte (vgl. DIN 5031, Teil 1), welche die Emission gemäß der temperaturabhängigenPlanck-Strahlungsgleichung angibt.

Dass innerhalb der Atmosphäre ein Strahlungstransport stattfindet, meint man belegen zu können, indem man die gemessenen Satellitenspektren mit den berechneten vergleicht. Das Ergebnis ist verblüffend, wie das Bild 6 belegt.

Bild 6: Links das gemessene Emissionsspektrum der Erde (Satellitenspektrum); rechts das mit Hilfe der Strahlungstransportgleichung berechnete Emissionsspektrum

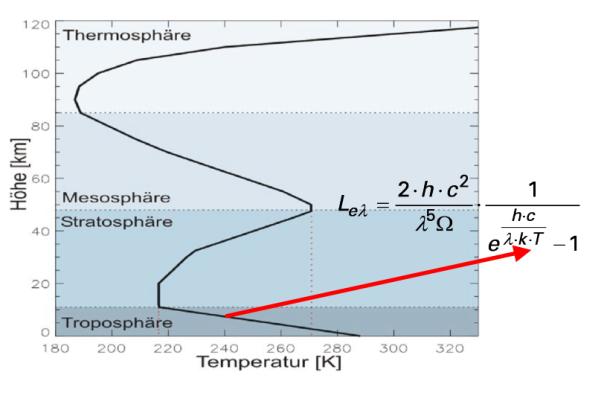

Das lokale thermodynamische Strahlungsgleichgewicht (LTE) begründet man mit dem Kirchhoff’schen Gesetz der Wärmestrahlung. Danach ist das Emissionsvermögen eines Körpers genau so groß wie sein Absorptionsvermögen. Das Ganze hat nur einen Haken. Es existiert kein „Strahlungsenergieerhaltungssatz“, wie er beim lokalen thermodynamischen Strahlungsgleichgewicht stillschweigend vorausgesetzt wird. Tatsächlich gibt man bei der „nachvollziehenden“ Berechnung der Satellitenspektren das gemessene atmosphärische Temperaturprofil in die Plank-Strahlungsgleichung ein, wie aus dem Bild 7 hervorgeht.

Bild 7: Strahlungstransport, Planck-Gleichung und gemessener Temperaturgradient

Zur Erinnerung: Beim Treibhauseffekt geht es auch um den Temperaturgradienten ( „Temperaturprofil“), den die Atmosphäre im Kontakt mit dem Erdboden unter adiabatischer Expansion annimmt. Lässt man sich dies durch den Kopf gehen, dann wird das Ergebnis – der Temperaturgradient – in die Rechnung eingesetzt (vgl. Bild 7), um dann daraus das temperaturabhängige Emissionsspektrum der Atmosphäre und des Erdkörpers zu erhalten (vgl. auch Bild 1). Deshalb ist die Übereinstimmung der im Bild 6 gezeigten Spektren kein Beweis für das dem Strahlungstransport zugrunde liegende hypothetische „lokale thermodynamische Strahlungsgleichgewicht“ innerhalb der Atmosphäre. Es ist vielmehr ein Beweis, dass man im Kreis herumrechnet und sich dann über den mathematisch „bewiesenen“ Treibhauseffekt freut.

Experimentelle Untersuchungen und die allgemein akzeptierte Theorie belegen eindeutig, dass die Molekülfluoreszenz anders funktioniert wie die Atomfluoreszenz, bei der die absorbierte Strahlung zu 100 % wieder emittiert wird (25, 26). Das LTE setzt aber eine „100%ige Molekülfluoreszenz“ voraus, die nicht existiert – auch nicht im IR-Bereich. Während angeregte Atome nur unter Emission von Strahlung in den Grundzustand zurückkehren können, erfolgt die Relaxation bei Molekülen wegen der Rotations- und Schwingungsfreiheitsgrade meist strahlungslos gemäß den Prinzipien des Jablonski-Diagramms (27). Deshalb reichte es eigentlich vollkommen aus, wenn man den „theoretischen“ Treibhauseffekt ohne jegliche Absorption nur mit der – temperaturabhängigen – Planck-Gleichung beschreibt, die man mit den jeweiligen Bandenstärken „klimawirksamer“ Spurengase und der „Anzahl IR-aktiver Moleküle in einem Luftvolumen“ multipliziert. Dann erhält man die thermische Emission der Atmosphäre unter Berücksichtigung des Raumwinkels.

Fazit: Dass eine atmosphärische Wärmestrahlung gemäß dem Planck-Gesetz gegeben ist, ist eine Selbstverständlichkeit. Solange aber ein atmosphärisches Temperaturprofil (oben kälter – unten wärmer) existiert und die Konvektion erheblich zum Energietransport beiträgt, solange ist die Hypothese in dem offenen System Atmosphäre existiere ein lokales thermodynamischen Gleichgewichts (LTE) falsch. Denn es gibt nämlich keinen „Strahlungsenergieerhaltungssatz“. Vielmehr übertragen „Treibhausgasmoleküle“ nach der Absorption von IR-Strahlung ihre Energie auf die nicht IR-aktiven Hauptbestandteile des Atmosphäre. Deshalb wird dem Strahlungsgeschehen bei der Klimamodellierung ein viel zu starkes Gewicht beigemessen.

6. Was Klimamodelle nicht können

Klimamodelle sind Computeralgorithmen (sprich: „Rechenvorschriften“, welche die meinungsabhängigen Vorgaben der Programmierung widerspiegeln) und nicht die Realität. Weil die Komplexität des Klimageschehens gegenwärtig und auch in absehbarer Zukunft mit keinem Computer realitätsorientiert erfassbar sein dürfte, handelt es sich mehr um politische Instrumentarien, denn um exakte Naturwissenschaft.

6. 1 Die Flusskorrekturen

Der Hypothese nach soll der „natürliche“ Treibeffekt den Globus um 33 °C aufheizen. Irrigerweise wird dabei angenommen, die Erde, die zu 70 % mit Wasser bedeckt ist, würde sich ähnlich verhalten wie der vollkommen wasserloseMond. Nimmt man an, nur die ersten 10 m Wassertiefe der Ozeane würden die mittlere Erdtemperatur thermostatisch regeln, ergibt die Rechnung, dass die Ozeane im Temperaturbereich von –18 °C bis +15 °C eine Energiemenge von 1,57.1018 MJ speichern. Hierzu die Gegenrechnung: In 24 Stunden werden durch den irdischen Treibhauseffekt 1,43.1016MJ umgeschlagen (22). Der gesamte natürliche Treibhauseffekt macht somit nur 0,9 % der Energie aus, die in den Ozeanen bei einer Wassertiefe bis zu 10 m gespeichert ist. Die Folge sind erhebliche Schwierigkeiten bei der Kopplung atmosphärischer Zirkulationsmodelle („General Circulation Atmospheric Models“) mit ozeanischen Zirkulationsmodellen („General Circulation Oceanic Models“). Diese Probleme lassen sich nur mit Hilfe so genannter „Flusskorrekturen“ überwinden, deren Beträge, wie das Bild 8 belegt, um ein Vielfaches größer sind als der anthropogene Treibhauseffekt. Die rechte Säule in Bild 8 stellt den Strahlungsantrieb des CO2 bei Verdopplung dar. Danach ist allein schon die 100 W/m2-Flusskorrektur zur Kopplung Ozeanoberfläche-Atmosphäre rund 27-mal (!) größer als der anthropogene Treibhauseffekt bei CO2-Verdopplung (3,7 W/m2).

Bild 8: Anthropogener Treibhauseffekt (rechte kleine Säule) im Verhältnis zu den bei der Klimamodellierung angewandten Flusskorrekturen

Es soll nicht unerwähnt bleiben, dass von einschlägigen Instituten in neuerer Zeit verlautbart wird, man benötige keine Flusskorrekturen mehr. Tatsächlich kommen Klimamodelle nach wie vor nicht ohne sie aus.

6. 2 Die Wolkendichte

Bei der Abschätzung des Strahlungsantriebs der Wolken kommen Klimamodelle zu äußerst unterschiedlichen Ergebnissen. So findet das „Bureau of Meteorology Research Center“ (BMRC) von Australien, dass die Wolken eine Abkühlung von ca. 1 W/m2 erbringen, während das Labaratoire de Météologie Dynamic (LMD) aus Frankreich meint, Wolken würden eine Erwärmung von ca. 1,7 W/m2 bewirken (Bild 9). Das ist beachtenswert!

Bild 9: Strahlungsantrieb der Wolken mit unterschiedlichen Klimamodellen gerechnet

6. 3 Die Vergangenheit

Beispielsweise können bis heute Klimamodelle nicht die im Bild 10 gezeigte Abkühlung zwischen 1930 und 1975 ohne Zuhilfenahme von Kunstgriffen (atmosphärischer Staubeintrag durch die Industriegesellschaft!) nachvollziehen.

Bild 10: CO2-Gehalt und Temperaturverlauf (vgl. a. Bild 11)

7. Die Alternative

Da treibhausgasfixierte Computer-Klimamodelle nicht nur im Zeitraum zwischen 1930 bis 1970 versagen sondern auch die kleine Eiszeit (14. bis 18. Jh.) und das mittelalterliche Klimaoptimum (11. – 13. Jh.) nicht nachbilden können, muss es einen anderen entscheidenden Mechanismus geben. Sehr viel spricht dafür, dass dies die Wolkendichte ist, die von der kosmischen Strahlung beeinflusst wird. Diese besteht überwiegend aus Protonen, die als Echo des Urknalls in unser Sonnensystem eindringen. Gelangen diese positiv geladenen Kernbausteine in die Atmosphäre, so führen sie über einen noch nicht restlos geklärten Mechanismus zur Kondensation von Wasserdampf – Wolken entstehen. Erhöht sich dasMagnetfeld der Sonne bei höherer Solaraktivität, dann werden die Protonen stärker abgeschirmt. In der Folge entstehenweniger Wolken und die erwärmende Sonnenstrahlung kann den Globus stärker aufheizen. Deshalb folgt der globale Temperaturverlauf der Schwankung des solaren Magnetfelds (Bild 11).

Bild 11: Solares Magnetfeld und Globaltemperatur (abgewandelt nach 28)

Wie Messungen zeigen, war im übrigen die Solaraktivität seit dem Jahr 850 noch nie so hoch wie nach 1940 (29). Auch im Wärmehaushalt der Weltmeere macht sich die wolkenbedeckungsabhängige Schwankung der solaren Einstrahlung stärker bemerkbar. Somit dürfte der anthropogene Treibhauseffekt eine kleine, aufgesetzte Größe auf einer natürlichen Klimaschwankung sein.

Abgesehen davon erscheint die unter Punkt 3 vorgerechnete Temperatur von – 18 °C, welche die Erde ohne Treibhausgase angeblich hätte, viel zu niedrig angesetzt sein. Sie entspricht aber der offiziellen Doktrin, die – und das muss betont werden – eine Hypothese ist. Weil, wie bereits hervorgehoben, die Erde kein wasserloser Gesteinshaufen im Weltall ist, sondern zu 70 % mit Wasser bedeckt ist, muss die direkte Absorption im nahen Infrarotgebiet (NIR) und die sehr verzögerte Strahlungsemission von Ozeanwasser stärker berücksichtigt werden.

<hug/img height=“303″ width=“444″ v:shapes=“_x0000_s1057″ src=“Hug/image034.gif“>

</hug/img>

Bild 12: Wolkenbedeckung (Wolkendichte) und globale Temperatur

Aus dem Bild 12 geht hervor, dass sich die globale Wolkenbedeckung zwischen 1986 und 2000 von 69 % auf 65 % reduzierte (linke Ordinate, „fallend“ aufgetragen). Parallel hierzu stieg die globale Mitteltemperatur (rechte Ordinate, „steigend“ aufgetragen).

Während die Temperaturschwankungen in der Sahara im Tagesverlauf ohne weiteres bis zu 50 °C betragen können, verhalten sich Meere wesentlich träger. Der Gesamtwärmeumsatz (Wärmeenergie nicht Wärmeleistung!) eines Meeres ist die Summe vieler Größen:

Qges = (QS – QA) – QK – QV – QT + QC + QE + QF + QR

QS = im Meer absorbierte Sonnen- und Himmelsstrahlung (= „Treibhauseffekt“)

QA = effektive Ausstrahlung

QK = „fühlbarer“ Wärmeübergang Luft-Wasser

QV = latenter Wärmeübergang Luft-Wasser (Verdunstung, Kondensation)

QT = Wärmetransport durch Strömung

QC = chemisch-biologische Prozesse

QE = Wärmezufuhr aus dem Erdinnern

QF = Reibungswärme

QR = radioaktiver Zerfall

Da die Speicherfähigkeit des Wassers erheblich über der von Gesteinen liegt, ist es ausgeschlossen, dass sich die Erde bei einer Trägheit des Systems Wasser-Luft nachts schlagartig um 50 °C herunterkühlen. Denn insbesondere die Abstrahlungsleistung dQA/dt unterscheidet sich wegen der wesentlich höheren Wärmespeicherungsfähigkeit von Meerwasser deutlich von jener der Sahara. Gemäß der Stefan-Boltzmann-Gleichung (Gleichung 2) hängt nämlich die spezifische Ausstrahlung der Erdoberfläche mit der Temperatur unmittelbar zusammen. Je höher die letztere ist, desto größer ist auch die Abstrahlung.

Aus der obigen Aufzählung geht aber hervor, dass der Energiegehalt des Meerwassers auch auf der Wärmezufuhr aus dem Erdinnern, auf chemisch-biologischen Prozessen, auf radioaktiven Zerfall und auf Reibungswärme beruht. Die Größe QF (Reibungswärme) in der obigen Aufzählung hängt von der Windgeschwindigkeit ab. Wie H. Volz auf einer Tagung der Bayerischen Akademie der Wissenschaften berichtete, differiert die spezifischen Ausstrahlung bei den Windstärken 0 und 7 in einer Größenordnung von DM = 11,1 W/m2 (30). Die Ein- und Ausstrahlungsbilanz geht aber von einer ruhenden See aus. Addiert man diese Größe zur spezifischen Ausstrahlung bei 15 °C, so erhält man:

M = 239,0 W/m2 + 11,1 W/m2 = 250,1 W/m2

Eingesetzt in die Gleichung 2 resultiert für die Temperatur T = 257,7 K (- 15,3 °C). Diese Temperatur liegt um 2,7 °C höher, als die besagten – 18 °C. Die Treibhausgase erhöhen dann die Mitteltemperatur nicht um 33 °C sondern „nur“ um 30,3 °C, insofern die These richtig ist, die „normale“ Mitteltemperatur der Erde beträgt + 15 °C. Wie hoch war diese eigentlich während des mittelalterlichen Klimaoptimums (11. – 13. Jh. ) und während der „kleinen Eiszeit“ (14. bis 18. Jh)?

Ein weiteres kommt hinzu. Etwa 50 % der Sonneneinstrahlung, die den Erdboden erreicht, ist Wärmestrahlung (nahes und mittleres IR). Diese wird vom Meerwasser absorbiert. Die strahlungsfixierte Treibhausgastheorie saldiert nur die Einstrahlung und Ausstrahlung im Tagesverlauf als könnten sich die Weltmeere auf der Nachtsseite schlagartig auf – 18 °C abkühlen. Die Trägheit der Ozeane ist aber mit einer Relaxationszeit bis zu 200 Jahren sehr hoch. Folglich dürfte die mittlere globale Gleichgewichtstemperatur der Ozeane ohne atmosphärische Treibhausgase eher um + 4 °C (Wasser höchster Dichte am Grunde eines zugefrorenen Gewässers) denn bei – 18 °C liegen. Als ich vor einiger Zeit einmal mit einem ehemaligen Leiter eines Klimarechenzentrums korrespondierte und ihn fragte, wie hoch die irdische Mitteltemperatur ohne Ozeane anzusetzen sei aber mit dem gegenwärtigen atmosphärischen Treibhausgasgehalt, erhielt ich zur Antwort, dies sei eine interessante Frage, die man aber bislang nicht durchgerechnet habe.

Zusammenfassung

· Der anthropogene Treibhauseffekt ist im wesentlichem ausgereizt, wie die Messung der Transmission von IR-Strahlung belegt. Eine globale Klimakatastrophe ist daher selbst bei einer CO2-Verdoppelung nicht zu erwarten.

· Die Steigerung des Treibhauseffekt um 1,2 % bei 100 % mehr CO2 ist eine Bagatelle, die man nur mit Hilfe des Wasserdampfverstärkungsmechanismus vergrößern kann.

· Zweifellos enthält die Atmosphäre gemäß der Clausius-Clapeyronschen-Gleichung mehr Wasserdampf, wenn es wärmer wird. Jedoch lässt sich der hypothetische Wasserdampfverstärkungsmechanismus, ohne den Klimamodelle nicht zu einem merklichen Temperaturanstieg kommen, in der Realität nicht nachzuweisen. Weil sich somit der atmosphärische Wasserdampfgehalt nicht an der Konzentration der Treibhausgase orientiert, erhöht sich die globale Mitteltemperatur bei 100 % mehr CO2 in der Atmosphäre bestenfalls um 0,7 K (0,7 °C).

· Computerklimamodelle kommen u. a. deshalb zu falschen Ergebnissen, weil der hypothetische Wasserdampfverstärkungsmechanismus vollkommen überwertet wird.

· Der atmosphärische Temperaturgradient beruht auf einem Energietransport und nicht auf einem Strahlungstransportmechanismus mit dem fiktiven LTE. Deshalb wird der atmosphärischen Rückstrahlung – dem Treibhauseffekt – eine zu große Bedeutung zugemessen.

· Klimamodelle müssen mit – gewillkürten – Flusskorrekturen arbeiten, deren Größenordnung den des anthropogenen Treibhauseffekts um ein Vielfaches übertreffen. Im anderen Fall „hat (man) als Modellierer … die Wahl, entweder ohne Flusskorrektur mit einem unrealistischen Klimazustand zu operieren, oder die Flusskorrektur mit ihren Schwächen zu akzeptieren, dafür aber ein realistisches Klima zu erhalten.“(32)

· Die Abbildung des Klimas in der Vergangenheit mit Computeralgorithmen gelingt nicht ohne massive Korrekturgrößen.

· Die globale Mitteltemperatur ohne Treibhauseffekt dürfte um einiges höher als bei 255 K (-18 °C) liegen.

· Das Klima wird hängt stärker von der Variation der Wolkenbedeckung ab als vom Gehalt atmosphärischer Treibhausgase.

· Das IPCC ist eine politische Organisation, die sich eines Wissenschaftlergremiums bedient, um volkspädagogische Lernziele durchzusetzen.

Abschließend möchte ich die Leser darauf aufmerksam machen, dass dem gegenwärtigen CO2-Gehalt je nach Literaturstelle ein unterschiedlicher Temperatureffekt zugeordnet wird. In dem von von J.T. Houghton herausgegebenen Buch „The Global Climate“ geben Kondratjew und Moskalenko 7,2 K an (14). Die Autoren zitieren sich dabei selbst (15). Besorgt man sich das in Kyrillisch geschriebene Buch und schaut auf der angegebenen Seite nach, so landet man im Sachwortverzeichnisses. Auch die weitere Suche in dem Buch bringt kein Ergebnis. Andererseits scheint man sich doch recht sicher zu sein, denn die Angaben der Autoren werden gerne zitiert (16). Allerdings gibt es Widersprüche, denn K.P. Shine gibt einen anderen Wert an, nämlich 12 K (17) und R. Lindzen (18) geht davon aus, dass dem CO2 nur etwa 5% des natürlichen Treibhauseffekts zuzuordnen sind. Das wären 1,65 K und damit weniger als ein Viertel des bei IPCC benutzten Werts von 7,2 K.

Literatur

[1] R. Revelle, Scientific American, 247, No.2, Aug. 1982, 33-41

[2] J. Barrett, Spectrochim. Acta Part A, 51, 415 (1995)

[3] R.A. Hanel et al. Journal of Geophysical Research, 77, 2629-2641 (1972)

[4] H. Flohn, Nachr. Chem.Tech.Lab, 32, 305-309 (1984)

[5] L.S.Rothman et al., Appl.Opt. 26, 4058 (1987)

[6] H. Hug, Chemische Rundschau, 20. Febr., p. 9 (1998)

[7] P. S. Braterman, Spectrochim. Acta Part A, 52, 1565 (1996)

[8] K. Shine, Spectrochim. Acta Part A, 51, 1393 (1995)

[9] J. Houghton, Spectrochim. Acta Part A, 51, 1391 (1995)

[10] R. S. Courtney, Spectrochim. Acta Part A, 53, 1601 (1997)

[11] R. P. Wayne, Chemistry of Atmospheres, Oxford University Press,

2nd. Edition, 44-49 (1991),

[12] Murry L. Salby, Fundamentals of Atmospheric Physics, Academic Press, 198-257 (1996)

[13] Climate Change 1990. The IPCC Scientific Assessment, p. 49

[14] K.Ya. Kondratyev, N.I. Moskalenko in J.T.Houghton, The Global Climate, Cambridge

Universitiy Press, 225-233 (1984)

[15] K.Ya. Kondratyev,N.I. Moskalenko, Thermal Emission of Planets, Gidrometeoizdat,

263 pp (1977) (Russisch)

[16] C.D. Schönwiese, Klimaänderungen, Springer-Verlag Berlin Heidelberg, p. 135 (1995)

[17] K. P. Shine, A. Sinha, Nature 354, 382 (1991)

[18] R. S. Lindzen, Proc. Nat. Acad. of Sciences, 94, 8335 (1997)

[19] R. Raschke, R. Hollman, Strahlungsübertragung in der Atmosphäre, Modellierung und Messung, Preprint zum CO2-Kolloquium der DECHEMA in Frankfurt/Main am 11.10.2001

[20] T. E. Graedel, Paul J. Crutzen, Chemie der Atmosphäre, Spektrum Akademischer Verlag, Heidelberg, Berlin, Oxford 1993, S. 414

[21] IPCC, Climate Change 2001, Chap. 1.2.1 Natural Forcing of the Climate System

[22] J. T. Kiehl, K. E. Trendberth, Bull. Amer. Meteor. Soc., 78 (1997) 197

Heinz Hug, Wiesbaden Juni 2007

Den Aufsatz können Sie auch als pdf Datei aus dem Anhang herunterladen

Related Files