Update: Solarforscher befürchten Beginn einer kleinen Eiszeit innerhalb der nächsten 10 Jahre! hier und hier

“If we are right, this could be the last solar maximum we’ll see for a few decades,” Hill said. “That would affect everything from space exploration to Earth’s climate.”

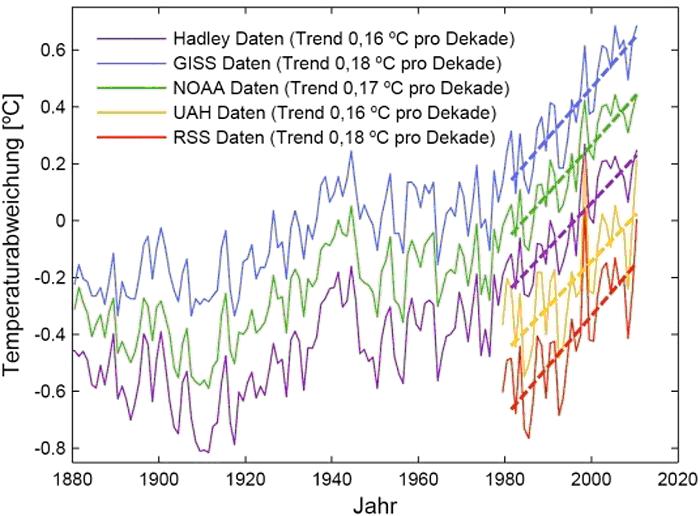

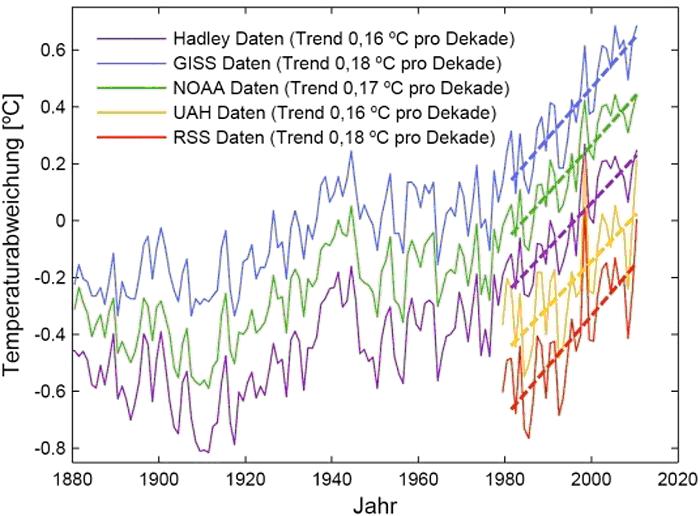

Prof. Rahmstorf untermauerte dann seine These mit fünf Temperaturdatenreihen (Abbildung 1), die des Hadley Centers, GISS, NOAA, UAH und RSS. Bei den beiden letztgenannten handelt es sich um Satellitenmessungen, von denen allgemein angenommen wird, sie seien korrekt.

Aber dazu später. Über die ersten drei, braucht seit Climategate nichts mehr gesagt zu werden. EIKE berichtete vielfach darüber. Sie sind durch Weglassen von kälteren Stationen verfälscht. Hier dazu ein Beispiel aus den USA, wie mit manipulierten Daten Temperaturwerte in die Höhe getrieben werden/wurden.

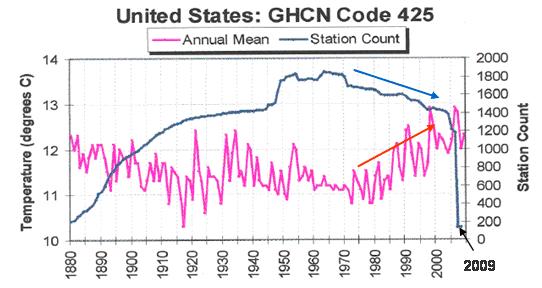

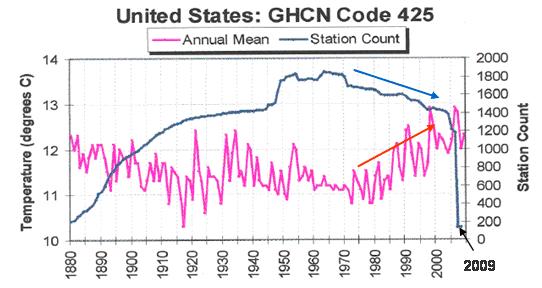

Abbildung 2 zeigt die Temperaturwerte für die USA des GHCN (Global History Climate Network – stellt die globalen Temperaturreihen zusammen, an denen sich GISS und NOAA anlehnt). Rot ist die Temperatur und blau die Anzahl der Messstationen. Ab 1880 erhöhte sich die Anzahl der Messstationen von ca. 200 auf ca. 1.800, wobei die neuen Stationen größtenteils nicht mehr in den Städten (waren bereits gut versorgt), sondern in ländlichen und gebirgigen Gebieten aufgestellt wurden. Zwischen 1970 und 2005 wurden die Stationen auf ca. 1.200 reduziert und insbesondere die „unpassenden“ Stationen in ländlichen Gebieten ausgesondert, wodurch es zu einem deutlichen Anstieg der Temperaturen kam (blauer und roter Pfeil). In 2009 wurden die Stationen von ca. 1.200 auf unter 200 (136!) reduziert. Diese verbliebenen Stationen liegen alle in Städten oder auf Großflughäfen.

Wie der Wärmeinseleffekt (WI) und Großflughäfen die Temperatur verfälschen, hatte EIKE berichtet:

http://www.eike-klima-energie.eu/news-anzeige/der-waermeinseleffekt-wi-als-antrieb-der-temperaturen-eine-wertung-der-dwd-temperaturmessstationen/

und hier

http://www.eike-klima-energie.eu/news-anzeige/was-sind-temperaturmessungen-auf-grossflughaefen-wert-oder-wie-das-zdf-mit-bewusst-falschen-temperaturaussagen-die-oeffentlichkeit-taeuscht-und-die-abkuehlung-in-deutschland-verschleiert/

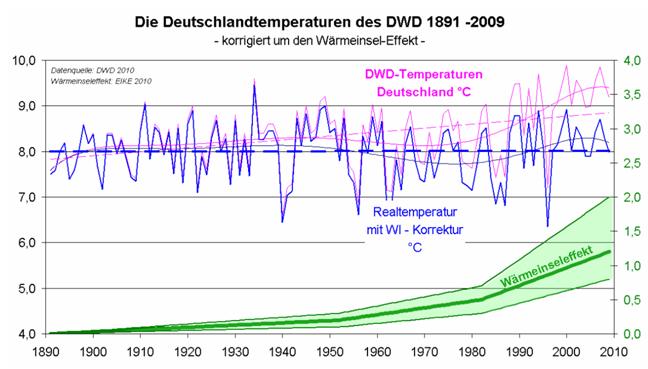

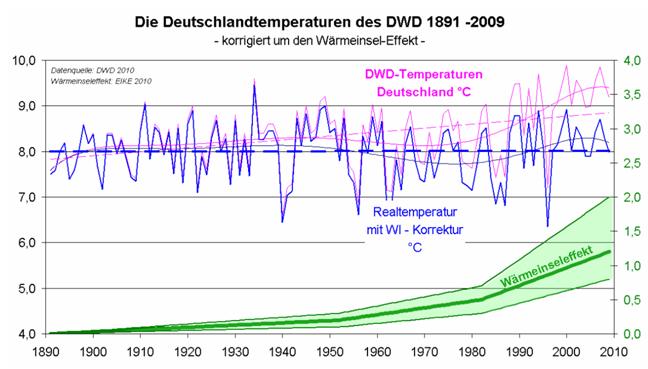

So ist denn auch in Deutschland in der von EIKE erstellten richtigen Vergleichskurve der Jahrestemperaturen von einer Erwärmung nichts zu sehen.

Abbildung 3 zeigt den unmittelbaren Vergleich der Deutschlandtemperaturen DWD und der WI-bereinigten von 1891 – 2009. Die blau gestrichelte Linie zeigt den Temperaturmittelwert im Betrachtungszeitraum. Die Temperaturen in Deutschland durchbrechen die Mittellinie nach unten, was bedeutet, dass es derzeit kälter als im 120-Jahresvergleich ist. Zum berechneten WI aus Abbildung 4, wurde, wie dies beim IPCC üblich ist, den Fehlertoleranzbereich angegeben (grüner Bereich).

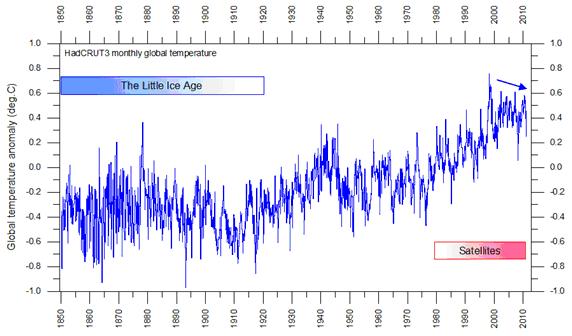

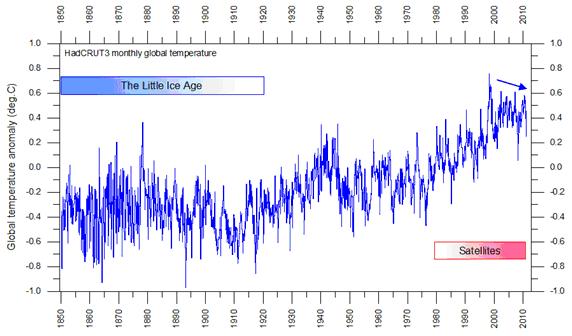

Doch Rahmstorf bezieht sich ja auf die globale Mitteltemperatur, bzw. deren Änderung. Aber auch die globalen Temperaturreihen zeigen nicht nach oben, sondern nach unten – es wird kälter.

Abbildung 4 zeigt die Temperaturreihe des Hadley Centers, Quelle, (http://www.climate4you.com/GlobalTemperatures.htm) von 1850 – 2010. Wie unschwer zu erkennen, fällt seit Beginn des Jahrhunderts die Temperatur. Erwärmung leider: Fehlanzeige.

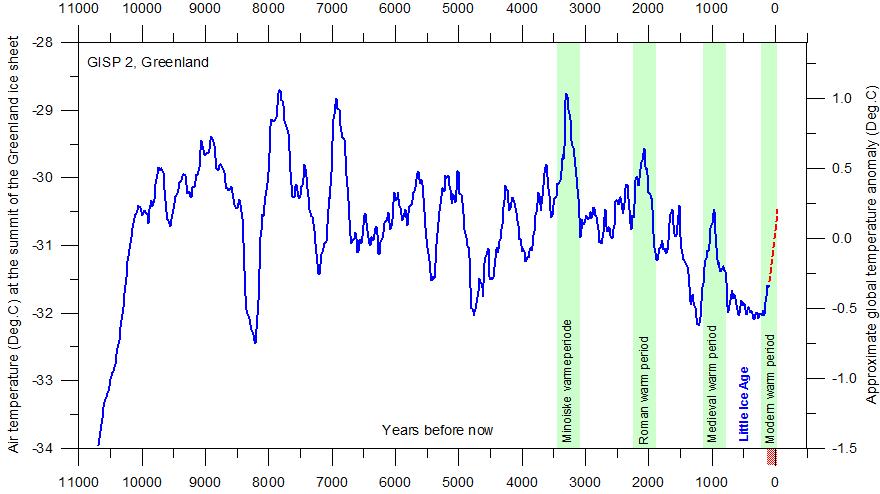

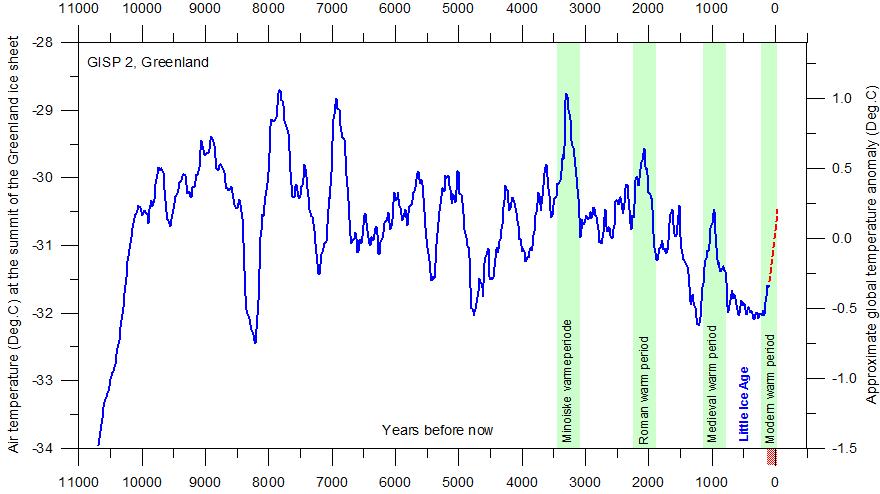

Inwieweit wir uns heute, wie die Temperaturreihen von Prof. Rahmstorf in seinem Artikel suggerieren sollen, in einer außergewöhnlichen Erwärmungsphase befinden, zeigt unbestechlich ein Blick in die Vergangenheit.

Abbildung 5 zeigt die Temperaturreihe seit der letzten Eiszeit (rot, gemessene Werte). Die heutigen Temperaturen sind vergleichsweise niedrig. Auch der Anstieg ist nichts Außergewöhnliches, Quelle, wie oben.

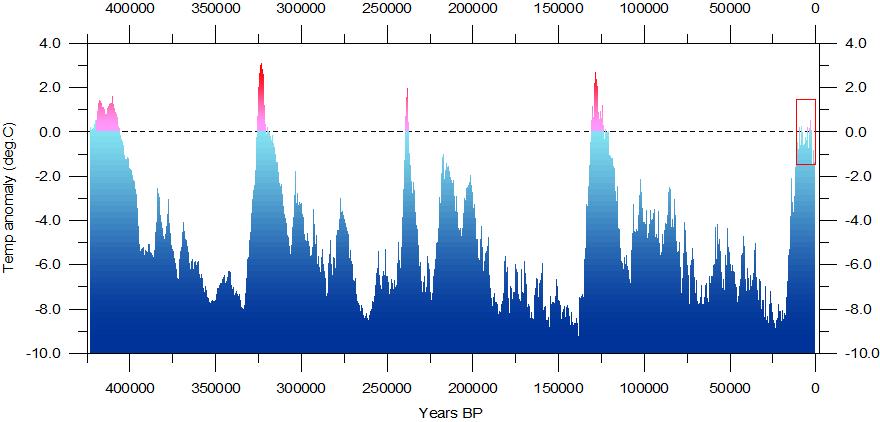

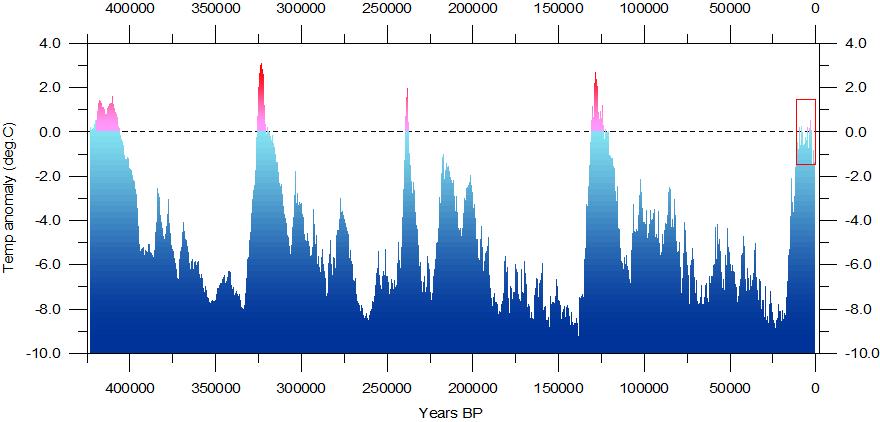

Das gleiche Bild ergibt sich, wenn noch weiter in die Vergangenheit der Blick gerichtet wird.

Abbildung 6 zeigt die Temperaturschwankungen der letzten 450.000 Jahre. Zum einen sind die Temperaturschwankungen zyklisch und zum anderen ist das heutige Niveau vergleichsweise niedrig! Quelle, wie oben.

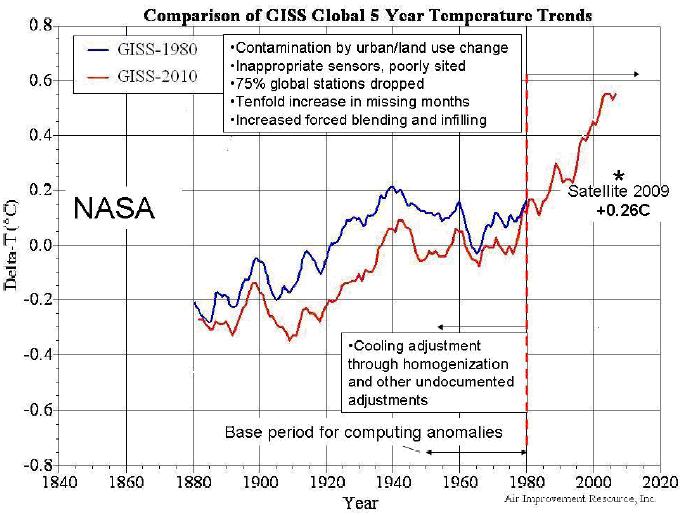

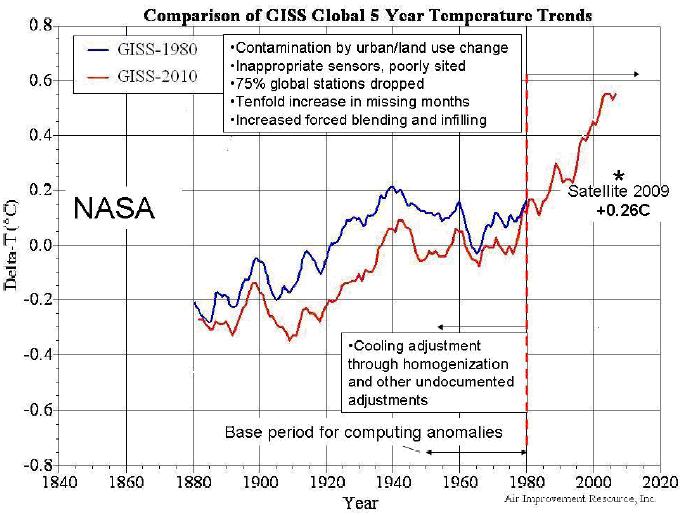

Prof. Rahmstorf bezieht sich u.a. auf die berüchtigte GISS-Temperaturkurve. Hier ein kleines Beispiel, wie die GISS unter seinem Direktor, dem, spätestens seit Climategate, ins Gerede (Kohlezüge sind „Todeszüge“) geratenen Prof. James Hansen, Temperaturreihen, manipuliert werden.

Abbildung 7 (Quelle: http://icecap.us/images/uploads/GHG_Model_failure_AO.pdf) zeigt die GISS-1980-Datenreihe (blau) und zum Vergleich, für exakt denselben Zeitraum, die GISS-Datenreihe 2010 (rot), in der auf wundersame Weise, der Temperaturverlauf gänzlich anders ist. Zum Vergleich ist die Abweichung der Satellitenmessungen (+0,26°C) für 2009 eingetragen.

Eingangs wurde erwähnt, dass Satellitenmessungen allgemein als verlässlich angesehen werden. Dies ist jedoch nicht so, wie die folgenden Zeilen zeigen.

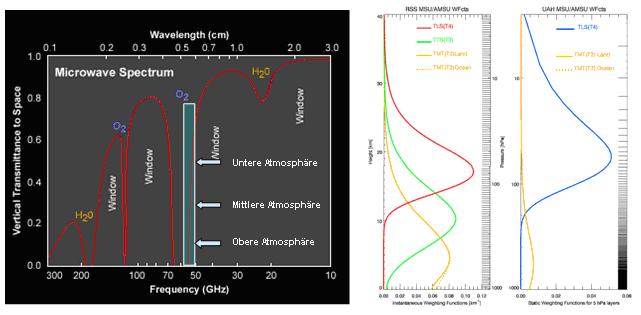

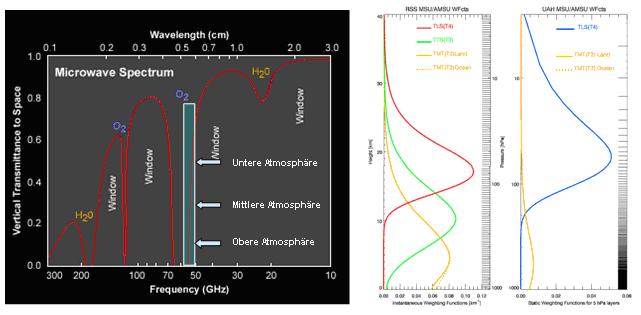

Die MSU-Messgeräte (Microwave Sounding Unit) auf Satelliten messen die Mikrowellenstrahlung von Sauerstoffmolekülen im Wellenlängenbereich von 0,5cm – 0,6cm (50,3GHz – 57,95GHz) in der Atmosphäre, deren Abhängigkeit (Strahlungsverteilung) von der Temperatur sehr genau und bekannt ist. Grundlage der Berechnung (auch hier, wie bei der bodengestützten Temperaturmittelwertbildung, werden die Temperaturen nicht direkt gemessen, sondern berechnet) ist die Strahlungsübertragungsgleichung, in Form der Schuster-Schwarzschild-Gleichung, in der die Plancksche Strahlungsformel unter der Annahme eines lokalen thermodynamischen Gleichgewichts als Quellfunktion dient und der Gewichtung der unterschiedlichen Satellitenkanäle, für die sog. mathematische Quellfunktionen (Gewichtsfunktionen) verwendet werden. MSU, der von der University of Alabama bereitgestellt wird und RSS (Remote Sensing Systems) basieren auf den selben Rohdaten (MSU-Radianzen), weisen aber teils unterschiedliche Werte aus. An der Beobachtung und Aufnahme der Daten sind immer mindestens 2 Satelliten beteiligt, deren Daten untereinander verglichen werden, um die Fehlertoleranzen einzugrenzen. MSU-Daten besitzen den großen Vorteil, dass mit ein und demselben Messgerät an allen Flächen der Erde gemessen wird und nicht an wenigen, ausgesuchten Stellen, wie dies bei Bodenmessungen der Fall ist.

Abbildung 8: MSU-Daten werden seit 1979 aufgenommen. Satelliten messen Strahlungsdichten! Links, Nimbus-Satellit aus der Anfangszeit der Satellitenbeobachtung und rechts, derzeitiger Aqua Satellit mit AMSU (Advanced Microwave Sounding Unit, der in 20 Kanälen misst) der NASA liefern täglich ca. 300.000 Messungen.

Die MSU-Messgeräte besitzen vier Kanäle, mit denen die Strahlungsverteilung und somit die Temperatur in verschiedenen vertikalen Profilen (Höhenbereichen) gemessen wird. Die Kanäle wurden dabei so gewählt, dass die Wolkenbedeckung keinen Einfluss auf das Messergebnis ausübt. Die Kanäle im Einzelnen sind:

- TLT = Temperature Lower Troposphere

- TMT = Temperature Middle Troposphere

- TTS = Temperature Troposphere / Stratosphere und

- TLS = Temperature Lower Stratosphere

TLT deckt die tiefe Troposphäre mit dem stärksten Gewicht bei 850 hPa (siehe Diagramm “Relative Weighting Function“). In diesem Höhenprofil tritt eine starke Beeinflussung der Bodenbeschaffenheit (Bodenstrahlung) auf (10% über Wasser, 25% über Land und 60% über Eis).

Da der Kanal sehr nahe am atmosphärischen Fenster liegt, bestehen die gemessenen Rohdaten nicht nur aus den Emissionen aus der Atmosphäre, sondern auch aus Bodenemissionen und Bodenreflexionen aufgrund der Flüsse von sensibler und latenter Wärme. Die Troposphäre wird mehr durch die Flüsse sensibler und latenter Wärme, als durch IR-Strahlung erwärmt, die insbesondere die unteren Schichten dominieren.

TMT repräsentiert die mittlere Troposphäre im Bereich zwischen 300 hPa und 850 hPa. Auch hier bedingt die Nähe zum atmosphärischen Fenster Beeinflussung durch Bodenemissionen. Etwa 10% der Rohdatenwerte stammen von Bodeneinflüssen. Wie beim TLT werden auch hier zum Datenabgleich Temperaturdaten von Bodenstationen benötigt. Satellitendaten werden also mit den Daten von Bodenstationen abgeglichen, sozusagen „geeicht“.

Sind diese Temperaturdaten zu hoch (falsch, siehe Climategate), so sind zwangsläufig, wenn auch weniger in der Höhe, die Temperaturdaten von Satelliten falsch, sprich, zu hoch! Aus diesem Grund sind auch die Trends gleich.

TTS umfasst den Übergangsbereich Troposphäre und Stratosphäre mit Schwerpunkt bei 220 hPa (ca. 10 km-Höhe). Daten liegen seit 1987 vor.

TLS deckt den Atmosphärenbereich zwischen 90 hPa und 150 hPa in der Stratosphäre ab. Wie aus der “Relative Weighting Function“ hervorgeht, liegt seine Gewichtung bei 90 hPa. In dieser Höhe sind sowohl die Tag/Nacht-Unterschiede, als auch die Land/Meer-Unterschiede zu vernachlässigen, als auch der Einfluss der Bodenemissionen auf die Rohdaten.

Abbildung 9: Um den gemessenen Strahlungswerten eine Temperatur in den verschiedenen Schichtdicken zuordnen zu können, wird neben der Strahlungsübertragungsgleichung, eine Gewichts- oder Quellfunktion benötigt. Diese Gewichtsfunktion ordnet den Hauptdurckflächen Gewichte zu, wie die Abbildung 8 für die vier MSU-Kanäle zeigt. Die Gewichtsfunktion ist dabei die Ableitung des optischen Weges, der Transmission nach der Höhe und beschreibt, welche vertikale Schicht den größten Beitrag an den gemessenen Rohdaten besitzt. Unter der Annahme, dass die Verteilung des Sauerstoffgehalts in der Atmosphäre genau bekannt ist, so ist auch über die Kenntnis des optischen Weges die Transmission bekannt.

Die Abbildung 9 zeigt, dass die Kanäle TTS und TLS nicht von Bodenemissionen beeinflusst werden. Mittlere und vor allem tiefe Troposphäre haben dagegen unterschiedliche Gewichtsfunktionen über der jeweiligen Höhe.

Abbildung 10 links zeigt das Emissionsspektrum der Erde im Wellenlängenbereich von 0,1 – 3 cm. Dazu die Absorptionen/Emissionen von Sauerstoff und Wasserdampf. Im Frequenzbereich von 50,3 – 57,95 GHz liegt der Messbereich der MSU-Kanäle. Die Messbereiche, die für die untere und mittlere Atmosphäre relevant sind, liegen nahe dem atmosphärischen Fenster und werden somit von Emissionen des Bodens beeinflusst.

Abbildung 10 rechts, Quelle: Uni Graz, “Monitoring des Klimawandels mit Satellitenmethoden“, zeigt die unterschiedlichen Gewichtsfunktionen von RSS und UAH, die einen Grund für die unterschiedlichen Temperaturwerte der beiden Datenreihen darstellen.

Auch Satellitendaten, denen eine hohe Richtigkeit zugebilligt wird, sind von den Landmessungen abhängig. Sind diese zu hoch, siehe Climategate, können die Satellitendaten nicht richtig sein, sondern sind ebenfalls zu hoch.

Aber der Autor möchte mit Herrn Prof. Dr. Rahmstorf nicht zu hart ins Gericht gehen, da es in der Tat eine menchen-gemachte Erwärmung gibt, wenn sich diese auch lediglich auf die Messsationen bezieht. Anbei für unsere Leser zwei Beispiele der menschen-gemachten Erwärmung.

Abbildung 11 zeigt die Temperaturmessstation auf dem Flughafen von Rom und dessen Lage zum Rollfeld, Quelle: Watts up with that.

Abbildung 12 (http://www.albwetter.de/Wetterstationsbilder.htm) zeigt die Wetterstation auf dem Frankfurter Flughafen. Sie liegt nicht nur sehr nah am Rollfeld (ca. 70m), sondern in direkter Richtung zu den Abgasstrahlen der Jets, wie in der rechten Abbildung zu sehen. Das Bild erinnert frappierend an die Zustände auf dem Flughafen Rom, wie von Prof. Watts gezeigt.

Abbildung 13 zeigt die Lage der DWD-Wetterstation auf dem Flughafengelände (roter Pfeil). Sie wird von den startenden und landenden Jets von deren heißen Triebwerksabgasen direkt getroffen.

Prof. Dr. Rahmstorf, sowie seine Kollegen vom PIK sollten sich lieber etwas mehr mit handfester Wissenschaft, als mit Zukunftsforschung beschäftigen, möchte man ihnen zurufen. Mit 5-Jahresplänen hat die Menschheit bekanntermaßen keine guten Erfahrungen gemacht. Mit 50-Jahresplänen sieht es ganz sicher nicht besser, sondern nur schlechter aus. Wie auch immer, beide haben mit Wissenschaft nichts zu tun. Stattdessen versucht sich Rahmstorf als Hütchenspieler und bot dem von ihm direkt angegriffenen Prof. Fritz Vahrenholt eine Wette an.

Ich möchte Herrn Vahrenholt daher hiermit eine Klimawette vorschlagen. Das vergangene Jahrzehnt (2000 – 2009) war das wärmste seit Beginn der Temperaturmessungen, wahrscheinlich sogar seit mindestens 2000 Jahren. Wenn das angelaufene Jahrzehnt (2010 – 2019) global kühler ausfallen sollte, dann spende ich ein Monatsgehalt an einen gemeinnützigen Zweck seiner Wahl – wenn es wärmer ausfällt als das letzte, dann spendet er ein Monatsgehalt an eine gute Sache meiner Wahl.

Dieser mochte sich dem Vorschlag nicht anschließen und antwortete unter der Überschrift ebenfalls in der SZ: „Ich stehe für Hütchenspiele nicht zur Verfügung“.

Recht hat er, sollte man hinzufügen. Darüber wetten nur Spieler oder eben Klimafolgenforscher. Auch EIKE hat einen offiziellen Widerspruch an die SZ geschickt, dieser wurde aber mit fadenscheinigen Begründung nicht veröffentlicht. Wir holen das demnächst nach.

Raimund Leistenschneider – EIKE, unter Mitarbeit von M. Limburg EIKE