Smart Grid und dezentralisierte Stromerzeugung: Ein flüchtiger Blick auf eine ferne Zukunft

Ist es das richtige Gleis, 1. die Kapazität des Netzes zu erhöhen und neue Übertragungswege einzuführen, um die Integration von Wind- und Solarenergie in brauchbarem Umfang vorzubereiten, oder 2. Smart Meters zu implementieren, um die Versorgung aus dieser schwankenden und unzuverlässigen Quelle zu regeln (sprich zu begrenzen)?

Absolut nicht! Solche unklugen Initiativen werden eine unakzeptabel hohe Investition in die Elemente des Grids erfordern, die nur zu schnell irrelevant werden dürften, wenn die erforderlichen Änderungen der Strominfrastruktur in der Zukunft konstruiert und eingeführt werden.

Aber erste Dinge zuerst: Was bedeuten die Begriffe Dezentralisierte Erzeugung (DG) und Smart Grid?

Dezentralisierte Stromerzeugung (Distributed Generation DG)

Eines der vordergründigen Ziele der DG ist es, eine gewisse Ebene des lokalen Stromverbrauchs zu erreichen und nicht, diesen Strom in das Netz einzuspeisen. Das Aufzwingen eines bestimmten Niveaus Erneuerbarer Energien (RES) und von Einspeisetarifen mit Vorzugspreisen, um die Entwicklung der Wind- und Solartechnik voranzutreiben, wird für Letzteres zu einem „Goldrausch“ führen. Die Stromerzeugung durch Wind und Sonne im großindustriellen Maßstab ist ähnlich der traditionellen Erzeugung, in denen der Strombedarf in großen Gebieten gedeckt wird, und im Falle von Solar- und Windenergie häufig über weite Entfernungen. Der Strom wird geographisch verteilt, und das ist ein Element der Differenzierung von konventionellen Quellen der Stromerzeugung. Aber dies ist so wegen der weit verteilten Treibstoffe sowie Sonnenlicht und Wind.

Die korrekte Darstellung von DG enthält die kleinräumige Stromerzeugung, zum Beispiel durch Solarpaneele auf den Dächern und eventuell Mikrowindturbinen (bessere Designs sind möglich) ebenso wie viele andere kleinräumige Erzeugungsmöglichkeiten, und diese Liste kann ziemlich lang sein. Diese werden in Mikronetze integriert, die selbständig die lokale Produktion steuern, ebenso wie die Speicherung (was auf diesem Niveau auch heute schon möglich ist und in Zukunft vielversprechend aussieht) sowie den Verbrauch und die Verbindung zum Netz über intelligente Leitungen. Mikronetze können viele Arten von „Gemeinden“ bedienen, zum Beispiel Wohngebiete (vor allem in ländlichen Gebieten), eine Kombination von kommerziellen/industriellen/privaten Gemeinschaften und Universitäten. Mit solchen „Konzepten“ wird bereits experimentiert, zum Beispiel an der University of California, San Diego (UCSD). Die Konzepte schließen eine Kombination mit einem Heiz- und Stromsystem mittels Gasturbinen sowie solaren Technologien und Brennstoffzellen ein, die hier beschrieben werden, sowie Elektroautos, beschrieben hier. Ein Zitat von Byron Washom, dem Direktor der Strategischen Energieinitiativen auf dem Campus ist angemessen:

„Die USCD wird zu einem Laboratorium werden, in dem Technologien getestet werden sowie das Verhalten der Verbraucher analysiert werden kann”.

Man ignoriere den Hype in den o. g. Beispielen, aber applaudiere dem Versuch, sich den beschriebenen Entwicklungen anzunähern, wie sie von Washom auf den Punkt gebracht worden sind.

Werden die “smart” meters, die heute schon installiert werden, mit den smart grids kompatibel sein, die erst noch entworfen und entwickelt werden müssen? Das ist unwahrscheinlich und birgt das Potential hoher unnützer Kosten, was künftige Generationen belasten dürfte. Heutzutage scheint die Hauptaufgabe der smart meters darin zu bestehen, ein Mittel zur Erhöhung der Stromraten zu sein, und zwar durch eine aggressive Preisgestaltung von Tag zu Tag. Damit sollen die erforderlichen großen Investitionen gedeckt werden, vor allem für Windfarmen samt deren zu ihrer Unterstützung erforderlichen Verteilungs- und Erzeugungsmöglichkeiten.

Das Smart Grid

In einer Broschüre des Department of Energy (DOE) werden kurzfristige Initiativen, wie sie im zweiten Abschnitt oben beschrieben werden, als das „intelligentere“ Netz bezeichnet und sollen den Weg zum „smart“ grid ebnen. Sogar ohne jedes Wissen über die involvierten Probleme wird jeder, dem unglaubwürdige Versprechen bekannt sind, die in manchen Werbungen nur zu offensichtlich sind, die Warnzeichen erkennen. Hier folgt ein Auszug aus dem Papier des DOE über Initiativen zum „smarter“ grid (Hervorhebung von mir):

- Verbesserung der Zuverlässigkeit auf ein Niveau, wie es zuvor noch nie möglich war

- Verbesserung der Bezahlbarkeit

- Stärkung unserer globalen Wettbewerbsfähigkeit

- Vollständige Verbindung von erneuerbaren und herkömmlichen Energiequellen

- Potentielle Reduzierung unseres Kohlenstoff-Fußabdrucks (interessanter Aspekt)

- Einführung von Fortschritten und einer Effizienz, die man noch entwerfen muss.

Mehr Informationen hierzu und über die Warnungen der North American Electric Reliability Corporation (NERC) wurden vor Kurzem hier beschrieben.

In Wirklichkeit weiß kein Mensch, wie die smart grids schließlich aussehen werden. Sie repräsentieren eine grundlegende Verschiebung der Infrastruktur unserer elektrischen Energie, die notwendigerweise lange brauchen wird, bis sie sich auswirkt, teilweise auch deshalb, weil sie zu sozialen Auswirkungen bei jeder dieser Umstrukturierungen führen wird. Wie schon erwähnt, ist es sinnvoll, als Zeitrahmen zur Verwirklichung dieser Pläne aus diesen Gründen sowie aus Gründen der Entwicklung und des Preises vieler Technologien innerhalb einer solide konstruierten Architektur die zweite Hälfte des 21. Jahrhunderts anzunehmen.

Führt man sich dies vor Augen, ist die heute vorgenommene aggressive Einführung wahrscheinlich nur vorläufig und hat fragwürdige Motive. Ebenso weiß kein Mensch, wie der Transport, die Kommunikation, die Informationsprozesse, die Bildung, eine Weltregierung, die Gesundheitsvorsorge, die Erzeugung von Nahrungsmitteln und die städtische Entwicklung im gleichen Zeitrahmen aussehen. Effektive Änderungen in all diesen Komplexen sind evolutionärer und nicht revolutionärer Natur. Die Stromerzeugung und –verteilung ist genauso fundamental wie dies alles, und jemand, der dies in kurzer Zeit revolutionieren will, ist einfach desinformiert.

In einem Artikel in der Ausgabe der Zeitschrift Power Magazine im April 2011 [Original: 2021; vermutet wird ein Schreibfehler. A. d. Übers.] mit der Überschrift „Smart Grid und dezentrale Erzeugung: besser beides zusammen“ findet sich ein gut dargestellter Hintergrund für diese Entwicklungen. Unter den vielen dort genannten Details sind einige, die einen vernünftigen Rahmen für diese bedeutende Änderung der Infrastruktur beschreiben:

- Niemand weiß, wie die Smart Grids im Endeffekt aussehen. Daher sollten keine frühen und große Investitionen in die Entwicklung von Technologien gesteckt werden, bevor diese nicht besser verstanden sind.

- Eine der primären Funktionen von DG ist es, den lokalen Bedarf zu decken, und nicht die Einspeisung ins Netz.

- Wir sollten uns nicht durch Diskussionen über die teure Einführung von Konzepten ablenken lassen (d. h. in brauchbarem Umfang die Speicherung von Elektrizität, die großräumige Verbreitung von Elektromobilen), die erst in ferner Zukunft verwirklicht werden können.

- Eine grundlegende Entwicklung muss der Sicherheit des Internets gelten. Dazu empfiehlt es sich, 1. übereilte Implementationen zu vermeiden und 2. die Wichtigkeit der lokalen Natur der wahrscheinlichsten Struktur künftiger smart grids zu beachten, die einer netzweiten Einspeisung entgegen steht.

Link: http://www.masterresource.org/2011/04/the-smart-grid-and-dg/#more-14745

Übersetzt von Chris Frey für EIKE

Bemerkung des Übersetzers: Unterstrichen wird in diesem Beitrag die lokale Natur der sog. smart grids. Für die großräumige Stromerzeugung z. B. für energieintensive Unternehmen werden sie also nie taugen. Auch wird gründlich mit dem Aktionismus aufgeräumt, der vor allem hierzulande derzeit in dieser Hinsicht an den Tag gelegt wird.

Nur am Rande kurz gestreift wird die Möglichkeit irgendwelcher Institutionen, unseren Stromverbrauch und damit unser gesamtes Verhalten lückenlos zu überwachen. Hier gilt es, besonders wachsam zu sein!

C. F.

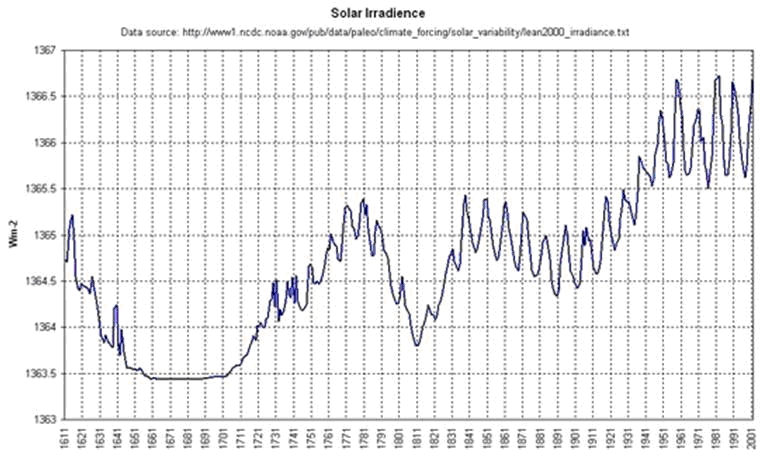

Feulner). Ein Abriss der wichtigsten Trendentwicklungen aus der Sicht des PIK. Die Diskussion im Anschluss war lebhaft. Herr Vahrenholt stellte den vorgetragenen Einfluss der solaren Aktivität – Herr Feulner stufte ihn mit 0,1 K als äußerst gering ein – in Frage. Er verwies auf neueste Untersuchungen von Shapiro (Shapiro et al 2011), wonach die TSI-Steigerung von der Kleinen Eiszeit bis heute möglicherweise 6 mal höher war als im AR4 angenommen. Verwiesen wurde auch auf ein in Januar 2010 erschienenen Paper von Solomon, wonach die Abkühlung der letzten 10 Jahre mit dem um 10 % verminderten Wasserdampf in der Stratosphäre in Zusammenhang gebracht wird.

Feulner). Ein Abriss der wichtigsten Trendentwicklungen aus der Sicht des PIK. Die Diskussion im Anschluss war lebhaft. Herr Vahrenholt stellte den vorgetragenen Einfluss der solaren Aktivität – Herr Feulner stufte ihn mit 0,1 K als äußerst gering ein – in Frage. Er verwies auf neueste Untersuchungen von Shapiro (Shapiro et al 2011), wonach die TSI-Steigerung von der Kleinen Eiszeit bis heute möglicherweise 6 mal höher war als im AR4 angenommen. Verwiesen wurde auch auf ein in Januar 2010 erschienenen Paper von Solomon, wonach die Abkühlung der letzten 10 Jahre mit dem um 10 % verminderten Wasserdampf in der Stratosphäre in Zusammenhang gebracht wird.