Aber wie auch immer, für die Suche nach Messfehlern bei der Ermittlung der Bodendaten scheint es eine gute Idee zu sein, die Datensätze der globalen Mitteltemperatur zur Hand zu haben, nur so als Referenz. Man weiß nie, wann diese zur Verfügung stehen.

Ich verfügte bereits [über die Datensätzen von] GISSTEMP 2007 und 2010 von der GISS-Website (2) sowie über die CRU-Daten 2005 als Download von der Site des Carbon Dioxide Information Analysis Center (CDIAC) (3). Aber frühere Daten zu erhalten erschien ebenfalls sinnvoll. Wie zu erwarten war, hat sich herausgestellt, dass diese interessante Eigenschaften haben.

Ich wollte die Datensätze so, wie sie veröffentlicht worden waren und habe sie deshalb direkt aus den veröffentlichten Graphiken digitalisiert: GISS 1984 (4), 1988 (5), 1996 (6) und 1999 (7), ferner CRU 1994 (8) und 2003 (9). Bei den Jahreszahlen handelt es sich um die Jahre der Veröffentlichung, daher enden die Datensätze ein oder zwei Jahre früher. In jedem Falle habe ich nur die ungeglätteten Daten digitalisiert, und jeder digitalisierte Punkt wurde in die Mitte des veröffentlichten Punktes gestellt. Unter Berücksichtigung der gewählten Auflösung der veröffentlichten Graphiken schätze ich die digitalisierte Präzision auf ± 0,002°C.

Eines der ersten Dinge, die ich fand, war etwas unerwartet – wie Jim Hansen 1988 vor dem Kongress aussagen konnte, dass er zu 99% sicher war, den menschlichen Fingerabdruck in der Klimaerwärmung zu sehen. Im Januar 1988 veröffentlichte er eine Studie über den Trend der globalen Temperatur an der Erdoberfläche (5), in der er die Normalisierung von 1951 bis 1980 eine 1-sigma globale Temperaturvariabilität von ± 0,13°C zeigte. Dies präsentierte er als die Grenzen der natürlichen Variabilität seit 1880 und sagte: „Falls eine Erwärmung um 3-sigma erreicht werden würde (d. h. 0,39°C – P), würde dies einen Trend nahe einem Vertrauenslevel von 99% Signifikanz repräsentieren“.

Er wurde ein wenig zweideutig in dieser Studie vom Januar, wiederholte aber die Abgrenzung in seiner Studie vom Juni 1988, in der er die Vorhersagen über einen „robusten“ 3-sigma-Antrieb aus dem GISS-Modell II (10) vorstellte. JH sagte weiter, dass „(eine persistente globale Erwärmung von) 0,4°C einen überzeugenden Beweis für die Beziehung von Ursache und Wirkung darstellen würde, d. h. eine „rauchende Kanone“ in der gegenwärtigen Umgangssprache“.

Der globale Anomalietrend von GISS 1996 zeigte, dass er sich im Jahre 1988 zügig der 3-sigma-Marke näherte, was sein Vertrauen gefestigt haben könnte. Aber die gesamte Basis für die 99%-Gewissheit, die Jim vor dem Kongress beschworen hatte, beruhte darauf, dass der Trend von 1951 bis 1980 als definitive Größe der natürlichen Variabilität für die letzten Jahrtausende des Klimas im Holozän stehen würde. Das können Sie nun selbst beurteilen, aber ich sehe das als wissenschaftlichen Blödsinn.

Wie auch immer, als ich nun alle Datensätze zur Hand hatte, schien es mir eine gute Idee, die früher veröffentlichten Trends mit den später veröffentlichten zu vergleichen. Sie würden diesen Artikel nicht lesen, wenn sich nicht interessante Dinge herausgestellt hätten. Hier kommen sie!

Eine unkritische Entdeckung war, dass die Anomalien von GISS 1987 zufällig mit einem positiven Abstand von 0,1°C von der Null-Linie geplottet worden waren. Ansonsten sind die Anomalien von 1987 identisch mit denen von GISS 1988. Beide Datensätze wurden auf das Mittel des Zeitraumes 1951 bis 1980 bezogen, so dass der Abstand von der Null-Linie nicht aufgrund von Normalisierungsverfahren zustande gekommen ist. Hansen und Lebedeff haben 1988 nichts zu dem Irrtum des Abstandes gesagt, den sie 1987 veröffentlicht hatten, und keines der beiden Studien hatte ein Korrigendum bis zum 1. Mai 2011. Vielleicht haben sich die Autoren gedacht, dass jeder das selbst herausfinden kann.

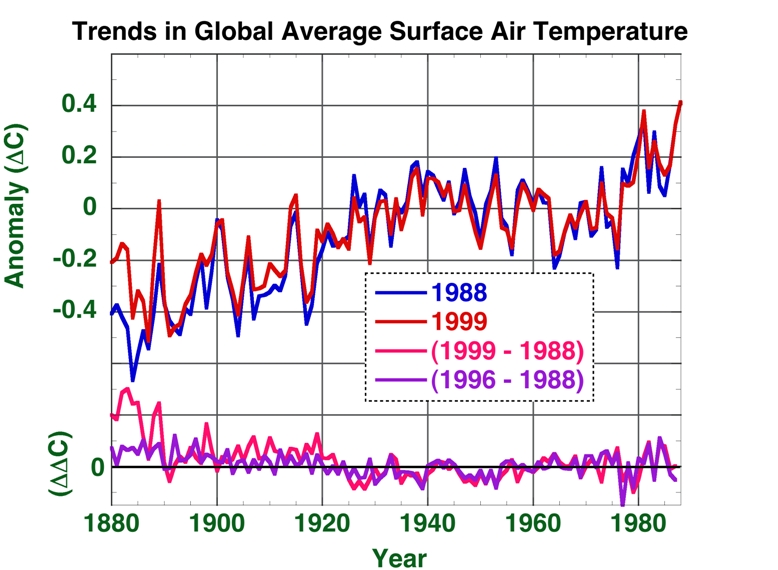

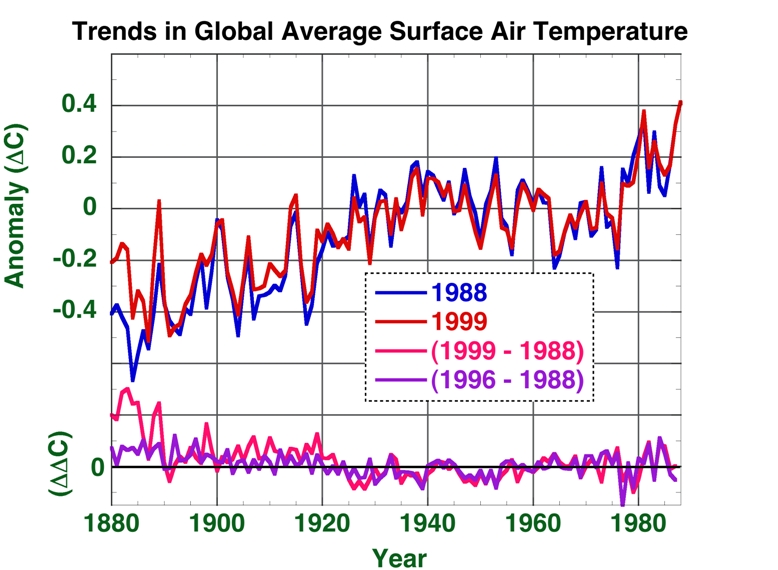

Aber weiter: Abbildung 1 zeigt die globale mittlere Temperatur, wie sie 1988 und 1999 veröffentlicht worden war. Die beiden Trendlinien scheinen sich gut zu überlagern, außer in der Zeit um 1880 bis 1890.

Abbildung 1: Anomalien der jährlichen globalen Mitteltemperatur, wie veröffentlicht in den Jahren 1988 und 1999. Die Unterschiede der Jahre 1996 bis 1988 und 1999 bis 1988 in den Datensätzen sind darunter geplottet.

Unten in der Abbildung 1 habe ich den Unterschied in den Trends geplottet: 1999 minus 1988 und 1996 minus 1988. Dieser Plot der Unterschiede zeigt, dass zwischen den Jahren 1925 und 1988 die globalen Temperaturtrends von 1996 und 1999 nicht wesentlich von dem Trend des Jahres 1988 unterscheiden. Aber 1996 und 1999 wurden die Jahre von 1880 bis 1925 plötzlich wärmer , als sie 1988 gewesen sein sollen. Und im Jahre 1999 erschienen die Jahre 1880 bis 1920 sogar noch wärmer als in 1996. Dies ist eine anthropogene globale Erwärmung, die wirklich jenseits der natürlichen Variabilität liegt.

Wir alle wissen, dass wir in einer wärmeren Welt leben. Aber wenn man die Aufzeichnungen des frühen 20. Jahrhunderts erhöht, reduziert sich die Erwärmungsrate bis zum Ende des 20. Jahrhunderts. 1988 lag die Erwärmungsrate bei 0,55°C pro Jahrhundert, während es 1999 nur noch 0,48°C pro Jahrhundert war (und nur 0,41°C zwischen 1880 und 1988). Wenn die Erwärmungsrate 1999 15% unter der des Jahres 1988 liegt, würde es da nicht weniger Anlass zur Sorge geben? Warum die Veränderung hin zu einer wärmeren Vergangenheit?

„Warum” könnte eine Frage der persönlichen Absicht sein, die unbekannt ist. Aber wir können ein „was?“ bemerken. 1988 schrieben Hansen und Lebedeff, dass „die Rate der Erwärmung zwischen Mitte der sechziger Jahre und der Gegenwart höher ist als die vorherige Periode einer rapiden Erwärmung zwischen 1880 und 1940“.

Das stimmt, aber nur, weil die Anomalie des Jahres 1964 ein starker Ausschlag nach unten war, während die achtziger Jahre mit einem ebenso großen Ausschlag nach oben begannen. Vielleicht wurden H&L wegen der Auswahl eines bequemen Startpunktes in den sechziger Jahren kritisiert, weil eine solche Feststellung in der Temperaturanomalie von GISS aus dem Jahr 1996 nicht auftauchte.

Aber im Jahre 1999 finden wir Beweise für eine erneute Durchsetzungskraft [assertiveness] in der Einführung: „Die Rate der Temperaturänderung war während der letzten 25 Jahre höher als jemals zuvor in dem Zeitraum mit instrumentellen Messungen“. 25 Jahre vor 1999, das bedeutet 1974, und 1976 zeigte sich erneut am Grund eines großen Ausschlags der Anomalie nach unten. Das hilft auch.

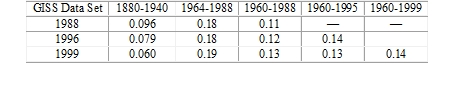

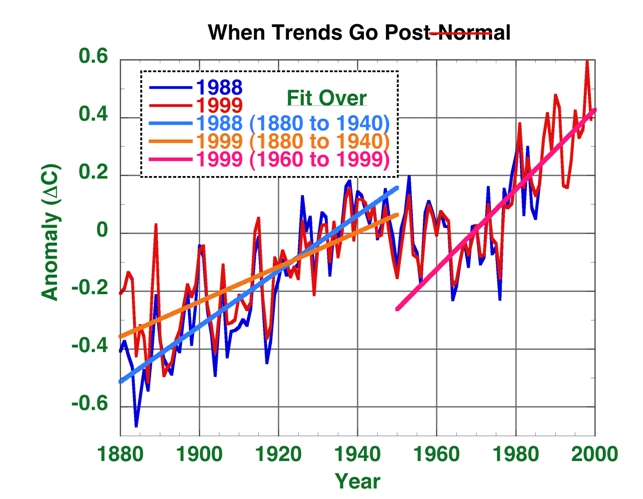

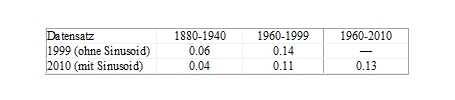

Aber schauen wir selbst. Hier folgt eine Tabelle von Erwärmungsraten nach GISS:

Tabelle 1: Mittlere dekadische Rate der Temperaturänderung (DDC)

Die Verzerrung (Bias) des Anfangspunktes 1964 ist ziemlich offensichtlich (Spalte 2 zu Spalte 3), also verpufft das zum Fenster hinaus. Das Jahr 1960 scheint einen viel weniger verzerrten Startpunkt für den Vergleich von Erwärmungsraten zu bieten, weil die Dekade wie 1880 und 1960 an der Spitze eines Anomalieausschlags begann.

Ich kann nicht darüber spekulieren, warum die Wissenschaftler beim GISS irgendwann zwischen 1960 und 1988 die Periode von 1880 bis 1920 systematisch erwärmt haben, aber Tabelle 1 zeigt die Auswirkung davon: Im Jahre 1988 erwärmte es sich von 1880 bis 1940 mit der gleichen Rate wie 1960 bis 1988 – also um etwa 0,1°C pro Dekade. Wie die Idsos sagen würden: ‚Hier ist nicht viel AGW!‘

Aber 1996 (Reihe 2) wurden von der Erwärmung pro Dekade im frühen 20. Jahrhundert 0,017°C abgezogen. Auf einmal lag die Erwärmungsrate von 1960 bis 1988 um 50% über der Rate von 1880 bis 1940. Vielleicht erschien ihnen das als eine gute Sache, weil 1999 (Reihe 3) weitere 0,019°C Erwärmung verschwanden. Also hat sich bis 1999 die Erde von 1960 bis 1988 doppelt so schnell erwärmt wie in den Jahren von 1880 bis 1940. Und diese für die NGOs vielversprechende Rate wurde gleich bis 1999 verlängert.

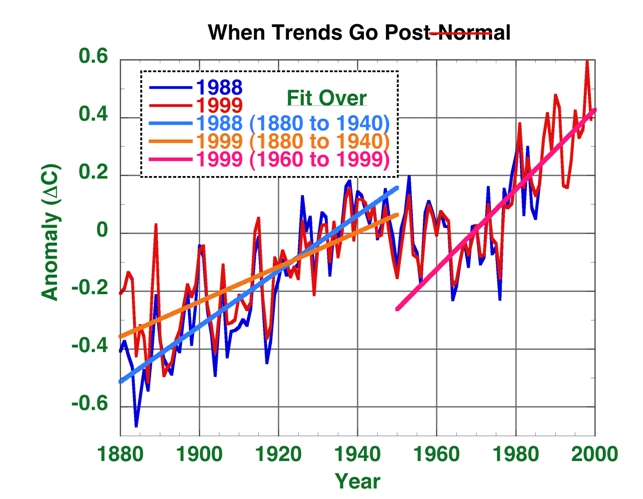

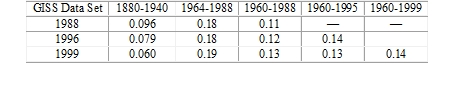

Abbildung 2: Die globalen jährlichen Temperaturtrends an der Erdoberfläche, wie sie 1988 und 1999 von GISS veröffentlicht worden waren. Blaue glatte Linie: Der Trend von 1880 bis 1940 aus dem Jahr 1988. Orange glatte Linie: Der Trend von 1880 bis 1940 nach den von GISS vorgenommenen Anpassungen der Daten. Rosa glatte Linie: die Rate von 1960 bis 1999. Dieser Trend verläuft auch eindeutig steiler als die Anomalien von 1988.

Abbildung 2 zeigt diesen Effekt visuell. Die blaue und die rosa Linie stellen die Glättungen der Temperaturen vor den Anpassungen dar. Sie verlaufen nahezu parallel. Also waren die Erwärmungsraten für die Zeiträume von 1880 bis 1940 und 1960 bis 1988 etwa gleich groß. Laut Tabelle 1 waren sie so ziemlich identisch, innerhalb der Fehlergrenzen.

Es wird ziemlich klar, dass man 1988 nicht behaupten konnte, dass es im späten 20. Jahrhundert schneller wärmer geworden ist als im frühen 20. Jahrhundert. Genau das konnte man jedoch 1999 sehr wohl behaupten. Wirklich?

Ist die verstärkte Erwärmung im späten 20. Jahrhundert die Erklärung für die seit 1988 von GISS vorgenommenen Änderungen bei der Anpassung? Ich weiß es nicht. Aber wir wissen sicher, dass die Anpassungen nach 1988 den Anpassern sehr geholfen haben.

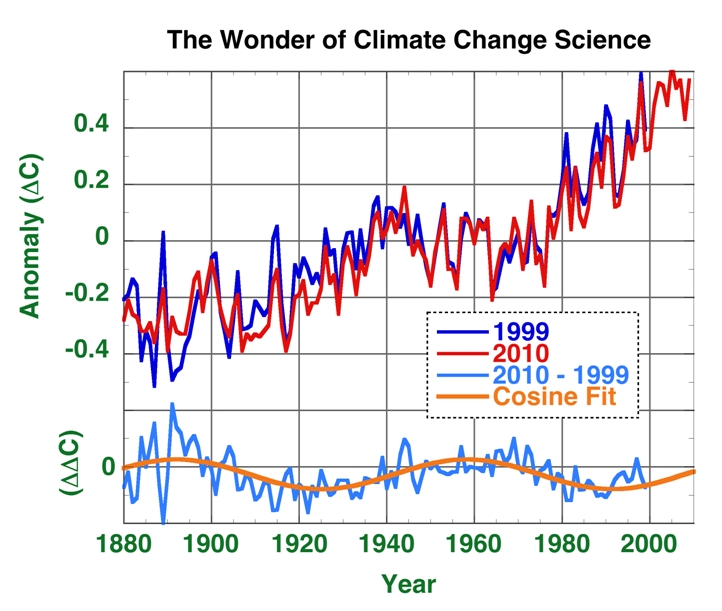

Es wird jedoch noch ein wenig merkwürdiger. Danach verglich ich den GISS-Trend 1999 mit den GISS-Trends von 2007 und 2010. Und siehe da, Gräber öffneten sich und Wunder liefen durch das Land.

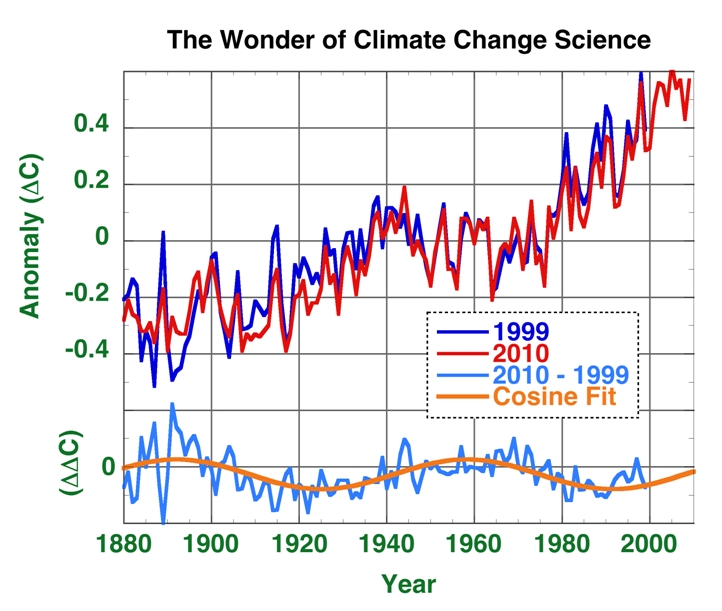

Abbildung 3 zeigt die Anomalietrends von GISS 1999 und 2010. Auch diese scheinen sich auf den ersten Blick nicht sehr zu unterscheiden. Aber man betrachte unten in Abbildung 3 den Unterschied 2010 minus 1999.

Abbildung 3: der globale mittlere Anoamlietrend der Temperatur nach GISS 1999 und 2010. Unten zeigt die blaue Linie den Unterschied 2010 minus 1999. Die orange Linie ist ein an den Unterschied angepasster Cosinus [?].

Das Wunder der Wissenschaft von der Klimaänderung besteht darin, dass sichere Klimaphänomene des 20. Jahrhunderts 1999 seltsam unsichtbar waren, sie wurden klar 2010 manifest. Die gleiche Cosinus-Differenz ergibt sich aus dem Reich der Wunder auch im Datensatz der globalen Temperatur nach GISS 2007, daher wissen wir, dass dieser Effekt vor 2007 in die Daten von 1999 eingegangen war.

Irgendwann zwischen 1999 und 2007 erschien ein Temperaturzyklus im Anomalietrend der globalen jährlichen Mitteltemperatur. Die Sinuskurven stehen für den gesamten signifikanten Unterschied der Anomalietrends zwischen 1999 und 2010 (einer spielt jedoch immer noch mit dem Zeitraum von 1880 bis 1890).

Ich habe eine exzellente Anpassung an den Unterschied zwischen 1999 und 2010 erhalten, und zwar durch Verwendung einer beliebigen Cosinus-Funktion. Die Periode ist 66 Jahre; leider nicht religiös signifikante 66,6 Jahre. 66 Jahre ist ein merkwürdiger Zyklus. Er ist etwas zu kurz für einen Gleissberg-Zyklus (60 bis 150 Jahre{11}) und scheint nicht zu irgendeinem der gewöhnlichen solaren Zyklen zu passen (http://en.wikipedia.org/wiki/Solar_variation). Also suchte ich in Google nach einem „66-Jahre-Zyklus“, und die ersten vier der über 88 Millionen Treffer führten mich zu Klimablogs.

Luboš (The Reference Frame, http://motls.blogspot.com/2011/03/is-there-66-year-cycle-in-temperatures.html) war der erste Treffer, und bei ihm findet sich eine gute Einführung in die Diskussion. Es scheint, dass Tamino über eine Studie bloggt, die einen 66-Jahre-Zyklus der Atlantischen Multidekadischen Oszillation innerhalb von 8000 Jahren in einem Eisbohrkern gefunden hatte. Tamino war skeptisch und Luboš stimmte zu, aber die AMO zeigt nicht die Aufzeichnungen der globalen jährlichen Mitteltemperatur. Das war also das. Wir haben keine Ahnung, was dieser wunderbare neue 66-Jahres-Zyklus repräsentiert. Vielleicht neu gefundene Zusammenhänge der AMO?

Noch mehr auf den Punkt gebracht: Welche legitime Anpassungsstrategie bringt ein Sinusoid in den Trend der globalen jährlichen Mitteltemperatur? Wird sie ‚entdeckt‘, wenn das nächste Mal jemand eine Wellenanalyse der instrumentellen Aufzeichnungen durchführt?

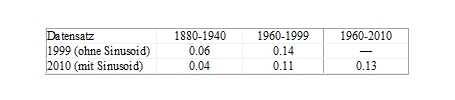

Man beachte, dass die Periodizität nicht sehr ersichtlich die Änderung des globalen mittleren Temperaturtrends zeigt. Hier folgt, welche Auswirkungen es auf die Temperaturtrends im frühen und im späten 20. Jahrhundert hat: das Sinusoid reduzierte 2010 die Erwärmungsrate zwischen 1960 und 1999 auf 20% unter die Rate im Datensatz von 1999, reduzierte jedoch den Trend zwischen 1880 und 1940 um 33%. Tabelle 2 zeigt die Zahlen.

Tabelle 2: GISS mittlere Dekadische Temperaturänderung mit Sinusoid (DDC)

Man sieht: als Ergebnis zeigt sich, dass die Erwärmung im späten 20.Jahrhundert bis 2010 2,8 mal schneller vonstatten ging als im frühen 20. Jahrhundert. 1999 lag das Verhältnis noch bei 2,3 mal schneller. Daraus folgt, dass das Sinusoid den gleichen Effekt hat wie die Erniedrigung der Temperatur von 1880 bis 1900: es verstärkt das Missverhältnis zwischen den Erwärmungsraten des frühen und des späten 20. Jahrhunderts. Aber es führt nicht dazu, dass sich die Trendlinien selbst aufsteilen. Der Effekt ist ziemlich subtil.

Die Änderung kommt – natürlich rein zufällig – jenen zupass, die nach einer noch nie da gewesenen Änderung anthropogenen Ursprungs suchen, aber wir alle wissen, dass wissenschaftliche Ergebnisse unabhängig von menschlichen Wünschen sind.

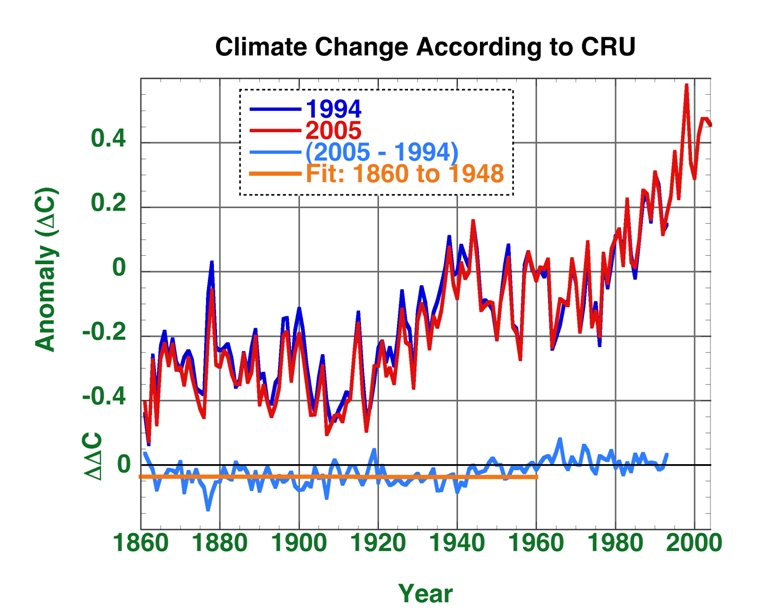

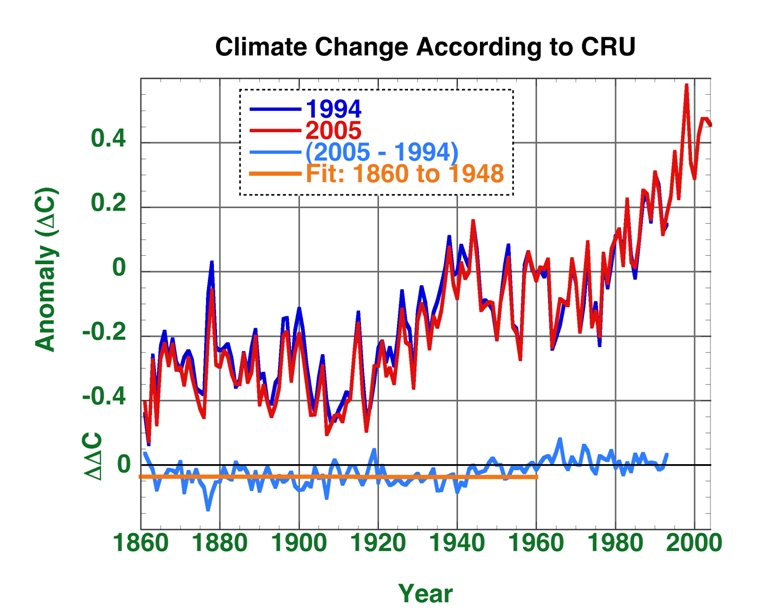

Aber vielleicht gibt es ja das Sinusoid wirklich, und es ist durch die primitiven Anpassungen vor 2007 nur zufällig verschwunden. Also beschloss ich, die analogen Datensätze der Climate Research Unit (CRU) der University of East Anglia zu untersuchen. Falls ein Temperaturzyklus mit den fortgeschrittenen Algorithmen des 21. Jahrhunderts wirklich enthüllt werden könnte, müssten die Differenztemperaturen CRU 2005 minus CRU 1994 das auch sicher zeigen. Gibt es einen 66-Jahres-Zyklus der Temperatur, der nur in späteren Datensätzen der CRU erscheint? Abbildung 4 zeigt die Antwort: Es gibt keinen Hinweis darauf. Wir bleiben zurück mit der Frage, was GISS sich bloß dabei gedacht hat.

Abbildung 4: Der Trend der mittleren globalen jährlichen Mitteltemperatur wie 1996 und 2006 von der CRU veröffentlicht. Unten zeigt die blaue Linie wieder die Differenz dieser Anomalien. Kein kryptisches Sinusoid ist zu sehen. Die y-Achse wird 1860 bei dem Wert -0,036°C geschnitten (Original: The fit y-intercept at 1860 is at -0.036 C).

Es ist interessant zu sehen, dass der Datensatz der CRU von 1994 kühler war als der Datensatz von CRU 2005, jedenfalls vor etwa 1940. 2005 hat das UK Met Office die Erstellung der globalen Temperaturanomalien in UK von der CRU übernommen. Daher dachte ich, dass das Met Office die Anpassungsmethoden vielleicht etwas verändert hätte. Aber die gleiche Kühle vor 1940 zeigte sich auch hier wieder, und jener Datensatz stammte ausschließlich von der CRU.

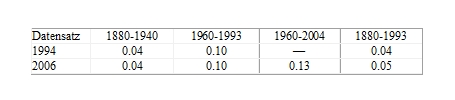

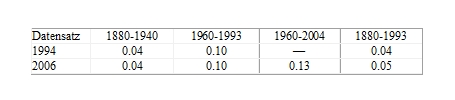

Was also auch immer der Fall ist, die Arbeitsgruppen der UEA CRU und des UK Met Office kühlten die Temperaturen vor 1940 mit den gleichen Methoden. Was bewirkte dies bei der Differenz der Anomalieraten zwischen dem frühen und dem späten 20. Jahrhundert? Tabelle 3 zeigt: fast nichts.

Aber die nach 1994 von CRU vorgenommene Anpassung hat den gesamten Anomalietrend von 1880 bis 1993 um 0,01°C pro Dekade zunehmen lassen.

Tabelle 3: CRU Mittlere dekadische Temperaturänderung (DDC)

Die Trends der CRU enthüllen auch etwas Interessantes bei den GISS-Trends: Die Hinzufügung des Sinusoids zu den GISS-Anomalien von 1999 zog ihre Trends von 2010 genau auf die Linie der CRU-Trends- Ein glücklicher Zufall? Ich weiß es nicht.

So verbleiben nach all dem mehr Fragen als Antworten. Aber die neue Wissenschaft von der Klimaänderung ist ganz klar umrissen: Sie hat sich von einem Studium des Klimas zu einem studierten Klima gewandelt.

Link: http://noconsensus.wordpress.com/2011/05/08/delta-t/

Autor: Pat Frank

References:

1. Frank, P., Uncertainty in the Global Average Surface Air Temperature Index: A Representative Lower Limit, Energy & Environment, 2010, 21 (8), 969-989; freely available by the generosity of Multi-Science http://meteo.lcd.lu/globalwarming/Frank/uncertainty_in%20global_average_temperature_2010.pdf.”>here</a>.

2. Hansen, J. and Sato, M., GISS Surface Temperature Analysis, Goddard Institute for Space Studies, NASA, http://data.giss.nasa.gov/gistemp/graphs/, Last accessed on: 2 April 2011.

3. Jones, P.D., Osborn, T.J., Briffa, K.R. and Parker, D.E., Global Monthly and Annual Temperature Anomalies (degrees C), 1856-2004 (Relative to the 1961-1990 Mean), CRU, University of East Anglia, and Hadley Centre for Climate Prediction and Research, http://cdiac.ornl.gov/ftp/trends/temp/jonescru/global.txt, Last accessed on: 27 November 2010.

4. Hansen, J. and Lebedeff, S., Global Trends of Measured Surface Air Temperature, J. Geophys. Res., 1987, 92 (D11), 13345-13372.

5. Hansen, J. and Lebedeff, S., Global Surface Air Temperatures: Update through 1987, Geophys. Res. Lett., 1988, 15 (4), 323-326.

6. Hansen, J., Ruedy, R., Sato, M. and Reynolds, R., Global surface air temperature in 1995: Return to pre-Pinatubo level, Geophys. Res. Lett., 1996, 23 (13), 1665-1668.

7. Hansen, J., Ruedy, R., Glascoe, J. and M. Sato, M., GISS analysis of surface temperature change, J. Geophys. Res., 1999, 104 (D24), 30997–31022.

8. Parker, D.E., Jones, P.D., Folland, C.K. and Bevan, A., Interdecadal changes of surface temperature since the late nineteenth century, J. Geophys. Res., 1994, 99 (D7), 14373-14399.

9. Jones, P.D. and Moberg, A., Hemispheric and Large-Scale Surface Air Temperature Variations: An Extensive Revision and an Update to 2001, Journal of Climate, 2003, 16 (2), 206-223.

10. Hansen, J., Fung, I., Lacis, A., Rind, D., Lebedeff, S., Ruedy, R., Russell, G. and Stone, P., Global Climate Changes as Forecast by Goddard Institute for Space Studies Three?Dimensional Model, J. Geophys. Res., 1988, 93 (D8), 9341-9364.

11. Ma, L.H., Gleissberg cycle of solar activity over the last 7000 years, New Astronomy, 2009, 14 (1), 1-3.

Übersetzt von Chris Frey für EIKE