Wissenschaftler: Erwärmung durch CO2 ist viel zu gering, um sich darüber Sorgen machen zu müssen!

Ich möchte ein paar Dinge klarstellen.

Die gesamte Idee, dass Kohlendioxid die Hauptursache der kürzlich erfolgten globalen Erwärmung gewesen ist, wurde durch empirische Beweise seit den neunziger Jahren eindeutig widerlegt. Aber der Erwärmungszug fuhr bereits zu schnell und enthielt zu viele Jobs, Industrien, Profite, politische Karrieren sowie die Möglichkeit einer Weltregierung und im Endergebnis totale Kontrolle. Anstatt zuzugeben, dass sie falsch lagen, halten die Politiker und ihre handzahmen Wissenschaftler jetzt die Fiktion, dass Kohlendioxid ein gefährlicher Giftstoff ist, auf empörende Weise am Leben.

Um es ganz klar zu sagen: Kohlendioxid ist ein Treibhausgas, und je mehr davon in der Luft enthalten ist, umso wärmer ist der Planet. Jedes Bisschen Kohlendioxid, das wir ausatmen, erwärmt den Planeten. Aber die Frage ist nicht, ob, sondern wie stark das Kohlendioxid zur Erwärmung beiträgt.

Die meisten Wissenschaftler auf beiden Seiten stimmen auch darin überein, wie stark ein bestimmter Anstieg des CO2-Anteils in der Atmosphäre die Temperatur des Planeten steigen lässt, wenn man zusätzliches Kohlendioxid berücksichtigt. Diese Berechnungen stammen aus Laborexperimenten; die grundlegende Physik dahinter ist seit einem Jahrhundert verstanden.

Der Streit beginnt damit, was danach kam.

Der Planet reagiert auf dieses zusätzliche Kohlendioxid, was alles ändert. Am meisten umstritten ist der Umstand, dass die zusätzliche Wärme zu größerer Verdunstung aus den Ozeanen führt. Aber bleibt diese zusätzliche Feuchtigkeit einfach in der Luft hängen und lässt den Anteil an Feuchtigkeit zunehmen, oder sorgt dies einfach nur für mehr Wolken und Regen? 1980, als die Theorie vom Kohlendioxid anfing, wusste das niemand. Die Alarmisten schätzten, dass die Menge an feuchter Luft rund um die Erde zunimmt, was zu weiterer Erwärmung führt, weil Feuchtigkeit auch ein Treibhausgas ist.

Dies ist die Kernidee jedes offiziellen Klimamodells. Für jedes einzelne Quäntchen Erwärmung durch Kohlendioxid wird einfach behauptet, dass der zusätzliche Eintrag feuchter Luft zu drei Quäntchen Erwärmung führt. Die Klimamodelle vergrößern den Erwärmungseffekt um den Faktor drei – so dass zwei Drittel ihrer simulierten Erwärmung auf zusätzlichen Feuchteeintrag (und andere Faktoren) zurückgeht; nur ein Drittel wird durch das zusätzliche Kohlendioxid verursacht.

Das ist der Kern dieser Angelegenheit. Alle Streitigkeiten und Missverständnisse haben hier ihren Ursprung. Die Alarmisten gründen ihre Behauptungen auf die Feuchtigkeit in der Atmosphäre, doch gibt es einfach keinen Beweis für diese Verstärkung im Kern ihres Alarmismus.

Seit den sechziger Jahren wurde die Atmosphäre mit Wetterballonen messtechnisch erfasst, viele Tausend pro Jahr. Die Klimamodelle sagen alle übereinstimmend vorher, dass der Planet sich erwärmt, und dass sich ein „Hot Spot“ feuchter Luft in 10 Kilometern Höhe über den Tropen bilden soll, wenn sich die feuchte Luftschicht ausdehnt. Während der Erwärmung in den späten siebziger sowie den achtziger und neunziger Jahren fanden die Ballone keinen „Hot Spot“. Überhaupt keinen. Nicht einmal einen kleinen. Dieser Umstand ist ein klarer Beweis dafür, dass die Klimamodellrechnungen fundamental versagt haben und dass sie den Temperaturanstieg durch Kohlendioxid weit überschätzen.

Dieser Beweis trat Mitte der neunziger Jahre erstmals klar zutage.

An diesem Punkt hörte die „Klimawissenschaft” auf, Wissenschaft zu sein. In der echten Wissenschaft sticht der empirische Beweis immer die Theorie aus, egal wie verliebt man in diese Theorie ist. Aber die offizielle Klimawissenschaft ignorierte den durch die Wetterballone erbrachten Beweis, ebenso wie andere Folgebeweise, die die Wetterballone bestätigten, sondern klebte stattdessen an ihrer Theorie zum Kohlendioxid – hielt sie dies doch in gut bezahlten Jobs mit großzügigen Forschungszuwendungen. Außerdem erhielten sie so politische Macht über ihre Regierungsbeamten.

Mittlerweise gibt es unabhängig voneinander viele verschiedene Beweisstücke, die belegen, dass durch den zusätzlichen CO2-Eintrag die Erwärmung der Erde gedämpft wird. Jedes langzeitliche System verhält sich so und reagiert so auf jede Störung. Anderenfalls würde das System instabil werden. Das Klimasystem bildet da keine Ausnahme, und jetzt können wir das beweisen.

Aber die Alarmisten sagen genau das Gegenteil, nämlich dass das Klimasystem jede Erwärmung durch zusätzliches CO2 beschleunigt und potentiell instabil ist. Es ist keine Überraschung, dass ihre Prognosen der planetaren Temperatur, die sie 1988 sowie 1990, 1995 und 2001 vor dem US-Kongress abgaben, sich allesamt als viel höher herausgestellt haben, als es dann in Wirklichkeit der Fall war.

Sie fahren fort, den erwarteten Temperaturanstieg zu reduzieren, von 0,3°C pro Dekade 1990 auf 0,2°C pro Dekade in 2001 und aktuell 0,15°C pro Dekade – und haben noch die Frechheit, uns zu sagen, es sei „schlimmer als erwartet“. Diese Leute sind keine Wissenschaftler. Sie überschätzen die Temperaturzunahme durch das Kohlendioxid, lehnen selektiv Beweise ab und verbergen inzwischen die Wahrheit.

Eine Art des Verbergens liegt in der Art, wie sie die Temperatur messen.

Die offiziellen Thermometer befinden sich oft im warmen Abwind von Klimaanlagen, über heißen Asphaltflächen an Flughäfen, meist auch noch im Abstrahl von Düsenjets, bei Kläranlagen, wo sich durch das Kompostieren von Faulschlamm Wärme entwickelt oder in aufgeheizten Städten mit vielen Autos und Gebäuden. Die Globale Erwärmung wird in Zehntelgrad gemessen, so dass jede äußere Wärmeeinwirkung von Bedeutung ist. In den USA verletzen fast 90% aller von Freiwilligen bedienten Stationen die Richtlinien bzgl. der Lage, die einen Mindestabstand von künstlichen Heizquellen vorschreiben.

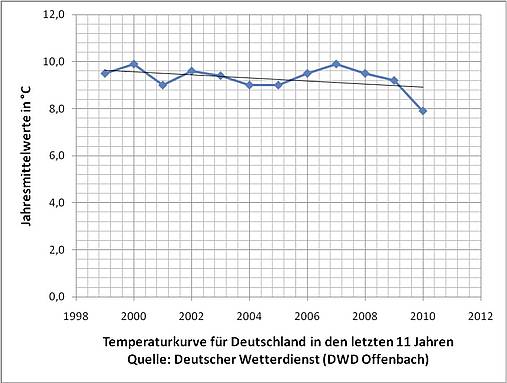

Die globale Temperatur wird auch durch Satelliten gemessen, die nahezu den gesamten Planeten 7 Tage pro Woche 24 Stunden lang ohne Verzerrungen beobachten. Diese Satellitendaten weisen das Jahr 1998 als das wärmste Jahr aus, und dass die Temperatur seit dem Jahr 2001 nicht mehr gestiegen ist (levelled off). Warum folgt die offizielle Wissenschaft nur den Thermometern an der Erdoberfläche und erwähnt die Satellitendaten nicht einmal?

Die Erde befand sich seit den Tiefen der Kleinen Eiszeit um 1680 in einem Erwärmungstrend. Menschliche Emissionen von Kohlendioxid waren vor 1850 vernachlässigbar und kamen erst nach dem Zweiten Weltkrieg richtig in Gang. Daher kann anthropogenes CO2 unmöglich den Trend ausgelöst haben. Innerhalb dieses Trends sorgte die Pazifische Dekadische Oszillation PDO für einen Wechsel zwischen globaler Erwärmung und Abkühlung für jeweils 25 bis 30 Jahre in beide Richtungen. Wir befinden uns gerade am Ende einer Warmphase, so dass man während der nächsten zwei Jahrzehnte eine leichte globale Abkühlung erwarten kann.

Wir befinden uns derzeit aber auch an einem außerordentlichen Zusammentreffen. Die offizielle Klimawissenschaft, vollständig von der Regierung dirigiert und gefördert, treibt eine auf Mutmaßungen über feuchte Luft basierende Theorie voran, doch haben diese Mutmaßungen sich längst als falsch herausgestellt. Die Regierungen nehmen diesen Rat voller Schadenfreude an, weil der einzige Weg, die Emissionen zu drosseln, darin besteht, Steuern zu erheben und die Kontrolle der Regierung über den gesamten Energieverbrauch zu erweitern. Und die Drosselung der Emissionen im weltweiten Maßstab könnte sogar zu einer Weltregierung führen – wie aufregend für die politische Klasse!

Selbst wenn alle CO2-Emissionen ab morgen beendet sind, alle Geschäfte geschlossen sind und wir zurück in die Steinzeit katapultiert werden, würde die Temperatur bis 2050 um 0,015°C zurückgehen. Aber ihre Modelle übertreiben um das zehnfache – tatsächlich würden unsere Opfer den Planet bis 2050 um bloße 0,0015°C abkühlen!

Schließlich, das gilt für alle diejenigen, die immer noch glauben, dass unser Planet durch Emissionen von Kohlendioxid in Gefahr ist: Es tut mir leid, aber man hat Sie hereingelegt! Ja, Kohlendioxid ist ein Grund für globale Erwärmung, aber der Effekt ist so minimal, dass es nicht wert ist, viel für eine Drosselung von Emissionen zu tun.

David Evans

Artikel in der Financial Post 7. April 2011

Financial Post

Der Autor David Evans beriet das Australian Greenhouse Office (jetzt das Department of Climate Change) von 1999 bis 2005 voll und von 2008 bis 2010 in Teilzeit. Er modellierte dabei den Kohlenstoff in Pflanzen, Trümmern, Mulch, Erden sowie von Wald- und Felderträgen in Australien. Er ist Mathematiker und Ingenieur mit sechs Universitätsgraden, einschließlich eines PhD der Stanford-Universität als Elektroingenieur. Die obigen Bemerkungen wurden für die Anti-Carbon-Tax [Protestbewegung gegen die Kohlenstoffsteuer] in Perth am 23. März geschrieben.

Link: http://opinion.financialpost.com/2011/04/07/climate-models-go-cold/

Übersetzt von Chris Frey für EIKE