Die neue rechtsgerichtete niederländische Regierung hat eine radikale Überarbeitung der niederländischen Energiepolitik angekündigt. Sie baut die Subventionen für die meisten erneuerbaren Energien drastisch ab und setzt sogar allen Subventionen für Offshore-Windkraft, Solarenergie und große Energieerzeugung aus Biomasse ein Ende. Sie befürwortet auch neue Kernkraftwerke – zum ersten Mal seit der Katastrophe von Tschernobyl 1986 hat eine holländische Regierung so etwas getan. Aber nicht alles ist für den Sektor der erneuerbaren Energien verloren: das Kabinett ist noch am Nachdenken über eine langfristige Strategie und einen "Grünen Deal", der die Niederlande vielleicht doch noch auf eine "grünere" Schiene setzen könnte.

Sonnenuntergang für holländische grüne Subventionen

Vermutlich war es die große Subventionierung eines 600 MW-Offshore-Windparks durch die vorherige Regierung, welche das neue niederländische Kabinett veranlasste, einige drastische Änderungen an der bestehenden Unterstützung für erneuerbare Energien zu machen. Im Mai 2010 hatte die vorherige Regierung angekündigt, dass der deutsche Windenergie-Investor BARD ENGINEERING eine Zuschuss bis zu maximal 4,5 vom niederländischen Steuerzahler für den Bau von zwei 300-MW-Offshore-Windparks vor der nordfriesischen Küste erhalten sollte. Die neue rechte Regierung, eine Koalition der liberalen VVD und der christlich-demokratischen CDA, unterstützt von der Anti-Islam Partei PVV, entschied, sie würden nicht den gleichen Fehler machen. Während des Wahlkampfes hatte der neue Premierminister, Mark Rutte von den Liberalen, die staatliche Unterstützung für große Windkraftanlagen mit den Worten verspottet: "Die Zuschüsse drehen die Windmühlen".

Das am 30. November vom schwergewichtigen Maxime Verhagen, Christdemokrat und neuer Minister für Wirtschaft, Landwirtschaft und Innovation, vorgestellte Konzept für die erneuerbare Energie stellte mit seinen großen Kürzungen der grünen Zuschüsse von 4 Mrd. pro Jahr auf 1,5 Mrd. keine Überraschung dar. Die neue Regelung ist mehr als eine Kürzung – sie zielt auch auf eine radikale Überarbeitung der bestehenden Verfahren zur Vergabe von Subventionen ab. Man will "effiziente" (billige) Formen der erneuerbaren Energieerzeugung belohnen, so z. B. die Windenergieerzeugung an Land, und nicht die relativ ineffiziente (teure) Offshore-Windenergieerzeugung.

Defizit

Im vorherigen Verfahren (bekannt unter der holländischen Abkürzung SDE) flossen die Subventionen für verschiedene Formen der erneuerbaren Energien für einen festgelegte Zeitraum (normalerweise 15 Jahre). Die Höhe der Subvention wurde aus der Differenz zwischen den Kosten der jeweiligen Energieerzeugungstechnik und den Kosten der Energieerzeugung aus fossilen Quellen ermittelt. Dieses sogenannte "Defizit" wird jährlich vom holländischen Energieforschungsinstitut ECN berechnet.

Nach neuen Regel wird die holländische Regierung die Subventionen ganz anders zuweisen.

So erhielt z. B. die Offshore-Windenergie im vergangenen Jahr 9,7 ct pro kWh, die landerzeugte 4 ct, solarerzeugte 43 ct, usw. – das alles aufgrund des vom ECN festgesetzten “Defizits”. Diese System unterstützt relativ uneffiziente (teuere) und effiziente (billige) Formen der erneuerbaren Energien gleichermaßen, weil sie alle mit dem Ziel unterstützt werden, sie im Vergleich mit gas- oder kohleerzeugter Energie wettbewerbsfähig zu machen.

Im neuen Reglement (ein wenig irreführend SDE-plus genannt), das Mitte 2011 in Kraft treten soll, wird die Regierung die Mittel auf völlig unterschiedliche Weise verteilen, und das ist sehr komplex. Im Windhund-Verfahren werden die Subventionen in vier Stufen zugewiesen.

1) In der ersten Stufe wird eine Subvention von 9 ct pro kWh (oder 79 ct pro Kubikmeter Gas) angeboten, aber nur Für Erzeuger mit Techniken, die "Defizite" von unter 9 ct haben. Aufgrund der Zahlen vom ECN sind das: Biogas, Wasserkraft, Müll-Energieerzeugung, Gas aus Fermentierungsprozessen.

2) Wenn dann noch Geld übrig ist, geht es in die zweite Stufe, wo eine Subvention von 11 ct pro kWh (oder 97 ct pro Kubikmeter Gas) angeboten wird. Diese Stufe steht für die Erzeuger von landgestützter Windkraft und Gaserzeugern aus Dünger offen.

3) Wenn immer noch Geld übrig ist, wird in der dritten Stufe mit 13 ct pro kWh oder 114 ct pro Kubikmeter Gas unterstützt. Diese Stufe ist für die Energieerzeuger aus Wasserkraft und kleiner Biomasse offen.

4) Die vierte und letzte Stufe (15 ct pro kWh oder 132 ct pro Kubikmeter Gas) steht den Energieerzeugern als aller Art von Fermentierungsprozessen offen.

Nicht eingeschlossen in allen vier Kategorien sind Solarkraft, Biomasse in großem Umfang und offshore Windkraftwerke weil sie allesamt zu teuer sind.

Es gibt aber auch einen Vorteil. Die Regierung hat eine "freie Kategorie" von Antragstellern definiert. Die können sich um Subventionen in allen vier Kategorien bewerben. Wer kann sich für diese "freie Kategorie" qualifizieren? Zu allererst alle diejenigen, die in einer der in den vier Stufen genannten Energieerzeugung tätig sind. Zweitens die Erzeuger einer begrenzten Anzahl von erneuerbaren Energieformen mit Defiziten über 15 ct pro kWh, vor allem thermische Umwandlung von Biomasse (< 10 MW), Solarenergie (> 15 kWp), Osmose und Geothermie.

Die neue holländische Energiepolitik für offshore Windenergie steht in starkem Gegensatz zu den Nachbarländern.

So können sich z. B. Firmen aus dem landgestützten Windenergiegeschäft (eine Technik aus der zweiten Stufe) für Subventionen von 9 ct. pro kWh in der ersten Stufe bewerben. Oder, um ein anderes Beispiel zu nennen, Solarenergieerzeuger können sich für Subventionen in allen vier Stufen bewerben, aber im Falle der Gewährung müssen sie sich mit einer deutlich geringeren Unterstützung abfinden als unter dem von der ECN definierten Defizit-Regime.

Große Biomasse- und Offshore-Windkraft-Erzeuger befinden sich noch nicht einmal in der "freien Kategorie". Anders gesagt, sie werden überhaupt keine Subventionen erhalten. Die Großbiomassenerzeuger werden laut Ministerium deswegen ausgeschlossen, weil sie danach tendierten, ein großes Stück der Subventionen in der Vergangenheit abzugreifen. Dennoch hat die Regierung den Energieerzeugern versprochen, noch "einen alternativen" Weg zu finden, um diese Form der erneuerbaren Energie zu fördern.

Das wird wahrscheinlich ein Art von Regierungsauflage zur Verbrennung eines Anteils von Biomasse in Kohlekraftwerken sein. Für die Offshore-Winderzeuger sieht die Zukunft sehr düster aus: sie werden nirgendwo im neuen Konzept erwähnt. Hier zeigt sich eine scharfe Kehrtwendung zur Politik der vergangenen Regierungen, die ein Ziel von 6.000 MW Offshore-Windkrafterzeugung für 2020 gesetzt hatten. Bislang sind nur 220 MW Offshore-Windkraftkapazität im holländischen Teil der Nordsee installiert worden. Jetzt sieht es so aus, dass die beiden hochsubventionierten 300 MW Parks von BARD ENGINEERING die einzigen sind, die in absehbarer Zukunft hinzukommen, mit der Ausnahme eines etwa 100 MW Parks, der noch nach den Regeln des auslaufenden Regimes gefördert wird.

Die neue niederländische Energiepolitik für Offshore-Windparks steht in scharfem Kontrast zu den Nachbarländern. Deutschland, England, Dänemark und Irland sind immer noch fest entschlossen, die Windenergieerzeugung in ihren territorialen Gewässern auszubauen. Die Meinungen der Regierung in Den Hag scheint mehr im Einklang mit der Zentrale von SHELL zu stehen, die sich nur in geringer Entfernung vom niederländischen Parlament befindet. Im Oktober 2010 hat der Vorstandsvorsitzende von SHELL, Peter Voser, die große Subventionierung von BARD ENGINEERING offen kritisiert. SHELL hat sich 2008 aus dem Windenergiegeschäft wegen der damit verbundenen hohen Kosten zurückgezogen.

Grüner Deal

Hauptgrund für die neuen Subventionierungspolitik ist laut Aussagen des Ministers, dass "die Niederlande das europäische Ziel für erneuerbare Energien auf die kostenwirksamste Weise erreichen wollen". Anders gesagt, Kosten werden gesenkt. Das SDE-plus Regime wird für den holländischen Haushalt sehr "kostenwirksam" werden, weil die Verbraucher für die Energie in Form von Aufschlägen auf ihre Elektrizitäts- und Gasrechnung bezahlen müssen. Das alte SDE-Regime beruhte auf Zahlungen aus dem Haushalt. Etwa eine Hälfte der neuen Aufschläge wird auf das Konto der Privathaushalte entfallen, die andere Hälfte auf Industrie und Gewerbe. Zusätzlich erwägt die Regierung eine gesonderte "Kohle- und Gas-Steuer" zu erheben.

Maxime Verhagen, Ministe für Wirtschaft, Landwirtschaft und Innovation: ‚Massive EU-Finanzierung der Energie-Infrastruktur wird die Märkte zerstören‘

Heißt das, die Niederlande gäben ihre offshore Windenergieerzeugung und andere "teure" Formen der erneuerbaren Energie völlig auf? Dieser Schluss wäre etwas verfrüht. Auf einer vom renommierten Clingendael International Energy Programme (CIEP) veranstalteten Konferenz in Den Hag am 11. Januar, betonte Minister Verhagen, dass die Regierung zwei Linien verfolge: eine kurzfristige und eine langfristige. Das neue Subventionierungsschema soll als kurzfristige Maßnahme gesehen werden. Als Bestandteil der längerfristigen Strategie möchte die Regierung die Investitionen, Innovationen, Forschung und Entwicklung von offshore Windenergie und anderer "teurer" Formen der "Erneuerbaren" verstärken.

Auf derselben Konferenz erklärte der Generaldirektor für Energie, Telekommunikation und Märkte in Verhagens Ministerium, Hans Vijlbrief, dass die vergangene Politik auf einem Missverständnis beruht hätte. Er sagte: "Wir haben versucht, die Förderung der Innovation und Produktion gleichermaßen zu vermischen. Das funktioniert nicht." Im neuen Konzept sind die beiden Anreizsysteme getrennt. Die Regierung wird ihre Anstrengungen darauf richten, die offshore Windenergie, vielleicht auch auf die Solarenergie und großvolumige Biomassenenergie billiger zu machen, bevor sie die Produktion fördert.

Im April will die Regierung ein neues Energiekonzept vorlegen, das die langfristigen Pläne in größerem Detail enthält. Gleichzeitig versprach Verhagen, mit einem Fächer von politischen Initiativen unter dem Namen "Grüner Deal" herauszukommen. Ziel dieses noch in Bearbeitung befindlichen Plans ist, die Initiativen für Energieeffizienz und lokale nachhaltige Energieprojekte zu fördern. Als Bestandteil des "Grünen Deals" betrachtet die Regierung die Möglichkeit, einen Finanzierungstopf zu schaffen, um beispielsweise Hauseigentümer zu fördern, die in Energiesparmaßnahmen investieren wollen.

Kernkraft

Ein zweiter Gezeitenwechsel in der holländischen Energiepolitik der rechten Regierung ist die bewusste Hinwendung zur Kernkraft.

Das Kabinett fordert zu Anträgen für den Bau neuer KKW auf

Die Niederlande haben nur ein einziges kleines KKW namens Borssele in Zeeland. Es hat eine Kapazität von nur 485 MW. Spätestens seit Tschernobyl hat eine starke Opposition der Sozialdemokraten und anderer Linker Kernkraftprojekte undenkbar gemacht. 1994 hat die Regierung beschlossen, Borssele 2004 zu schließen. 2002 ist das Schließungsdaten auf 2013 verschoben worden. Dann wurde entschieden, das Kraftwerk bis 2033 zu betreiben. Neue Kernkraftprojekte waren aber von den verschiedenen vergangenen Koalitionsregierungen abgelehnt worden.

Damit ist nun seit der Machtübernahme durch die neue rechte Koalition Schluss. Das neue Kabinett hat klargestellt, dass es Anträge auf neue Kernkraftwerke befürwortet. In der Koalitionsvereinbarung vom 30. September steht, dass " … mehr Kernkraft nötig ist, um CO2-Verminderungsziele und geringere Abhängigkeit in der Energieversorgung zu erreichen. Anträge auf Genehmigungen für den Bau eines oder mehrerer neuen Kernkraftwerke, die die Auflagen erfüllen, werden genehmigt werden." Die Regierung hat aber keine Subventionierung versprochen. Auf parlamentarische Anfragen antwortete Verhagen, dass die interessierten Firmen selber die Kosten decken müssten.

In Reaktion auf die neue Politik haben einige Firmen angedeutet, dass sie am Bau neuer KKWs in den Niederlanden interessiert sind. Der Energieversorger DELTA, im Eigentum der Provinzregierung von Zeeland und 50%-iger Eigentümer von Borssele, steht bereits in Verhandlungen mit dem französischen Energieriesen EDF. Beide Firmen befinden sich im fortgeschrittenen Stadium der Vorbereitungen der Beantragung einer Baugenehmigung. Im kommenden Jahr wird der Antrag erwartet.

Borssele ist das einzige holländische KKW

DELTA hat eine Hauptwettbewerber in Energy Resources Holding (ERH), dem anderen 50%-Eigentümer des KKW Borssele. ERH hat ebenfalls die Absicht zum Bau eines neuen KKW in Borssele angekündigt. Die deutliche Rivalität zwischen den beiden Joint-Venture-Partnern von Borssele hat ihre eigene Geschichte. Borssele war als Joint-Venture von DELTA und ESSENT gebaut worden, beide im Eigentum der Provinz- und lokalen Behörden zur damaligen Zeit. Als aber ESSENT 2009 vom deutschen Energieversorger RWE übernommen worden war, hat DELTA mit Erfolg den Verkauf der ESSENT-Anteile an RWE verhindert mit der Begründung, dass die Statuten von Borssele eine Privatisierung verböten. Die früheren ESSENT-Eigner behielten ihre Borssele-Anteile, die sie in eine getrennte Holding einbrachten, die ERH. Eine gerichtliche Klärung ist im Gange, in der festgestellt werden soll, ob das Privatisierungsverbot aufgehoben und ERH an RWE verkauft werden könnte. Im Erfolgsfalle hätte die deutsche Firma die Möglichkeit in den Kernkraftsektor in den Niederlanden einzusteigen. Eine Ironie ist, das Borssele mit RWE-Technologie gebaut worden ist.

Zusätzlich zu DELTA (EDF) und ERH (RWE) haben zwei weitere Kandidaten ihr Interesse am Ausbau der Kernkraft in den Niederlanden gezeigt: ELECTRABEL, Tochter der französischen GDF-SUEZ, des größten Energieerzeugers in den Niederlanden, und die schwedische VATTENFALL, die den holländischen Energieerzeuger NUON 2009 übernommen hat.

Garantien

Der Erfolg eines neuen Kernkraftprojekts in den Niederlanden ist aber keineswegs sicher. Auf der CIEP-Konferenz sagte Verhagen, er erwarte den Antrag von DELTA 2012. Dann würde die Regierung alles in ihrer Macht Stehende tun, um die Genehmigung noch innerhalb der vierjährigen Legislaturperiode zu erteilen, d. h. vor 2015. Das beträfe auch alle anderen Projekte. Es ist aber noch unklar, ob der Minister sein Versprechen wird einhalten können. Die Bearbeitung eines Antrags für ein Kernkraftprojekt ist eine höchst komplexe Angelegenheit. Experten zweifeln, ob die holländische Regierung überhaupt genügend Sachverstand hat, um so etwas zügig zu erledigen.

Für Firmen, die einen Antrag stellen wollen, ist es ebenfalls nicht leicht. Peter Terium, Vorstand von ESSENT sagte, dass 2012 ein "sehr ambitionierter" Abgabetermin für jede Firma wäre.

Solide gesetzliche Grundlagen und Regeln sind nötig, die nicht nach den nächsten Wahlen über Bord geworfen werden können

Er merkte an, dass allein die Angebotsbearbeitung 10 Mio. Euro für jede Firma kosten könnte, vielleicht auch mehr. Auch sagte er, dass die Energieversorger vor dem Eingehen größerer Investitionen weit bessere Regierungsgarantien brauchten als die reine Absichtserklärung, einen Antrag zu genehmigen. In seinen Worten: "Es muss eine solide gesetzliche Grundlage her, die nach den nächsten Wahlen nicht mehr abgeschafft werden kann."

Ein Regierungssprecher sagte, dass Verhagen einen Entwurf für eine gesetzliche Regelung vorbereite. Der könnte binnen einiger Wochen fertig sein.

Dennoch, wenn es um das Erreichen des CO2-Emissions-Ziels für 2020 geht, wäre die holländische Regierung wohl besser beraten, nicht auf die Kernkraft als Teil der Lösung zu setzen.

Autoren Karel Beckman and Alexander Haje Hier in Europena Energy Review kann der Artikel im Original gelesen werden. The Dutch lose faith in windmills

Die Übersetzung besorgte Helmut Jäger EIKE

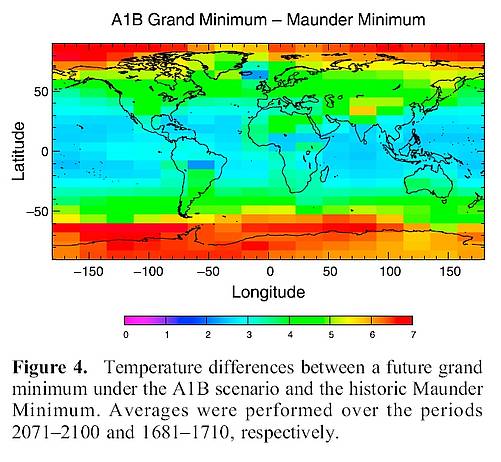

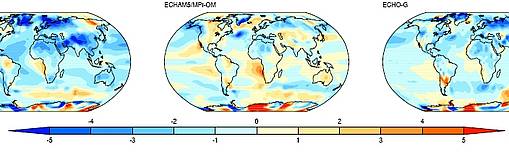

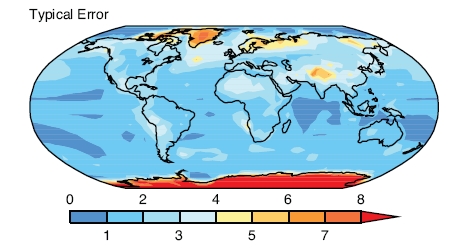

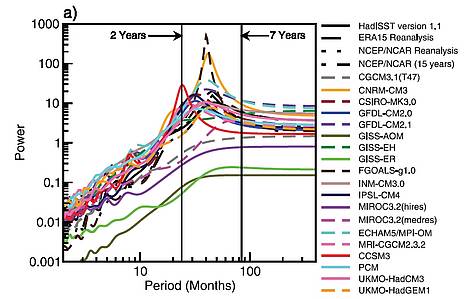

Das ist nicht ganz neu, denn im Report „Wie verlässlich sind Klimamodelle“ konnte man schon sehen, dass in einigen Modellen die Antarktis eisfrei war. Zur Erinnerung:

Das ist nicht ganz neu, denn im Report „Wie verlässlich sind Klimamodelle“ konnte man schon sehen, dass in einigen Modellen die Antarktis eisfrei war. Zur Erinnerung:

…

…