Realer Temperaturverlauf für Deutschland

Nicht nur Großflughäfen und Städte haben einen Wärmeinseleffekt, der die Temperaturdaten in die Höhe treibt und damit verfälscht. Der WI steht für Einflüsse des Menschen auf seine Umgebung, die nicht temperaturneutral sind, da sie entweder direkt Wärme ausbringen oder indirekt das Wärmeverhalten der Landschaft und damit dessen Wärmespeicherung und/oder Abstrahlung ändert, einwirken. Hierzu zählen beispielsweise Flächenversiegelung/-umwandlung, Energieverbrauch, Verkehr, Industrialisierung, mehr Komfort im Haushalt,…

Für die tägliche Temperaturerfassung eines Ortes ist der WI nicht von Bedeutung. Denn die ortsgebundene Temperaturmessung soll ja dazu dienen, den Temperaturwert vor Ort aktuell zu bestimmen. Der WI ist aber von immenser Bedeutung, werden Vergleiche zu anderen Messstationen oder gar Vergleiche zu früheren Epochen, in denen es z.B. keine Jets gab oder das Landschaftsbild ein ganz anderes war, erstellt. Werden hier keine WI-Korrekturen vorgenommen, werden die berühmten Äpfel mit Birnen verglichen und genau dies ist in der/den Datenreihen des DWD, die die Deutschlandtemperaturen von 1881 – 2009 zeigen, der Fall.

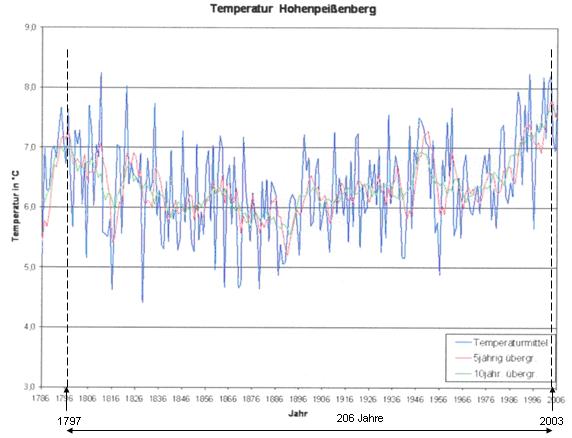

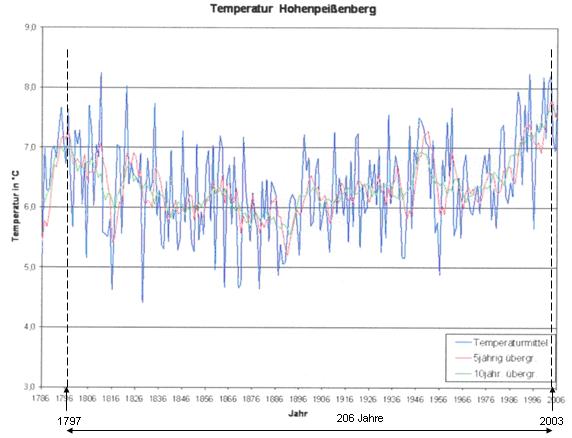

Auf Anfrage konnte uns der DWD keine Aussage über den WI seiner Messstationen machen. Er teilte lediglich mit, dass dieser in der Fläche in Deutschland nicht über 0,1°C läge und damit unbedeutend sei. Nun, wir wollten dies genauer wissen und untersuchten, wie der WI-Anteil aus den DWD-Deutschlandwerten herauszurechnen ist. Hierzu ist es notwendig, eine Referenzstation zu finden, die eine lange Temperaturaufzeichnung vorweisen kann, weitab von Zivilisationseinflüssen liegt und die sich über die Jahre überschaubar änderte (es gibt keine Messstation, die sich über 100 Jahre nicht ändert). Eine solche Referenzstation, die auch der DWD als Referenzstation benennt, ist die Station Hohenpeißenberg (HPB).

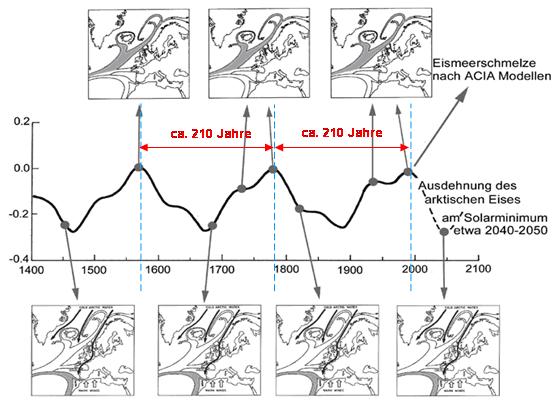

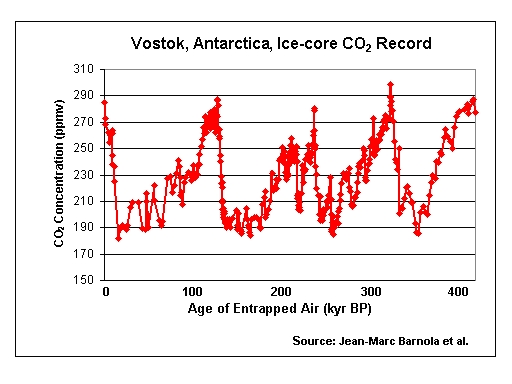

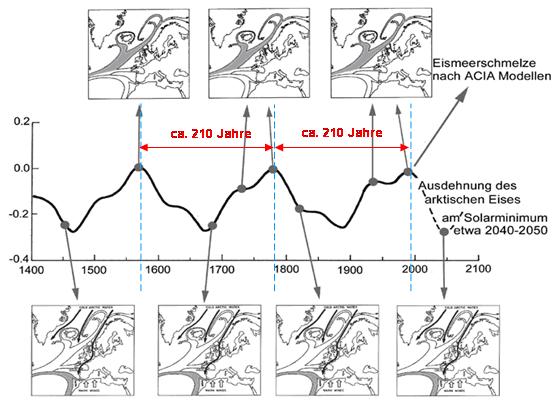

Abbildung 1 zeigt die Temperaturentwicklung am HPB von 1786 – 2006. Deutlich ist ein natürliches Schwingverhalten zu sehen, deren Periode bei ca. 206 Jahren liegt (Maxima der 5 und 10-Jahrestrends). Diese stimmt exakt mit dem Hauptsonnenzyklus, dem im Mittel 208-jährigen de Vries/Suess-Zyklus überein, der in 2003 sein (im Mittel) 208-jähriges Aktivitätsmaximum hatte, als ganz Europa unter einem Jahrhundertsommer stöhnte. Folgende Abbildung zeigt beispielsweise seinen Einfluss auf die arktische Eisbedeckung.

Natürliche Schwankungen auf die Meeresströmungen im Nordatlantik und somit auf den Golfstrom, zeigt Abbildung 2, Quelle: Dr. Axel Mörner, “Keine Gefahr eines globalen Meeresspiegelanstiegs“. Die Abbildung wurde um den de Vries/Suess-Sonnenzyklus ergänzt. Zu sehen ist die arktische Eisentwicklung in Verbindung mit den vorherrschenden Meeresströmungen in Relation zum Hauptsonnenzyklus (de Vries-Suess-Zyklus). Sowohl die arktische Eisbedeckung, als auch das Muster der Meeresströmungen folgt dem im Mittel 208-jährigen de Vries-Suess-Zyklus. Bei Sonnenminima erlebten Nordwesteuropa, der Nordatlantik und die Arktis Kaltphasen. Die Abbildung zeigt weiter, dass für die nächsten 30 – 40 Jahre eine arktische Eisausdehnung und keine Eisschmelze zu erwarten ist.

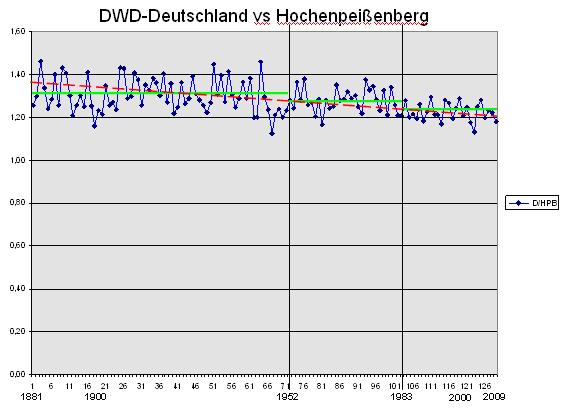

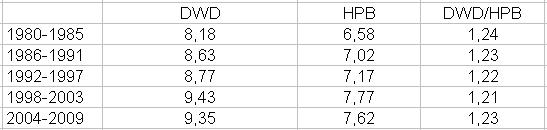

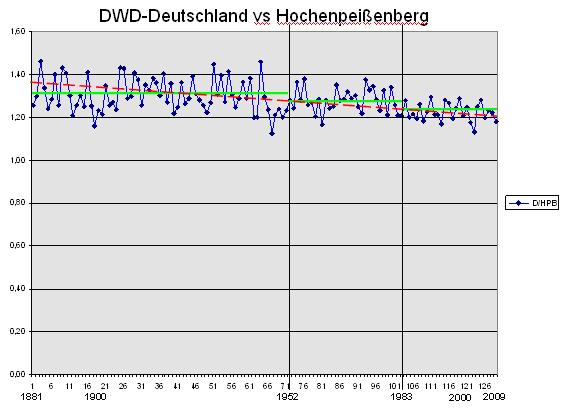

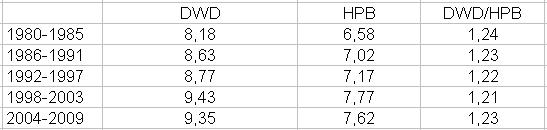

Es gilt nun, die Deutschlandtemperaturwerte mit der Referenzstation HPB in Relation zu setzen. Dabei ist anzumerken, dass beide Datenreihen vom DWD stammen und somit offiziellen Charakter besitzen. Die Relation der Daten ergibt folgende Reihe.

Abbildung 3 zeigt die Datenreihe D/HPB im Zeitraum 1881 – 2009. Für Deutschland liegen erst ab 1881 Daten vor, daher kann die Datenreihe erst 1881 beginnen. Die Datenreihe zeigt (die Zahlen 1 – 126 dienen zum Vergleich mit der Excel-Liste der Anlage), dass sich die Werte von HPB und Deutschland mehr und mehr angleichen (Trend ist negativ). D.h., auf HPB wird es vergleichsweise (in %) mehr warm. Dies liegt daran, dass sich kalte Gebiete, fernab von Zivilisations- also WI-Einflüssen, relativ schneller erwärmen (warum? – weiter im Text). Es lassen sich drei Bereiche erkennen, in denen die Werte jeweils um einen gemeinsamen Mittelwert pendeln.

In der obigen Relationskurve ist der WI „verborgen“ und nicht in der Referenzkurve (die als Referenz nur einen kleinen WI hat – 0 kann er nicht sein, weil, wie gesagt, keine Station über 100 Jahre unverändert bleibt), sondern in der Deutschlandkurve des DWD. Der WI ist in der Dämpfung (oder Spreizung, je nach Betrachtung) des DWD-Temperaturverlaufs zu HPB enthalten, weil die DWD-D-Daten relativ weniger steigen. Die durch den WI höheren Temperaturen dämpfen dort den Erwärmungstrend, weil sie ihn quasi bereits vorweg genommen haben.

Um den WI in den drei in Abbildung 3 zu sehenden Zeiträumen zu ermitteln (für die Zeiträume 2 und 3 berechnet), wurde folgendermaßen vorgegangen:

· Ermittlung der jeweiligen Mittelwerte für D und HPB in den o.g. drei Zeiträumen (1881 – 1952, 1953 – 1982 und 1983 – 2009)

· Ermittlung der jeweiligen %-Änderung des Folgezeitraums zum Vorgängerzeitraum

· Unterschied ermittelt HPB zu D

· WI im 2. und 3. Zeitraum berechnet

· WI im 1. Zeitraum wurde mit 0,2°C sehr konservativ geschätzt. Grund des WI: Andere Verteilung der Stationen, andere Messsysteme, andere Flächen – Deutschland wurde kleiner (um die Hälfte) und große Landschaftsflächen fielen weg, Beginn der industriellen Landschaftsveränderung, …

· WI HPB von 1881 – 2009 mit 0,3°C bestimmt.

Dass auch HPB nicht WI-los sein kann, wurde bereits geschildert. Der Grund für die 0,3°C ist wie folgt: Etwa 1940 ist die Klimastation auf dem HPB umgezogen. Der Leiter hat damals gefordert, Parallelmessungen durchzuführen, was aber nicht geschah. Die alte Wetterstation wurde den Mönchen weggenommen und bekam ein eigenes Gebäude beim Friedhof, das ständig erweitert und beheizt wurde. Heute stehen dort Gebäudekomplexe. Im Kloster zuvor wurde nur ein Aufwärmraum beheizt. Außerdem wurde allmählich ein stetig sich vergrößernder Parkplatz angelegt, der zugleich auch als Parkplatz für den Friedhof in der Nachbarschaft dient. Fassungsvermögen geschätzt, etwa 100 Autos. Daraus folgt: Bis 1940 hatte der HPB keinen WI. Dann hat er einen entwickelt, mit zunehmender Bebauung. Der Berg ist also nicht WI-frei, wie er allgemein in der Literatur und vom DWD dargestellt wird.

Für die drei Zeiträume ergibt sich ein dynamischer WI:

Zeitraum 1: 1881 – 1952 = 0,2°C

Zeitraum 2: 1953 – 1982 = 0,3°C

Zeitraum 3: 1983 – 2009 = 0,7°C

Der Gesamt-WI ist die Steigung über alle drei Zeiträume.

WI über alle drei betrachteten Zeiträume von 1881 – 2009 = 1,2°C

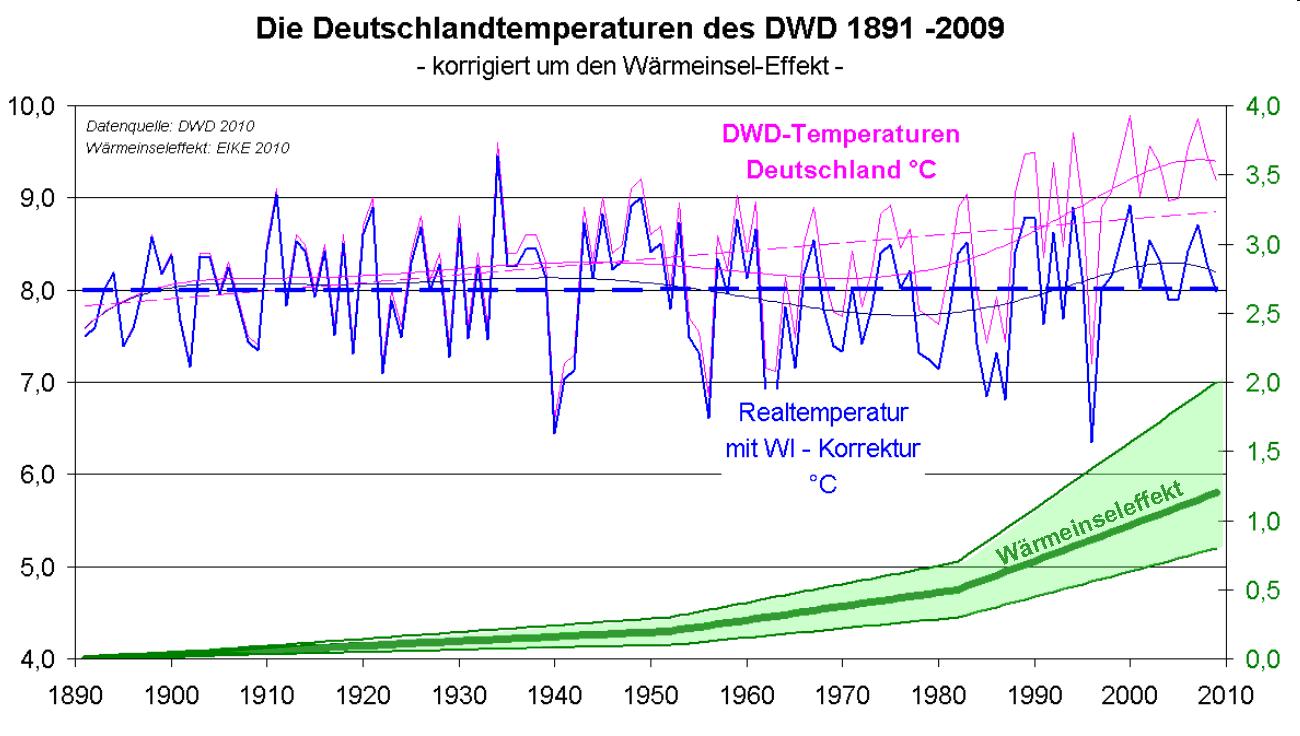

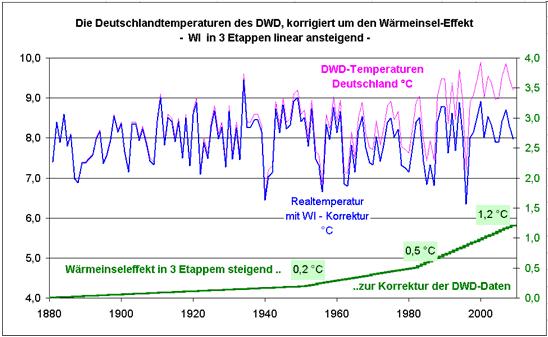

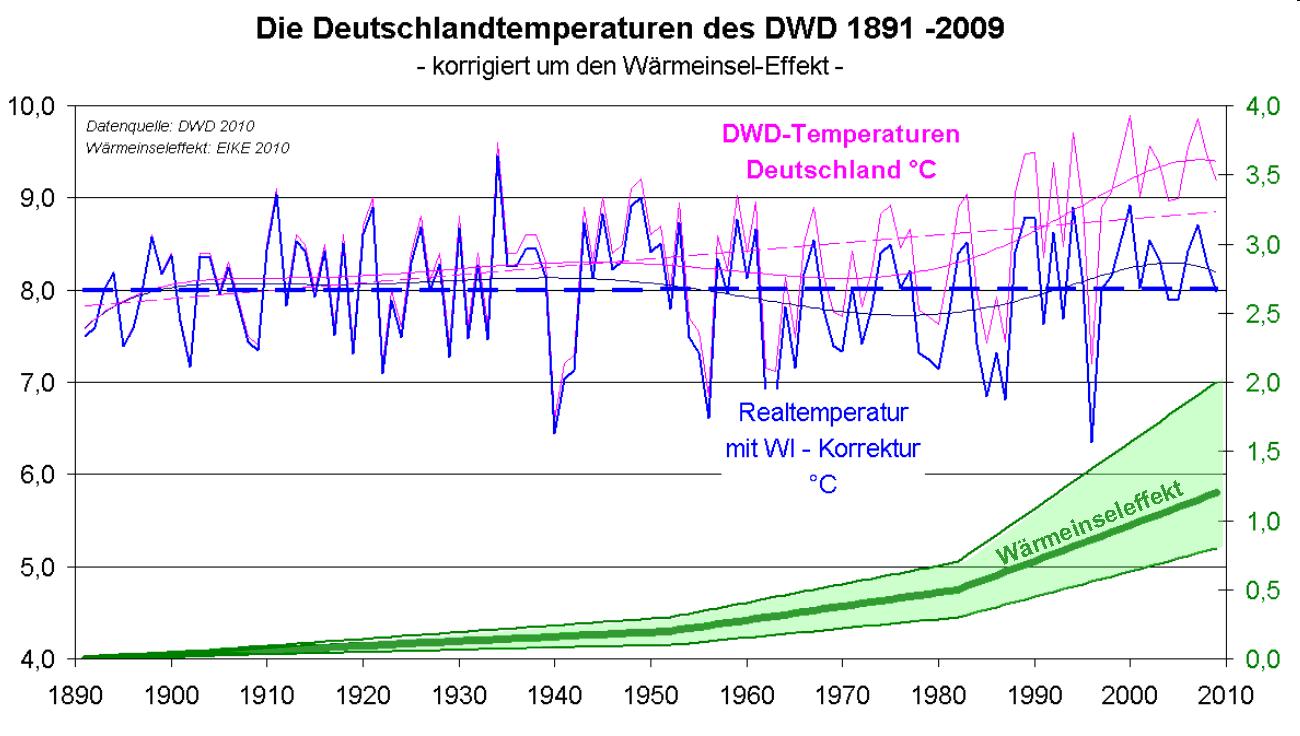

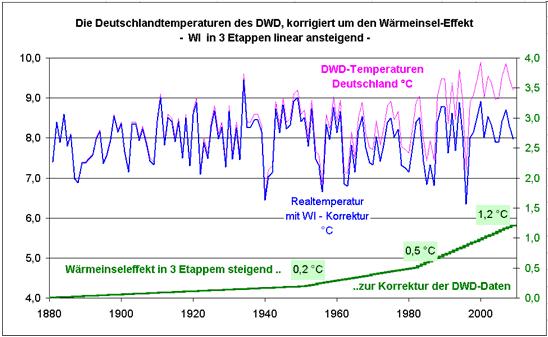

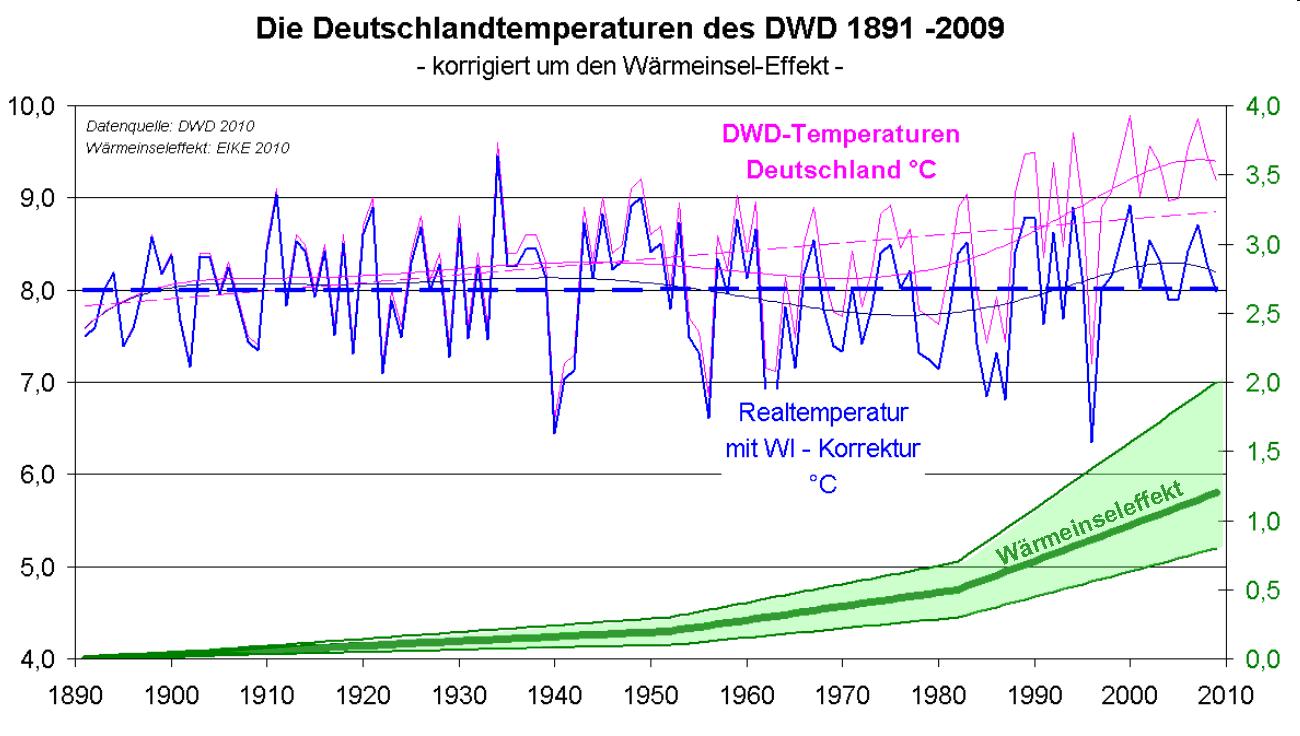

Die Berechnung ist in der Excel-Liste mit den Quelldaten im Anhang zu sehen. Mit den von uns ermittelten dynamischen WI-Werten ergibt sich die für Deutschland korrekte Vergleichskurve der Temperaturdaten von 1881 – 2009 (Abbildung 4).

Abbildung 4 zeigt den Temperaturverlauf für Deutschland nach Daten des DWD (rosa), ohne Berücksichtigung der sich veränderten Rahmenbedingungen für Deutschland von 1881 – 2009. Die blaue Kurve zeigt die von uns ermittelte reale, WI-bereinigte Temperaturvergleichsreihe für Deutschland im selben Zeitraum. Der grüne Trendverlauf zeigt den dynamischen WI, der für die drei Zeiträume ermittelt wurde.

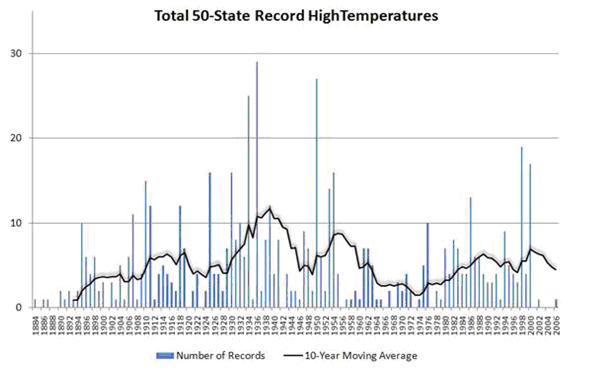

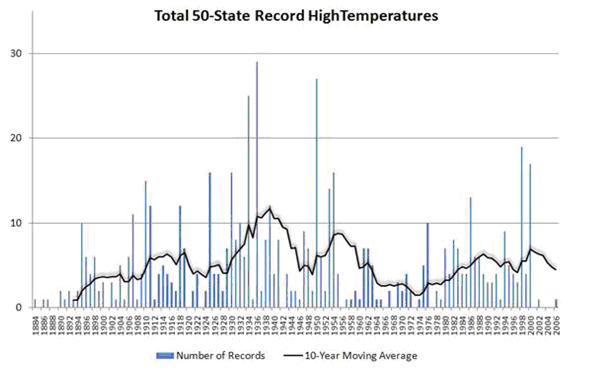

Die realen Vergleichswerte (blaue Kurve) zeigen keine nennenswerte Temperaturerhöhung für Deutschland im Betrachtungszeitraum. Die Maximaltemperatur wurde in den 1930-Jahren erreicht, was i.ü. mit den Temperaturdaten in den USA übereinstimmt. Dort lagen die höchsten Temperaturen ebenfalls in den 1930-Jahren (Abbildung 5).

Die Berechnung ergab, dass der WI dynamisch ansteigt, was auch einleuchtend ist, da der WI bekanntlich auf Flächenversiegelung, Flächenumwandlung, Energieverbrauch, Verkehr, Industrialisierung, mehr Komfort im Haushalt, eben human-influences basiert und diese werden und wurden von Jahr zu Jahr größer, und folglich der WI ebenfalls größer.

Abbildung 5 zeigt den Temperaturverlauf in den USA nach Daten der amerikanischen Wetterbehörde NOAA (National Oceanic and Atmospheric Administration). Die höchsten Temperaturen lagen auch dort Mitte der 1930-Jahre.

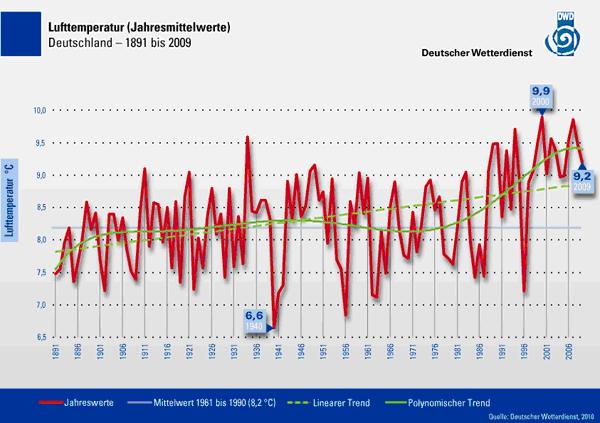

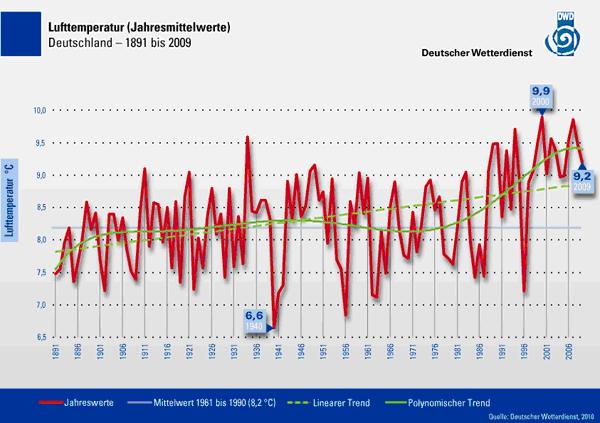

In unserem Vergleich der Abbildung 4 beginnt die Datenreihe ab 1881, weil ab diesem Jahr beim DWD durchgängige und verlässliche Temperaturdaten für Deutschland vorliegen, die uns der DWD übermittelte. Der DWD selbst lässt seine Datenreihe indes erst ab 1891 beginnen (Abbildung 6). Darum in Abbildung 7 der direkte Vergleich zu den DWD-Daten von 1891 – 2009.

Abbildung 6 (Quelle DWD) zeigt die mittlere Jahrestemperatur in Deutschland von 1891 – 2009. Für den Betrachter ergibt sich der Eindruck, dass Ende des 20. Jahrhunderts und zu Beginn des 21. Jahrhunderts die Temperaturen außerordentlich hoch ausfallen und auch in den „Kältejahren“ 2008 und 2009 die Temperaturen immer noch über dem Durchschnitt liegen und damit zu warm wären. Unsere Berechnung der realen Vergleichstemperaturen ergab, dass seit 10 Jahren die mittleren Temperaturen in Deutschland unter dem Trend(gestrichelte Trendkurve) liegen und damit zu kalt sind.

Abbildung 7 zeigt den unmittelbaren Vergleich der Deutschlandtemperaturen DWD und EIKE von 1891 – 2009. Die blau gestrichelte Linie zeigt den Temperaturmittelwert im Betrachtungszeitraum. Die Temperaturen in Deutschland durchbrechen die Mittellinie nach unten, was bedeutet, dass es derzeit kälter als im 120-Jahresvergleich ist. Zum berechneten WI aus Abbildung 4, haben wir, wie dies beim IPCC üblich ist, den Fehlertoleranzbereich angegeben (grüner Bereich). Auch bei der Datenreihe ab 1891, wieder der Quervergleich mit dem Temperaturniveau der USA aus Abbildung 5. Die EIKE-Deutschlandtemperaturkurve zeigt exakt das gleiche Bild: Die höchsten Temperaturen im Betrachtungszeitraum lagen Mitte der 1930-Jahre. Um 1950 lagen die Temperaturen ebenfalls über denen der letzten 30 Jahre und das Temperaturniveau von heute ähnelt dem zu Beginn des 20. Jahrhunderts. Allerdings sind solche Meldungen natürlich nicht geeignet, die Theorie einer menschen-gemachten Erwärmung, die auf sog. Treibhausgasen basiert, zu unterstützen oder gar zu beweisen. Zur Temperaturentwicklung, siehe auch den aktuellen Bericht von Antony Watts vom 26.11.2010 (http://wattsupwiththat.com/2010/11/26/examination-of-cru-data-suggests-no-statistically-significant-warming/).

Die Basisüberlegung zum Berechnen des WI liegt darin (siehe oben), dass bei Erwärmung sich die Daten zur Referenzstation mehr und mehr angleichen, folglich muss auch der Umkehrschluss gelten, dass sich bei Abkühlung, die Temperaturen relativ mehr und mehr wieder voneinander entfernen. Da wir in Deutschland seit mehreren Jahren eine Abkühlung zu verzeichnen haben, kann dies überprüft werden. Dabei wurde nach zwei Kriterien vorgegangen:

1. Beginn der Erwärmungsphase, anhand der diversen national (siehe DWD-Kurve in Abbildung 6) und internationalen Temperaturreihen, ab 1980. Dies ist somit das erste Betrachtungsjahr zur Überprüfung der Aussage, dass sich auf Grund des WI in einer Erwärmungsphase die Werte zur Referenzstation angleichen und damit das Verhältnis abnimmt.

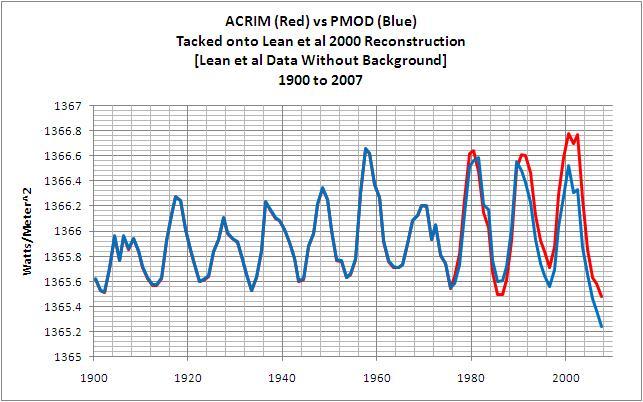

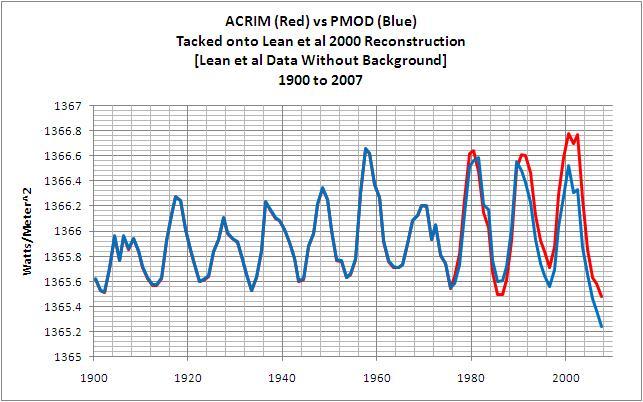

2. Ende der sonnenbasierten Erwärmungsphase in 2003. Hier hatte der Hauptsonnenzyklus sein (im Mittel) 208-jähriges Maximum und die NASA-Satellitenwerte der gemessenen und somit realen Sonnenaktivität, hatten um diesen Zeitraum ihr Maximum, wie die folgende Abbildung belegt:

Abbildung 8 zeigt die rekonstruierte Sonnenaktivitätskurve (blau, PMOD = Physikalisch-Meteorologisches Observatorium Davos) und die von NASA-Satelliten direkt gemessene Sonnenaktivitätskurve (rot, ACRIM = Active Cavity Radiometer Irradiance Monitor), Quelle: (http://bobtisdale.blogspot.com/2008/08/reference-graphs-total-solar-irradiance.html). Deutlich zeigen die direkten Satellitenmessungen, dass die solare Aktivität ab 1980, als global die Temperaturen (moderat) zu steigen beginnen, deutlich anzieht und unmittelbar nach der Jahrtausendwende, mit dem de Vries/Suess-Hauptsonnenzyklus ihr Maximum erreichen und anschließend, wieder parallel zu den Temperaturen, deutlich fallen.

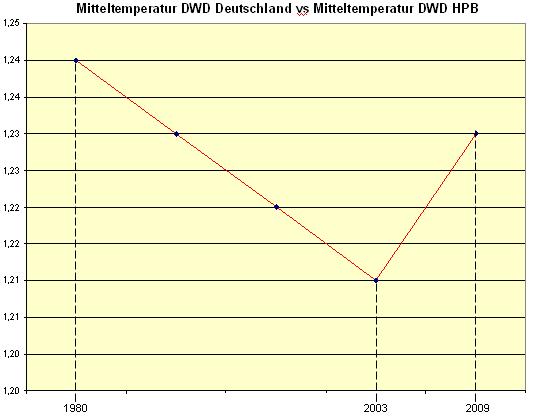

Unter Anwendung beider Punkte ergeben sich fünf 6-Jahresblöcke. Die Überprüfung ergibt folgende Tabelle:

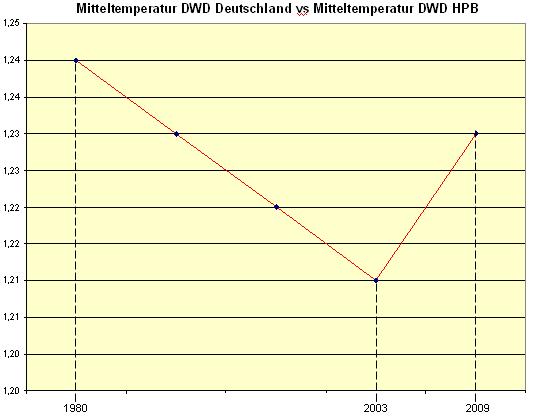

Dazu der Verlauf:

Abbildung 9 zeigt ganz deutlich, dass bis 2003, also in der gesamten sonnenbasierten Erwärmungsphase, das Verhältnis Deutschlandtemperatur zur Referenzstation (D/HPB) fällt und seit Beginn der Abkühlungsphase wieder ansteigt. Die Trendkurve bestätigt in eindrucksvoller Weise, den seit Beginn des 21. Jahrhunderts beobachteten Temperaturrückgang. Die Kurve steigt dabei viel schneller (doppelt so schnell), als sie vorher abfiel, d.h. nichts anderes, als dass wir derzeit einen schnellen Temperaturrückgang erleben, der durch den WI der Städte und Landschaftsveränderung gemindert wird und sich daher in den diversen Temperaturkurven des DWD nicht wiederfindet, aber von uns allen bereits erlebt wird – der letzte kalte und lange Winter und das insgesamt sehr kalte Jahr 2010. Die Kurve passt auch zu den Aussagen der NASA, russischer Forscherteams (http://de.rian.ru/science/20100423/126040500.html) und des SSRC (Space and Science Research Center)>zur erwartenden Sonnenaktivität und der daraus resultierenden Kälteepoche, die uns bevorsteht.

Fazit – Die Erwärmung ist vorbei

Mit einem dynamischen WI von derzeit +1,2°C liegen die heutigen Temperaturen auf dem Niveau zu Beginn der Messaufzeichnungen in den 80-Jahren des 19. Jahrhunderts, also auf einem Niveau, welches kurz nach den letzten Kälteepoche, die in der Wissenschaft als die “Kleine Eiszeit“ bekannt ist und bis ca. 1850 andauerte, erreicht wurde. Dies deckt sich übrigens mit der Aussage des Leiters der Wetterstation Ostalbwetterwarte:

„Zusammenfassend kann man sagen: Das vergangene Frühjahr war ein bisschen kühler als im langjährigen Mittel, deutlich kühler als im Mittel der zurückliegenden 16 Jahre und genau so warm oder kalt wie vor 150 Jahren“.>

Quelle: “Das Wetterglas“ Nr. 49 (http://www.wetterglas.de/Wetterglas/wg_49.PDF), und damit so kalt wie am Ende der “Kleinen Eiszeit“, der kältesten Epoche seit 2.000 Jahren!

Es ist daher dringend geboten, dass der DWD seine Temperaturdaten der Realität anpasst und Politik, Medien und insbesondere der Bevölkerung das wahre Temperaturniveau mitteilt. Und zwar das, was wohl jeder bereits wahrgenommen hat, dass es kälter geworden und die Zeit der Warmperiode vorbei ist und wir für die nächsten Jahrzehnte, wegen dem beobachteten starken Rückgang in der Sonnenaktivität (Abbildung 8) deutlich fallende Temperaturen bekommen.

Für die Politik ist es an der Zeit, das Gespenst der anthropogenen CO2-basierten Klimaerwärmung dorthin zu verfrachten, wo es hingehört, auf den Müllhaufen falscher (vermeintlich) wissenschaftlicher Theorien – da abgekoppelt von jeglicher beobachteter Realität und sich wieder den Themen zuwendet, die für unser Land und für unsere Gesellschaft essenziell sind. Bildung und Wissen sind hiervon nur zwei Begriffe. Eine Klimakönigin braucht unser Land nicht. Die Zeiten der Monarchie sind schon lange vorbei, wie die globale Erwärmung.

Der schleichende WI beim DWD, Zusammenfassung unserer beiden ersten Beiträge

Als Anhang für den eiligen Betrachter, eine kurze Zusammenfassung unserer ersten Beiträge, aus denen ersichtlich wird, warum der DWD in seinen Messreihen und damit Messstationen einen gemittelten WI von derzeit 1,2°C hat, der seine ganze Messreihe verfälscht.

Nach Angeben des DWD vom 10.06.2010 besteht sein Hauptamtliches Netz aus 182 Wetterwarten und an 531 Stationen werden nach unseren Informationen Lufttemperatur und- feuchte gemessen. Wir hatten 130 Messstationen des DWD an dessen eigenen Vorgaben für die Aufstellung und Betrieb solcher Stationen gespiegelt und dabei festgestellt, dass allein nach diesen Kriterien ca. 40% ungeeignet sind. Anbei einige Beispiele:

Eingangs hatten wir erwähnt, dass vermehrt Flughafenstationen in die Datenreihen einfließen. So lag allein 2009 der Anteil der „Flughafenmessstationen“ im globalen Temperaturnetzwerk des GHCN (Global History Climate Network), welches die globalen Temperaturreihen generiert, bei 41%! Somit sind deren Daten über globale Temperaturtrends ungeeignet. Bei näherer Betrachtung ist es logisch, dass Temperaturmessstationen auf Flughäfen, mit ihren vielen heißen Triebwerksabgasen für Messwerterfassungen im Zehntel-°C-Bereich ungeeignet sind. Kein Hausbesitzer käme auf die Idee, die Temperatur eines Wohnraumes unmittelbar an den Heizkörpern abzugreifen! Der DWD aber tut dies bei seinen Flughafenmessstationen.

WI auf Großflughäfen

Zur Qualifizierung und Quantifizierung ist zu beachten, wo sich die Temperaturmessstation auf dem Flughafengelände befindet, wie groß der Flugbetrieb, also die Flugbewegungen sind und welche Luftturbolenzen durch den Flugbetrieb auftreten. Die Höhe des Flugbetriebes bestimmt das Maß für den Wärmeeintrag der rund 600°C heißen Strahltriebwerksabgase in die Umgebungsluft. Die Luftturbolenzen zeigen, wie sich diese heißen Luftschichten verteilen und wie groß ihr Einzugsgebiet ist und der Aufstellort bestimmt, inwieweit die Messstation von diesen Turbolenzen oder sogar direkt von den heißen Abgasstrahlen der Jets beaufschlagt wird, wodurch sich in allen Fällen, der Messwert erhöht, also verfälscht.

Zur Bewertung der Luftturbolenz werden die in der Luftfahrt gefürchteten Wirbelschleppen herangezogen. Diese werden an den Tragflächenenden von Flugzeugen infolge des unterschiedlichen Drucks an Flügelunter- und Flügeloberkante erzeugt. Die Höhe der Druckdifferenz hängt von der Flugzeugeigengeschwindigkeit, dem Tragflächenprofil und dem Anstellwinkel ab. Die Stärke der Wirbel vom Flugzeuggewicht. Wirbelschleppen bestehen aus entgegengesetzt rotierenden Luftmassen. Sie dehnen sich rückwärts und nach unten(!) aus. Wirbelschleppen können für nachfolgende Luftfahrzeuge sehr gefährlich sein, da sie die sonst laminare Strömung extrem stören und es so zu einem Strömungsabriss kommen kann. Aus diesem Grund müssen nachfolgende Flugzeuge einen Abstand zum voraus fliegenden Flugzeug auf gleicher Höhe von 5 – 12 km halten.

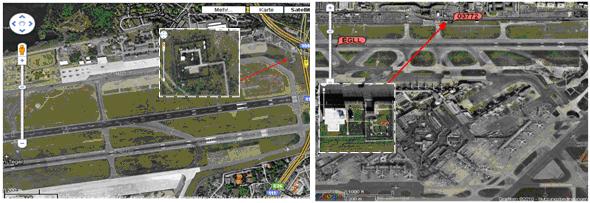

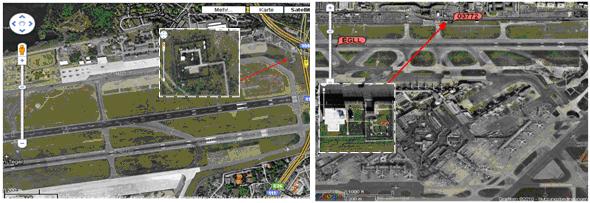

Wo liegt die DWD-Temperaturmessstation auf dem Flughafen Frankfurt?

Auch auf Berlin-Tegel oder London-Heathrow ergibt sich prinzipiell das gleiche Bild.

Abbildung 18 links zeigt die Temperaturmessstation auf Berlin-Tegel (roter Pfeil). Gut erkennbar, dass die Station unter 100m vom Rollfeld entfernt liegt und ca. 270m von der Start- und Landebahn. Abbildung rechts zeigt die Temperaturmessstation auf London Heathrow (roter Pfeil). Mit einem Abstand von knapp 200m ist die Wetterstation zwar grundsätzlich besser platziert, als in Frankfurt Rhein-Main, jedoch ist auch hier der Abstand zu den heißen Luftturbulenzen auf Grund der Wirbelschleppen viel zu gering. Es ist festzuhalten, dass die Wetterstation deutlich zu hohe Werte liefert (die Mitteltemperatur lag 2009 in Heathrow bei 11,9°C, gegenüber 9,17°C der Jahresmitteltemperatur von Großbritannien). Ein Unterschied von gut 2,5°C, was dem WI-Wert von Frankfurt Rhein-Main sehr nahe kommt.

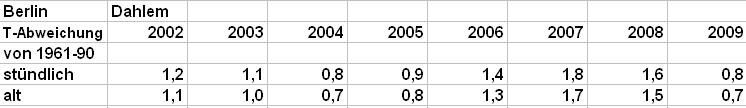

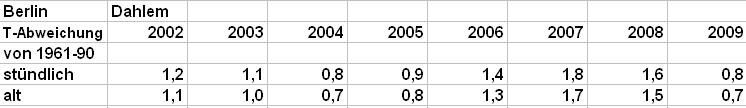

Darüber hinaus hat der DWD zum 01. April 2001 (kein Aprilscherz) die Datenerfassungsmethode grundlegend geändert. Bis zu dem Datum wurde am Tag dreimal gemessen (um 7,30 Uhr, 14,30 Uhr und 21,30 Uhr – letzter Wert wurde doppelt gewertet, weil man sich den vierten Wert in der Nacht sparen wollte) und seither stündlich. Wegen der starken Asymmetrie des Temperaturtagesganges können beide Verfahren grundsätzlich keine gleichen Ergebnisse liefern. Durch das neue Verfahren werden die Mitteltemperaturen um mindestens 0,1°C autom. angehoben, obwohl sich an den gemessenen Temperaturen überhaupt nichts ändert.

Die Datenreihe zeigt die Temperaturabweichung (nach oben) der DWD-Station in Berlin-Dahlem nach der alten und nach der neuen Methode.

Nicht nur, dass der DWD offensichtlich mit Taschenspielertricks die Temperaturen künstlich in die Höhe treibt, seine eigenen Vorgaben für die Aufstellung und den Betrieb von Wetterstationen missachtet und nicht einmal den WI seiner eigenen Stationen kennt, scheint er nicht einmal wahrzunehmen, was er eigentlich misst und was er womit vergleicht.

Links zu den WI-Artikeln Teil 1 und Teil 2

http://www.eike-klima-energie.eu/klima-anzeige/der-waermeinseleffekt-wi-als-antrieb-der-temperaturen-eine-wertung-der-dwd-temperaturmessstationen/?tx_ttnews[pointer]=2

und

http://www.eike-klima-energie.eu/klima-anzeige/was-sind-temperaturmessungen-auf-grossflughaefen-wert-oder-wie-das-zdf-mit-bewusst-falschen-temperaturaussagen-die-oeffentlichkeit-taeuscht-und-die-abkuehlung-in-deutschland-verschleiert/?tx_ttnews[pointer]=1

Raimund Leistenschneider – EIKE

Josef Kowatsch – Hüttlingen

Anlage

In der Dateianlage finden Sie die Excel-Liste der Jahreswerte und der WI-Berechnung

Related Files

Anlage.

Anlage. Ameling,

Ameling,  Carter ,

Carter ,  Limburg,

Limburg,  Puls,

Puls,  Ewert,

Ewert,  Lüdecke

Lüdecke  Courtillot,

Courtillot,  Haas,

Haas,  Haas Manuskript,

Haas Manuskript,  Peters,

Peters,  Kirstein

Kirstein  Ederer,

Ederer,  Plimer ,

Plimer ,  Veizer

Veizer  Borchert weitere werden folgen

Borchert weitere werden folgen