Phoenix-Runde Teil II: „Kein prima Klima – Ist die Welt noch zu retten?“ Ein Faktencheck!

Zum besseren Vergleich der Argumente finden Sie hier nochmals das Video (mit freundlicher Genehmigung von PHOENIX)

Sendung vom 9.12.10 „Ist die Welt noch zu retten“ (Mit freundlicher Erlaubnis von Phoenix)

4. Der Glaube an statistisch gesicherte historische Wetteraufzeichnungen.

Moderator Kähler sprach es aus: (Wir haben) …seit Ende des 19. Jh. statistisch gesicherte Wetteraufzeichnungen.(4:52). Bott ging sogar noch einen Schritt weiter und sprach von Proxydaten, die noch frühere Aussagen zur (Welt)-Temperatur zulassen würden.

Wie ist der Sachstand?

Basis jeder Naturwissenschaft ist die Messung, dann folgt die Klassifizierung, dann die Zuordnung, dann die Hypothese – die wird dann zur Theorie, wenn genügende Beweise vorliegen -, dann die Vorhersage, gemäß dieser Theorie. Wir sind in Phase 1, der Messung der Temperatur in der Luft. Seit über 300 Jahren wird in Europa die Lufttemperatur gemessen. Anfangs aus Neugier, kurze Zeit später schon aus dem wissenschaftlichen Erkenntnisdrang heraus, zu finden, wie sich denn das Wetter entwickelt, das alle Lebensumstände von Mensch und Tier von Anbeginn der Zeit an stark beeinflusst. Oder auch, um zu ermitteln, ob sich hinter den gemessenen Zeitreihen Gesetzmäßigkeiten verbergen, die es u.U. erlauben würden, Wettervorhersagen zu machen. Schönwiese [Schönwiese, 2000] datiert die Thermometererfindung auf 1611 und schreibt sie – bewusst vage – Galileo zu. Zur damaligen Erfassung schreibt er: Die ersten regelmäßigen Messungen [1] und Aufzeichnungen der Lufttemperatur erfolgten in Florenz und Pisa von 1653 bis 1670 durch die Academia del Cimiento. Deren Messungen waren für ihre Zeit schon sehr fortgeschritten…. Im 18. Jahrhundert und weitestgehend auch im 19. Jh. waren die Thermometer sehr ungenau, ihre Aufstellbedingungen unheitlich (wie auch heute) und die Messergebnisse mit hohen Unsicherheiten behaftet. Für meteorologische Zwecke bedingt brauchbar, für klimatologische Zwecke unbrauchbar. Mit der Einführung des Assmanschen Aspirationsthermometers 1892 war wenigstens ein hinreichend genaues Messinstrument geschaffen, das unter gleichen Umständen Vergleichbares lieferte. Es wurde daraufhin weltweit eingesetzt, allerdings erst an wenigen Stellen.

Abbildung 6 nach Peterson et. al [Peterson, 1997]: Die Zeitreihe zeigt die Zahl von Mess-Stationen, deren Daten nach verschiedenen Mittelwertalgorithmen zur Temperaturbestimmung in die GHCN Datenbank einbezogen wurden (schwarze Line) und, darin enthalten, solchen (gestrichelte Linie) Stationen mit Max/Min Ablesung.

Die Abbildung 6 zeigt die Anzahl der Stationen, die vom IPCC (hier aus Peterson et. al 1997) in seine Durchschnittsberechnung der Welttemperatur einbezogen wurden. Allein schon aus der absoluten Zahl der Stationen ist zu erkennen, dass eine weltweite Abdeckung nicht gegeben sein kann. Noch nicht einmal der Landmasse allein, die nur 29 % der Eroberfläche ausmacht. 40 % der Landmasse befinden sich auf der Nordhalbkugel, nur 20 % auf der Südhalbkugel. Diese ist also messtechnisch, von wenigen Orten abgesehen, ziemlich unbekannt.

Allein damit ist noch nichts über die Qualität der Messungen gesagt. Die war trotz des Assmann-Thermometers mäßig bis sehr mäßig. Am Besten charakterisiert diese Qualität der Meteorologe und CRU Programmierer Ian (Harry) Harris. Sie sind in der Datei „HARRY_READ_Me.txt.“ der Cimategate Emails enthalten. Diese ist 274 Seiten lang. Die dazugehörige Datenbasis enthält über 11.000 Dateien aus den Jahren 2006 bis 2009 [2].

Harry ist der Spitzname, mit dem der Klimatologe Ian Harris seine Arbeit zeichnete. Ian Harris, ein Gläubiger der Erwärmungshypothese und Anhänger der Grünen, wurde in der CRU als Programmierer eingesetzt, der die vielen Datensätze aus den weltweiten Messstationen zur statistischen Auswertung und Zusammenfassung aufbereiten sollte. Da es sich um Millionen, zum guten Teil nur verstümmelt vorliegende Daten handelt, ist das nur per Computer und geduldigem Zusammentragen von allerlei Zusatzdaten möglich. Hierzu gehört dazu eine gehörige Portion Spürsinn und wie wir sehen werden, auch „Kreativität“:

„Aber was sind dies alles für monatliche Dateien? Ich weiß nichts, alles undokumentiert, wohin ich auch schau, da sind Dateien, keine Infos darüber, was sie sind, anders als ihre Namen. Und das ist sinnlos …“ (Seite 17)

– „Es ist Pfusch über Pfusch über Pfusch.“ (18)

– „Oh, Gott, wenn ich dieses Projekt erneut starten und tatsächlich über diesen Fall mit der geerbten Müll-Programm-Suite streiten könnte.“ (37)

– „Bin ich der erste Mensch, der den Versuch macht, die CRU-Datenbanken in Ordnung zu bekommen?!“ (47)

– „Soweit ich sehen kann, macht dies die (Wetter-) Stations Zählung völlig sinnlos.“ (57

– „Cobar AIRPORT AWS (Daten aus einer australischen Wetterstation) können nicht im Jahr 1962 begonnen haben, sie sind erst seit 1993 in Betrieb!“ (71)

– „Was zur Hölle soll hier passieren? Oh yeah – es gibt kein „angenommenes ich kann es machen“. Also tat ich es: -)“ (98)

– „Du kannst dir nicht vorstellen, was mich dies kostete – tatsächlich dem Operator zu erlauben, auf falsche WMO (World Meteorological Organization)-Codes zu verweisen. Aber was soll man sonst in solchen Situationen machen? Gerade im Umgang mit einer „Master“-Datenbank zweifelhafter Herkunft … “ (98)

– „Also, mit einem leicht zynischen Achselzucken habe ich noch die atomare Option – jedem möglichen WMO Treffer zuzuordnen, und den Rest einfach auf neue Stationen zu verteilen… mit anderen Worten, was man bei der CRU sonst auch tut. Dies erlaubt es, schlechten Datenbanken unerkannt zu bleiben und guten Datenbanken zu schlecht zu werden … “ (98-9)

– „Ach F — das. Es ist Sonntag Abend, ich habe das ganze Wochenende gearbeitet, und gerade als ich dachte, es fertig zu haben, treffe ich noch auf ein weiteres Problem, auf dem der hoffnungslos Zustand unserer Datenbanken basiert.“ (241).

– „Das ganze Projekt ist so ein Durcheinander …“ (266)

Und auf Sachen wie diese wollen die Politiker unsere Wirtschaft die Luft sprengen und unseren Lebensstandard abzusenken, um „das Klima“ zu reparieren?

Sind die verrückt?

Soweit die Kommentare des leicht überfordert wirkenden Harry. Selbstverständlich sind das noch keine Beweise dafür, dass die gemeldeten Temperaturdaten alle unbrauchbar waren. Das sind sie wahrscheinlich nicht. Auf jeden Fall sind diese Seufzer und Flüche aber ein klarer Hinweis darauf, dass die vermeintlich gesicherten, weltweit oft nur spärlich verfügbaren Temperaturdaten, mit sehr viel größeren Unsicherheiten (sprich Fehlermargen) behaftet sind, als es uns die nur scheingenaue Temperaturkurve des IPCC (erstellt aus eben diesen Daten, wie oben beprochen) glauben machen will. Wer nähere Auskünfte dazu haben will, wende sich an den Autor dieser Zeilen.

5. Ist die Mehrzahl der Klimaforscher wirklich von der anthropogenen Erwärmung überzeugt?

Dieser Überzeugung waren alle Teilnehmer der Runde – mit Ausnahme des Autors:

Fischer: (Limburg vertritt) Splittermeinung (9:37) (sie ist) nicht repräsentativ, von div. Gremien überprüft 1000-ende Wissenschaftler seien überzeugt. Bott: (11:38) man spricht von 97%, die hinter dem IPCC Bericht stehen.

Dagegen Limburg: Widerspruch (10:22) In WGI sind nur ca. 40 bis 60 Autoren der harte Kern. Als Beleg wurde Prof. Mike Hulme zitiert: 1000 Wissenschafter votierten jüngst wieder dagegen (11:19)

Schauen wir uns die Fakten der Reihe nach an.

1. Mehrheit der Wissenschaftler dafür?

Behauptet wird: „Die überwältigende Mehrheit der Wissenschaftler seien dieser Ansicht, es herrsche gar Konsens“. Vorab darf nüchtern festgestellt werden, dass Konsens in der Politik – besonders in einer Demokratie – eine gute Sache sein kann, die politische Handlungen legitimiert. In der Wissenschaft mag Konsens ein nützlicher Nebeneffekt sein, kann aber keinesfalls als Ersatz für fehlende Beweise dienen. Ja, Konsens ist oft sogar äußerst gefährlich und verhindert wirksam die Erkenntnis der wahren Zusammenhänge. Das ist wohl auch der Hauptgrund warum – voran der Demagoge Al Gore und seine Apologeten -, aber auch fast alle Politiker das Wort Konsens in Sachen Klima so lieben. Oft wurde schon Konsens behauptet. Erinnern wir uns doch nur: Die Erde sei eine Scheibe, die Sonne bewege sich um die Erde, an die Phlogiston-Theorie (Flammen bestünden aus einem besonderen Stoff, dem Phlogiston), an die Äthertheorie, an die Zurückweisung der Kontinentalverschiebungstheorie, an die Zurückweisung der Relativitätstheorie, an die Zurückweisung der Theorie über Bakterien als Ursache von Magengeschwüren und, und, und..-

Die Liste der Konsensthesen, die sich als falsch erwiesen haben, ist schier endlos. Konsens ist kein Ersatz für wissenschaftliche überprüfbare Beweise: Von Albert Einstein ist folgender Ausspruch überliefert, als er mit der Behauptung konfrontiert wurde, dass 200 arische Wissenschaftler seine Relativitätstheorie widerlegt hätten. Seine kurze Antwort darauf: Wenn sie recht hätten, genügte einer!

Tatsache ist aber außerdem, dass sich nicht einmal die Mehrheit der Wissenschaftler (Klimaforscher im engen Sinne gibt es nicht) aus klimarelevanten Disziplinen der AGW-Katastrophenhypothese des IPCC anschließen. Mehr noch, sehr, sehr viel sind dagegen. Eike hat über das brisante Thema „Konsens“ bereits ausführlich berichtet. Konsens gibt es im hier besprochenen Zusammenhang nicht!

Dies bestätigt auch Prof. Mike Hulme, Meteorologe und Direktor des Gründungs Direktor des Tyndall Centers in England, zudem an der Universität von East Anglia beschäftigt, außerdem Leitautor des IPCC. Er hat dazu kürzlich folgendes gesagt (veröffentlicht in der National Post ) und zusätzlich in einem Aufsatz – zusammen mit seinem Studenten Martin Mahony – für die Fachzeitschrift „Progress in Physical Geography“ geschrieben:

„Das UN-Intergovernmental Panel on Climate Change führte die Presse und Öffentlichkeit mit der Behauptung in die Irre, dass Tausende von Wissenschaftlern seine Ansprüche auf die vom Menschen verursachte globale Erwärmung unterstützen. Die tatsächliche Zahl der Wissenschaftler, die diese Behauptung unterstützen, seien nur ein paar Dutzend Experten“

„Behauptungen, wie 2500 der weltweit führenden Wissenschaftler seien im Konsens darüber, dass menschliche Aktivitäten einen signifikanten Einfluss auf das Klima haben, sind unaufrichtig. Das macht das IPCC anfällig für Kritik von außen.“

Woher kommt die Zahl 97 % ?

Die Zahl geht wohl auf einen vor kurzem veröffentlichten Beitrag von Frau Cordula Meyer im ehemaligen Nachrichtenmagazin der Spiegel zurück (http://www.spiegel.de/spiegel/0,1518,721168,00.html9 , die darin wörtlich schrieb:

„Nach einer US-Studie gehen 97 Prozent aller Klimatologen weltweit davon aus, dass sich die Erde durch von Menschen produzierte Treibhausgase erwärmt.“

Sie hatte sie wahrscheinlich von Stefan Rahmstorf. Der hatte die Zahl 97 % im März 09 im Artikel (Klimaforscher-Konsens 97%) auf wissenlog.de in die Welt gesetzt.

Rekapitulieren wir doch einmal, wie Stefan Rahmstorf zu diesen 97 Prozent kommt: Er beruft sich dabei auf eine EOS-Umfrage – EOS Volume 90, Number 3, 20 January 2009 – nach der 10.257 Wissenschaftlern angeschrieben wurden. Sie sollten die Fragen beantworten:

1. Verglichen mit dem Pegel vor 1800, glauben Sie dass die globale Mitteltemperatur eher gestiegen, gefallen oder relativ gleich geblieben ist?

2. Glauben Sie, dass der menschliche Anteil eine signifikanten Anteil an der Änderung der globalen Mitteltemperatur hat?

Insgesamt beantworteten 3146 Personen diese allgemein gehaltenen Fragen, das sind 30,7 %.

96 % der Antwortenden stammten aus den USA und Kanada, der Rest verteilt sich auf 21 Nationen. Ungefähr 5 % der Antwortenden wurden von den Verfassernder Umfrage als Klimaforscher eingestuft.

90 % der Antwortenden glauben, dass die Mitteltemperatur gestiegen ist, (wie wir auch) und 82 % bejahten die Frage 2.

Eine Gruppe von 79 Personen (oder 0.77%, der Befragten, bzw. 2,5 % der Antwortenden) stuften sich selbst als Spezialisten auf dem Gebiet des Klimawandels ein, weil sich 50 % oder mehr ihrer (peer- reviewed) Veröffentlichungen in irgendeiner Weise mit dem Thema Klimawandel befassten. Von diesen bejahten die Frage 2 76 Personen, das sind 97,4 %.

Da also kommen die 97 % her!

Aber 7.111 angeschriebenen Forscher haben keine Antwort gegeben !!!

(Mit Dank an Leser: Ralph Bombosch).

Wie aus den Fragen überhaupt eine 97 % ige Zustimmung zum „überwiegend“ anthopogen verursachten Klimawandel gemacht werden kann bedarf schon einer gehörigen Dehnung der Aussage der Studie. Weltweit war die Zustimmung auch nicht, wenn 96 % der Antwortenden aus nur 2 Ländern stammten. Und erst recht stimmt die Aussage nicht von 97 % aller Klimaforscher weltweit, wenn tatsächlich nur 76 der 3146 Personen – das sind 2,4 % – aller Antwortenden- sich selbst als Spezialisten auf dem Gebiet des Klimawandels einstuften.

Ist aber die Mehrheit der Wissenschaftler dagegen?

Diese Frage ist sehr schwer zu beantworten, da keiner weiß, wie viele Wissenschaftler sich heute in der Querschnittsdisziplin Klimaforschung betätigen. Man kann aber die Zahl derer angeben, die sich früher oder heute gegen diese These ausgeprochen haben. Das haben wir in diesem Beitrag „SPIEGEL vs. EIKE: Häme und Verleumdungen anstatt „Schreiben was ist“ (hier) ausführlich getan. Danach sind es zigtausende. Jüngst haben sich wieder tausend geäußert wie man hier nachlesen kann. More Than 1000 International Scientists Dissent Over Man-Made Global Warming Claims – Challenge UN IPCC & Gore.

6. Treibt CO2 die Temperatur oder ist es umgekehrt? Was taugen Klimamodelle? Teil I

Bei allen anderen Teilnehmern der Runde herrschte unbedingte Einigkeit darüber, dass eine vom Menschen verursachte Erhöhung der CO2-Konzentration in der Atmosphäre höchst klimaschädlich sei und deshalb dringend seine starke Reduzierung geboten sei. Hier manifestierte sich der immer wieder zu hörende Irrtum über die Wirkung des CO2. Nach der gängigen Treibhausthese ist CO2 vielleicht das (nach dem Wasserdampf) stärkste Treibhausgas, aber hierauf kommt es nicht an. Es kommt darauf an, welche globale Temperatursteigerung möglicherweise erfolgen würde – so die These stimmt-, wenn sich seine Konzentration in der Erdatmosphäre erhöht. Und diese potentielle Temperatursteigerung wäre praktisch verschwindend gering, denn die Infrarotabsorption von CO2 ist bereits gesättigt. Vergleicht man seine potentiell erwärmende Wirkung populär mit einer sehr gut isolierenden Pudelmütze, so wärmen zwei Pudelmützen übereinander auch nicht wesentlich besser als eine. Viele klimafachnahen Naturwissenschaftler – Gegner und Befürworter der AGW-Hypothese gleichermaßen – nennen grob 1 °C globale Erwärmung bei CO2-Verdoppelung (man bezeichnet diese Größe als „Klimasensitivität des CO2“). Sie wäre daher völlig unbedenklich und keiner Rede oder gar weiteren Auseinandersetzung wert, denn sie wäre vernachlässigbar. Man könnte dann mit Fug und Recht auch von einem „Nulleffekt“ sprechen. Die Menschheit müsste schon alle fossilen Reserven verbrennen, um CO2-Verdoppelung zu erreichen, wozu es nicht kommen wird. Die vom IPCC und seinen Anhängern beschworenen, viel größeren Erwärmungswerte basieren auf fiktiven Rückkoppelungen in noch fiktiveren Modellen, die inzwischen durch Messungen weitgehend widerlegt sind. EIKE hat über das Thema des potentiellen Treibhauseffekts und die mögliche Wirkung des CO2 bereits ausführlich berichtet.

Bevor wir uns also den Modellen zuwenden, welche einen vermuteten Katastrophalzusammenhang als Tatsache unterstellen und ihre Gleichungssysteme darauf aufbauen, wollen wir uns erst einmal die Vergangenheit anschauen, ob sich dort in den Beoabachtungsdaten eine Abhängigkeit zwischen CO2-Konzentrationen und Temperaturen erkennen lässt.

Tatsache ist, dass aus den Beobachtungen der jüngsten, der jüngeren und der ganz langen Zeit zwischen Temperatur und CO2 keinerlei Ursache-Wirkungsbeziehung festgestellt werden kann. Eine Ausnahme bilden die Temperaturproxies aus den Eisbohrkernen, dort aber läuft die CO2 Konzentration der Temperatur im Schnitt 800 Jahre nach. Dahinter steht ein wohlbekannter Prozess, nämlich, dass kaltes Wasser mehr CO2 lösen kann als warmes Wasser und das Weltmeer etwa die Zeit von grob 800 Jahren benötigt, um sich vollständig umzuwälzen.

Abbildung 7: Verlauf von Proxydaten der Temperatur und der CO2 Konzentrationen aus Eisbohrkernmessungen für letzten 400.000 Jahre. Darin eingezeichnet die höher aufgelöste Graphik der letzen 8000 bis 22.000 Jahre. Deutlich ist die Nach-Eilung der CO2 Konzentration im Vergleich zu den Temperaturen zu erkennen.

Abbildung 7: Verlauf von Proxydaten der Temperatur und der CO2 Konzentrationen aus Eisbohrkernmessungen für letzten 400.000 Jahre. Darin eingezeichnet die höher aufgelöste Graphik der letzen 8000 bis 22.000 Jahre. Deutlich ist die Nach-Eilung der CO2 Konzentration im Vergleich zu den Temperaturen zu erkennen.

Da mit den temperaturabhängigen Lösungseigenschaften des CO2 in Wasser die Proxy-Befunde bestens erklärt sind, müssen alle Versuche neuer Hypothesen als Verstoß gegen das Ockham-Prinzip angesehen werden. Es besagt, dass zur Erklärung eines physikalischen Phänomens, falls schon vorhandene, bekannte Gesetzmäßigkeiten völlig ausreichen, keine neuen Hypothesen aufgestellt werden dürfen (Entia non sunt multiplicanda präter necessitatem).

Abbildung 7 zeigt einen solchen Fall für die letzten 400.000 Jahre. Proxydaten aus Eisbohrkernen lassen die sehr grobe Bestimmung der am Bohrloch früher herrschenden Temperatur- und CO2 Konzentrationen zu. Sie reichen heute bis ca. 800.000 Jahre zurück. Al Gore benutzte eine derartige Grafik in seinem mit Unwahrheiten und Propagandatricks vollgestopften Film „Eine unbequeme Wahrheit“.

Leider vergass der den Zuschauern und mit ihnen allen Medienschaffenden mitzuteilen, dass darin die Ursache-Wirkungskette genau anders herum zu erkennen ist. Erst kommt die Temperatur, dann das CO2. Aber selbst diesen Zusammenhang zeigen die jüngsten Temperatur- und CO2 Verläufe nicht. Wie die folgende Abbildung beweist.

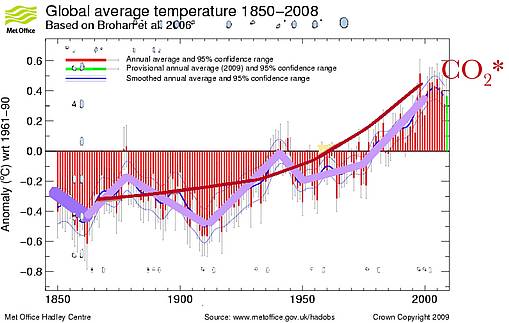

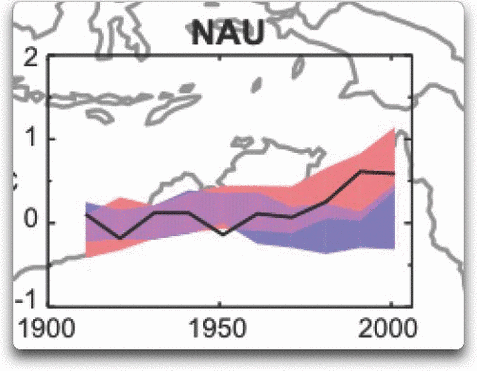

Abbildung 8: Hier wird die offizielle IPCC Temperaturkurve (blaue Linie) mit der ebenso offiziellen CO2-Konzentration (bis 1955 aus Eisbohrkernen, danach vom Mauna Loa direkt gemessen) überlagert. (dicke rote Kurve). Die dicken lila Balken, sollen die Richtung des Temperaturtrends verdeutlichen.

Man erkennt in Abb. 8, dass es zumindest seit 1850 keine ausreichende Korrelation zwischen beiden Größen gibt. Laut THE (Treibhauseffekt)-These, machmal auch als AGW-Hypothese (anthropogenic global warming hypothesis) bezeichnet, müsste es eine gute positive Korrelation beider Größen geben. Mehr CO2 ergibt höhere Temperatur. Oder wie Rahmstorf es beschrieb:

Wir Klimaforscher können nur nach dem Wenn-dann-Prinzip sagen: Wenn so und so viel CO2 ausgestoßen wird, dann wird das Klima sich so und so stark erwärmen.“[3]

Vom Rahmstorfschen „Wenn-Dann“ keine Spur! Die Korrelation CO2-Temperatur ist miserabel. Inzwischen wissen wir, dass der Anstieg der Temperatur ab 1990 beendet war und bis zum heutigen Tage einem Plateau und leichten Abstieg Platz machte. Auch Phil Jones, der „Held“ der ClimateGate Affaire, Direktor der CRU (Climate research Unit), IPCC Leitautor und Haupttreiber der Idee von der anthopogenen induzierten globalen Erwärmung, sprach von keiner signifikanten Erwärmung mehr seit 1995 [4]. Zum selben Ergebnis kommen auch Prof. Richard Lindzen und mit einigen Abstrichen Prof. Mojib Latif vom Geomar, um nur zwei weitere prominente Forscher zu nennen.

Was also ist das für ein merkwürdiger Prozess, der stetig sein soll, aber ständig seine Befürworter narrt?

Angesichts dieser Sachlage wird umso deutlicher erkennbar, warum der Chef der britischen Wetterbehörde Met Office, Sir John Mitchell (dem deutschen DWD vergleichbar) 2007 feststellte:

“It is only possible to attribute 20th Century warming to human interference using numerical models of the climate system.”[5]

So ist es! In der messtechnischen Realität ist dieser Prozess nicht zu beobachten.

Wird fortgesetzt.

Michael Limburg, Prof. Dr. Horst-Joachim Lüdecke

[1] Aus : http://www.freunde-alter-wetterinstrumente.de/21theein01.htm#in%20Deutschland

[2] Details entnommen aus ‚Botch after botch after botch‘ Leaked ‚climategate‘ documents show huge flaws in the backbone of climate change science By LORRIE GOLDSTEIN

[3] Zitat aus „Die Welt“ vom 3.2.2007

[4] Quelle hier http://news.bbc.co.uk/2/hi/science/nature/8511670.stm Bewertung hier: http://wattsupwiththat.com/2010/02/14/phil-jones-momentous-qa-with-bbc-reopens-the-science-is-settled-issues/

[5] John Mit chell, Ju lia Slin go, Da vid S. Lee, Ja son Lowe & Vicky Pope: ‘CLI MA TE CHANGE Re spon se to Car te r et al.’, World Eco no mics, 8 (1): 221228.

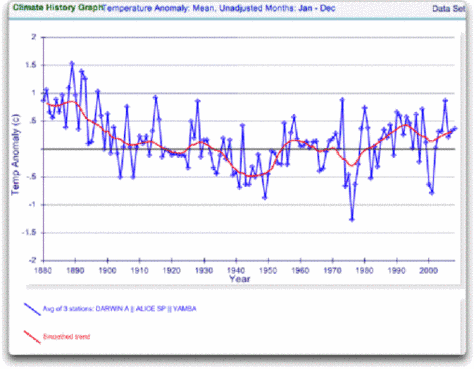

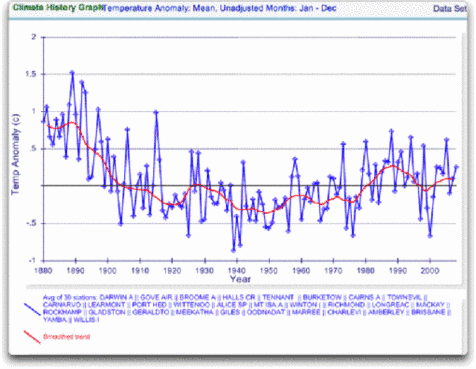

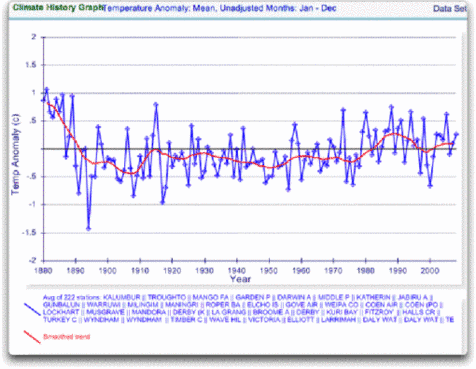

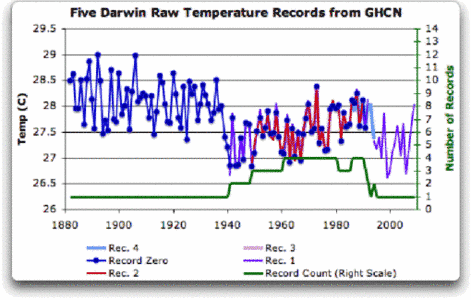

Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung

Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung

Abb. 4. GHCN Rohdaten. Alle Stationen bis 2000 im IPCC Gebiet.

Abb. 4. GHCN Rohdaten. Alle Stationen bis 2000 im IPCC Gebiet.

richter.c@zdf.de

richter.c@zdf.de