Das Temperaturdilemma!

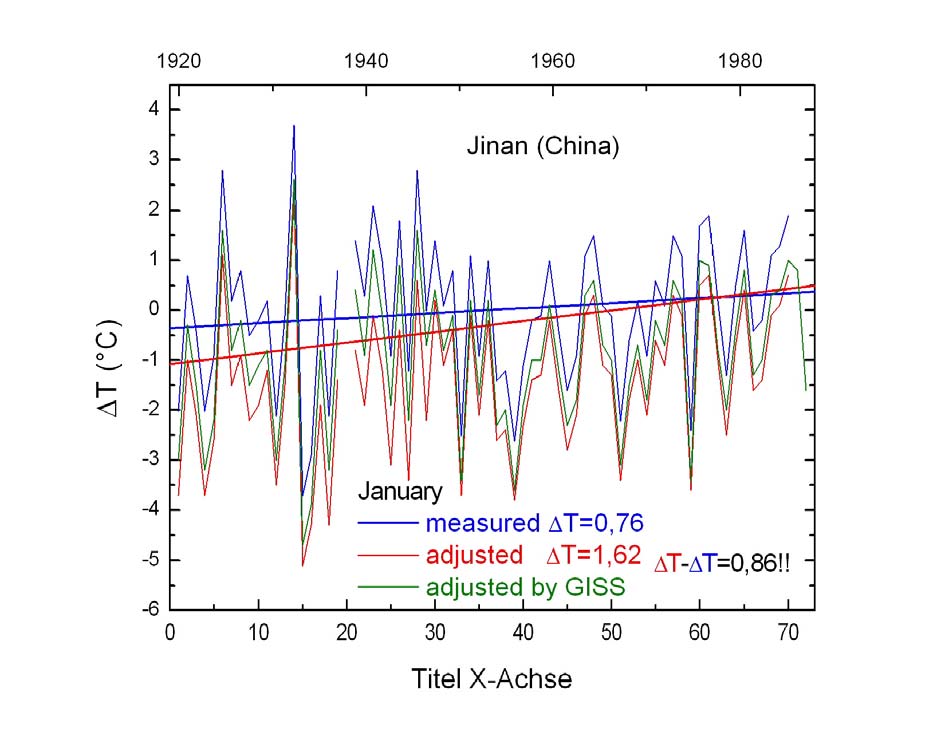

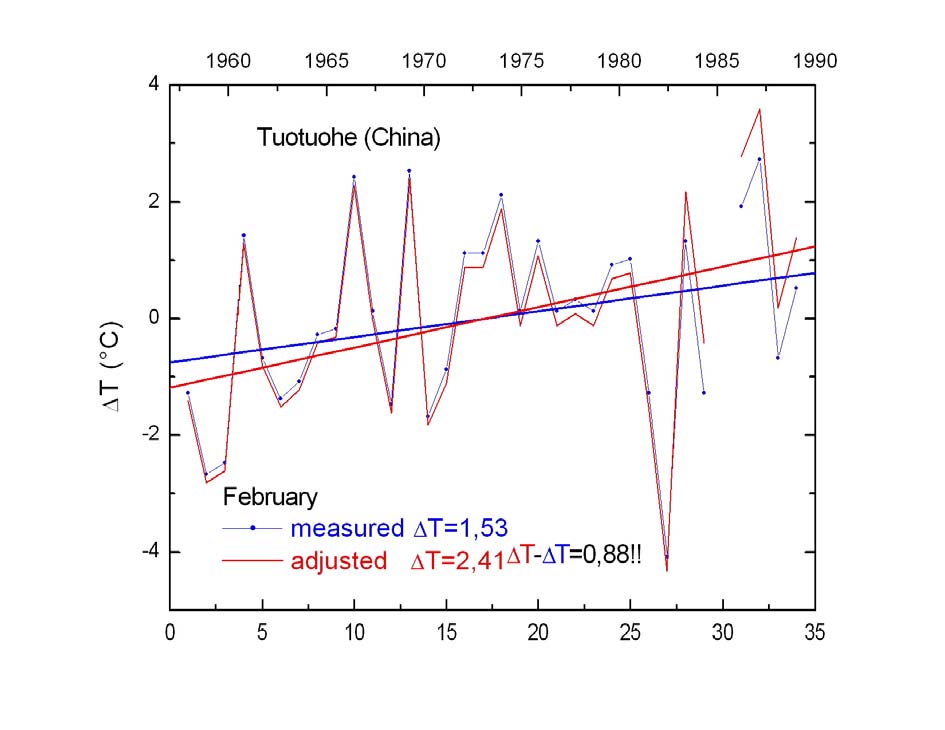

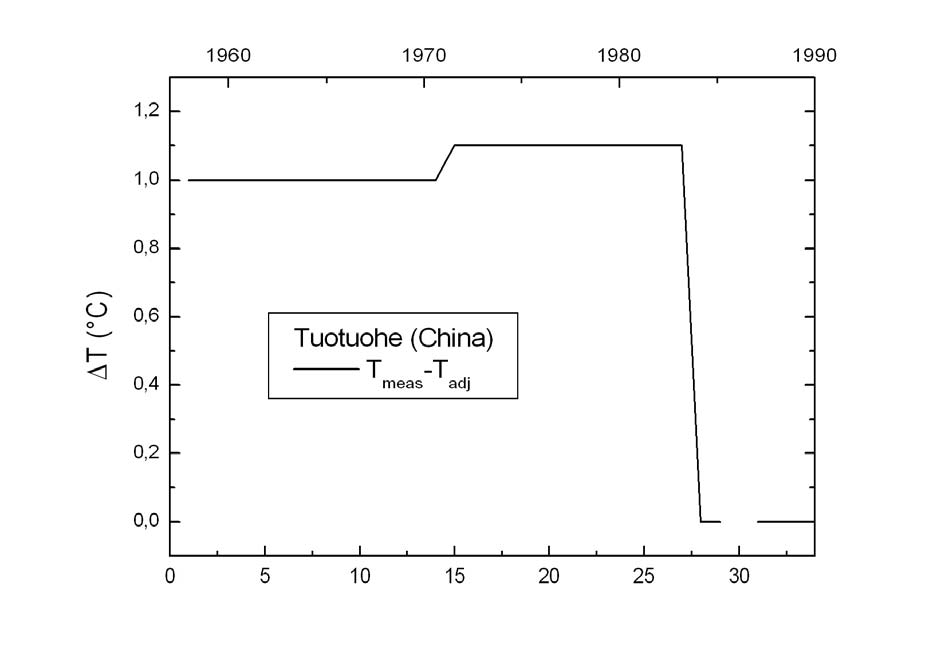

Was bedeutet überhaupt angepasst? Nun das GHCN (Global Historical Climate Network) nennt dies homogenisieren und versteht darunter Messfehler, Ortsveränderungen der Messstationen etc. zu entfernen. Hierzu werden die nächsten fünf Stationen ausgewählt, wenn sie we-nigstens eine 20 Jahre lange übereinstimmende Messreihe haben und wenn die Korrelation zwischen beiden 0.8 oder größer ist. Dies klingt sehr vernünftig, scheint aber in der Praxis anders gehandhabt zu werden. Einige Beispiele sollen dies illustrieren.

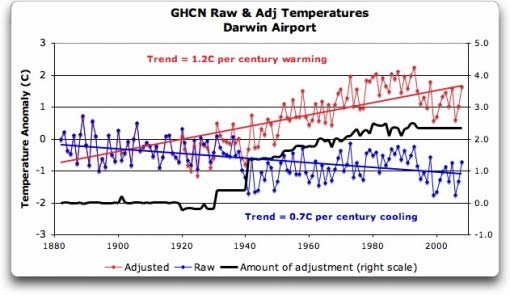

1. Darwin zero (Australien) von Willis Eschenbach.

Die blaue Kurve beinhaltet die gemessenen Werte, während die rote aus der Homogenisierung folgt. Aus einer Abnahme von 0.7°C wurde ein Anstieg von 1,2°C pro Jahrhundert gemacht. Die nächste Station, die die obigen Kriterien erfüllt ist aber 500km entfernt. Eschenbach, der dies herausfand, spekulierte, dass dies ein Einzelfall sein könnte. Hier ist die ganze Story

http://wattsupwiththat.com/2009/12/08/the-smoking-gun-at-darwin-zero/:

Es gibt aber offensichtlich mehr Einzelfälle.

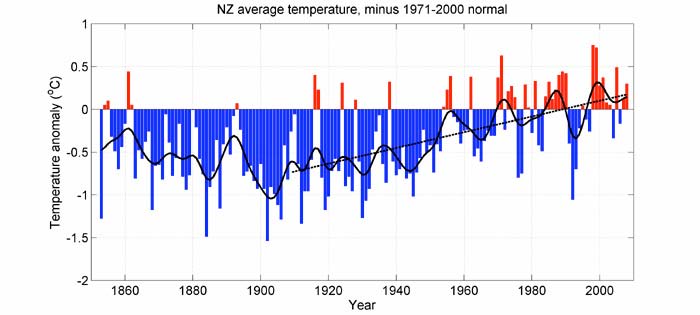

Zum Beispiel Neuseeland. Die folgende Graphik stellt den angepassten Temperaturverlauf dar, welcher einen deutlichen Anstieg besitzt.

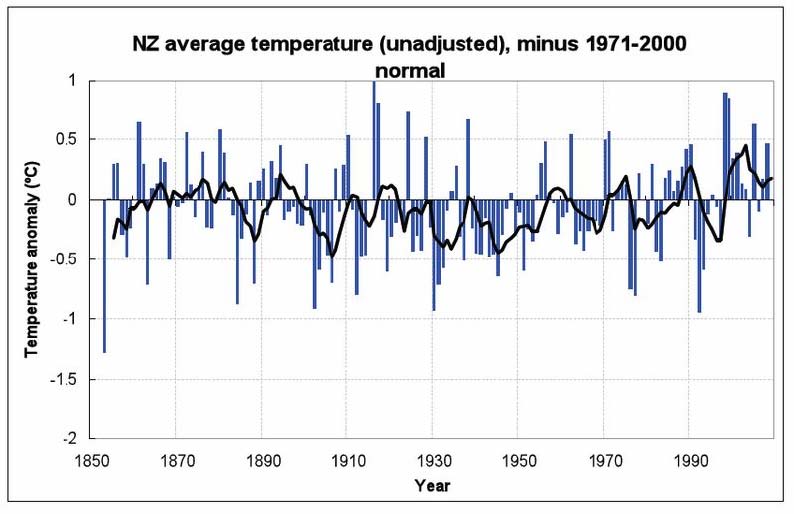

Die ganze Dramatik verschwindet allerdings, wenn man sich die gemessenen Werte ansieht.

Quelle: http://wattsupwiththat.com/2009/11/25/uh-oh-raw-data-in-new-zealand-tells-a-different-story-than-the-official-one/

Dies hat mich veranlasst selber die GHCN-Daten näher zu betrachten.

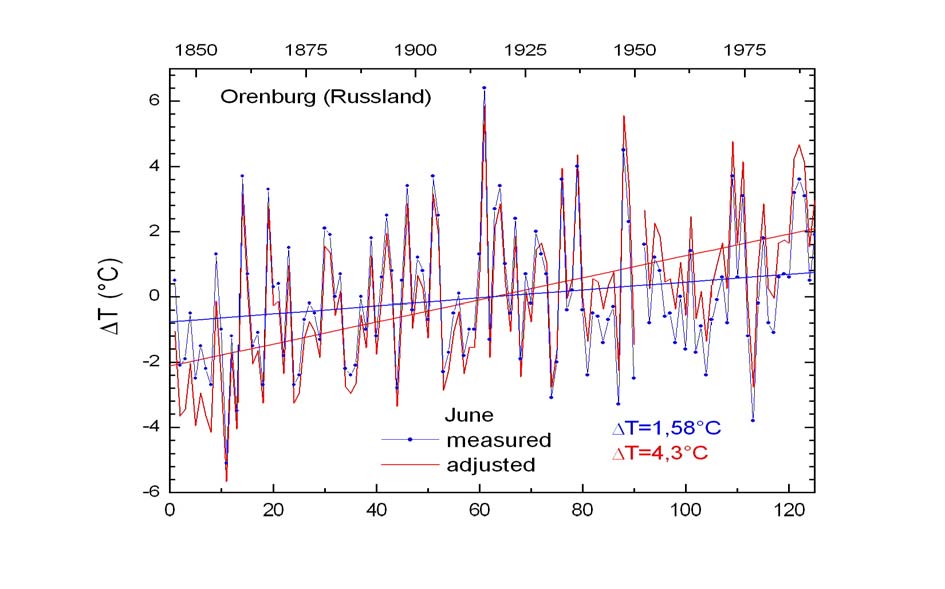

Die folgende Graphik zeigt die gemessene und die korrigierte Kurve für Orenburg (früher Russland) im Juni. Die Stadt hat ihre Einwohner zwischen 1930 und 1960 verdoppelt und hat heute über eine halbe Million Bewohner. Laut Goggle befindet sich die Station jetzt 10km vom Zentrum entfernt. Dies lässt den Anstieg von 1.58°C durch den Wärmeinseleffekt wahrscheinlich sein.

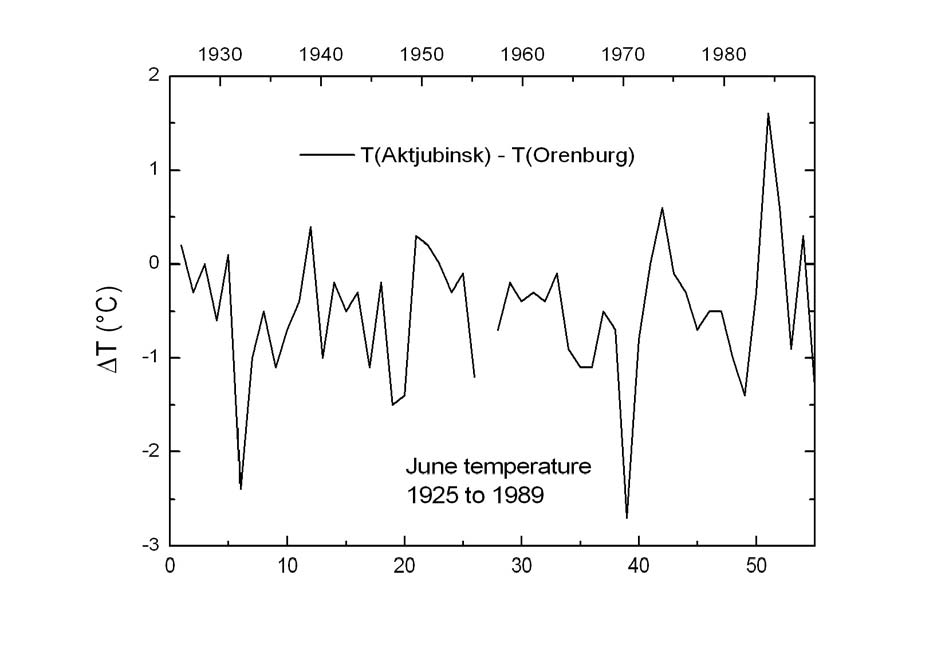

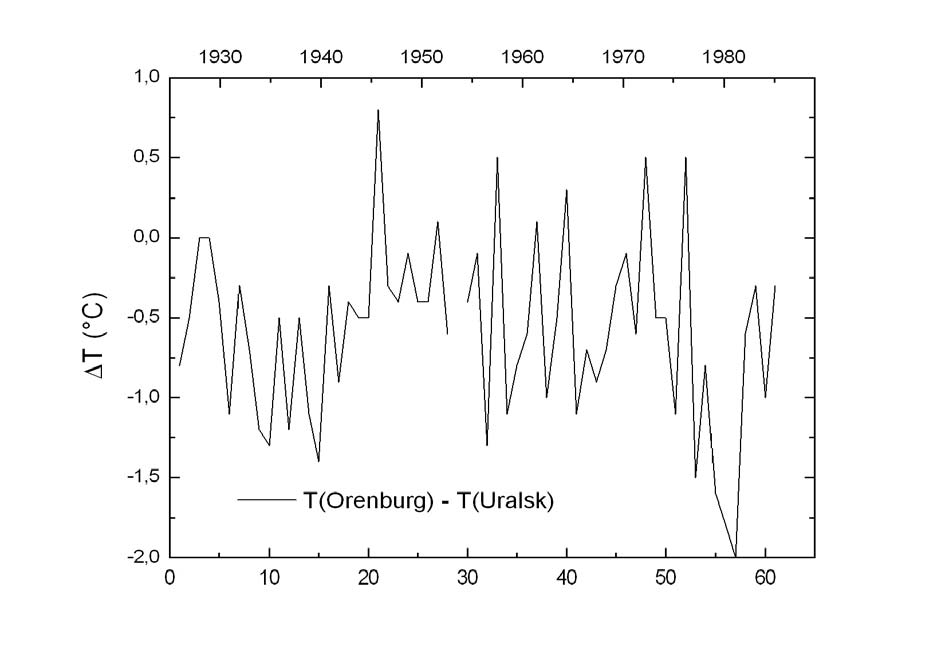

Die nächsten Stationen befinden sich in Aktjubinsk und in Uralsk und sind 212km bzw. 269km entfernt. Da nach dem Verfahren des GHCN der starke Anstieg eine Folge der Tempe-raturkorrektur mit den, zwar ziemlich weit entfernten, nächsten Stationen ist, ist in den fol-genden zwei Graphiken die jeweilige Temperaturdifferenz aufgetragen. Ein ausgemachter Aufwärtstrend ist aus keiner der beiden Darstellungen zu entnehmen. Woher die zusätzlichen 2.72°C bei dem Anstieg kommen, bleibt zumindest fraglich.

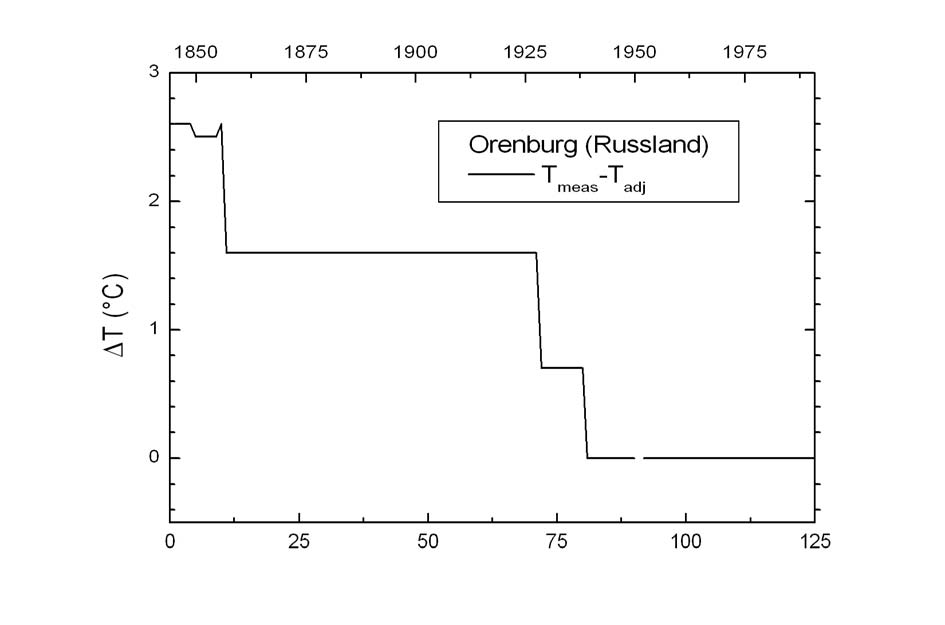

Orenburg besitzt aber eine viel längere Temperaturreihe, die eine noch merkwürdigere Korrektur aufweist, wie die nächste Graphik zeigt.

Wie man sich einen 70jährigen konstanten Temperaturabzug von 1.6°C erklären kann, bleibt wohl ein Geheimnis vom GHCN. Sieht man sich weitere korrigierte Reihen an, so lässt sich ein Trend erkennen.

Dass die Anpassung vom GISS in die gleiche Richtung verläuft wundert niemand ernsthaft.

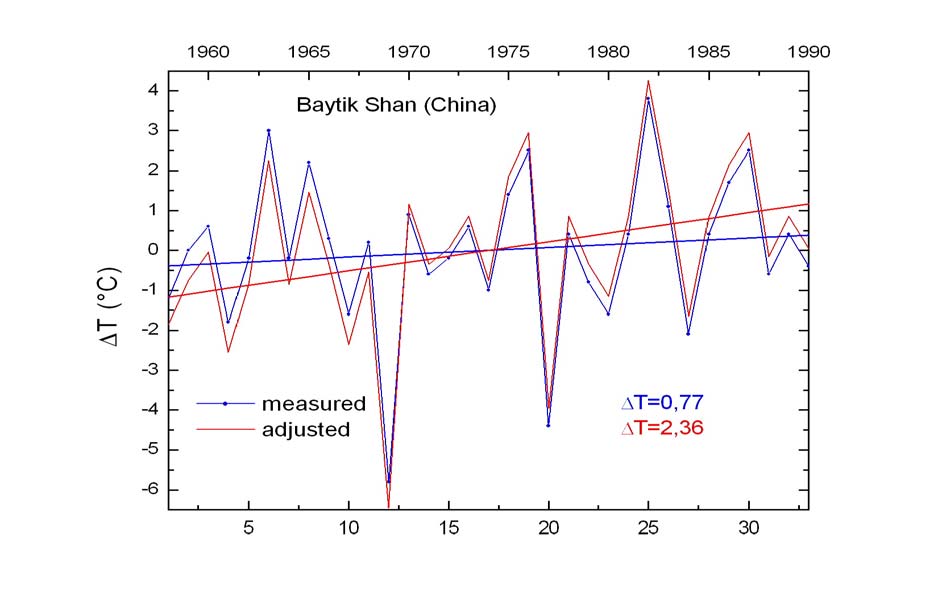

Auch für diese Station sieht die Differenz der Temperaturen merkwürdig aus.

Allen ist aber gemeinsam, dass die Temperatur in der Vergangenheit nach unten in der jüngeren Zeit nach oben angepasst wird. Naiv würde man in Folge der Urbanisierung eher das Gegenteil erwarten. Der Verdacht, dass hier ein Trend hineinkorrigiert wurde, ist nicht von der Hand zu weisen. Dies wird auch durch die merkwürdige Selektion der Messstationen untermauert.

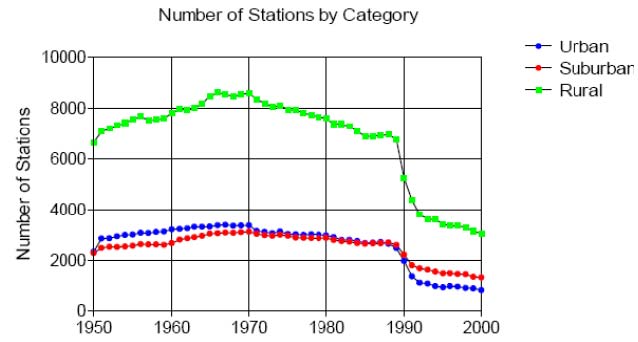

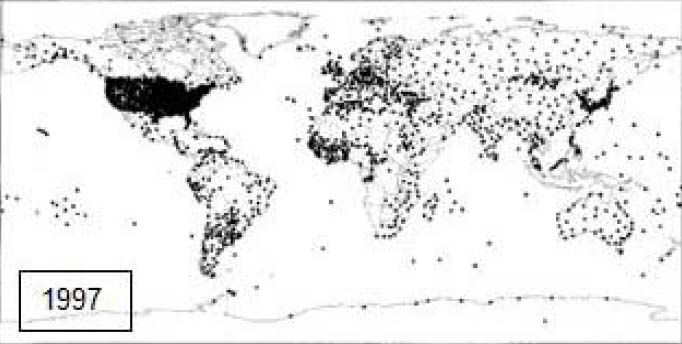

Immer weniger statt mehr Stationen werden zur Bestimmung der globalen Temperatur ausgewählt, was besonders für die ländlichen gilt.

Die Landfläche der Erde beträgt 148.490.000km2. Verteilen wir die derzeit (2008) noch verbliebenen rund 2.000 Stationen gleichmäßig, dann bestimmt jede Station die Temperatur für ein Gebiet von rund 75.000km2, was etwas größer als die zweifache Fläche von Baden-Württemberg ist. Mit anderen Worten ein Thermometer soll die Temperatur in BW und, sagen wir, im angrenzenden Hessen widerspiegeln. Die mittlere Jahrestemperatur beträgt z.B. in Freiburg 10.4°C, während der Feldberg nur 3.3°C aufweist. Welche Temperatur gilt nun für BW und Hessen? Da die Stationen in Wirklichkeit aber sehr inhomogen verteilt sind, gibt es für die größten Teile der Erdoberfläche gar keine belastbaren Aussagen. Diese Asymmetrie wird noch verstärkt, wenn man die Verteilung der verbliebenen Stationen betrachtet.

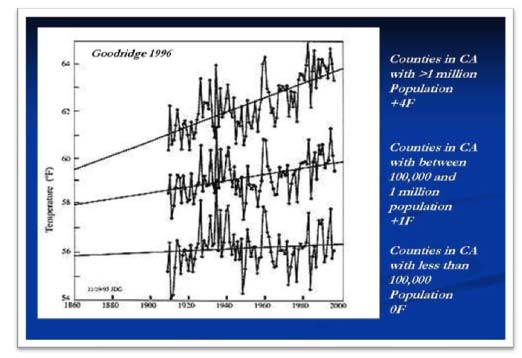

Sie stehen überwiegend im dicht besiedelten Europa, an der chinesischen Ostküste und in den USA. In Sibirien gibt es Gebiete von der Größe Deutschlands, wo keine einzige Station zu finden ist. Dass dies nicht ohne Auswirkung auf die globale Temperatur ist, folgert unmittel-bar aus der nächsten Abbildung, die die Temperaturtrends für unterschiedlich stark bewohnte

Gebiete Kaliforniens zeigen. Es gibt den erwarteten positiven Zusammenhang zwischen Urbanisierung und Temperaturänderung. Das GHCN muss eine negative Korrelation zwischen beiden Grüßen gefunden haben, die es aber bisher weder publiziert noch begründet hat.

Kürzlich wurde eine Studie im „Geophysical Research Letters“ publiziert. Die Autoren kamen zu dem Ergebnis:

“After examining climate data extending back nearly 100 years, a team of Government scientists has concluded that there has been no significant change in average temperatures or rainfall in the United States over that entire period.” (Hervorhebung durch mich)

Dr. Hansen, einer der führenden Klimahysteriker, sagte dazu:

“he had ”no quarrel” with the findings in the new study. He noted that the United States cov-ered only 1.5 percent of Earth. ”If you have only one degree warming on a global average, how much do you get at random” when taking measurements in such a relatively small area, he asked rhetorically.”

Quelle: http://wattsupwiththat.com/2010/03/01/flashback-u-s-data-since-1895-fail-to-show-warming-trend/#more-16839

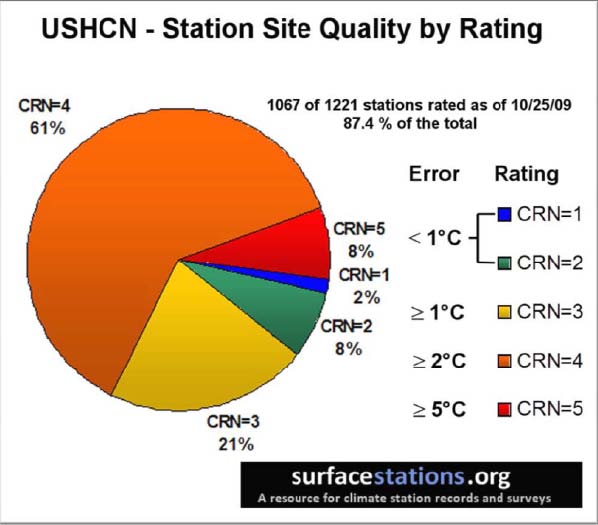

Wenn schon die USA mit der noch vorhandenen größten Anzahl von Stationen nicht aussagekräftig ist, woher kennt Herr Hansen dann eigentlich die globale Temperatur? Außerdem dürfte Herrn Hansen bekannt sein, dass selbst die amerikanischen Stationen überwiegend falsch messen, wie bei surfacestation.org nachgelesen werden kann. Hier nur die Graphik dazu. Bisher wurden knapp 82% aller amerikanischen Stationen untersucht. Gerade einmal 10% der Stationen haben einen tolerablen Fehler. Alle anderen messen zu hohe Temperaturen. Da die „Welttemperatur“ durch die Dominanz der amerikanischen Stationen wesentlich geprägt wird, kommen Zweifel auf.

Worin besteht aber nun das Dilemma? Das Dilemma besteht darin, dass offensichtlich nicht nur die Proxydaten manipuliert worden sind, sondern auch die schon fehlerbehafteten Messreihen und zwar so, dass im Mittel ein Temperaturanstieg im 20. Jahrhundert herauskommt. Es ist somit auf der einen Seite überhaupt nicht mehr klar, ob es eine mittlere globale Temperaturänderung gab und wenn ja in welche Richtung. Es scheint somit momentan nicht möglich zu sein eine Theorie zur Klimaentwicklung experimentell zu überprüfen und sie entweder zu verifizieren oder zu falsifizieren. Die Datenfälscher haben der Menschheit und der Klimaforschung einen Bärendienst erwiesen und sollten u. a. dafür belangt werden.

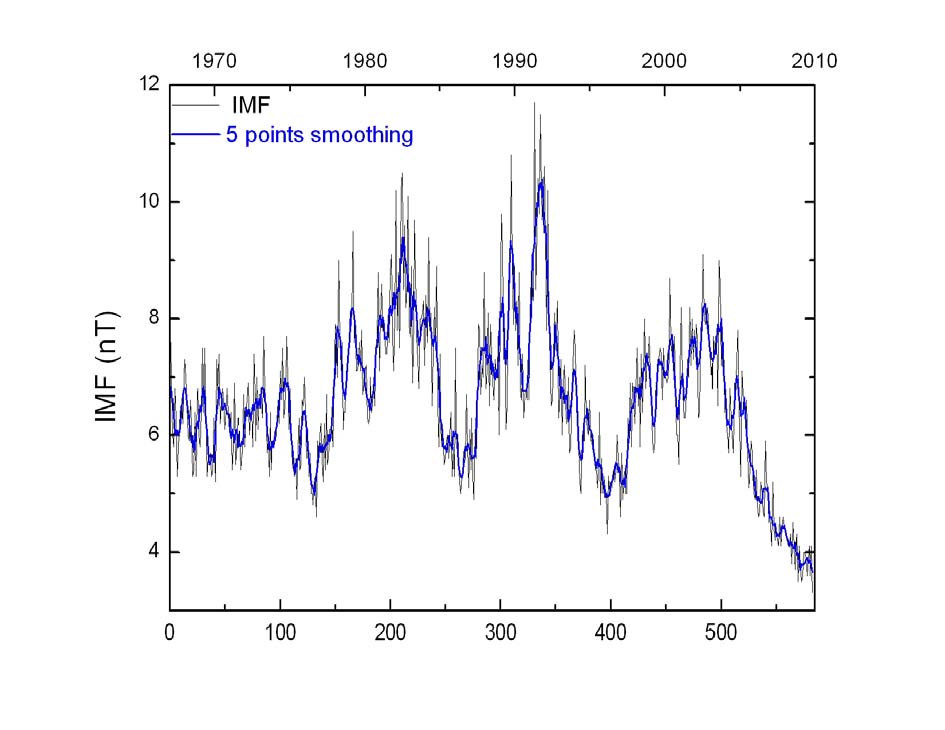

Auf der anderen Seite zeichnete sich das 20. Jahrhundert durch eine besonders aktive Sonne aus. Dies müsste gemäß dem Inhalt der zwei Reporte „Klima, Sonnenflecken und kosmische Strahlung“ mit einem Temperaturanstieg verbunden sein, welcher durch ein Absinken in diesem Jahrhundert in Folge einer Ruhephase der Sonnenaktivität fortgesetzt werden sollte. In der nächsten Graphik ist die Stärke des interplanetaren Magnetfeldes (IMF) abgebildet. Man erkennt eine relativ ruhige Phase in den 70ger Jahren, zu der Zeit wurde der Kältekollaps pro-phezeit („Die Abkühlung hat schon hunderttausende Menschen getötet. Wenn sie weiter voranschreitet und keine Maßnahmen ergriffen werden, wird sie weltweite Hungernöte, weltweites Chaos und Weltkrieg hervorrufen und das kann alles noch vor dem Jahr 2000 eintreffen“, sagte zum Beispiel Lowell Ponte 1976 in „The Cooling“), und dann einen starken Anstieg, der mit einer Temperaturerhöhung verbunden war.

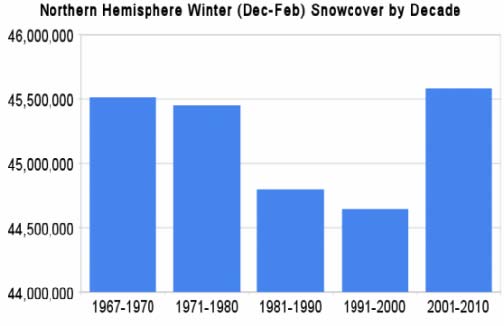

Da das interplanetare Magnetfeld derzeit so niedrige Werte hat, wie sie noch nie gemessen worden sind, müsste es kälter werden. Ob dies global so gilt, ist aus dem obigen Grund nicht sicher. Zumindest stehen die reduzierte Sonnenaktivität und der Rekord bei der Schneebede-ckungder Nordhalbkugel nicht im Widerspruch zu einander.

Rutgers University Global Snow Lab

Dies trifft aber nicht für die Vorhersagen der Klimamodelle zu, die eine Abnahme der Schneefälle prophezeiten oder für den englischen Wetterdienst (Met office), der basierend auf Modellrechnungen mit 80%er Wahrscheinlichkeit einen milden Winter prognostizierte. Die Realität hielt sich aber nicht daran. Es war der kälteste Winter seit mehr als 30 Jahren.

Dipl. Physiker Dr. Bernd Hüttner für EIKE

Die pdf Version finden Sie im Anhang