US-Klimawissenschaftler Spencer: Klare Belege dafür, dass das meiste von der U.S. Erwärmung seit 1973 falsch sein könnte!

EINFÜHRUNG

Meine beiden letzten Beiträge haben eine neue Methode beschrieben, um den durchschnittlichen Wärmeinsel-Effekt als eine Funktion der Bevölkerungsdichte zu quantifizieren, indem Tausende von Paaren von Temperatur-Messstationen benutzt wurden, die im Abstand von 150 Km zueinander lagen. Die Ergebnisse stützen frühere Arbeiten, die gezeigt haben, dass die Wärmeinsel-Erwärmung logarithmisch mit der Bevölkerung steigt, wobei die größte Rate der Wärmezunahme dort ist, wo der Anstieg von der niedrigsten Bevölkerungsdichte stattfindet.

Doch wie hilft uns das bei der Entscheidung, ob die globalen Erwärmungstrends auf fehlerhafte Weise durch Effekte verstärkt wurden, die in den führenden Oberflächentemperaturdaten-Reihen liegen, wie sie beispielsweise von Phil Jones (CRU) und Jim Hansen (NASA/GISS) erzeugt wurden.

Wenn auch meine Quantifizierungen des Wärmeinsel-Effekts eine interessante Übung sind, so beweist das Vorhandensein dieses Effekts auf den Raum bezogen (für Stationen mit räumlicher Entfernung) nicht notwendigerweise, dass es auch einen Erwärmungsfehler bei den Temperaturdatenim zeitlichen Verlauf gegeben hätte. Der Grund dafür liegt darin, dass, soweit die Bevölkerungsdichte [in der Umgebung] einer Messstation sich nicht über die Zeit verändert, die unterschiedlichen Maße des Wärmeinsel-Einflusses bei unterschiedlichen Messstationen wahrscheinlich geringen Einfluss auf die Langzeit-Temperatur-Trends haben. Städtische Stationen werden tatsächlich wärmer als der Durchschnitt sein, aber die „globale Erwärmung“ wird sie in etwa genau so beeinflussen wie die eher ländlichen Stationen.

Diese hypothetische Annahme scheint trotzdem unwahrscheinlich zu sein, weil die Bevölkerung doch tatsächlich mit der Zeit zunimmt. Wenn wir uns auf genug ländliche Stationen verlassen könnten, könnten wir alle anderen Wärmeinsel-verseuchten Daten wegwerfen. Unglücklicherweise gibt es nur sehr wenige Langzeit-Messungen von Thermometern, die keinerlei Veränderungen in ihrer Umgebung ausgesetzt waren … normalerweise sind es die menschlichen Bauwerke und Bodenabdeckungen, die zu fehlerhafter Erwärmung führen.

Deshalb müssen wir Daten von Stationen mit wenigstens geringer Wärmeinsel-Kontaminierung benutzen. Und damit erhebt sich die Frage, wie berücksichtigt man derartige Effekte?

Als Lieferant der offiziell abgesegneten GHCN – Temperatur-Reihen, auf die sich Hansen und Jones stützen, hat die NOAA einen ziemlich mühsamen Ansatz gewählt, bei dem die Langzeit-Temperaturdatenreihen von den einzelnen Messstationen Homogenitäts-„Korrekturen“ unterzogen werden, die auf (vermutlich fehlerhaften) abrupten Temperaturänderungen über der Zeit beruhten. Das Entstehen und Vergehen von Messstationen im Verlauf der Jahre verkompliziert weiterhin die Erstellung von Temperaturdatenreihen für Zeiträume bis zu 100 Jahren oder mehr zurück.

Das alles (und noch mehr) hat zu einem Mischmasch von komplexen Anpassungen geführt.

EINE EINFACHERE TECHNIK ZUM AUFSPÜREN VON FEHLERHAFTER ERWÄRMUNG

Bei der Analyse bevorzuge ich stets die Einfachheit – wo immer möglich. Komplexität bei der Daten-Analyse sollte nur eingeführt werden, wenn dies zur Aufklärung eines Sachverhalts nötig ist, der mithilfe einfacherer Analyse nicht erklärbar ist. Und so zeigt sich, dass die einfache Analyse der öffentlich zugänglichen Rohdaten der NOAA/NCDC von den jeweiligen Messstationen zusammen mit hoch aufgelösten Bevölkerungsdichte-Daten klare Belege dafür liefert, dass die GHCN-Daten für die Vereinigten Staaten Wärmeinsel-verseucht sind.

Ich begrenze die Analyse auf 1973 und nachfolgend, weil dies (1.) die primäre Erwärmungsperiode ist, die den menschlichen Treibhausgas-Emissionen zugeschrieben wird, und (2.) dies die Periode mit der höchsten Anzahl von Überwachungsstationen seit 1973 ist; und (3.), weil eine relativ kurze 37-Jahre-Historie die Anzahl der fortwährend arbeitenden Stationen maximiert. Dabei entfällt die Notwendigkeit, Übergänge zu behandeln, wenn ältere Stationen außer Betrieb gehen und neue hinzukommen.

Wie ich schon früher dargelegt habe: Ich bilde für vier Temperaturmessungen pro Tag (00, 06, 12, 18 Uhr UTC) für jede U.S.-Messstation einen Mittelwert (GHCN benutzt tägliche max/min-Werte) zur Errechnung eines Tagesmittels. Für eine monatsbezogene Durchschnittsbildung braucht man Messungen für wenigstens 20 Tage. Dann nehme ich nur diejenigen Stationen, die wenigstens 90% vollständige monatliche Daten von 1973 – 2009 haben. Die jährlichen Verläufe der Temperaturen und der Anomalien werden von jeder Station getrennt berechnet.

Dann errechne ich Multi-Stations-Anomalie-Durchschnitte für Quadrate mit der Größe von 5×5 Grad Breite/Länge, die ich dann mit den Temperatur-Trends der jeweiligen Region im CRUTem3-Datenbestand (das ist der Datenbestand von Phil Jones) vergleiche. Um aber zu erkennen, ob der CRUTem3–Datenbestand irgendwelche Fehler-Trends hat, teile ich meine Durchschnittswerte in 4 Klassen unterschiedlicher Bevölkerungsdichte: 0 – 25; 25 – 100; 100 – 400; mehr als 400 Menschen pro qkm. Die Bevölkerungsdichte ist auf eine nominale 1 km Auflösung eingestellt, die für 1990 bis 2000 erhältlich ist. Ich benutze die Daten von 2000.

Aus allen diesen Einschränkungen ergeben sich 24 bis 26 Fünf-Grad-Kästchen, verteilt über die Vereinigten Staaten mit allen Bevölkerungsdichteklassen in der 37-Jahre-Aufzeichnung. Zum Vergleich: Die gesamten Vereinigten Staaten überdecken ca. 40 Gitterkästchen im CRUTem3-Datenbestand. Weil die nachfolgend dargestellten Ergebnisse einen regionalen Subset (mindestens 60%) der USA darstellen, werden wir erkennen, dass die CRUTem3–Temperaturänderungen für die gesamten Vereinigten Staaten sich nicht substanziell ändern, wenn alle 40 Kästchen in die CRUTem3–Durchschnittsbildung einbezogen werden.

BELEG FÜR GROSSEN FEHLERHAFTEN ERWÄRMUNGSTREND IN DEN U.S. – GHCN-DATEN

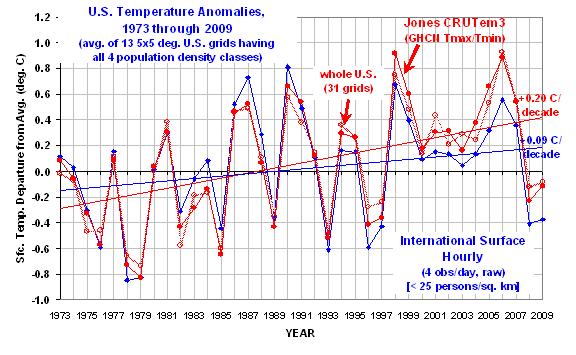

Die dicke rote Linie ist vom CRUTem3 Datenbestand und kann so als die „offizielle“ Abschätzung gelten. Die dicke blaue Kurve gilt für die Klasse der niedrigsten Bevölkerungsdichte. (Die übrigen drei Bevölkerungsdichteklassen würden die Grafik so unkenntlich machen, dass sie weggelassen sind, aber wir werden die Ergebnisse unten in brauchbarer Form sehen.)

Die folgende Grafik zeigt die jährlichen gebietsgemittelten Temperatur-Anomalien von 1973 – 2009 für die 24 bis 26 über die Vereinigten Staaten verteilten 5-Grad-Kästchen mit allen vier Bevölkerungsdichte-Klassen (wie auch eine CRUTem3-Durchschnittstemperaturmessung). Alle Anomalien sind rückgerechnet auf die 30-Jahr-Periode von 1973-2002.

Der Erwärmungstrend in der niedrigsten Bevölkerungsdichte-Klasse ist um 47% signifikant geringer als der CRUTem3-Trend. Ein Unterschied um den Faktor 2.

Interessant ist auch, dass in den CRUTem3-Daten 1998 und 2006 die beiden wärmsten Jahre der Aufzeichnungsperiode sind. Aber in der niedrigsten Bevölkerungsdichte-Klasse sind die beiden wärmsten Jahre 1987 und 1990. Bei der Analyse der CRUTem3-Daten für die gesamten Vereinigten Staaten (die hellrote Linie) sind die beiden wärmsten Jahre vertauscht, 2006 steht an erster, 1998 an zweiter Stelle.

Wenn man sich die wärmsten Jahre im CRUTem3-Datenbestand ansieht, gewinnt man den Eindruck, dass jedes Hochtemperatur-Jahr das vorhergehende an Intensität übertrifft. Doch die Stationen aus dem Niedrig-Bevölkerungsdichte-Gebiet zeigen das Umgekehrte: die Intensität der wärmsten Jahre nimmt tatsächlich ab im Verlauf der Zeit.

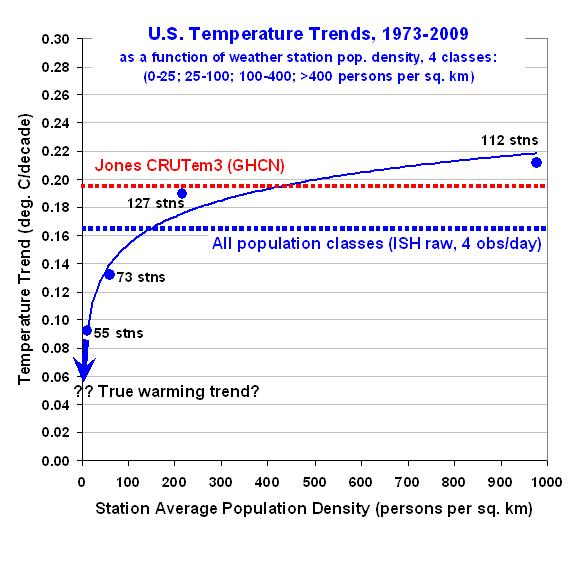

Zur besseren Vorstellung, wie der errechnete Erwärmungstrend von der Bevölkerungsdichte in allen 4 Klassen abhängt, zeigt die folgende Grafik – wie ich schon früher über den räumlichen Wärmeinsel-Effekt berichtet habe –, dass der Erwärmungstrend nichtlinear mit der Abnahme der Bevölkerungsdichte einhergeht. Tatsächlich würde die Extrapolation dieser Ergebnisse auf Null-Bevölkerungsdichte-Wachstum kaum Erwärmung zeigen:

Das ist ein sehr signifikantes Ergebnis. Es deutet die Möglichkeit an, dass überhaupt keine Erwärmung in den Vereinigten Staaten seit den 1970er Jahren stattfand.

Man beachte auch, dass sich in der höchsten Bevölkerungsdichte-Klasse eine leicht erhöhte Erwärmung zeigt im Vergleich zu den CRUTem3-Daten. Das stützt das Vertrauen, dass die hier gezeigten Effekte real existieren.

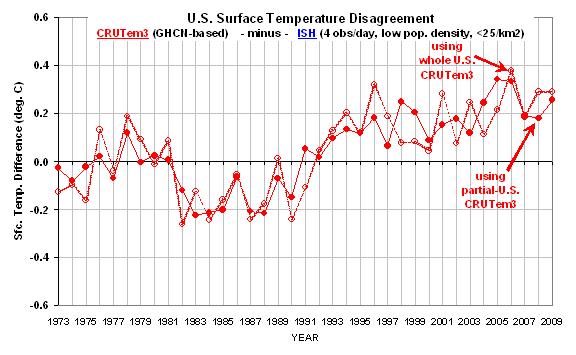

Zum Schluss zeigt die nächste Grafik den Unterschied zwischen der niedrigsten Bevölkerungsdichte-Klasse im Vergleich zur ersten Grafik oben. Hier gewinnt man eine bessere Vorstellung davon, welche Jahre zur großen Differenz bei den Erwärmungstrends beigetragen haben.

In der Zusammenschau glaube ich, dass diese Ergebnisse einen starken und direkten Beleg für die substanzielle Fehlerhaftigkeit der Erwärmungskomponente in den GHCN-Daten darstellen, zumindest für die hier angesprochene Periode (seit 1973) und Region (U.S.).

Wir brauchen wirklich neue und unabhängige Analysen der globalen Temperatur-Daten… der Rohdaten. Wie ich schon früher gesagt habe, brauchen wir unabhängige Gruppen zur unabhängigen Analyse der Globaltemperaturen – keine internationalen Gremien von Nobelpreisträgern, die Meinungen auf steinernen Gebotstafeln herunterreichen.

Aber wie immer wird diese Untersuchung präsentiert, um die Gedanken und die Diskussion anzuregen. Sie ist kein peer-reviewed Papier.

CAVEAT EMPTOR.

Roy Spencer (Original hier)

Die Übersetzung besorgte dankenswerterweise Hellmut Jäger für EIKE